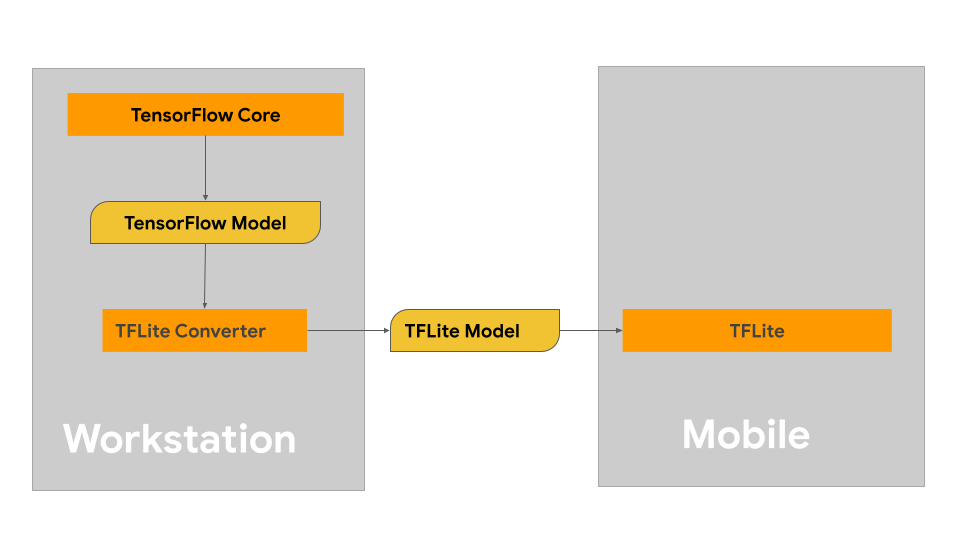

این صفحه راهنماییهایی برای ساخت مدلهای TensorFlow شما با هدف تبدیل به فرمت مدل LiteRT ارائه میدهد. مدلهای یادگیری ماشینی (ML) که با LiteRT استفاده میکنید، در اصل با استفاده از کتابخانهها و ابزارهای هسته TensorFlow ساخته و آموزش داده شدهاند. پس از ساخت مدل با هسته TensorFlow، میتوانید آن را به یک فرمت مدل ML کوچکتر و کارآمدتر به نام مدل LiteRT تبدیل کنید.

اگر از قبل مدلی برای تبدیل دارید، برای راهنمایی در مورد تبدیل مدل خود، به صفحه نمای کلی تبدیل مدلها مراجعه کنید.

ساخت مدل شما

اگر در حال ساخت یک مدل سفارشی برای مورد استفاده خاص خود هستید، باید با توسعه و آموزش یک مدل TensorFlow یا گسترش یک مدل موجود شروع کنید.

محدودیتهای طراحی مدل

قبل از شروع فرآیند توسعه مدل، باید از محدودیتهای مدلهای LiteRT آگاه باشید و مدل خود را با در نظر گرفتن این محدودیتها بسازید:

- قابلیتهای محاسباتی محدود - در مقایسه با سرورهای کاملاً مجهز به چندین CPU، ظرفیت حافظه بالا و پردازندههای تخصصی مانند GPU و TPU، دستگاههای موبایل و لبه بسیار محدودتر هستند. در حالی که آنها از نظر قدرت محاسباتی و سازگاری با سختافزار تخصصی در حال رشد هستند، مدلها و دادههایی که میتوانید به طور مؤثر با آنها پردازش کنید، هنوز هم به طور قابل توجهی محدود هستند.

- اندازه مدلها - پیچیدگی کلی یک مدل، شامل منطق پیشپردازش دادهها و تعداد لایههای موجود در مدل، اندازه حافظه داخلی یک مدل را افزایش میدهد. یک مدل بزرگ ممکن است به طور غیرقابل قبولی کند اجرا شود یا به سادگی در حافظه موجود یک دستگاه تلفن همراه یا لبه جا نشود.

- اندازه دادهها - اندازه دادههای ورودی که میتوانند به طور موثر با یک مدل یادگیری ماشین پردازش شوند، در یک دستگاه تلفن همراه یا لبه محدود است. مدلهایی که از کتابخانههای داده بزرگ مانند کتابخانههای زبان، کتابخانههای تصویر یا کتابخانههای کلیپ ویدیویی استفاده میکنند، ممکن است در این دستگاهها جا نشوند و ممکن است به راهحلهای ذخیرهسازی و دسترسی خارج از دستگاه نیاز داشته باشند.

- عملیات TensorFlow پشتیبانیشده - محیطهای زمان اجرای LiteRT در مقایسه با مدلهای معمولی TensorFlow، از زیرمجموعهای از عملیات مدل یادگیری ماشین پشتیبانی میکنند. هنگام توسعه مدلی برای استفاده با LiteRT، باید سازگاری مدل خود را با قابلیتهای محیطهای زمان اجرای LiteRT پیگیری کنید.

برای اطلاعات بیشتر در مورد ساخت مدلهای مؤثر، سازگار و با کارایی بالا برای LiteRT، به بهترین شیوههای عملکرد مراجعه کنید.

توسعه مدل

برای ساخت یک مدل LiteRT، ابتدا باید با استفاده از کتابخانههای اصلی TensorFlow، مدلی بسازید. کتابخانههای اصلی TensorFlow، کتابخانههای سطح پایینتری هستند که APIهایی را برای ساخت، آموزش و استقرار مدلهای یادگیری ماشینی ارائه میدهند.

TensorFlow دو مسیر برای انجام این کار ارائه میدهد. میتوانید کد مدل سفارشی خود را توسعه دهید یا میتوانید با پیادهسازی مدل موجود در TensorFlow Model Garden شروع کنید.

باغ مدل

TensorFlow Model Garden پیادهسازیهای بسیاری از مدلهای پیشرفته یادگیری ماشین (ML) را برای بینایی و پردازش زبان طبیعی (NLP) ارائه میدهد. همچنین ابزارهای گردش کار را خواهید یافت تا به شما امکان پیکربندی و اجرای سریع آن مدلها را بر روی مجموعه دادههای استاندارد بدهد. مدلهای یادگیری ماشین در Model Garden شامل کد کامل هستند، بنابراین میتوانید آنها را با استفاده از مجموعه دادههای خود آزمایش، آموزش یا دوباره آموزش دهید.

چه به دنبال ارزیابی عملکرد یک مدل شناختهشده باشید، چه بخواهید نتایج تحقیقات اخیراً منتشر شده را تأیید کنید، یا مدلهای موجود را گسترش دهید، Model Garden میتواند به شما در دستیابی به اهداف یادگیری ماشینیتان کمک کند.

مدلهای سفارشی

اگر مورد استفاده شما خارج از مواردی است که توسط مدلهای موجود در Model Garden پشتیبانی میشوند، میتوانید از یک کتابخانه سطح بالا مانند Keras برای توسعه کد آموزشی سفارشی خود استفاده کنید. برای یادگیری اصول TensorFlow، به راهنمای TensorFlow مراجعه کنید. برای شروع کار با مثالها، به مرور کلی آموزشهای TensorFlow مراجعه کنید که شامل نکاتی برای آموزشهای سطح مبتدی تا حرفهای است.

ارزیابی مدل

پس از توسعه مدل خود، باید عملکرد آن را ارزیابی کرده و آن را روی دستگاههای کاربر نهایی آزمایش کنید. TensorFlow چند روش برای انجام این کار ارائه میدهد.

- TensorBoard ابزاری برای ارائه اندازهگیریها و مصورسازیهای مورد نیاز در طول گردش کار یادگیری ماشین است. این ابزار امکان ردیابی معیارهای آزمایش مانند تلفات و دقت، مصورسازی نمودار مدل، تصویرسازی جاسازیها در فضایی با ابعاد کمتر و موارد دیگر را فراهم میکند.

- ابزارهای بنچمارک برای هر پلتفرم پشتیبانیشده مانند برنامه بنچمارک اندروید و برنامه بنچمارک iOS در دسترس هستند. از این ابزارها برای اندازهگیری و محاسبه آمار برای معیارهای مهم عملکرد استفاده کنید.

بهینهسازی مدل

با توجه به محدودیتهای منابع مختص مدلهای TensorFlow Lite، بهینهسازی مدل میتواند به تضمین عملکرد خوب مدل شما و استفاده کمتر از منابع محاسباتی کمک کند. عملکرد مدل یادگیری ماشین معمولاً تعادلی بین اندازه و سرعت استنتاج در مقابل دقت است. LiteRT در حال حاضر از بهینهسازی از طریق کوانتیزاسیون، هرس و خوشهبندی پشتیبانی میکند. برای جزئیات بیشتر در مورد این تکنیکها، به موضوع بهینهسازی مدل مراجعه کنید. TensorFlow همچنین یک جعبه ابزار بهینهسازی مدل ارائه میدهد که یک API برای پیادهسازی این تکنیکها ارائه میدهد.

مراحل بعدی

- برای شروع ساخت مدل سفارشی خود، به آموزش شروع سریع برای مبتدیان در مستندات هسته TensorFlow مراجعه کنید.

- برای تبدیل مدل TensorFlow سفارشی خود، به نمای کلی Convert models مراجعه کنید.

- برای تعیین اینکه آیا مدل شما با LiteRT سازگار است یا اینکه باید اقدامات بیشتری برای سازگاری آن انجام دهید، به راهنمای سازگاری اپراتور مراجعه کنید.

- برای راهنمایی در مورد کارآمد و کارآمد کردن مدلهای LiteRT خود، به راهنمای بهترین شیوههای عملکرد مراجعه کنید.

- برای یادگیری نحوه اندازهگیری عملکرد مدل خود با استفاده از ابزارهای بنچمارک، به راهنمای معیارهای عملکرد مراجعه کنید.