פריסת ML ו-GenAI בביצועים גבוהים בפלטפורמות קצה

המרות, זמני ריצה ואופטימיזציה יעילים ללמידת מכונה במכשיר.

נשען על הבסיס שנבדק בקרב של TensorFlow Lite

LiteRT הוא לא רק חדש, הוא הדור הבא של זמן הריצה של למידת מכונה שהכי נפוץ בעולם. היא מפעילה את האפליקציות שבהן אתם משתמשים מדי יום, ומספקת זמן אחזור נמוך ורמת פרטיות גבוהה במיליארדי מכשירים.

אפליקציות Google הכי חשובות מסתמכות עליו

יותר מ-100,000 אפליקציות, מיליארדי משתמשים ברחבי העולם

המיטב של LiteRT

מוכן לשימוש בפלטפורמות שונות

שימוש ב-AI גנרטיבי

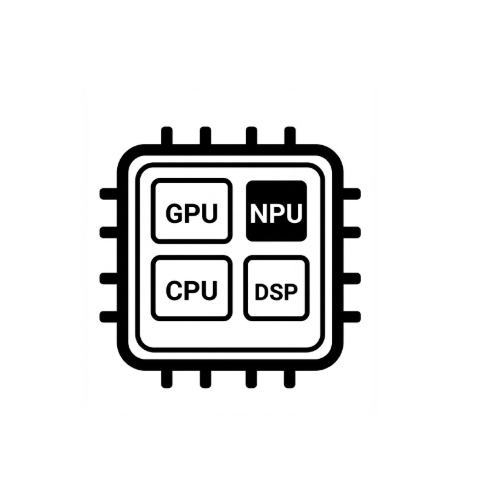

שיפור מהירות באמצעות חומרה

תמיכה במספר מסגרות

פריסה באמצעות LiteRT

קבלת מודל

שימוש במודלים שעברו אימון מקדים בפורמט .tflite או המרה של מודלים בפורמטים PyTorch, JAX או TensorFlow לפורמט .tflite

אופטימיזציה של המודל

קוונטיזציה של המודל (אופציונלי)

ריצה

בוחרים את המאיץ הרצוי ומריצים אותו ב-LiteRT

דוגמאות, מודלים והדגמות

הצגת אפליקציה לדוגמה

במדריכים מוסבר איך להשתמש ב-LiteRT, עם דוגמאות מלאות מקצה לקצה.

צפייה במודלים של AI גנרטיבי

מודלים של AI גנרטיבי שעברו אימון מראש ומוכנים לשימוש.

לצפייה בהדגמות – אפליקציית Google AI Edge Gallery

גלריה שמציגה תרחישים לדוגמה של למידת מכונה או AI גנרטיבי במכשיר