Gemma 3

אוסף של מודלים פתוחים, קלים ומתקדמים שנוצרו על סמך אותם מחקר וטכנולוגיה שמניעים את המודלים שלנו מסוג Gemini 2.0

טיפול במשימות מורכבות

חלון ההקשר של Gemma 3 עם 128,000 אסימונים מאפשר לאפליקציות לעבד ולהבין כמויות אדירות של מידע, וכך מאפשר יכולות מתקדמות יותר של AI.

יציאה לשוק הגלובלי באופן מיידי

יכולות התמיכה במספר שפות של Gemma 3 מאפשרות לכם לתקשר בקלות בשפות שונות. פיתוח אפליקציות שיכולות להגיע לקהל גלובלי, עם תמיכה ביותר מ-140 שפות.

הבנת מילים ותמונות

פיתוח אפליקציות שמנתחות תמונות, טקסט וסרטונים בקלות, ומאפשרות ליצור אפליקציות אינטראקטיביות וחכמות.

פיתוח עם המודל הטוב ביותר בעולם עם מאיץ יחיד

תחילת העבודה עם Gemma

שיפור המחקר באמצעות Gemma

אוסף הולך וגדל של מודלים מיוחדים של Gemma למחקר מתקדם.

הצגה חזותית של 3 נקודות השוואה של Gemma

אפשר לבצע פעולות שונות בתרשים כדי לראות את התוצאות של Gemma 3 במגוון של מדדי LLM.

MMLU-Pro

מדד MMLU הוא בדיקה למדידת היקף הידע ויכולת פתרון הבעיות שמודלים גדולים של שפה צוברים במהלך ההדרכה המוקדמת.

LiveCodeBench

הערכה של יכולות יצירת הקוד בבעיות תכנות מהעולם האמיתי מפלטפורמות כמו LeetCode ו-Codeforces.

dev

Bird-SQL

בדיקה של היכולת של מודל לתרגם שאלות בשפה טבעית לשאילתות SQL מורכבות בתחומים שונים.

GPQA Diamond

אתגרים למודלים עם שאלות קשות שנכתבו על ידי דוקטורים בביולוגיה, בפיזיקה ובכימיה.

SimpleQA

הבדיקה הזו בודקת את היכולת של מודל לענות על שאלות פשוטות עובדתיות באמצעות ביטויים קצרים.

עיגון של FACTS

הכלי הזה מעריך אם התשובות של ה-LLM מדויקות מבחינה עובדתית ומפורטות מספיק, על סמך מסמכי הקלט שסופקו.

MATH

המדד MATH מעריך את היכולת של מודל שפה לפתור בעיות מילוליות מתמטיות מורכבות, שדורשות חשיבה, פתרון בעיות בכמה שלבים והבנה של מושגים מתמטיים.

HiddenMath

קבוצה פנימית של בעיות מתמטיות בתחרות.

val

MMMU

הערכה של הבנה וחשיבה במגוון מישורים (multimodal) במגוון תחומים שדורשים ידע ברמת קולג'.

100%

75%

50%

25%

0%

100%

75%

50%

25%

0%

*פרטים על הביצועים בשיטות אחרות זמינים בדוח הטכני. קריאת הדוח הטכני

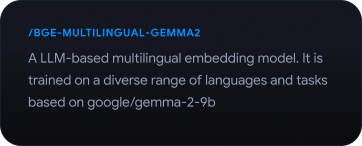

Gemmaverse

סביבה רחבה של מודלים וכלים של Gemma שנוצרו על ידי הקהילה, שיעזרו לכם לחדש ולהתחדש

בחירת יעד הפריסה

נייד

פריסה במכשיר באמצעות Google AI Edge

פריסת הפונקציות ישירות במכשירים כדי ליהנות מזמן אחזור קצר ופונקציונליות אופליין. מתאים במיוחד לאפליקציות שדורשות תגובה מיידית ופרטיות, כמו אפליקציות לנייד, מכשירי IoT ומערכות מוטמעות.

אינטרנט

שילוב חלק באפליקציות אינטרנט

שדרוג האתרים ושירותי האינטרנט שלכם באמצעות יכולות AI מתקדמות, שמאפשרות תכונות אינטראקטיביות, תוכן מותאם אישית ואוטומציה חכמה.

Cloud

התאמה לעומס בקלות באמצעות תשתית ענן

נצלו את הגמישות וההתאמה לעומס של הענן כדי לטפל בפריסות בקנה מידה רחב, בעומסי עבודה כבדים ובאפליקציות AI מורכבות.

האצת המחקר האקדמי באמצעות קרדיטים ב-Google Cloud

שיפור המחקר בעזרת מודלים של Gemma 3 ב-Google Cloud. אתם מוזמנים להגיש בקשה כבר עכשיו כדי לקבל קרדיטים ל-Google Cloud, שיעזרו לכם להתקדם במחקר ולתרום לקידום הקהילה המדעית.