Высокопроизводительное развертывание машинного обучения и искусственного интеллекта на периферийных платформах

Эффективное преобразование, выполнение и оптимизация для машинного обучения на устройстве.

Создано на основе проверенной в боевых условиях платформы TensorFlow Lite.

LiteRT — это не просто новая технология; это следующее поколение самой распространенной в мире среды выполнения машинного обучения. Она обеспечивает работу приложений, которыми вы пользуетесь каждый день, гарантируя низкую задержку и высокую конфиденциальность на миллиардах устройств.

LiteRT — это не просто новая технология; это следующее поколение самой распространенной в мире среды выполнения машинного обучения.

Ему доверяют самые важные приложения Google.

Более 100 000 приложений, миллиарды пользователей по всему миру

Основные моменты LiteRT

кроссплатформенная готовность

Раскройте потенциал искусственного интеллекта

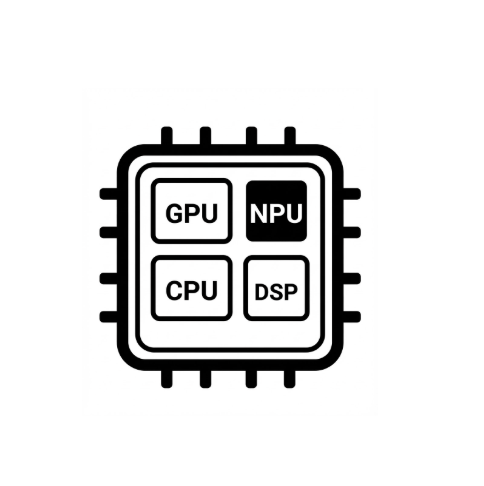

Упрощенное аппаратное ускорение

Поддержка нескольких фреймворков

Развертывание через LiteRT

Получите модель

Используйте предварительно обученные модели в формате .tflite или преобразуйте модели PyTorch, JAX или TensorFlow в формат .tflite.

Оптимизировать модель

При желании можно квантовать модель.

Бегать

Выберите нужный ускоритель и запустите на LiteRT

Образцы, модели и демонстрационные материалы

См. пример приложения

В обучающих материалах показано, как использовать LiteRT с полными, комплексными примерами.

См. модели genAI

Предварительно обученные, готовые к использованию модели искусственного интеллекта.

Смотрите демонстрации — приложение Google AI Edge Gallery

Галерея, демонстрирующая примеры использования машинного обучения/генерированного искусственного интеллекта на устройствах.