การติดตั้งใช้งาน ML และ GenAI ประสิทธิภาพสูงบนแพลตฟอร์ม Edge

Conversion, รันไทม์ และการเพิ่มประสิทธิภาพที่มีประสิทธิภาพสำหรับแมชชีนเลิร์นนิงบนอุปกรณ์

สร้างขึ้นบนรากฐานที่ผ่านการทดสอบมาอย่างดีของ TensorFlow Lite

LiteRT ไม่ใช่แค่ของใหม่ แต่เป็นรันไทม์แมชชีนเลิร์นนิงรุ่นต่อไปที่ได้รับการติดตั้งใช้งานอย่างกว้างขวางที่สุดในโลก โดยเป็นเทคโนโลยีที่ขับเคลื่อนแอปที่คุณใช้ทุกวัน ซึ่งมอบเวลาในการตอบสนองที่ต่ำและความเป็นส่วนตัวสูงในอุปกรณ์หลายพันล้านเครื่อง

แอป Google ที่สำคัญที่สุดเชื่อมั่นในเรา

มีแอปพลิเคชันมากกว่า 100, 000 รายการและผู้ใช้ทั่วโลกหลายพันล้านคน

ไฮไลต์ของ LiteRT

พร้อมใช้งานข้ามแพลตฟอร์ม

ปลดปล่อย GenAI

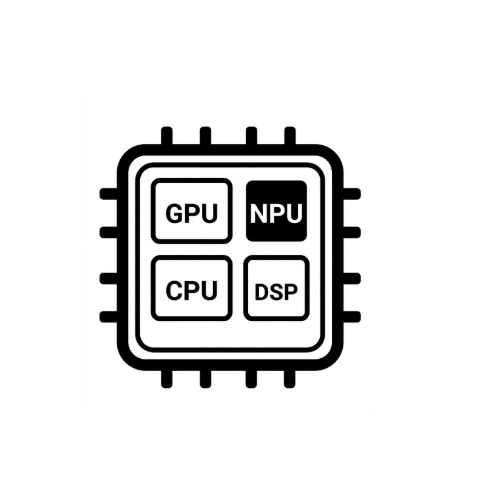

การเร่งฮาร์ดแวร์ที่ง่ายขึ้น

การรองรับหลายเฟรมเวิร์ก

ติดตั้งใช้งานผ่าน LiteRT

รับโมเดล

ใช้โมเดลที่ฝึกล่วงหน้า .tflite หรือแปลงโมเดล PyTorch, JAX หรือ TensorFlow เป็น .tflite

เพิ่มประสิทธิภาพโมเดล

เลือกที่จะทําการหาปริมาณโมเดล

เรียกใช้

เลือกตัวเร่งที่ต้องการและเรียกใช้ใน LiteRT

ตัวอย่าง โมเดล และการสาธิต

ดูแอปตัวอย่าง

บทแนะนำจะแสดงวิธีใช้ LiteRT พร้อมตัวอย่างแบบครบวงจร

ดูโมเดล Gen AI

โมเดล Gen AI ที่พร้อมใช้งานและได้รับการฝึกไว้ล่วงหน้า

ดูการสาธิต - แอป Google AI Edge Gallery

แกลเลอรีที่แสดงกรณีการใช้งาน ML/GenAI บนอุปกรณ์