A tarefa do MediaPipe Face Detector permite detectar rostos em uma imagem ou vídeo. Você pode usar essa tarefa para localizar rostos e características faciais em um frame. Esta tarefa usa um modelo de aprendizado de máquina (ML) que funciona com imagens únicas ou um fluxo contínuo de imagens. A tarefa gera locais do rosto, além dos seguintes pontos-chave faciais: olho esquerdo, olho direito, ponta do nariz, boca, trágus do olho esquerdo e trágus do olho direito.

O exemplo de código descrito nestas instruções está disponível no GitHub. Para mais informações sobre os recursos, modelos e opções de configuração desta tarefa, consulte a Visão geral.

Exemplo de código

O exemplo de código para o Detector de rosto oferece uma implementação completa dessa tarefa em Python para sua referência. Esse código ajuda a testar essa tarefa e a criar seu próprio detector de rosto. Você pode conferir, executar e editar o código de exemplo do Face Detector usando apenas o navegador da Web.

Se você estiver implementando o detector facial para Raspberry Pi, consulte o app de exemplo do Raspberry Pi.

Configuração

Esta seção descreve as principais etapas para configurar seu ambiente de desenvolvimento e projetos de código especificamente para usar o Detector de rostos. Para informações gerais sobre como configurar o ambiente de desenvolvimento para usar as tarefas do MediaPipe, incluindo os requisitos da versão da plataforma, consulte o Guia de configuração para Python.

Pacotes

A tarefa do MediaPipe Face Detector requer o pacote PyPI do MediaPipe. É possível instalar e importar essas dependências com o seguinte:

$ python -m pip install mediapipe

Importações

Importe as classes a seguir para acessar as funções de tarefa do Face Detector:

import mediapipe as mp

from mediapipe.tasks import python

from mediapipe.tasks.python import vision

Modelo

A tarefa do detector de rosto do MediaPipe exige um modelo treinado compatível com essa tarefa. Para mais informações sobre os modelos treinados disponíveis para o Detector de rostos, consulte a seção "Modelos" da visão geral da tarefa.

Selecione e faça o download do modelo e armazene-o em um diretório local:

model_path = '/absolute/path/to/face_detector.task'

Use o parâmetro model_asset_path do objeto BaseOptions para especificar o caminho

do modelo a ser usado. Para conferir um exemplo de código, consulte a próxima seção.

Criar a tarefa

A tarefa do detector de rosto do MediaPipe usa a função create_from_options para

configurar a tarefa. A função create_from_options aceita valores

para que as opções de configuração sejam processadas. Para mais informações sobre as opções de

configuração, consulte Opções de configuração.

O código a seguir demonstra como criar e configurar essa tarefa.

Esses exemplos também mostram as variações da construção de tarefas para imagens, arquivos de vídeo e transmissão ao vivo.

Imagem

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions FaceDetector = mp.tasks.vision.FaceDetector FaceDetectorOptions = mp.tasks.vision.FaceDetectorOptions VisionRunningMode = mp.tasks.vision.RunningMode # Create a face detector instance with the image mode: options = FaceDetectorOptions( base_options=BaseOptions(model_asset_path='/path/to/model.task'), running_mode=VisionRunningMode.IMAGE) with FaceDetector.create_from_options(options) as detector: # The detector is initialized. Use it here. # ...

Vídeo

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions FaceDetector = mp.tasks.vision.FaceDetector FaceDetectorOptions = mp.tasks.vision.FaceDetectorOptions VisionRunningMode = mp.tasks.vision.RunningMode # Create a face detector instance with the video mode: options = FaceDetectorOptions( base_options=BaseOptions(model_asset_path='/path/to/model.task'), running_mode=VisionRunningMode.VIDEO) with FaceDetector.create_from_options(options) as detector: # The detector is initialized. Use it here. # ...

Transmissão ao vivo

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions FaceDetector = mp.tasks.vision.FaceDetector FaceDetectorOptions = mp.tasks.vision.FaceDetectorOptions FaceDetectorResult = mp.tasks.vision.FaceDetectorResult VisionRunningMode = mp.tasks.vision.RunningMode # Create a face detector instance with the live stream mode: def print_result(result: FaceDetectorResult, output_image: mp.Image, timestamp_ms: int): print('face detector result: {}'.format(result)) options = FaceDetectorOptions( base_options=BaseOptions(model_asset_path='/path/to/model.task'), running_mode=VisionRunningMode.LIVE_STREAM, result_callback=print_result) with FaceDetector.create_from_options(options) as detector: # The detector is initialized. Use it here. # ...

Para conferir um exemplo completo de como criar um detector de rosto para uso com uma imagem, consulte o exemplo de código.

Opções de configuração

Esta tarefa tem as seguintes opções de configuração para aplicativos Python:

| Nome da opção | Descrição | Intervalo de valor | Valor padrão |

|---|---|---|---|

running_mode |

Define o modo de execução da tarefa. Há três

modos: IMAGE: o modo para entradas de imagem única. VÍDEO: o modo para quadros decodificados de um vídeo. LIVE_STREAM: o modo de uma transmissão ao vivo de dados de entrada, como de uma câmera. Nesse modo, o resultListener precisa ser chamado para configurar um listener para receber resultados de forma assíncrona. |

{IMAGE, VIDEO, LIVE_STREAM} |

IMAGE |

min_detection_confidence |

A pontuação de confiança mínima para que a detecção de rosto seja considerada bem-sucedida. | Float [0,1] |

0.5 |

min_suppression_threshold |

O limite mínimo de supressão não máxima para que a detecção de rostos seja considerada sobreposta. | Float [0,1] |

0.3 |

result_callback |

Define o listener de resultados para receber os resultados de detecção

de forma assíncrona quando o detector de rosto está no modo de transmissão

ao vivo. Só pode ser usado quando o modo de execução está definido como LIVE_STREAM. |

N/A |

Not set |

Preparar dados

Prepare a entrada como um arquivo de imagem ou uma matriz NumPy

e converta-a em um objeto mediapipe.Image. Se a entrada for um arquivo de vídeo

ou uma transmissão ao vivo de uma webcam, use uma biblioteca externa, como o

OpenCV, para carregar os frames de entrada como matrizes

numpy.

Imagem

import mediapipe as mp # Load the input image from an image file. mp_image = mp.Image.create_from_file('/path/to/image') # Load the input image from a numpy array. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_image)

Vídeo

import mediapipe as mp # Use OpenCV’s VideoCapture to load the input video. # Load the frame rate of the video using OpenCV’s CV_CAP_PROP_FPS # You’ll need it to calculate the timestamp for each frame. # Loop through each frame in the video using VideoCapture#read() # Convert the frame received from OpenCV to a MediaPipe’s Image object. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_frame_from_opencv)

Transmissão ao vivo

import mediapipe as mp # Use OpenCV’s VideoCapture to start capturing from the webcam. # Create a loop to read the latest frame from the camera using VideoCapture#read() # Convert the frame received from OpenCV to a MediaPipe’s Image object. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_frame_from_opencv)

Executar a tarefa

O Detector de rosto usa as funções detect, detect_for_video e detect_async

para acionar inferências. Para a detecção de rostos, isso envolve

pré-processar os dados de entrada e detectar rostos na imagem.

O código abaixo demonstra como executar o processamento com o modelo de tarefa.

Imagem

# Perform face detection on the provided single image. # The face detector must be created with the image mode. face_detector_result = detector.detect(mp_image)

Vídeo

# Perform face detection on the provided single image. # The face detector must be created with the video mode. face_detector_result = detector.detect_for_video(mp_image, frame_timestamp_ms)

Transmissão ao vivo

# Send live image data to perform face detection. # The results are accessible via the `result_callback` provided in # the `FaceDetectorOptions` object. # The face detector must be created with the live stream mode. detector.detect_async(mp_image, frame_timestamp_ms)

Observe o seguinte:

- Ao executar no modo de vídeo ou de transmissão ao vivo, também forneça à tarefa do detector facial o carimbo de data/hora do frame de entrada.

- Ao ser executada no modelo de imagem ou vídeo, a tarefa do detector de rosto bloqueia a linha de execução atual até que ela termine de processar a imagem de entrada ou o frame.

- Quando executada no modo de transmissão ao vivo, a tarefa do detector de rosto é retornada imediatamente e não bloqueia a linha de execução atual. Ele invoca o listener de resultado com o resultado da detecção sempre que termina de processar um frame de entrada. Se a função de detecção for chamada quando a tarefa do detector facial estiver ocupada processando outro frame, a tarefa vai ignorar o novo frame de entrada.

Para conferir um exemplo completo de execução de um detector de rosto em uma imagem, consulte o exemplo de código para saber mais.

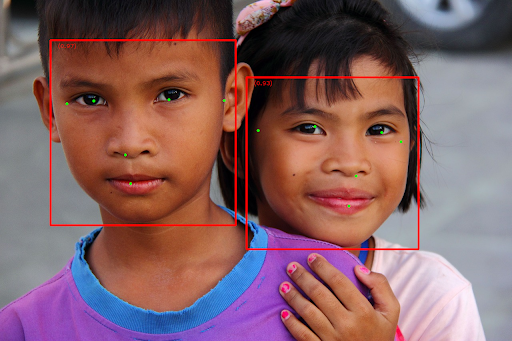

Processar e mostrar resultados

O Face Detector retorna um objeto FaceDetectorResult para cada execução

de detecção. O objeto de resultado contém caixas delimitadoras para os rostos detectados e uma

pontuação de confiança para cada rosto detectado.

Confira a seguir um exemplo dos dados de saída desta tarefa:

FaceDetectionResult:

Detections:

Detection #0:

BoundingBox:

origin_x: 126

origin_y: 100

width: 463

height: 463

Categories:

Category #0:

index: 0

score: 0.9729152917861938

NormalizedKeypoints:

NormalizedKeypoint #0:

x: 0.18298381567001343

y: 0.2961040139198303

NormalizedKeypoint #1:

x: 0.3302789330482483

y: 0.29289937019348145

... (6 keypoints for each face)

Detection #1:

BoundingBox:

origin_x: 616

origin_y: 193

width: 430

height: 430

Categories:

Category #0:

index: 0

score: 0.9251380562782288

NormalizedKeypoints:

NormalizedKeypoint #0:

x: 0.6151331663131714

y: 0.3713381886482239

NormalizedKeypoint #1:

x: 0.7460576295852661

y: 0.38825345039367676

... (6 keypoints for each face)

A imagem a seguir mostra uma visualização da saída da tarefa:

Para a imagem sem caixas delimitadoras, consulte a imagem original.

O código de exemplo do Face Detector demonstra como mostrar os resultados retornados pela tarefa. Consulte o exemplo de código para mais detalhes.