La tarea del detector de objetos de MediaPipe te permite detectar la presencia y la ubicación de varias clases de objetos. En estas instrucciones, se muestra cómo usar la tarea del detector de objetos en Python. El ejemplo de código que se describe en estas instrucciones está disponible en GitHub.

Para ver esta tarea en acción, consulta la demostración web. Para obtener más información sobre las capacidades, los modelos y las opciones de configuración de esta tarea, consulta la descripción general.

Ejemplo de código

El código de ejemplo del detector de objetos proporciona una implementación completa de esta tarea en Python como referencia. Este código te ayuda a probar esta tarea y comenzar a compilar tu propia app de clasificación de texto. Puedes ver, ejecutar y editar el código de ejemplo del detector de objetos solo con tu navegador web.

Si implementas el detector de objetos para Raspberry Pi, consulta la app de ejemplo para Raspberry Pi.

Configuración

En esta sección, se describen los pasos clave para configurar tu entorno de desarrollo y codificar proyectos específicamente para usar el detector de objetos. Para obtener información general sobre cómo configurar tu entorno de desarrollo para usar tareas de MediaPipe, incluidos los requisitos de la versión de la plataforma, consulta la Guía de configuración para Python.

Paquetes

La tarea del detector de objetos requiere el paquete pip de mediapipe. Puedes instalar los paquetes necesarios con los siguientes comandos:

$ python -m pip install mediapipe

Importaciones

Importa las siguientes clases para acceder a las funciones de tareas del detector de objetos:

import mediapipe as mp

from mediapipe.tasks import python

from mediapipe.tasks.python import vision

Modelo

La tarea del detector de objetos de MediaPipe requiere un modelo entrenado que sea compatible con esta tarea. Para obtener más información sobre los modelos entrenados disponibles para el Detector de objetos, consulta la sección Modelos de la descripción general de la tarea.

Selecciona y descarga un modelo y, luego, almacénalo en un directorio local:

model_path = '/absolute/path/to/lite-model_efficientdet_lite0_detection_metadata_1.tflite'

Usa el parámetro model_asset_path del objeto BaseOptions para especificar la ruta del modelo que se usará. Para ver un ejemplo de código, consulta la siguiente sección.

Crea la tarea

Usa la función create_from_options para crear la tarea. La función create_from_options acepta opciones de configuración, como el modo de ejecución, la configuración regional de los nombres visibles, la cantidad máxima de resultados, el umbral de confianza, la lista de entidades permitidas de la categoría y la lista de entidades rechazadas. Si no estableces una opción de configuración, la tarea usará el valor predeterminado. Para obtener más información sobre las opciones de configuración, consulta la sección Opciones de configuración.

La tarea Detector de objetos admite varios tipos de datos de entrada: imágenes estáticas, archivos de video y transmisiones de video en vivo. Elige la pestaña correspondiente al tipo de datos de entrada para ver cómo crear la tarea y ejecutar la inferencia.

Imagen

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions ObjectDetector = mp.tasks.vision.ObjectDetector ObjectDetectorOptions = mp.tasks.vision.ObjectDetectorOptions VisionRunningMode = mp.tasks.vision.RunningMode options = ObjectDetectorOptions( base_options=BaseOptions(model_asset_path='/path/to/model.tflite'), max_results=5, running_mode=VisionRunningMode.IMAGE) with ObjectDetector.create_from_options(options) as detector: # The detector is initialized. Use it here. # ...

Video

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions ObjectDetector = mp.tasks.vision.ObjectDetector ObjectDetectorOptions = mp.tasks.vision.ObjectDetectorOptions VisionRunningMode = mp.tasks.vision.RunningMode options = ObjectDetectorOptions( base_options=BaseOptions(model_asset_path='/path/to/model.tflite'), max_results=5, running_mode=VisionRunningMode.VIDEO) with ObjectDetector.create_from_options(options) as detector: # The detector is initialized. Use it here. # ...

Transmisión en vivo

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions DetectionResult = mp.tasks.components.containers.detections.DetectionResult ObjectDetector = mp.tasks.vision.ObjectDetector ObjectDetectorOptions = mp.tasks.vision.ObjectDetectorOptions VisionRunningMode = mp.tasks.vision.RunningMode def print_result(result: DetectionResult, output_image: mp.Image, timestamp_ms: int): print('detection result: {}'.format(result)) options = ObjectDetectorOptions( base_options=BaseOptions(model_asset_path='/path/to/model.tflite'), running_mode=VisionRunningMode.LIVE_STREAM, max_results=5, result_callback=print_result) with ObjectDetector.create_from_options(options) as detector: # The detector is initialized. Use it here. # ...

Para ver un ejemplo completo de cómo crear un detector de objetos para usarlo con una imagen, consulta el ejemplo de código.

Opciones de configuración

Esta tarea tiene las siguientes opciones de configuración para aplicaciones de Python:

| Nombre de la opción | Descripción | Rango de valores | Valor predeterminado |

|---|---|---|---|

running_mode |

Establece el modo de ejecución de la tarea. Existen tres modos: IMAGE: Es el modo para entradas de una sola imagen. VIDEO: Es el modo para los fotogramas decodificados de un video. LIVE_STREAM: Es el modo de transmisión en vivo de datos de entrada, como los de una cámara. En este modo, se debe llamar a resultListener para configurar un objeto de escucha que reciba resultados de forma asíncrona. |

{IMAGE, VIDEO, LIVE_STREAM} |

IMAGE |

display_names |

Establece el idioma de las etiquetas que se usarán para los nombres visibles proporcionados en los metadatos del modelo de la tarea, si están disponibles. El valor predeterminado es en para el inglés. Puedes agregar etiquetas localizadas a los metadatos de un modelo personalizado con la API de Metadata Writer de TensorFlow Lite.

|

Código de configuración regional | en |

max_results |

Establece la cantidad máxima opcional de resultados de detección con la puntuación más alta que se mostrarán. | Cualquier número positivo | -1 (se muestran todos los resultados) |

score_threshold |

Establece el umbral de puntuación de predicción que anula el que se proporciona en los metadatos del modelo (si corresponde). Se rechazan los resultados por debajo de este valor. | Cualquier número de punto flotante | Sin establecer |

category_allowlist |

Establece la lista opcional de nombres de categorías permitidas. Si no está vacío, se filtrarán los resultados de detección cuyo nombre de categoría no esté en este conjunto. Se ignoran los nombres de categorías duplicados o desconocidos.

Esta opción es mutuamente excluyente con category_denylist y, si se usan ambas, se genera un error. |

Cualquier cadena | Sin establecer |

category_denylist |

Establece la lista opcional de nombres de categorías que no están permitidos. Si no está vacío, se filtrarán los resultados de detección cuyo nombre de categoría esté en este conjunto. Se ignoran los nombres de categorías duplicados o desconocidos. Esta opción es mutuamente excluyente con category_allowlist y usar ambas genera un error. |

Cualquier cadena | Sin establecer |

Preparar los datos

Prepara tu entrada como un archivo de imagen o un array de numpy y, luego, conviértela en un objeto mediapipe.Image. Si tu entrada es un archivo de video o una transmisión en vivo desde una cámara web, puedes usar una biblioteca externa, como OpenCV, para cargar tus fotogramas de entrada como arrays de numpy.

En los siguientes ejemplos, se explica y muestra cómo preparar los datos para su procesamiento para cada uno de los tipos de datos disponibles:

Imagen

import mediapipe as mp # Load the input image from an image file. mp_image = mp.Image.create_from_file('/path/to/image') # Load the input image from a numpy array. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_image)

Video

import mediapipe as mp # Use OpenCV’s VideoCapture to load the input video. # Load the frame rate of the video using OpenCV’s CV_CAP_PROP_FPS # You’ll need it to calculate the timestamp for each frame. # Loop through each frame in the video using VideoCapture#read() # Convert the frame received from OpenCV to a MediaPipe’s Image object. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_frame_from_opencv)

Transmisión en vivo

import mediapipe as mp # Use OpenCV’s VideoCapture to start capturing from the webcam. # Create a loop to read the latest frame from the camera using VideoCapture#read() # Convert the frame received from OpenCV to a MediaPipe’s Image object. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_frame_from_opencv)

Ejecuta la tarea

Puedes llamar a una de las funciones de detección para activar inferencias. La tarea del detector de objetos mostrará los objetos detectados en la imagen o el fotograma de entrada.

Imagen

# Perform object detection on the provided single image. detection_result = detector.detect(mp_image)

Video

# Calculate the timestamp of the current frame frame_timestamp_ms = 1000 * frame_index / video_file_fps # Perform object detection on the video frame. detection_result = detector.detect_for_video(mp_image, frame_timestamp_ms)

Transmisión en vivo

# Send the latest frame to perform object detection. # Results are sent to the `result_callback` provided in the `ObjectDetectorOptions`. detector.detect_async(mp_image, frame_timestamp_ms)

Para ver un ejemplo completo de cómo ejecutar un detector de objetos en una imagen, consulta el ejemplo de código para obtener más información.

Ten en cuenta lo siguiente:

- Cuando se ejecuta en el modo de video o en el modo de transmisión en vivo, también debes proporcionar a la tarea del detector de objetos la marca de tiempo del fotograma de entrada.

- Cuando se ejecuta en la imagen o el modelo de video, la tarea del detector de objetos bloqueará el subproceso actual hasta que termine de procesar la imagen o el fotograma de entrada.

- Cuando se ejecuta en el modo de transmisión en vivo, la tarea del detector de objetos no bloquea el subproceso actual, sino que se muestra de inmediato. Invocará su objeto de escucha de resultados con el resultado de la detección cada vez que termine de procesar un fotograma de entrada. Si se llama a la función de detección cuando la tarea del detector de objetos está ocupada procesando otro fotograma, se ignorará el nuevo fotograma de entrada.

Cómo controlar y mostrar los resultados

Cuando se ejecuta la inferencia, la tarea del detector de objetos muestra un objeto ObjectDetectionResult que describe los objetos que encontró en la imagen de entrada.

A continuación, se muestra un ejemplo de los datos de resultado de esta tarea:

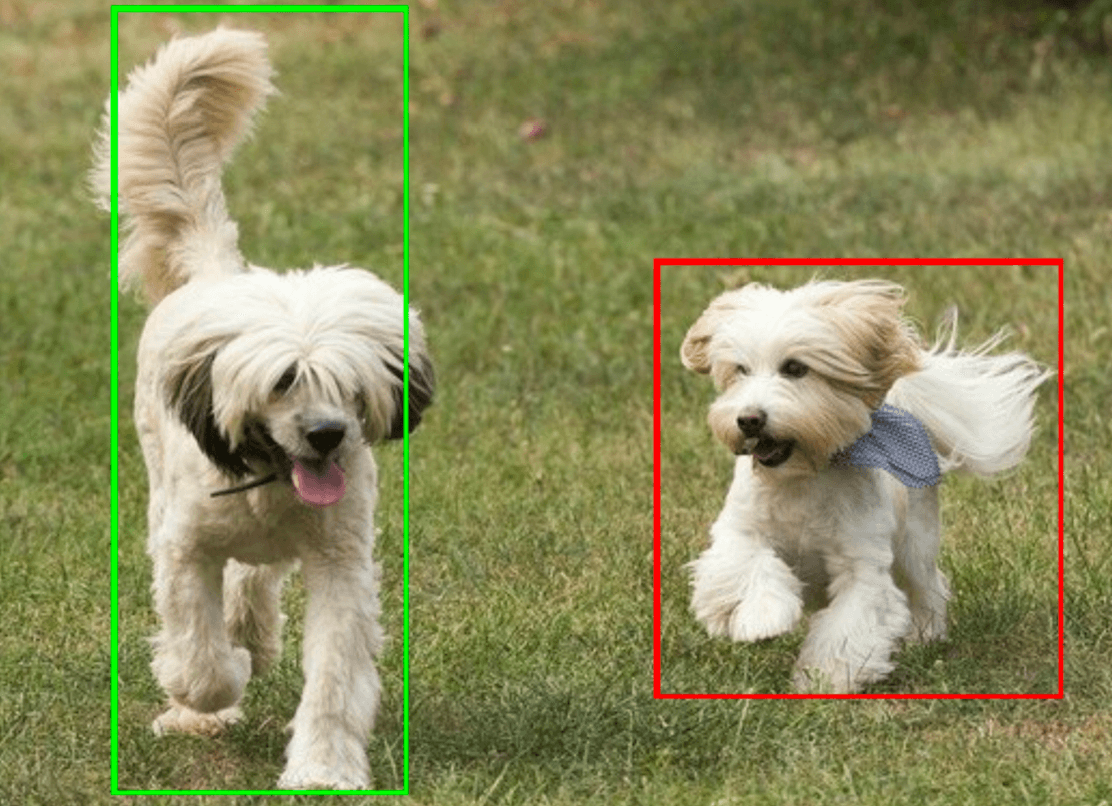

ObjectDetectorResult:

Detection #0:

Box: (x: 355, y: 133, w: 190, h: 206)

Categories:

index : 17

score : 0.73828

class name : dog

Detection #1:

Box: (x: 103, y: 15, w: 138, h: 369)

Categories:

index : 17

score : 0.73047

class name : dog

En la siguiente imagen, se muestra una visualización del resultado de la tarea:

En el código de ejemplo del detector de objetos, se muestra cómo mostrar los resultados de detección que se devuelven de la tarea. Consulta el ejemplo de código para obtener más información.