30 OCT 2024

Déployer des agents d'IA en production avec l'API Gemini

La création et le déploiement d'agents d'IA représentent un domaine passionnant, mais la gestion de ces systèmes complexes dans un environnement de production nécessite une observabilité robuste. AgentOps, un SDK Python pour la surveillance des agents, le suivi des coûts des LLM, le benchmarking et plus encore, permet aux développeurs de faire passer leurs agents du prototype à la production, en particulier lorsqu'il est associé à la puissance et à la rentabilité de l'API Gemini.

Les avantages de Gemini

Adam Silverman, COO d'Agency AI, l'équipe à l'origine d'AgentOps, explique que le coût est un facteur essentiel pour les entreprises qui déploient des agents d'IA à grande échelle. "Nous avons constaté que les entreprises dépensent 80 000 $par mois pour les appels de LLM. Avec Gemini 1.5, cela aurait coûté quelques milliers de dollars pour le même résultat."

Cette rentabilité, combinée aux puissantes capacités de compréhension et de génération du langage de Gemini, en fait un choix idéal pour les développeurs qui créent des agents d'IA sophistiqués. "Gemini 1.5 Flash nous offre une qualité comparable à celle des modèles plus volumineux, à une fraction du coût et avec une rapidité incroyable", explique Silverman. Cela permet aux développeurs de se concentrer sur la création de workflows d'agents complexes en plusieurs étapes sans se soucier des coûts excessifs.

"Nous avons constaté que les exécutions d'agents individuels avec d'autres fournisseurs de LLM coûtent plus de 500 $par exécution. Ces mêmes exécutions avec Gemini (1.5 Flash-8B) coûtent moins de 50 $."

Alimenter les agents IA

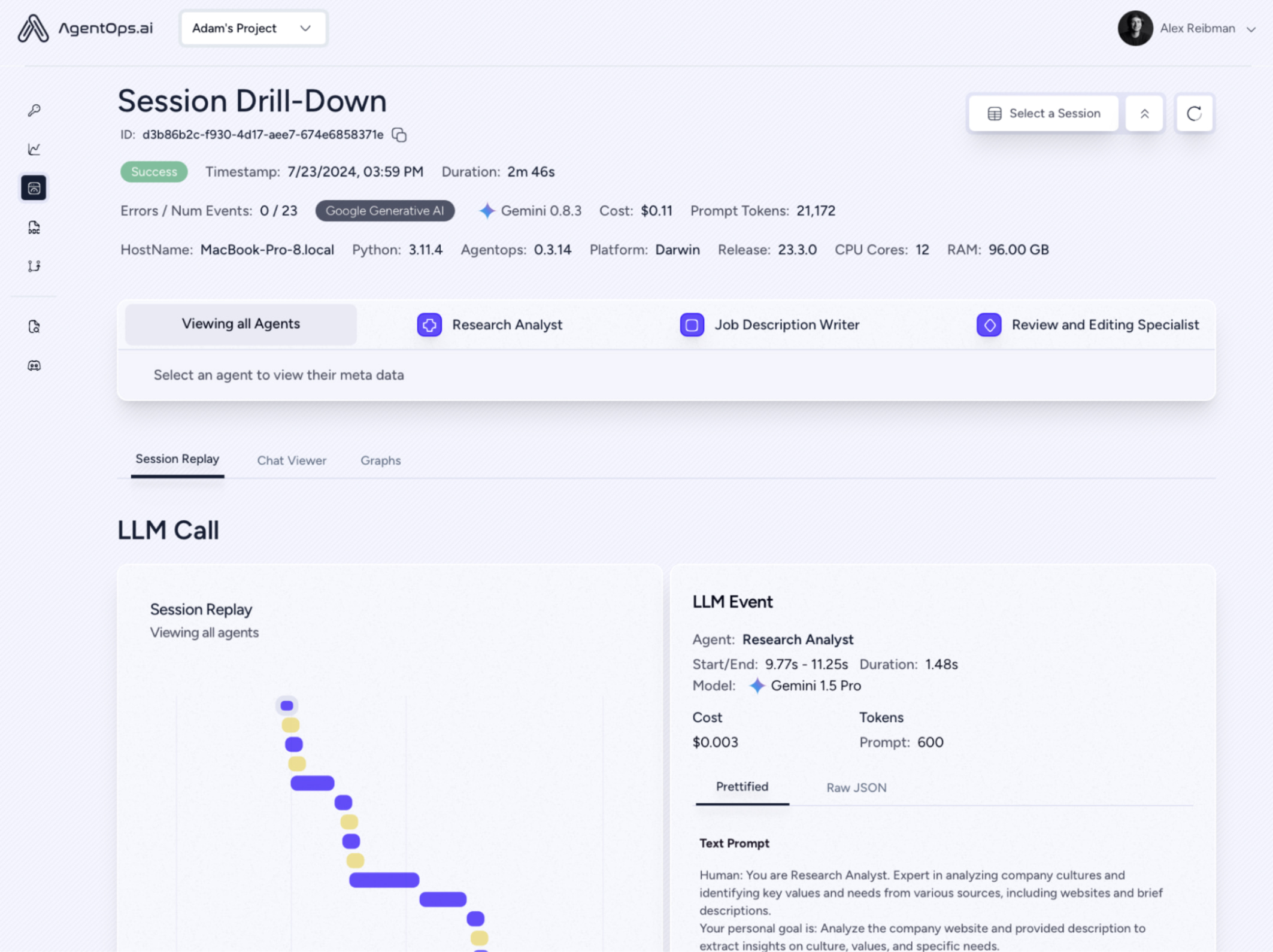

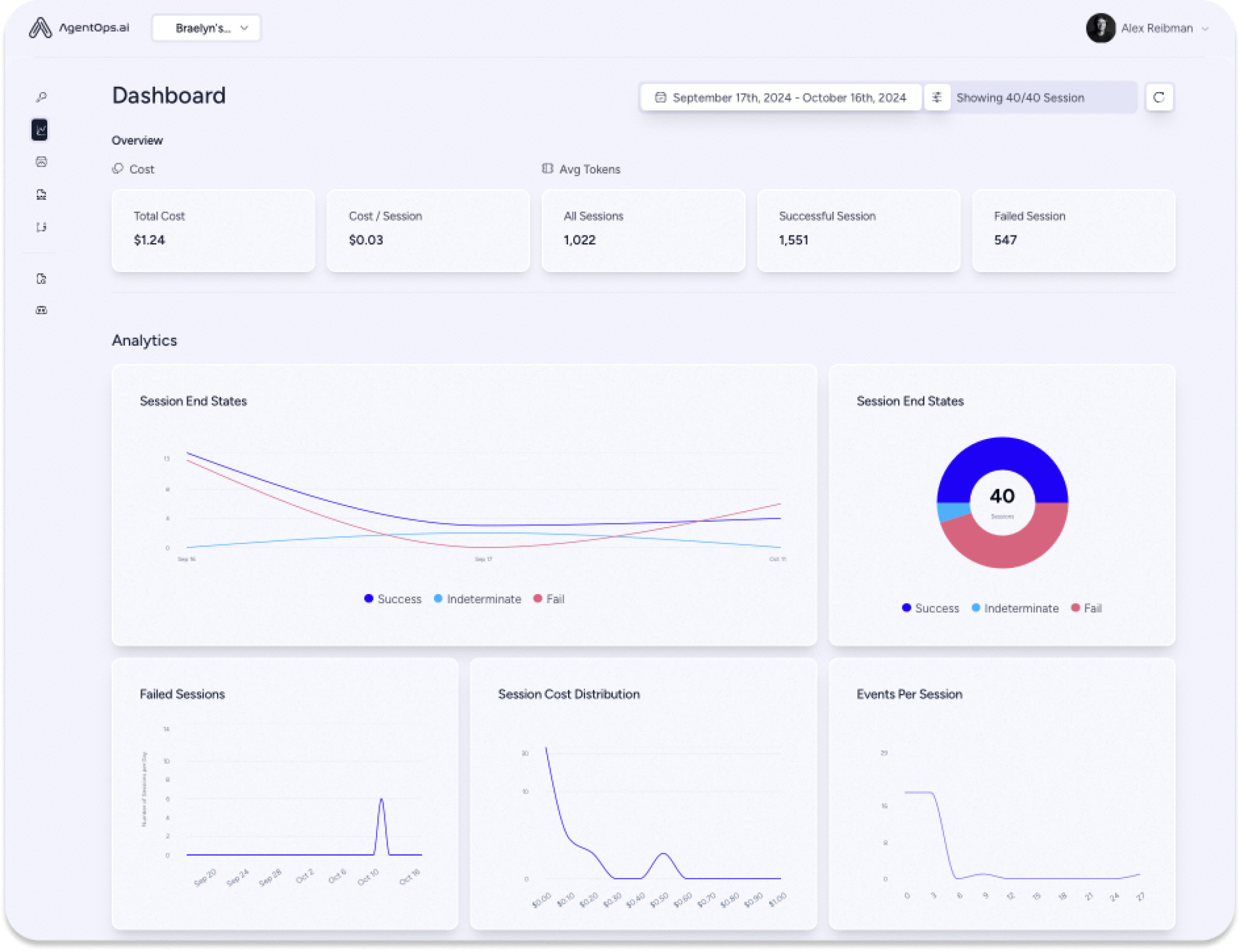

AgentOps capture des données sur chaque interaction d'agent, et pas seulement sur les appels LLM. Vous obtenez ainsi une vue complète du fonctionnement des systèmes multi-agents. Ce niveau de détail précis est essentiel pour les équipes d'ingénierie et de conformité, car il offre des insights cruciaux pour le débogage, l'optimisation et les journaux d'audit.

L'intégration des modèles Gemini à AgentOps est remarquablement simple et ne prend souvent que quelques minutes avec LiteLLM. Les développeurs peuvent rapidement obtenir de la visibilité sur leurs appels d'API Gemini, suivre les coûts en temps réel et assurer la fiabilité de leurs agents en production.

Perspectives

AgentOps s'engage à aider les développeurs d'agents à faire évoluer leurs projets. Agency AI aide les entreprises à créer des agents abordables et évolutifs, ce qui renforce l'intérêt de combiner AgentOps et l'API Gemini. Comme le souligne Silverman, "cela incite les développeurs plus sensibles au prix à créer des agents".

Pour les développeurs qui envisagent d'utiliser Gemini, le conseil de Silverman est clair : "Essayez-le, vous serez impressionné."