Gemini Nano 是 Gemini 模型系列中的最小版本, Google Pixel 8 Pro(搭载 Google Pixel 8 Pro 和 Samsung S24 系列。

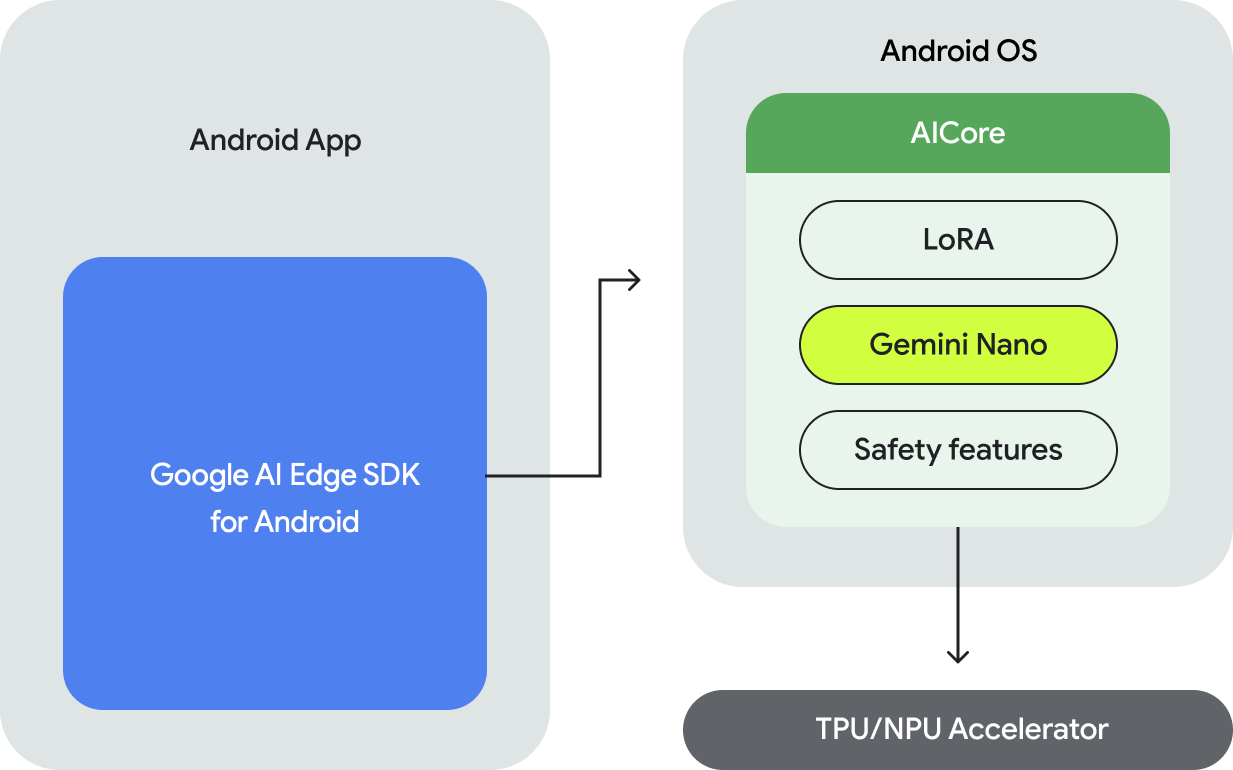

如需在 Android 上执行 Gemini Nano 模型,您需要使用 适用于 Android 的 Google AI Edge SDK,它提供的 API 用于:

- 确定底层 Android 设备是否受支持。

- 使用 Gemini Nano 模型。

- 调整安全设置。

- 以高性能运行推理并实现回退。

- (可选)提供 LoRA 微调块以提高 选择适合你的应用场景的模型。

用于访问 Gemini Nano 的 API 支持文本到文本模态,并且 未来发展模式。

在设备端执行的好处

设备端执行支持以下各项:

- 在本地处理敏感数据:在本地处理数据可以帮助您 避免将用户数据发送到云端这对于处理 敏感数据,例如采用端到端加密的即时通讯应用。

- 离线访问:即使没有 或互联网连接。这对于需要正常运行的应用 或网络连接多变时。

- 节省费用:您可以将执行作业分流到本地,以降低推断费用 消费类硬件。这可以为经常使用的工作负载 用户体验流程

在设备端执行 Gemini 有诸多好处:但对于 需要更大的 Gemini 模型,并且为了支持多种设备,您可能 可以考虑使用 Gemini API 访问服务器上的 Gemini。您 可以通过后端集成(与 Python、 Go、Node.js 或 REST),或直接从 通过新的 Android 版 Google AI 客户端 SDK。

工作原理

Gemini Nano 的设备端执行由 Android AICore 提供支持, 系统级功能,提供对设备端基础模型的访问 Android 14 中引入的新功能。基础模型是使用 AICore,因此您无需在应用中下载或分发它们。您 可以使用 LoRa 为下游任务微调这些模型。Android AICore 现已在 Google Pixel 8 Pro 和 Samsung S24 系列设备上发布正式版 并已在为 Google 应用中的创新功能提供支持。

如需了解详情,请参阅 Android AICore。

后续步骤

- 了解如何在 Google 服务器上利用 Gemini Pro 推断功能 请参阅快速入门: 适用于 Android 的 Google AI 客户端 SDK。