Gemini Nano 是 Gemini 模型系列的最小版本 Gemini 搭載 Android 裝置的功能,從 Google Pixel 8 Pro 開始 Samsung S24 系列

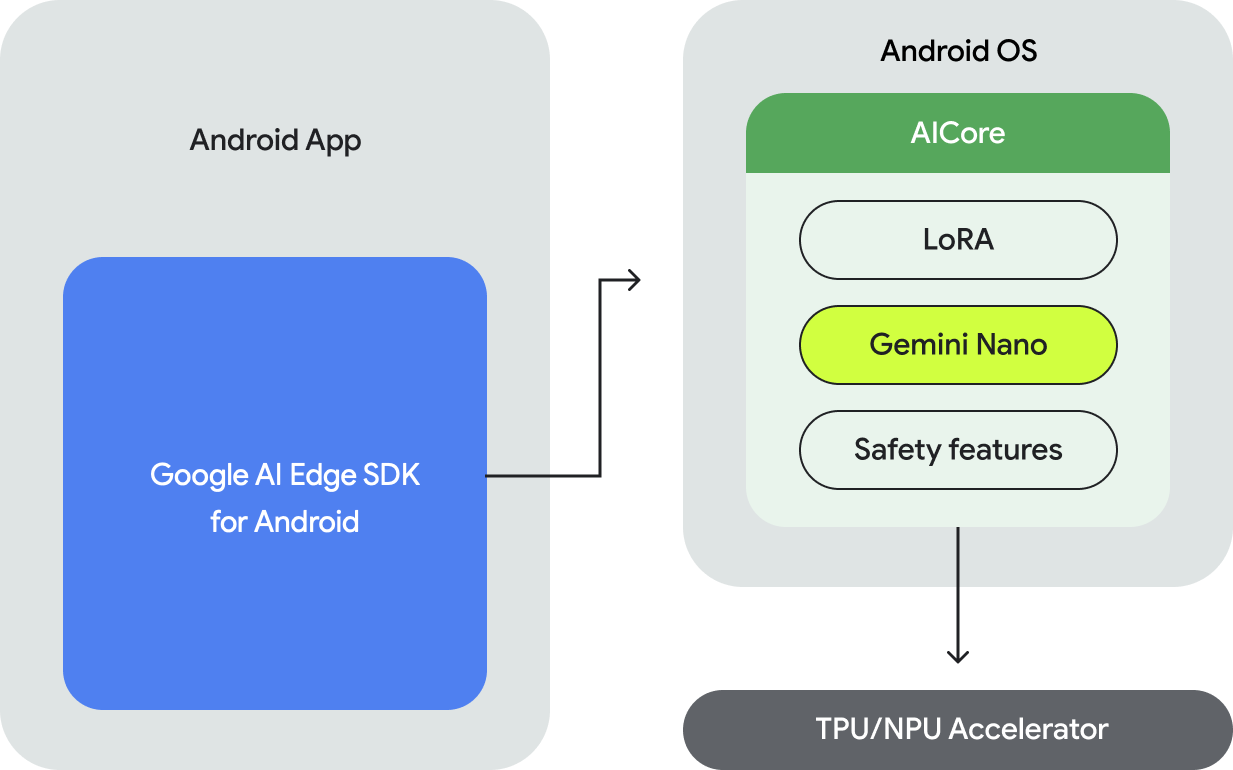

如要在 Android 上執行 Gemini Nano 模型,請使用 Google AI Edge SDK for Android 專為以下用途提供 API:

- 判斷是否支援基礎 Android 裝置。

- 使用 Gemini Nano 模型。

- 調整安全設定。

- 在高效能執行推論並實作備用項目。

- 您也可以視需要提供 LoRA 微調區塊,提升 我們也有專用的模型

用於存取 Gemini Nano 的 API 支援文字轉文字模式,並提供更多功能 。

在裝置上執行的好處

裝置端執行功能可啟用以下功能:

- 在本機處理機密資料:在本機處理資料可協助您 避免將使用者資料傳送至雲端這對於處理 機密資料,例如採用端對端加密的訊息應用程式。

- 離線存取:即使沒有網路,也能使用 AI 功能 網際網路連線。對於需要執行 離線或變換連線方式

- 節省費用:您可以將執行作業卸載至 消費性硬體這麼做可為常用帳戶省下可觀的費用 使用者流程

在裝置端執行 Gemini 有許多優點:但用途 需要較大的 Gemini 模型,而且支援多種裝置 考慮透過 Gemini API 在伺服器上使用 Gemini個人中心 方法有兩種:使用後端整合 (使用 Python、 Go、Node.js 或 REST) 或直接透過 Android 應用程式 適用於 Android 的 Google AI 用戶端 SDK。

運作方式

在裝置端執行 Gemini Nano 採用的是 Android AICore 新推出的 為裝置端提供基礎模型的系統層級功能 執行 (引入 Android 14 版本)基礎模型會透過 AICore,不必在應用程式中下載或發布這些內容。個人中心 可使用 LoRa 微調這些模型以進行下游工作Android AICore 已 Google Pixel 8 Pro 和 Samsung S24 系列裝置現已推出正式版 並已開始支援 Google 應用程式的創新功能

詳情請參閱「Android AICore」。

後續步驟

- 瞭解如何在 Google 伺服器中運用 Gemini Pro 推論 請參閱這份 Android 版 Google AI 用戶端 SDK。