Gemini Nano(Gemini モデル ファミリーの最小バージョン)を実行可能 オンデバイス(Google Pixel 8 Pro 以降に対応する Android デバイス) Samsung S24 シリーズ。

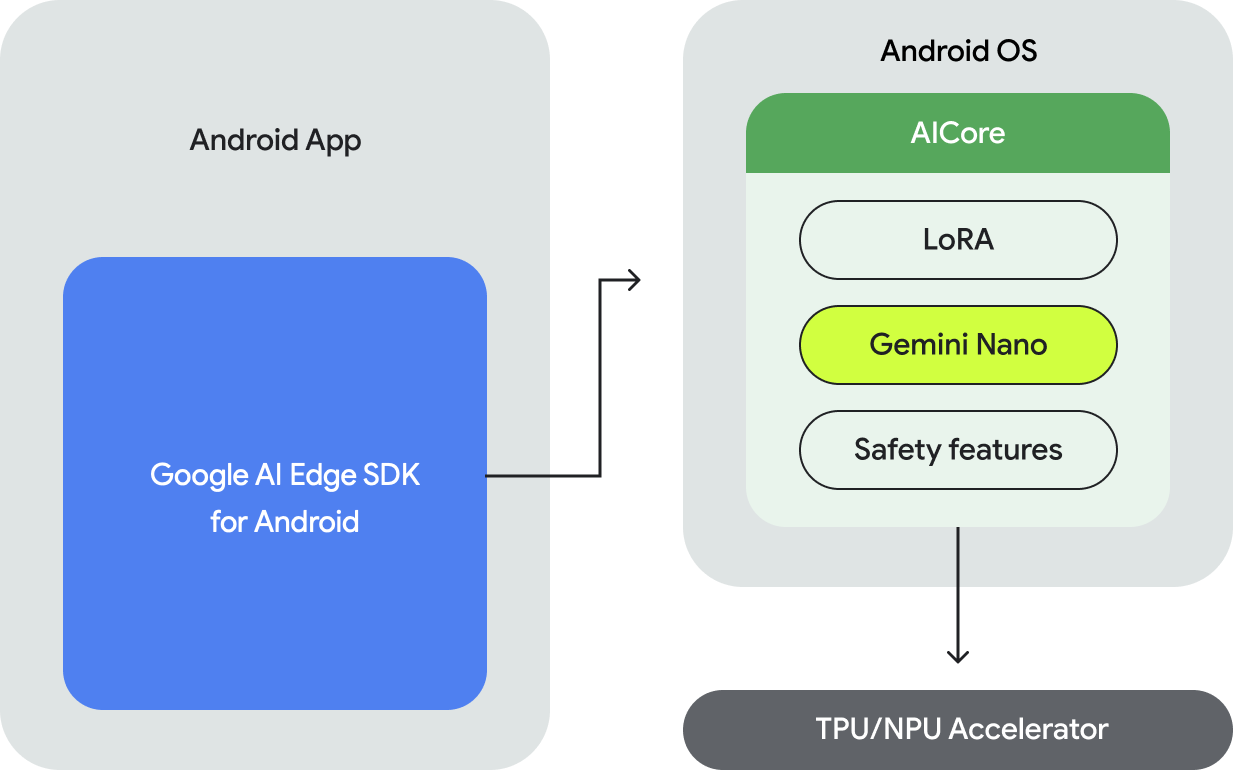

Android で Gemini Nano モデルを実行するには、 Google AI Edge SDK for Android。以下を行うための API を提供します。

- 搭載されている Android 搭載デバイスがサポートされているかどうかを確認します。

- Gemini Nano モデルにアクセスします。

- 安全性設定を調整する。

- 高パフォーマンスで推論を実行し、フォールバックを実装します。

- 必要に応じて、LoRA ファインチューニング ブロックを提供して、 最適なモデルを見つけることです

Gemini Nano にアクセスするための API は、テキストからテキストへのモダリティをサポートしています。 モダリティにも対応する予定です。

オンデバイス実行のメリット

オンデバイス実行により、以下が可能になります。

- センシティブ データのローカル処理: データをローカルに処理することで、 ユーザーデータをクラウドに送信せずに済みますこれは、アプリでの エンドツーエンドの暗号化を使用するメッセージ アプリなど、センシティブ データを保護できます。

- オフライン アクセス: オフライン アクセスがない場合でも、ユーザーは インターネット接続ですこれは、ソフトウェアを動作させる必要がある 接続が不安定な場合に適しています

- コスト削減: 実行をオフロードすることで、推論にかかる費用を削減できます。 保護します。これにより、頻繁に使用するサービスに対して できます。

Gemini をデバイス上で実行すると、多くのメリットがあります。ただし、Google Cloud で より大規模な Gemini モデルが必要であり、幅広いデバイスをサポートするために、 サーバー上の Gemini へのアクセスに Gemini API の使用を検討したいとお考えの場合は、マイページ これは、バックエンドの統合(Python、 Go、Node.js、REST)で定義することも、 Android アプリの Android 用 Google AI クライアント SDK。

仕組み

Gemini Nano のオンデバイス実行には、新しい Android AICore が活用されています。 デバイス上の基盤モデルへのアクセスを提供するシステムレベルの機能 Android 14 で導入されました。基盤モデルは、Cloud KMS 鍵を使用してプリインストール アプリ内でダウンロードしたり配布したりする必要はありません。マイページ LoRa を使用してダウンストリーム タスク向けにこれらのモデルを微調整できます。Android AICore は Google Pixel 8 Pro と Samsung S24 シリーズのデバイスで製品版で利用可能に Google アプリの革新的な機能を実現しています。

詳細については、Android AICore をご覧ください。

次のステップ

- Google のサーバーで Gemini Pro の推論を利用する方法を学習するため については、クイックスタート: Android 用 Google AI クライアント SDK をご覧ください。