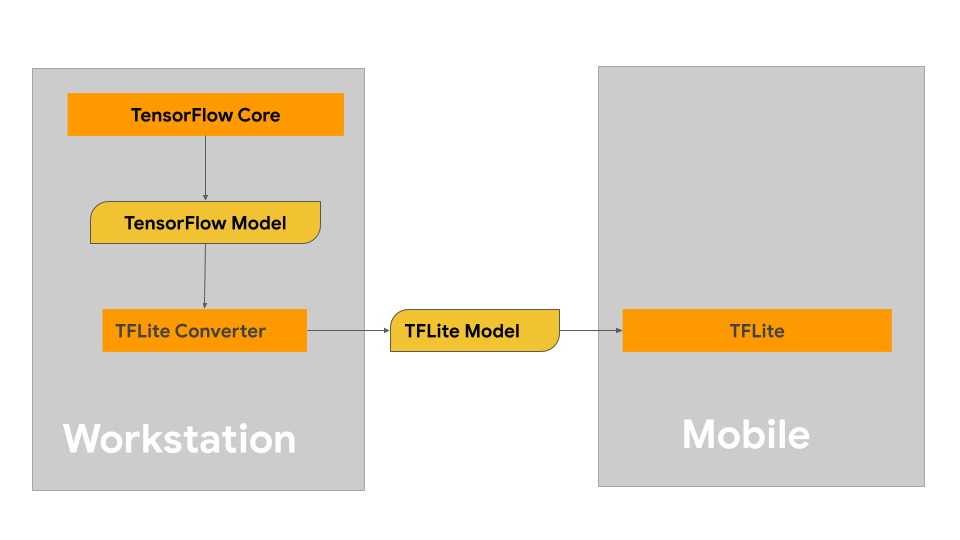

En esta página, se proporciona orientación para compilar tus modelos de TensorFlow con la intención de convertirlos al formato de modelo de LiteRT. Los modelos de aprendizaje automático (AA) que usas con LiteRT se compilan y entrenan originalmente con las herramientas y bibliotecas principales de TensorFlow. Una vez que hayas creado un modelo con TensorFlow Core, puedes convertirlo a un formato de modelo de AA más pequeño y eficiente llamado modelo de LiteRT.

Si ya tienes un modelo para convertir, consulta la página de Descripción general de la conversión de modelos para obtener orientación sobre cómo convertir tu modelo.

Cómo crear tu modelo

Si compilas un modelo personalizado para tu caso de uso específico, debes comenzar por desarrollar y entrenar un modelo de TensorFlow o extender uno existente.

Restricciones de diseño del modelo

Antes de comenzar el proceso de desarrollo del modelo, debes conocer las restricciones de los modelos de LiteRT y crear tu modelo teniendo en cuenta estas restricciones:

- Capacidades de procesamiento limitadas: En comparación con los servidores completamente equipados con varias CPU, alta capacidad de memoria y procesadores especializados, como GPU y TPU, los dispositivos móviles y perimetrales son mucho más limitados. Si bien su potencia de procesamiento y compatibilidad con hardware especializado están en aumento, los modelos y los datos que puedes procesar de manera eficaz con ellos siguen siendo comparativamente limitados.

- Tamaño de los modelos: La complejidad general de un modelo, incluida la lógica de preprocesamiento de datos y la cantidad de capas del modelo, aumenta el tamaño en la memoria del modelo. Un modelo grande puede ejecutarse de forma inaceptablemente lenta o simplemente no caber en la memoria disponible de un dispositivo móvil o perimetral.

- Tamaño de los datos: El tamaño de los datos de entrada que se pueden procesar de manera eficaz con un modelo de aprendizaje automático es limitado en un dispositivo móvil o perimetral. Los modelos que usan grandes bibliotecas de datos, como bibliotecas de idiomas, bibliotecas de imágenes o bibliotecas de clips de video, es posible que no quepan en estos dispositivos y que requieran soluciones de almacenamiento y acceso fuera del dispositivo.

- Operaciones de TensorFlow compatibles: Los entornos de ejecución de LiteRT admiten un subconjunto de operaciones de modelos de aprendizaje automático en comparación con los modelos de TensorFlow normales. A medida que desarrollas un modelo para usarlo con LiteRT, debes hacer un seguimiento de la compatibilidad de tu modelo con las capacidades de los entornos de ejecución de LiteRT.

Para obtener más información sobre cómo compilar modelos eficaces, compatibles y de alto rendimiento para LiteRT, consulta Prácticas recomendadas de rendimiento.

Desarrollo del modelo

Para compilar un modelo de LiteRT, primero debes compilar un modelo con las bibliotecas principales de TensorFlow. Las bibliotecas principales de TensorFlow son las bibliotecas de nivel inferior que proporcionan APIs para compilar, entrenar e implementar modelos de AA.

TensorFlow proporciona dos rutas para hacerlo. Puedes desarrollar tu propio código de modelo personalizado o comenzar con una implementación de modelo disponible en Model Garden de TensorFlow.

Model Garden

TensorFlow Model Garden proporciona implementaciones de muchos modelos de aprendizaje automático (AA) de vanguardia para la visión y el procesamiento de lenguaje natural (PLN). También encontrarás herramientas de flujo de trabajo que te permitirán configurar y ejecutar rápidamente esos modelos en conjuntos de datos estándar. Los modelos de aprendizaje automático en Model Garden incluyen código completo para que puedas probarlos, entrenarlos o volver a entrenarlos con tus propios conjuntos de datos.

Ya sea que desees comparar el rendimiento de un modelo conocido, verificar los resultados de investigaciones publicadas recientemente o extender modelos existentes, Model Garden puede ayudarte a alcanzar tus objetivos de AA.

Modelos personalizados

Si tu caso de uso no se encuentra entre los que admiten los modelos en Model Garden, puedes usar una biblioteca de alto nivel, como Keras, para desarrollar tu código de entrenamiento personalizado. Para aprender los conceptos básicos de TensorFlow, consulta la guía de TensorFlow. Para comenzar con los ejemplos, consulta la descripción general de los instructivos de TensorFlow, que contiene punteros a instructivos para principiantes y expertos.

Evaluación del modelo

Una vez que desarrolles tu modelo, debes evaluar su rendimiento y probarlo en dispositivos de usuarios finales. TensorFlow ofrece varias formas de hacerlo.

- TensorBoard es una herramienta que proporciona las mediciones y las visualizaciones necesarias durante el flujo de trabajo de aprendizaje automático. Permite hacer un seguimiento de las métricas del experimento, como la pérdida y la exactitud, visualizar el grafo del modelo, proyectar incorporaciones en un espacio de menor dimensión y mucho más.

- Las herramientas de comparativas están disponibles para cada plataforma compatible, como la app de comparativas de Android y la app de comparativas de iOS. Usa estas herramientas para medir y calcular estadísticas de métricas de rendimiento importantes.

Optimización de modelos

Con las restricciones sobre los recursos específicos de los modelos de TensorFlow Lite, la optimización del modelo puede ayudar a garantizar que el modelo funcione bien y use menos recursos de procesamiento. El rendimiento de los modelos de aprendizaje automático suele ser un equilibrio entre el tamaño y la velocidad de la inferencia, por un lado, y la precisión, por el otro. Actualmente, LiteRT admite la optimización a través de la cuantización, la poda y el agrupamiento en clústeres. Consulta el tema sobre la optimización de modelos para obtener más detalles sobre estas técnicas. TensorFlow también proporciona un kit de herramientas de optimización de modelos que incluye una API que implementa estas técnicas.

Próximos pasos

- Para comenzar a crear tu modelo personalizado, consulta el instructivo de inicio rápido para principiantes en la documentación principal de TensorFlow.

- Para convertir tu modelo personalizado de TensorFlow, consulta la descripción general de la conversión de modelos.

- Consulta la guía de compatibilidad de operadores para determinar si tu modelo es compatible con LiteRT o si deberás seguir pasos adicionales para que lo sea.

- Consulta la guía de prácticas recomendadas para el rendimiento y obtén orientación para que tus modelos de LiteRT sean eficientes y tengan un buen rendimiento.

- Consulta la guía de métricas de rendimiento para aprender a medir el rendimiento de tu modelo con herramientas de comparativas.