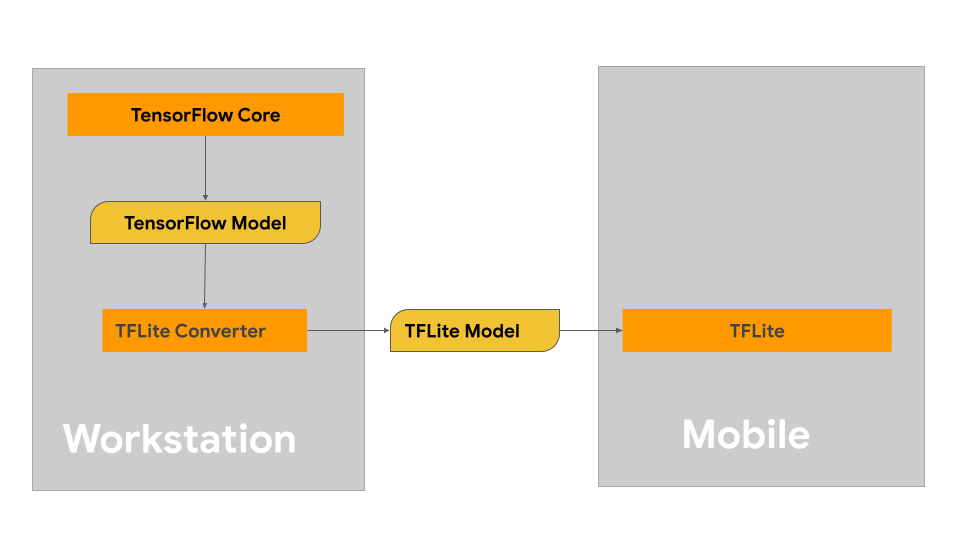

Kjo faqe ofron udhëzime për ndërtimin e modeleve tuaja TensorFlow me qëllim konvertimin në formatin e modelit LiteRT. Modelet e të mësuarit automatik (ML) që përdorni me LiteRT fillimisht ndërtohen dhe trajnohen duke përdorur bibliotekat dhe mjetet kryesore të TensorFlow. Pasi të keni ndërtuar një model me bërthamën TensorFlow, mund ta konvertoni atë në një format modeli ML më të vogël dhe më efikas të quajtur model LiteRT.

Nëse keni tashmë një model për të konvertuar, shihni faqen e përgjithshme të Konvertimit të modeleve për udhëzime se si ta konvertoni modelin tuaj.

Ndërtimi i modelit tuaj

Nëse po ndërtoni një model të personalizuar për rastin tuaj specifik të përdorimit, duhet të filloni me zhvillimin dhe trajnimin e një modeli TensorFlow ose zgjerimin e një modeli ekzistues.

Kufizimet e projektimit të modelit

Para se të filloni procesin e zhvillimit të modelit tuaj, duhet të jeni të vetëdijshëm për kufizimet për modelet LiteRT dhe ta ndërtoni modelin tuaj duke pasur parasysh këto kufizime:

- Aftësi të kufizuara llogaritëse - Krahasuar me serverat e pajisur plotësisht me CPU të shumta, kapacitet të lartë memorieje dhe procesorë të specializuar si GPU dhe TPU, pajisjet mobile dhe ato periferike janë shumë më të kufizuara. Ndërsa ato po rriten në fuqinë llogaritëse dhe përputhshmërinë e specializuar të harduerit, modelet dhe të dhënat që mund të përpunoni në mënyrë efektive me to janë ende relativisht të kufizuara.

- Madhësia e modeleve - Kompleksiteti i përgjithshëm i një modeli, duke përfshirë logjikën e para-përpunimit të të dhënave dhe numrin e shtresave në model, rrit madhësinë e memories së një modeli. Një model i madh mund të funksionojë në mënyrë të papranueshme ngadalë ose thjesht mund të mos përshtatet në memorien e disponueshme të një pajisjeje celulare ose periferike.

- Madhësia e të dhënave - Madhësia e të dhënave hyrëse që mund të përpunohen në mënyrë efektive me një model të të mësuarit automatik është e kufizuar në një pajisje celulare ose periferike. Modelet që përdorin biblioteka të mëdha të të dhënave, të tilla si bibliotekat e gjuhëve, bibliotekat e imazheve ose bibliotekat e klipeve video, mund të mos përshtaten në këto pajisje dhe mund të kërkojnë zgjidhje ruajtjeje dhe aksesi jashtë pajisjes.

- Operacionet e mbështetura të TensorFlow - Mjediset e ekzekutimit LiteRT mbështesin një nëngrup të operacioneve të modelit të të mësuarit automatik krahasuar me modelet e rregullta të TensorFlow. Ndërsa zhvilloni një model për përdorim me LiteRT, duhet të gjurmoni përputhshmërinë e modelit tuaj kundrejt aftësive të mjediseve të ekzekutimit LiteRT.

Për më shumë informacion mbi ndërtimin e modeleve efektive, të pajtueshme dhe me performancë të lartë për LiteRT, shihni Praktikat më të mira të performancës .

Zhvillimi i modelit

Për të ndërtuar një model LiteRT, së pari duhet të ndërtoni një model duke përdorur bibliotekat kryesore të TensorFlow. Bibliotekat kryesore të TensorFlow janë bibliotekat e nivelit më të ulët që ofrojnë API për të ndërtuar, trajnuar dhe vendosur modele ML.

TensorFlow ofron dy rrugë për ta bërë këtë. Ju mund të zhvilloni kodin tuaj të modelit të personalizuar ose mund të filloni me një implementim modeli të disponueshëm në Kopshtin e Modeleve TensorFlow.

Kopsht Modeli

Kopshti i Modeleve TensorFlow ofron zbatime të shumë modeleve të të mësuarit automatik (ML) të teknologjisë së fundit për përpunimin e vizionit dhe gjuhës natyrore (NLP). Gjithashtu, do të gjeni mjete të rrjedhës së punës që ju lejojnë të konfiguroni dhe ekzekutoni shpejt këto modele në grupe standarde të të dhënave. Modelet e të mësuarit automatik në Kopshtin e Modeleve përfshijnë kod të plotë, kështu që mund t'i testoni, trajnoni ose ritrajnoni ato duke përdorur grupet tuaja të të dhënave.

Nëse doni të krahasoni performancën për një model të njohur, të verifikoni rezultatet e hulumtimeve të publikuara së fundmi ose të zgjeroni modelet ekzistuese, Kopshti i Modeleve mund t'ju ndihmojë të arrini qëllimet tuaja të ML-së.

Modele të personalizuara

Nëse rasti juaj i përdorimit është jashtë atyre të mbështetura nga modelet në Model Garden, mund të përdorni një bibliotekë të nivelit të lartë si Keras për të zhvilluar kodin tuaj të trajnimit të personalizuar. Për të mësuar bazat e TensorFlow, shihni udhëzuesin TensorFlow . Për të filluar me shembuj, shihni përmbledhjen e tutorialeve të TensorFlow të cilat përmbajnë udhëzime për tutoriale nga niveli fillestar deri në atë të nivelit ekspert.

Vlerësimi i modelit

Pasi ta keni zhvilluar modelin tuaj, duhet të vlerësoni performancën e tij dhe ta testoni atë në pajisjet e përdoruesit fundor. TensorFlow ofron disa mënyra për ta bërë këtë.

- TensorBoard është një mjet për të ofruar matjet dhe vizualizimet e nevojshme gjatë rrjedhës së punës së të mësuarit automatik. Ai mundëson gjurmimin e metrikave të eksperimentit si humbja dhe saktësia, vizualizimin e grafikut të modelit, projektimin e ngulitjeve në një hapësirë me dimensione më të ulëta dhe shumë më tepër.

- Mjetet e krahasimit janë të disponueshme për secilën platformë të mbështetur, siç është aplikacioni i krahasimit për Android dhe aplikacioni i krahasimit për iOS. Përdorni këto mjete për të matur dhe llogaritur statistikat për metrika të rëndësishme të performancës.

Optimizimi i modelit

Me kufizimet në burimet specifike për modelet TensorFlow Lite, optimizimi i modelit mund të ndihmojë në sigurimin e performancës së mirë të modelit tuaj dhe përdor më pak burime llogaritëse. Performanca e modelit të të mësuarit automatik zakonisht është një ekuilibër midis madhësisë dhe shpejtësisë së përfundimit kundrejt saktësisë. LiteRT aktualisht mbështet optimizimin nëpërmjet kuantizimit, krasitjes dhe grupimit. Shihni temën e optimizimit të modelit për më shumë detaje mbi këto teknika. TensorFlow gjithashtu ofron një set mjetesh për optimizimin e modelit i cili ofron një API që zbaton këto teknika.

Hapat e ardhshëm

- Për të filluar ndërtimin e modelit tuaj të personalizuar, shihni tutorialin e shpejtë për fillestarët në dokumentacionin bazë të TensorFlow.

- Për të konvertuar modelin tuaj të personalizuar TensorFlow, shihni përmbledhjen e modeleve të konvertimit .

- Shihni udhëzuesin e përputhshmërisë së operatorit për të përcaktuar nëse modeli juaj është i përputhshëm me LiteRT ose nëse do t'ju duhet të ndërmerrni hapa shtesë për ta bërë atë të përputhshëm.

- Shihni udhëzuesin e praktikave më të mira të performancës për udhëzime se si t'i bëni modelet tuaja LiteRT efikase dhe performuese.

- Shihni udhëzuesin e metrikave të performancës për të mësuar se si të matni performancën e modelit tuaj duke përdorur mjete krahasimi.