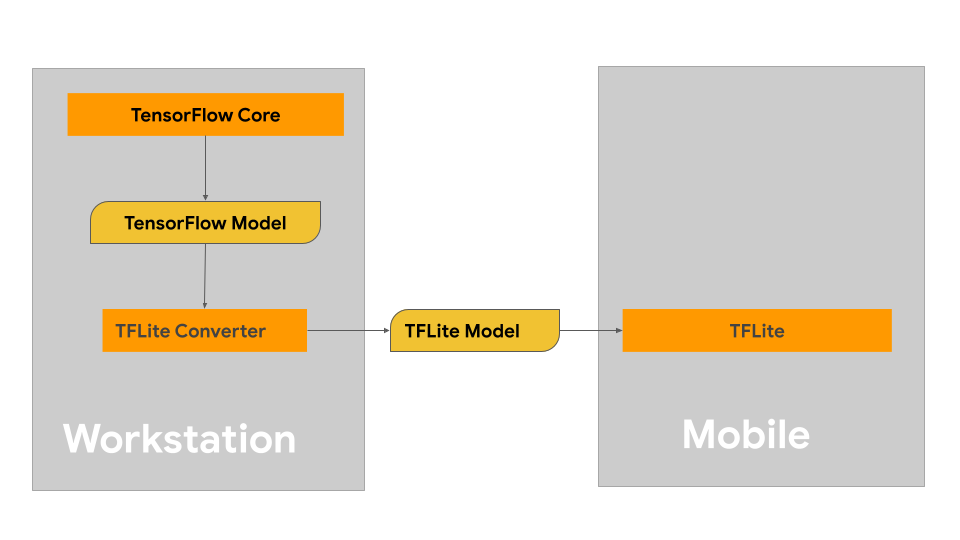

หน้านี้ให้คำแนะนำในการสร้างโมเดล TensorFlow โดยมีจุดประสงค์เพื่อแปลงเป็นรูปแบบโมเดล LiteRT โมเดลแมชชีนเลิร์นนิง (ML) ที่คุณใช้กับ LiteRT สร้างและฝึกโดยใช้ไลบรารีและเครื่องมือหลักของ TensorFlow เมื่อสร้างโมเดลด้วย TensorFlow Core แล้ว คุณจะแปลงโมเดลเป็นรูปแบบโมเดล ML ที่มีขนาดเล็กลงและมีประสิทธิภาพมากขึ้นที่เรียกว่าโมเดล LiteRT ได้

หากมีโมเดลที่ต้องการแปลงอยู่แล้ว โปรดดูคําแนะนําในการแปลงโมเดลในหน้าภาพรวมการแปลงโมเดล

การสร้างโมเดล

หากคุณกำลังสร้างโมเดลที่กำหนดเองสำหรับกรณีการใช้งานที่เฉพาะเจาะจง คุณควรเริ่มต้นด้วยการพัฒนาและฝึกโมเดล TensorFlow หรือขยายโมเดลที่มีอยู่

ข้อจำกัดในการออกแบบโมเดล

ก่อนเริ่มกระบวนการพัฒนาโมเดล คุณควรทราบข้อจำกัดสำหรับโมเดล LiteRT และสร้างโมเดลโดยคำนึงถึงข้อจำกัดเหล่านี้

- ความสามารถในการประมวลผลที่จำกัด - อุปกรณ์เคลื่อนที่และอุปกรณ์ Edge มีข้อจำกัดมากกว่าเซิร์ฟเวอร์ที่มีอุปกรณ์ครบครันซึ่งมี CPU หลายตัว ความจุหน่วยความจำสูง และโปรเซสเซอร์เฉพาะทาง เช่น GPU และ TPU แม้ว่าโมเดลจะ มีกำลังประมวลผลเพิ่มขึ้นและมีความเข้ากันได้กับฮาร์ดแวร์เฉพาะทาง แต่โมเดล และข้อมูลที่คุณประมวลผลได้อย่างมีประสิทธิภาพก็ยังคงมีข้อจำกัดอยู่

- ขนาดของโมเดล - ความซับซ้อนโดยรวมของโมเดล รวมถึงตรรกะการประมวลผลข้อมูลเบื้องต้นและจำนวนเลเยอร์ในโมเดล จะเพิ่มขนาดในหน่วยความจำของโมเดล โมเดลขนาดใหญ่อาจทำงานช้าเกินไปจนรับไม่ได้ หรืออาจ ไม่พอดีกับหน่วยความจำที่มีอยู่ในอุปกรณ์เคลื่อนที่หรืออุปกรณ์ Edge

- ขนาดของข้อมูล - ขนาดของข้อมูลอินพุตที่ประมวลผลได้อย่างมีประสิทธิภาพ ด้วยโมเดลแมชชีนเลิร์นนิงจะถูกจำกัดในอุปกรณ์เคลื่อนที่หรืออุปกรณ์ Edge โมเดล ที่ใช้คลังข้อมูลขนาดใหญ่ เช่น คลังภาษา คลังรูปภาพ หรือคลังวิดีโอคลิป อาจไม่พอดีกับอุปกรณ์เหล่านี้ และอาจต้องใช้ โซลูชันการจัดเก็บและการเข้าถึงนอกอุปกรณ์

- การดำเนินการ TensorFlow ที่รองรับ - สภาพแวดล้อมรันไทม์ LiteRT รองรับการดำเนินการโมเดลแมชชีนเลิร์นนิงบางส่วนเมื่อเทียบกับโมเดล TensorFlow ปกติ ขณะพัฒนาโมเดลเพื่อใช้กับ LiteRT คุณควรติดตาม ความเข้ากันได้ของโมเดลกับความสามารถของสภาพแวดล้อม รันไทม์ของ LiteRT

ดูข้อมูลเพิ่มเติมเกี่ยวกับการสร้างโมเดลที่มีประสิทธิภาพ เข้ากันได้ และมีประสิทธิภาพสูงสำหรับ LiteRT ได้ที่แนวทางปฏิบัติแนะนำด้านประสิทธิภาพ

การพัฒนาโมเดล

หากต้องการสร้างโมเดล LiteRT คุณต้องสร้างโมเดลโดยใช้ไลบรารีหลักของ TensorFlow ก่อน ไลบรารีหลักของ TensorFlow เป็นไลบรารีระดับล่างที่ มี API สำหรับสร้าง ฝึก และทำให้โมเดล ML ใช้งานได้

TensorFlow มี 2 เส้นทางในการดำเนินการนี้ คุณสามารถพัฒนาโค้ดโมเดลที่กำหนดเองของคุณเอง หรือจะเริ่มต้นด้วยการติดตั้งใช้งานโมเดลที่มีอยู่ใน Model Garden ของ TensorFlow ก็ได้

Model Garden

TensorFlow Model Garden มีการใช้งานโมเดลแมชชีนเลิร์นนิง (ML) ที่ล้ำสมัยมากมาย สำหรับการมองเห็นและการประมวลผลภาษาธรรมชาติ (NLP) นอกจากนี้ คุณยังจะเห็นเครื่องมือเวิร์กโฟลว์ที่ช่วยให้คุณกำหนดค่าและเรียกใช้โมเดลเหล่านั้นในชุดข้อมูลมาตรฐานได้อย่างรวดเร็ว โมเดลแมชชีนเลิร์นนิงใน Model Garden มีโค้ดทั้งหมดเพื่อให้คุณทดสอบ ฝึก หรือฝึกซ้ำได้โดยใช้ชุดข้อมูลของคุณเอง

ไม่ว่าคุณจะต้องการเปรียบเทียบประสิทธิภาพของโมเดลที่รู้จักกันดี ยืนยันผลการวิจัยที่เพิ่งเผยแพร่ หรือขยายโมเดลที่มีอยู่ Model Garden ก็ช่วยให้คุณบรรลุเป้าหมาย ML ได้

โมเดลที่กำหนดเอง

หากกรณีการใช้งานของคุณอยู่นอกเหนือจากที่โมเดลใน Model Garden รองรับ คุณสามารถใช้ไลบรารีระดับสูง เช่น Keras เพื่อพัฒนา โค้ดการฝึกที่กำหนดเองได้ ดูข้อมูลพื้นฐานของ TensorFlow ได้ที่คู่มือ TensorFlow หากต้องการเริ่มต้นใช้งานตัวอย่าง โปรดดูภาพรวมของบทแนะนำ TensorFlow ซึ่งมีเคล็ดลับสำหรับบทแนะนำตั้งแต่ระดับเริ่มต้นจนถึงระดับผู้เชี่ยวชาญ

การประเมินโมเดล

เมื่อพัฒนาโมเดลแล้ว คุณควรประเมินประสิทธิภาพและทดสอบ ในอุปกรณ์ของผู้ใช้ปลายทาง TensorFlow มีวิธีดำเนินการนี้อยู่ 2-3 วิธี

- TensorBoard เป็นเครื่องมือสำหรับแสดงการวัดและการแสดงภาพที่จำเป็นในระหว่าง เวิร์กโฟลว์แมชชีนเลิร์นนิง ซึ่งช่วยให้ติดตามเมตริกการทดสอบ เช่น การสูญเสีย และความแม่นยำ แสดงภาพกราฟโมเดล โปรเจ็กต์การฝังไปยังพื้นที่ที่มีมิติ ต่ำกว่า และอื่นๆ อีกมากมาย

- เครื่องมือเปรียบเทียบพร้อมใช้งานสำหรับแต่ละแพลตฟอร์มที่รองรับ เช่น แอปเปรียบเทียบ Android และแอปเปรียบเทียบ iOS ใช้เครื่องมือเหล่านี้เพื่อวัดและคำนวณสถิติสำหรับเมตริกประสิทธิภาพที่สำคัญ

การเพิ่มประสิทธิภาพโมเดล

เมื่อมีข้อจำกัดเกี่ยวกับทรัพยากรที่เฉพาะเจาะจงสำหรับโมเดล TensorFlow Lite การเพิ่มประสิทธิภาพโมเดลจะช่วยให้มั่นใจได้ว่าโมเดลทำงานได้ดี และใช้ทรัพยากรการคำนวณน้อยลง โดยปกติแล้วประสิทธิภาพของโมเดลแมชชีนเลิร์นนิงจะ ขึ้นอยู่กับขนาดและความเร็วของการอนุมานเทียบกับความแม่นยำ ปัจจุบัน LiteRT รองรับการเพิ่มประสิทธิภาพผ่านการหาปริมาณ การตัดแต่ง และการจัดกลุ่ม ดูรายละเอียดเพิ่มเติมเกี่ยวกับเทคนิคเหล่านี้ได้ที่หัวข้อการเพิ่มประสิทธิภาพ โมเดล นอกจากนี้ TensorFlow ยังมีชุดเครื่องมือเพิ่มประสิทธิภาพโมเดล ซึ่งมี API ที่ใช้เทคนิคเหล่านี้

ขั้นตอนถัดไป

- หากต้องการเริ่มสร้างโมเดลที่กำหนดเอง โปรดดูบทแนะนำคู่มือเริ่มต้นฉบับย่อสำหรับผู้เริ่มต้น ในเอกสารประกอบหลักของ TensorFlow

- หากต้องการแปลงโมเดล TensorFlow ที่กำหนดเอง โปรดดูภาพรวมการแปลงโมเดล

- ดูคู่มือความเข้ากันได้ของผู้ให้บริการเพื่อพิจารณาว่ารุ่นของคุณเข้ากันได้กับ LiteRT หรือไม่ หรือคุณจะต้องทำตามขั้นตอนเพิ่มเติมเพื่อให้เข้ากันได้

- ดูคำแนะนำเกี่ยวกับ การทำให้โมเดล LiteRT มีประสิทธิภาพและทำงานได้ดีในคู่มือแนวทางปฏิบัติแนะนำด้านประสิทธิภาพ

- ดูคู่มือเมตริกประสิทธิภาพเพื่อดูวิธีวัด ประสิทธิภาพของโมเดลโดยใช้เครื่องมือเปรียบเทียบ