エッジ プラットフォームでの高性能 ML と生成 AI のデプロイ

デバイス上の ML の効率的な変換、ランタイム、最適化。

TensorFlow Lite の実績ある基盤上に構築

LiteRT は単に新しいだけでなく、世界で最も広く導入されている機械学習ランタイムの次世代版です。この技術は、日常的に使用するアプリを支え、数十億台のデバイスで低レイテンシと高いプライバシー保護を実現しています。

最も重要な Google アプリで信頼されている

10 万件以上のアプリケーション、数十億人のグローバル ユーザー

LiteRT のハイライト

クロス プラットフォーム対応

生成 AI を活用する

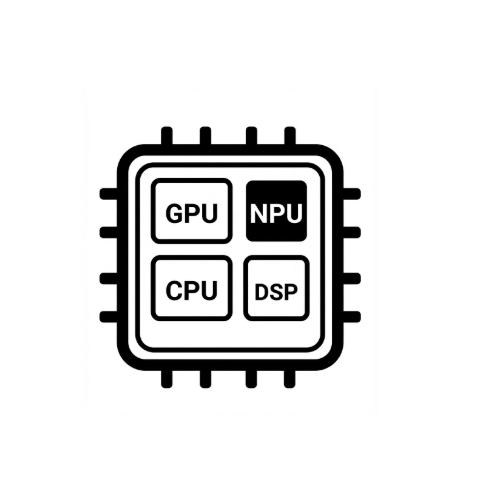

簡素化されたハードウェア アクセラレーション

マルチ フレームワークのサポート

LiteRT 経由でデプロイする

モデルを取得する

.tflite 事前トレーニング済みモデルを使用するか、PyTorch、JAX、TensorFlow モデルを .tflite に変換する

モデルを最適化する

(省略可)モデルを量子化する

実行

目的のアクセラレータを選択して LiteRT で実行する

サンプル、モデル、デモ

サンプルアプリを見る

包括的で完全な例を挙げながら LiteRT の使い方を説明するチュートリアルです。

生成 AI モデルを参照する

事前トレーニング済みで、すぐに使用できる生成 AI モデル。

デモを見る - Google AI Edge ギャラリー アプリ

オンデバイス ML/生成 AI のユースケースを紹介するギャラリー