Wdrożenie wydajnych modeli ML i generatywnej AI na platformach brzegowych

Wydajne konwersje, czas działania i optymalizacja na potrzeby uczenia maszynowego na urządzeniu.

Oparta na sprawdzonej platformie TensorFlow Lite

LiteRT to nie tylko nowość, ale też nowa generacja najczęściej wdrażanego na świecie środowiska wykonawczego uczenia maszynowego. Umożliwia działanie aplikacji, których używasz na co dzień, zapewniając niskie opóźnienia i wysoki poziom prywatności na miliardach urządzeń.

Zaufane przez najważniejsze aplikacje Google

Ponad 100 tys. aplikacji i miliardy użytkowników na całym świecie

Najważniejsze informacje o LiteRT

Gotowość do działania na różnych platformach

Uwolnij generatywną AI

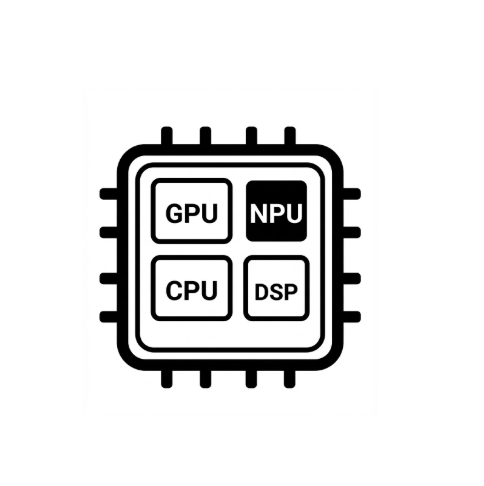

Uproszczona akceleracja sprzętowa

Obsługa wielu platform

Wdrażanie za pomocą LiteRT

Uzyskiwanie modelu

Używaj wstępnie wytrenowanych modeli .tflite lub przekonwertuj modele PyTorch, JAX lub TensorFlow na format .tflite.

Optymalizowanie modelu

Opcjonalna kwantyzacja modelu

Uruchom

Wybierz odpowiedni akcelerator i uruchom go w LiteRT.

Próbki, modele i wersje demonstracyjne

Zobacz przykładową aplikację

Samouczki pokazują, jak używać LiteRT, i zawierają kompletne przykłady.

Zobacz modele generatywnej AI

Wytrenowane, gotowe do użycia modele generatywnej AI.

Zobacz wersje demonstracyjne – aplikacja Galeria AI Edge od Google

Galeria prezentująca przypadki użycia ML/generatywnej AI na urządzeniu