La tâche Détecteur d'objets vous permet de détecter la présence et l'emplacement de plusieurs classes d'objets. Par exemple, un détecteur d'objets peut localiser des chiens dans une image. Ces instructions vous expliquent comment utiliser la tâche Object Detector sur Android. L'exemple de code décrit dans ces instructions est disponible sur GitHub. Pour voir cette tâche en action, regardez cette démonstration Web. Pour en savoir plus sur les fonctionnalités, les modèles et les options de configuration de cette tâche, consultez la section Présentation.

Exemple de code

L'exemple de code MediaPipe Tasks est une implémentation simple d'une application de détection d'objets pour Android. L'exemple utilise l'appareil photo d'un appareil Android physique pour détecter en continu des objets. Il peut également utiliser des images et des vidéos de la galerie de l'appareil pour détecter des objets de manière statique.

Vous pouvez utiliser l'application comme point de départ pour votre propre application Android ou vous y référer lorsque vous modifiez une application existante. L'exemple de code du détecteur d'objets est hébergé sur GitHub.

Télécharger le code

Les instructions suivantes vous expliquent comment créer une copie locale de l'exemple de code à l'aide de l'outil de ligne de commande git.

Pour télécharger l'exemple de code:

- Clonez le dépôt Git à l'aide de la commande suivante:

git clone https://github.com/google-ai-edge/mediapipe-samples

- Vous pouvez également configurer votre instance git pour utiliser un "checkout" clairsemé afin de n'avoir que les fichiers de l'application exemple Object Detector:

cd mediapipe-samples git sparse-checkout init --cone git sparse-checkout set examples/object_detection/android

Après avoir créé une version locale de l'exemple de code, vous pouvez importer le projet dans Android Studio et exécuter l'application. Pour obtenir des instructions, consultez le guide de configuration pour Android.

Composants clés

Les fichiers suivants contiennent le code essentiel de l'application exemple du détecteur d'objets:

- ObjectDetectorHelper.kt : initialise le détecteur d'objets et gère le modèle et la sélection du délégué

- MainActivity.kt : implémente l'application et assemble les composants de l'interface utilisateur

- OverlayView.kt : gère et affiche les résultats

Configuration

Cette section décrit les étapes clés à suivre pour configurer votre environnement de développement et vos projets de code afin d'utiliser Object Detector. Pour obtenir des informations générales sur la configuration de votre environnement de développement pour utiliser les tâches MediaPipe, y compris les exigences concernant les versions de la plate-forme, consultez le guide de configuration pour Android.

Dépendances

Le détecteur d'objets utilise la bibliothèque com.google.mediapipe:tasks-vision. Ajoutez cette dépendance au fichier build.gradle de votre projet de développement d'application Android. Importez les dépendances requises avec le code suivant:

dependencies {

implementation 'com.google.mediapipe:tasks-vision:latest.release'

}

Modèle

La tâche de détection d'objets MediaPipe nécessite un modèle entraîné compatible avec cette tâche. Pour en savoir plus sur les modèles entraînés disponibles pour Object Detector, consultez la section Modèles de la présentation de la tâche.

Sélectionnez et téléchargez le modèle, puis stockez-le dans le répertoire de votre projet:

<dev-project-root>/src/main/assets

Utilisez la méthode BaseOptions.Builder.setModelAssetPath() pour spécifier le chemin d'accès utilisé par le modèle. Pour obtenir un exemple de code, consultez la section suivante.

Créer la tâche

Vous pouvez utiliser la fonction createFromOptions pour créer la tâche. La fonction createFromOptions accepte des options de configuration, y compris le mode d'exécution, les paramètres régionaux des noms à afficher, le nombre maximal de résultats, le seuil de confiance, la liste d'autorisation et la liste de refus des catégories. Si aucune option de configuration n'est spécifiée, la valeur par défaut est utilisée. Pour en savoir plus sur les options de configuration, consultez la section Présentation de la configuration.

La tâche Détecteur d'objets est compatible avec trois types de données d'entrée: les images fixes, les fichiers vidéo et les flux vidéo en direct. Vous devez spécifier le mode d'exécution correspondant à votre type de données d'entrée lorsque vous créez la tâche. Sélectionnez l'onglet correspondant à votre type de données d'entrée pour découvrir comment créer la tâche et exécuter l'inférence.

Image

ObjectDetectorOptions options =

ObjectDetectorOptions.builder()

.setBaseOptions(BaseOptions.builder().setModelAssetPath(‘model.tflite’).build())

.setRunningMode(RunningMode.IMAGE)

.setMaxResults(5)

.build();

objectDetector = ObjectDetector.createFromOptions(context, options);

Vidéo

ObjectDetectorOptions options =

ObjectDetectorOptions.builder()

.setBaseOptions(BaseOptions.builder().setModelAssetPath(‘model.tflite’).build())

.setRunningMode(RunningMode.VIDEO)

.setMaxResults(5)

.build();

objectDetector = ObjectDetector.createFromOptions(context, options);

Diffusion en direct

ObjectDetectorOptions options = ObjectDetectorOptions.builder() .setBaseOptions(BaseOptions.builder().setModelAssetPath(‘model.tflite’).build()) .setRunningMode(RunningMode.LIVE_STREAM) .setMaxResults(5) .setResultListener((result, inputImage) -> { // Process the detection result here. }) .setErrorListener((result, inputImage) -> { // Process the classification errors here. }) .build(); objectDetector = ObjectDetector.createFromOptions(context, options);

L'implémentation de l'exemple de code du détecteur d'objets permet à l'utilisateur de basculer entre les modes de traitement. Cette approche rend le code de création de tâche plus complexe et n'est peut-être pas adaptée à votre cas d'utilisation. Vous pouvez voir ce code dans la fonction setupObjectDetector() de la classe ObjectDetectorHelper.

Options de configuration

Cette tâche propose les options de configuration suivantes pour les applications Android:

| Nom de l'option | Description | Plage de valeurs | Valeur par défaut |

|---|---|---|---|

runningMode |

Définit le mode d'exécution de la tâche. Il existe trois modes: IMAGE: mode pour les entrées d'une seule image. VIDEO: mode des images décodées d'une vidéo. LIVE_STREAM: mode de diffusion en direct des données d'entrée, par exemple à partir d'une caméra. Dans ce mode, resultListener doit être appelé pour configurer un écouteur afin de recevoir les résultats de manière asynchrone. |

{IMAGE, VIDEO, LIVE_STREAM} |

IMAGE |

displayNamesLocales |

Définit la langue des libellés à utiliser pour les noms à afficher fournis dans les métadonnées du modèle de la tâche, le cas échéant. La valeur par défaut est en pour l'anglais. Vous pouvez ajouter des libellés localisés aux métadonnées d'un modèle personnalisé à l'aide de l'API TensorFlow Lite Metadata Writer.

|

Code de paramètres régionaux | en |

maxResults |

Définit le nombre maximal facultatif de résultats de détection les plus élevés à renvoyer. | N'importe quel nombre positif | -1 (tous les résultats sont renvoyés) |

scoreThreshold |

Définit le seuil de score de prédiction qui remplace celui fourni dans les métadonnées du modèle (le cas échéant). Les résultats inférieurs à cette valeur sont rejetés. | N'importe quelle superposition | Non défini |

categoryAllowlist |

Définit la liste facultative des noms de catégories autorisés. Si cet ensemble n'est pas vide, les résultats de détection dont le nom de catégorie ne figure pas dans cet ensemble seront filtrés. Les noms de catégories en double ou inconnus sont ignorés.

Cette option s'exclut mutuellement avec categoryDenylist. L'utilisation des deux entraîne une erreur. |

N'importe quelle chaîne | Non défini |

categoryDenylist |

Définit la liste facultative des noms de catégories non autorisés. Si cet ensemble n'est pas vide, les résultats de détection dont le nom de catégorie figure dans cet ensemble seront filtrés. Les noms de catégories en double ou inconnus sont ignorés. Cette option s'exclut mutuellement avec categoryAllowlist. L'utilisation des deux entraîne une erreur. |

N'importe quelle chaîne | Non défini |

resultListener |

Définit l'écouteur de résultats pour qu'il reçoive les résultats de détection de manière asynchrone lorsque le détecteur d'objets est en mode diffusion en direct. Vous ne pouvez utiliser cette option que lorsque vous définissez runningMode sur LIVE_STREAM. | Non applicable | Non défini |

Préparer les données

Vous devez convertir l'image ou le frame d'entrée en objet com.google.mediapipe.framework.image.MPImage avant de le transmettre au détecteur d'objets.

Les exemples suivants expliquent et montrent comment préparer les données pour le traitement pour chacun des types de données disponibles:

Image

import com.google.mediapipe.framework.image.BitmapImageBuilder; import com.google.mediapipe.framework.image.MPImage; // Load an image on the user’s device as a Bitmap object using BitmapFactory. // Convert an Android’s Bitmap object to a MediaPipe’s Image object. Image mpImage = new BitmapImageBuilder(bitmap).build();

Vidéo

import com.google.mediapipe.framework.image.BitmapImageBuilder; import com.google.mediapipe.framework.image.MPImage; // Load a video file on the user's device using MediaMetadataRetriever // From the video’s metadata, load the METADATA_KEY_DURATION and // METADATA_KEY_VIDEO_FRAME_COUNT values. Use these values // to calculate the timestamp of each frame later. // Loop through the video and load each frame as a Bitmap object. // Convert the Android’s Bitmap object to a MediaPipe’s Image object. Image mpImage = new BitmapImageBuilder(frame).build();

Diffusion en direct

import com.google.mediapipe.framework.image.MediaImageBuilder; import com.google.mediapipe.framework.image.MPImage; // Create a CameraX’s ImageAnalysis to continuously receive frames // from the device’s camera. Configure it to output frames in RGBA_8888 // format to match with what is required by the model. // For each Android’s ImageProxy object received from the ImageAnalysis, // extract the encapsulated Android’s Image object and convert it to // a MediaPipe’s Image object. android.media.Image mediaImage = imageProxy.getImage() MPImage mpImage = new MediaImageBuilder(mediaImage).build();

Dans l'exemple de code du détecteur d'objets, la préparation des données est gérée dans la classe ObjectDetectorHelper dans les fonctions detectImage(), detectVideoFile() et detectLivestreamFrame().

Exécuter la tâche

En fonction du type de données avec lequel vous travaillez, utilisez la méthode ObjectDetector.detect...() spécifique à ce type de données. Utilisez detect() pour les images individuelles, detectForVideo() pour les images dans les fichiers vidéo et detectAsync() pour les flux vidéo. Lorsque vous effectuez des détections sur un flux vidéo, assurez-vous de les exécuter sur un thread distinct pour éviter de bloquer le thread de l'interface utilisateur.

Les exemples de code suivants montrent comment exécuter le détecteur d'objets dans ces différents modes de données:

Image

ObjectDetectorResult detectionResult = objectDetector.detect(image);

Vidéo

// Calculate the timestamp in milliseconds of the current frame. long frame_timestamp_ms = 1000 * video_duration * frame_index / frame_count; // Run inference on the frame. ObjectDetectorResult detectionResult = objectDetector.detectForVideo(image, frameTimestampMs);

Diffusion en direct

// Run inference on the frame. The detection results will be available // via the `resultListener` provided in the `ObjectDetectorOptions` when // the object detector was created. objectDetector.detectAsync(image, frameTimestampMs);

L'exemple de code du détecteur d'objets montre plus en détail les implémentations de chacun de ces modes : detect(), detectVideoFile() et detectAsync().

L'exemple de code permet à l'utilisateur de basculer entre les modes de traitement, ce qui n'est peut-être pas nécessaire pour votre cas d'utilisation.

Veuillez noter les points suivants :

- Lorsque vous exécutez le mode vidéo ou le mode de diffusion en direct, vous devez également fournir le code temporel du frame d'entrée à la tâche de détection d'objets.

- Lorsqu'elle s'exécute en mode image ou vidéo, la tâche du détecteur d'objets bloque le thread actuel jusqu'à ce qu'elle ait terminé de traiter l'image ou le frame d'entrée. Pour éviter de bloquer le thread actuel, exécutez le traitement dans un thread en arrière-plan.

- Lorsqu'elle s'exécute en mode diffusion en direct, la tâche du détecteur d'objets ne bloque pas le thread actuel, mais renvoie immédiatement. Il appelle son écouteur de résultats avec le résultat de la détection chaque fois qu'il a terminé le traitement d'un frame d'entrée. Si la fonction de détection est appelée lorsque la tâche du détecteur d'objets est occupée à traiter un autre frame, le nouveau frame d'entrée sera ignoré.

Gérer et afficher les résultats

Lors de l'exécution de l'inférence, la tâche Object Detector renvoie un objet ObjectDetectorResult qui décrit les objets qu'elle a trouvés dans l'image d'entrée.

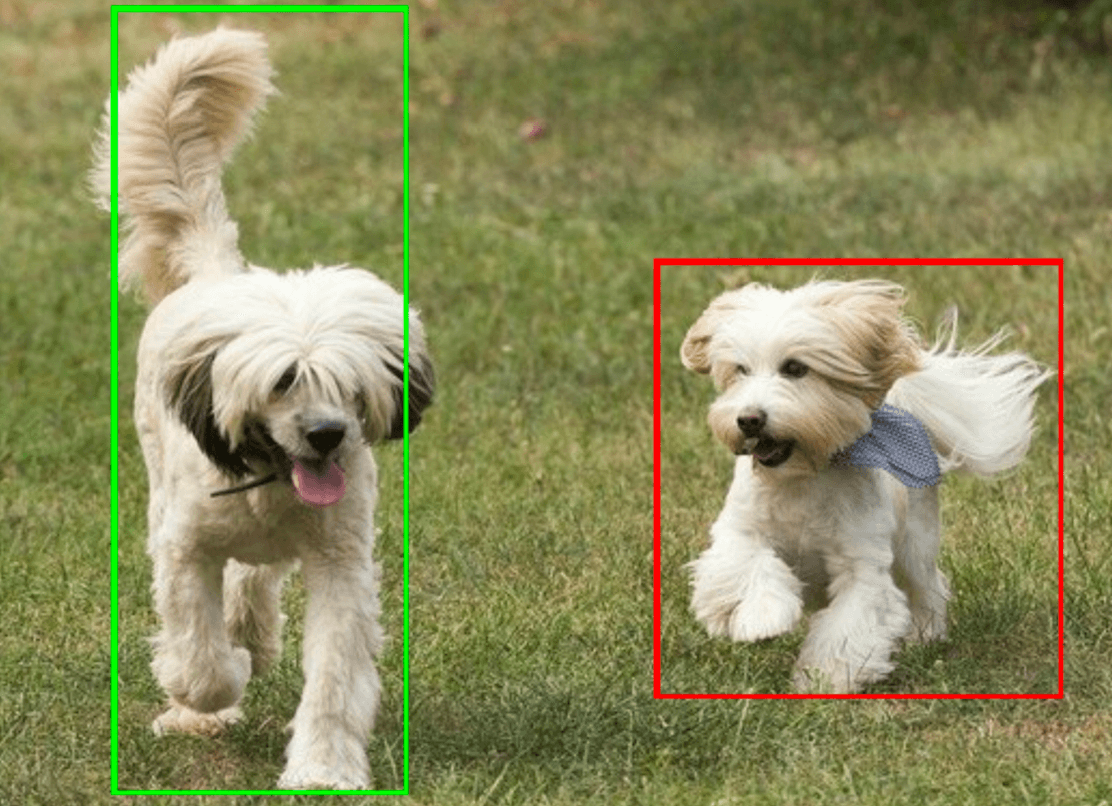

Voici un exemple des données de sortie de cette tâche:

ObjectDetectorResult:

Detection #0:

Box: (x: 355, y: 133, w: 190, h: 206)

Categories:

index : 17

score : 0.73828

class name : dog

Detection #1:

Box: (x: 103, y: 15, w: 138, h: 369)

Categories:

index : 17

score : 0.73047

class name : dog

L'image suivante présente une visualisation du résultat de la tâche:

L'exemple de code du détecteur d'objets montre comment afficher les résultats de détection renvoyés par la tâche. Pour en savoir plus, consultez la classe OverlayView.