Добавление GenAI в ваше приложение может принести огромную пользу вашим пользователям, но также требует пристального внимания для обеспечения безопасности и конфиденциальности, которых ожидают ваши пользователи.

Дизайн для безопасности

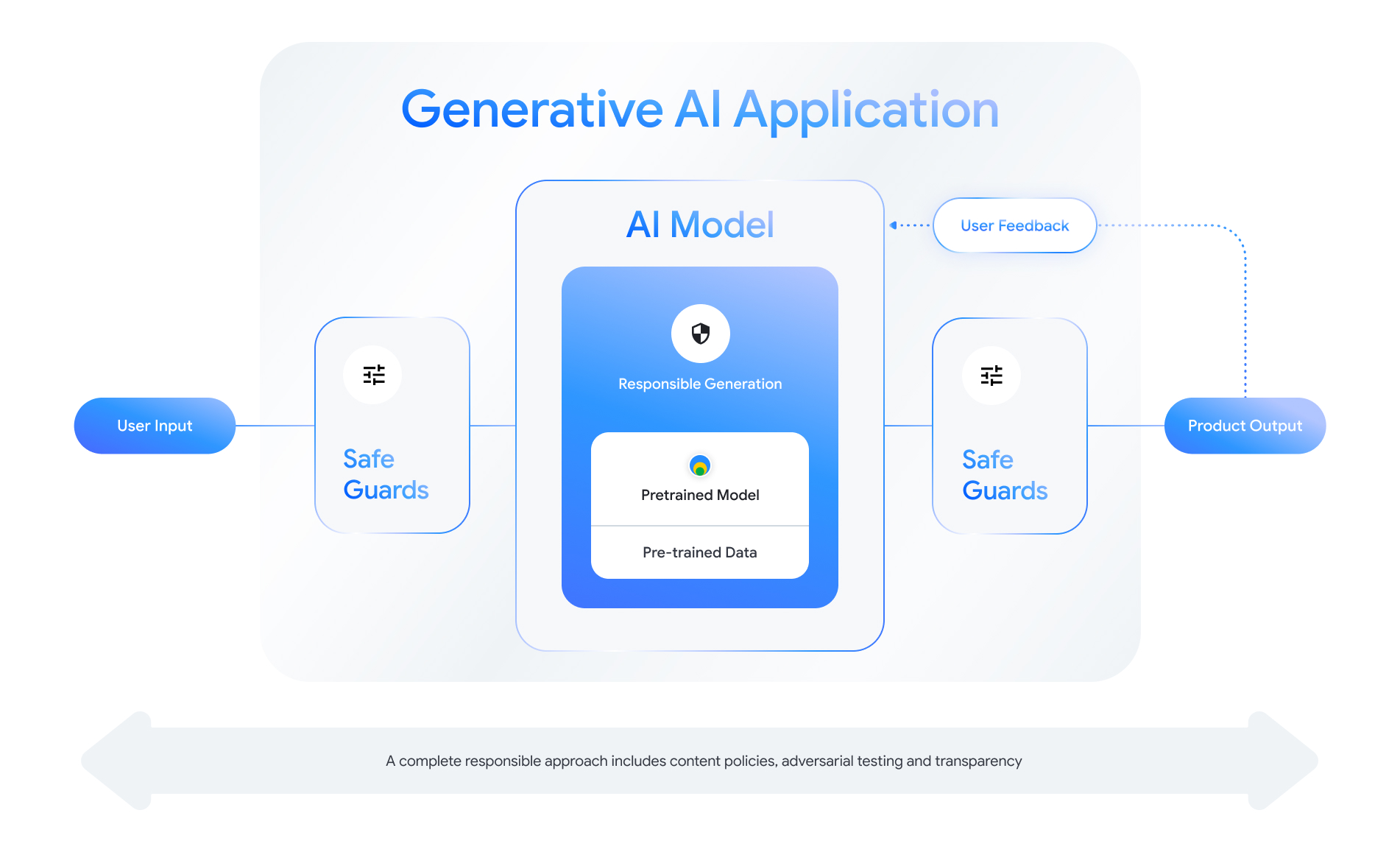

Каждая функция GenAI предоставляет возможности для создания уровней безопасности. Как показано на следующем рисунке, один из способов подумать о безопасности — поместить в центр модель искусственного интеллекта, которая обеспечивает эту функцию. Эта модель должна быть:

- Настроен на выполнение возложенной на него задачи;

- Защищено средствами защиты , гарантирующими, что входные и выходные данные, выходящие за пределы границ, будут отклонены; и

- Оценивается комплексно, чтобы оценить, как модель и система реагируют на взаимодействия, влияющие на безопасность.

Посетите сессию «Создание ответственных продуктов искусственного интеллекта» на конференции Google I/O 2024, чтобы узнать больше о аспектах проектирования, мыслительных упражнениях и методах прототипирования, которые могут помочь ускорить ваши методы ответственной разработки.

Кроме того, вы можете изучить лучшие практики и увидеть примеры для:

- Определение политик , которые будут регулировать поведение ИИ в вашем приложении;

- Создание артефактов прозрачности , чтобы донести до пользователей ваш ответственный подход; и

- Защита вашего приложения от злонамеренного использования.

Прежде всего, помните, что разумный подход к безопасности и ответственности — это подход, который предполагает самоанализ и адаптацию к техническим, культурным и технологическим проблемам. Вовлекайте себя и свою команду в регулярный критический анализ вашего подхода, чтобы обеспечить наилучшие результаты.

Определение политик системного уровня

Политики безопасности контента определяют, какие типы вредоносного контента не разрешены на онлайн-платформе. Возможно, вы знакомы с политиками в отношении контента таких платформ, как YouTube или Google Play . Политики контента для генеративных приложений искусственного интеллекта аналогичны: они определяют, какой тип контента ваше приложение не должно генерировать, а также определяют, как настраивать модели и какие соответствующие меры безопасности добавлять.

Ваши политики должны отражать вариант использования вашего приложения. Например, продукт генеративного искусственного интеллекта, предназначенный для предложения идей для семейных занятий на основе предложений сообщества, может иметь политику, запрещающую создание контента, носящего насильственный характер, поскольку он может нанести вред пользователям. И наоборот, приложение, обобщающее идеи научно-фантастических рассказов, предложенные пользователями, может захотеть разрешить создание насилия, поскольку оно является предметом многих рассказов этого жанра.

Ваша политика безопасности должна запрещать создание контента, который является вредным для пользователей или является незаконным, и должна указывать, какие типы создаваемого контента соответствуют этому требованию для вашего приложения. Вы также можете рассмотреть возможность включения исключений для образовательного, документального, научного или художественного контента, который в противном случае мог бы считаться вредным.

Определение четких политик с высокой степенью детализации, включая исключения из правил с примерами, имеет основополагающее значение для создания ответственного продукта. Ваши политики используются на каждом этапе разработки модели. При очистке или маркировке данных неточность может привести к неправильной маркировке данных, чрезмерному или недостаточному удалению данных, что повлияет на реакцию безопасности вашей модели. В целях оценки плохо определенные политики приведут к высокой дисперсии между экспертами, что затруднит определение того, соответствует ли ваша модель вашим стандартам безопасности.

Гипотетическая политика (только для иллюстрации)

Ниже приведены некоторые примеры политик, которые вы можете рассмотреть для своего приложения, при условии, что они соответствуют вашему сценарию использования.

| Категория политики | Политика |

|---|---|

| Конфиденциальная личная информация (SPII) | Приложение не будет раскрывать конфиденциальную и личную информацию (например, адрес электронной почты, номер кредитной карты или номер социального страхования частного лица). |

| Разжигание ненависти | Приложение не будет создавать негативный или вредный контент, нацеленный на личность и/или защищенные атрибуты (например, расовые оскорбления, пропаганда дискриминации, призывы к насилию в отношении защищенных групп). |

| Домогательство | Приложение не будет создавать вредоносный, запугивающий, запугивающий или оскорбительный контент, направленный против другого человека (например, физические угрозы, отрицание трагических событий, унижение жертв насилия). |

| Опасный контент | Приложение не будет генерировать инструкции или советы о том, как причинить вред себе и/или другим людям (например, получение доступа или изготовление огнестрельного оружия и взрывных устройств, пропаганда терроризма, инструкции по самоубийству). |

| Сексуально откровенно | Приложение не будет создавать контент, содержащий ссылки на сексуальные действия или другой непристойный контент (например, изображения сексуального характера, контент, направленный на возбуждение). |

| Обеспечение доступа к вредным товарам и услугам | Приложение не будет создавать контент, который пропагандирует или обеспечивает доступ к потенциально вредным товарам, услугам и деятельности (например, облегчает доступ к рекламе азартных игр, фармацевтических препаратов, фейерверков, сексуальных услуг). |

| Вредоносный контент | Приложение не будет генерировать инструкции для выполнения незаконных или вводящих в заблуждение действий (например, создания фишинга, спама или контента, предназначенного для массового вымогательства, методов взлома). |

Артефакты прозрачности

Документация — это ключевой метод достижения прозрачности для разработчиков, правительств, политиков и конечных пользователей вашего продукта. Это может повлечь за собой выпуск подробных технических отчетов или моделей, данных и системных карточек, которые соответствующим образом обнародуют важную информацию, основанную на оценках безопасности и других моделях. Артефакты прозрачности — это больше, чем средство коммуникации; они также предлагают рекомендации для исследователей ИИ, специалистов по развертыванию и последующих разработчиков по ответственному использованию модели. Эта информация также будет полезна конечным пользователям вашего продукта, которые хотят разобраться в деталях модели.

Некоторые рекомендации по обеспечению прозрачности, которые следует учитывать:

- Будьте предельно ясны с пользователями, когда они используют экспериментальную технологию генеративного искусственного интеллекта, и подчеркивайте возможность неожиданного поведения модели.

- Предложите подробную документацию о том, как работает сервис или продукт генеративного ИИ, используя понятный язык. Рассмотрите возможность публикации структурированных артефактов прозрачности, таких как карточки моделей. Эти карточки описывают предполагаемое использование вашей модели и суммируют оценки, выполненные на протяжении всего процесса разработки модели.

- Покажите людям, как они могут предлагать обратную связь и как они все контролируют, например:

- Предоставление механизмов, помогающих пользователям проверять вопросы, основанные на фактах.

- Значки «палец вверх» и «вниз» для обратной связи с пользователем

- Ссылки для сообщения о проблемах и предложения поддержки для быстрого реагирования на отзывы пользователей.

- Пользовательский контроль для сохранения или удаления активности пользователя

Безопасные системы искусственного интеллекта

Приложения с поддержкой GenAI представляют собой сложные поверхности для атак , которые требуют более разнообразных мер защиты, чем традиционные приложения. Secure AI Framework (SAIF) от Google предоставляет целостную концептуальную основу для рассмотрения того, как разработать приложение с поддержкой GenAI для безопасного использования. Эта структура может помочь вам оценить, как эффективно использовать согласование , состязательную оценку и меры безопасности для обеспечения безопасности вашего приложения, однако помните, что это только начальные блоки. Для достижения целей безопасности для вашего конкретного варианта использования и контекста, вероятно, потребуются дополнительные изменения в организационных методах, мониторинге и оповещениях.

Ресурсы для разработчиков

Примеры генеративной политики ИИ:

- Cloud Gemini API и PaLM API предоставляют список атрибутов безопасности, которые могут служить основой для построения политик безопасности.

- Пример политик, включенных в Обновление принципов Google AI за 2023 год .

- Ассоциация MLCommons , инженерный консорциум, основанный на философии открытого сотрудничества для улучшения систем ИИ, ссылается на 6 опасностей, по которым они оценивают модели безопасности ИИ, в рамках своего теста безопасности ИИ .

В отрасли не существует единого шаблона для артефактов прозрачности, но существующие карточки моделей могут служить отправной точкой для создания собственных:

- Модельная карточка Джеммы

- Шаблон карточки модели из оригинальной бумаги модели карточки.

- Карточки моделей из Google Cloud API