只要在應用程式中加入生成式 AI,就能為 但在這個架構下,您應該密切關注 以及對使用者的期望

安全設計

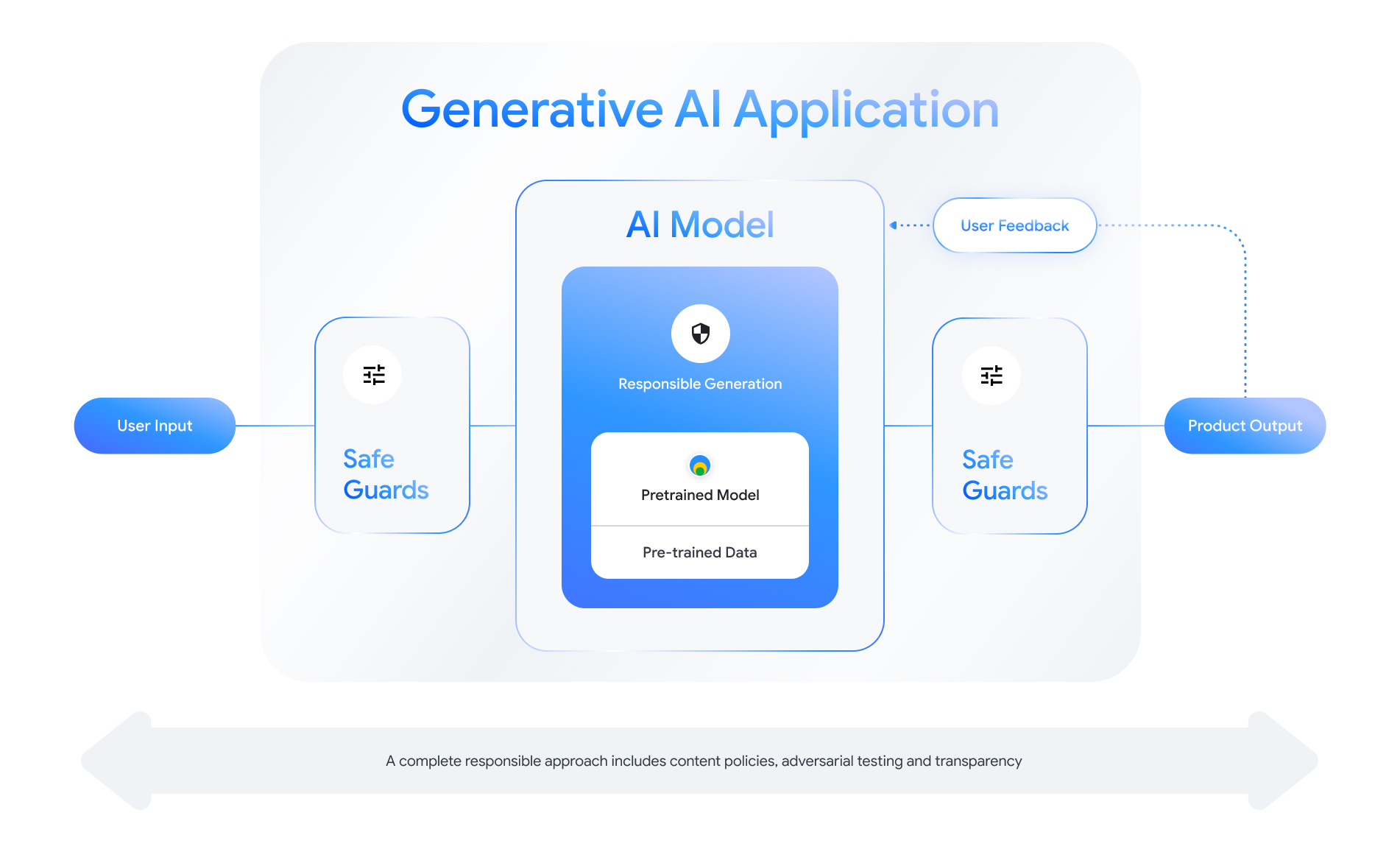

每項啟用生成式 AI 的功能都有設計安全層的機會。阿斯 如下圖所示 一個您會認為是安全的 它是啟用此功能的 AI 模型。這個模型應如下所示:

查看 「打造負責任的 AI 產品」工作階段 2024 年 Google I/O 大會,進一步瞭解設計注意事項、思考練習 和原型設計方法 做法。

此外,您也可以瞭解最佳做法,並查看下列示例:

最重要的是,維護安全和責任的音效 自我反思且適應技術、文化及程序等 可能會遇到難題請自己和團隊成員定期進行重要審查 確保最佳成果

定義系統層級政策

內容安全政策會定義不得發布的有害內容類型 或線上平台上實際操作你可能已經熟悉平台的內容政策 例如 YouTube 或 Google Play。內容 生成式 AI 應用的政策也是如此 應用程式無法產生的內容,能引導如何調整模型 以及要新增哪些適當保護措施

政策應反映應用程式的用途。舉例來說 生成式 AI 產品,旨在根據 社群推薦功能可能存在相關政策,禁止 內容為暴力,且可能對使用者有害。相反地 應用程式要是能摘要呈現使用者提出的科幻故事, 會想要允許生成暴力行為 播放這類音樂

您的安全性政策應禁止產生有害內容 並指出生成內容符合哪種類型 調整應用程式列我們也建議您考慮加入 具教育、紀實、科學或藝術性質的內容, 否則就會視為有害

制定明確的政策,並以極為精細的方式詳述,包括 但有個例子能讓你瞭解,建立負責任的 AI 技術 產品。您的政策會在模型開發的每個步驟中使用。資料 如果清理或加上標籤,不精確可能會導致資料標籤有誤、過度移除或 不足以移除資料,這會影響模型的安全性回應。適用對象 評估目的、定義明確的政策將導致高內部評分 使模型難以判斷模型是否滿足您的安全 標準。

假設政策 (僅供說明)

以下列舉幾個您在 是否符合您的用途

| 政策類別 | 政策 |

|---|---|

| 機密的個人識別資訊 (SPII) | 應用程式不會引用敏感和個人識別資訊 資訊 (例如電子郵件、信用卡號碼或 身分證字號)。 |

| 仇恨言論 | 應用程式不會生成負面或有害內容 鎖定身分和/或受保護特質 (例如種族歧視) 鼓吹歧視、呼籲暴力對待保護 群組)。 |

| 騷擾 | 這個應用程式不會生成惡意、恐嚇、霸凌 或是針對特定人士 (例如 威脅、否認不幸事件、貶低其受害者 暴力內容)。 |

| 危險內容 | 這個應用程式不會提供關於損害的相關指示或建議 自己和/或他人 (例如存取或建造槍械, 爆裂物、宣揚恐怖主義,並說明如何 自殺)。 |

| 性愛 | 應用程式不會產生包含下列內容的內容: 性行為或其他猥褻內容 (例如情色露骨內容) 吸引大量觀眾的文字說明和內容)。 |

| 協助提供有害商品與服務 | 應用程式不會產生宣傳或啟用「服務」的內容 防範可能有害的商品、服務和活動 (例如 協助發布商宣傳賭博、藥物 煙火、色情服務)。 |

| 惡意內容 | 應用程式不會針對違法行為產生指示 或欺騙活動 (例如產生網路釣魚詐騙、垃圾內容或 意圖大量散佈或敲詐行為的內容)。 |

透明度構件

說明文件是實現資訊公開的關鍵方法 政府機關、政策執行者和使用者。包括 提供詳細的技術報表或模型、資料和系統資訊卡 根據安全及其他模型 以及評估結果透明度構件不只是通訊工具,他們 也為 AI 研究人員、部署人員和下游開發人員提供指引 如何負責任地使用模型這些資訊對於 也想深入瞭解型號

以下列舉幾項資訊公開指南,請多加留意:

- 向使用者明確告知正在參與實驗 並著重在突顯非預期模型的可能性 行為

- 提供詳盡的說明文件,說明生成式 AI 服務或產品的方式 就是使用容易理解的語言考慮採用結構化發布方式 透明度構件,例如模型資訊卡這些資訊卡提供 並總結先前採用的評估作業 都會在整個模型開發期間執行

- 向觀眾說明他們可以如何提供意見,以及如何掌控一切,例如:

為:

- 提供機制,協助使用者確認事實問題

- 按讚/倒讚圖示,用來收集使用者意見

- 回報問題和支援快速回應連結 使用者意見回饋

- 儲存或刪除使用者活動的使用者控制項

安全 AI 系統

支援生成式 AI 的應用程式呈現複雜的攻擊面 與傳統應用程式相比,需要更多多樣化的緩解措施。 Google 的安全 AI 架構 (SAIF) 提供全方位的 思考如何設計採用生成式 AI 的應用程式 安全用途這個架構可協助您評估 一致性、對抗評估,以及 有效保護以保護應用程式。 不過請注意,這只是第一步的其他變更 可能必須執行相應的機構、監控和快訊工作 針對特定用途和情境來實現資安目標。

開發人員資源

生成式 AI 政策的例子:

- Cloud Gemini API 和 PaLM API 提供 安全屬性清單,有助於建立安全機制 再檢查有關聯的允許政策

- 政策示例 2023 年 Google AI 開發原則進度更新。

- MLCommons 協會 (根據 有助於改善 AI 系統的理念,參考資料 6 評估模型是否包含 AI 安全性模型 AI 安全性基準。

整個 YAML 平台上的透明度構件並無單一範本 不過現有的模型資訊卡可做為起點 :

- Gemma 的模型資訊卡

- 原始模型資訊卡文件中的 Model Card 範本

- Google Cloud API 提供的 Model Card