Die Gemini API bietet Sicherheitseinstellungen, die Sie während der Prototyping-Phase anpassen können, um festzustellen, ob Ihre Anwendung eine mehr oder weniger restriktive Sicherheitskonfiguration erfordert. Sie können diese Einstellungen in vier Filterkategorien anpassen, um bestimmte Arten von Inhalten zuzulassen oder einzuschränken.

In diesem Leitfaden wird beschrieben, wie die Gemini API Sicherheitseinstellungen und Filterung handhabt und wie Sie die Sicherheitseinstellungen für Ihre Anwendung ändern können.

Sicherheitsfilter

Die anpassbaren Sicherheitsfilter der Gemini API decken die folgenden Kategorien ab:

| Kategorie | Beschreibung |

|---|---|

| Belästigung | Negative oder schädliche Kommentare, die auf Identität und/oder geschützte Merkmale ausgerichtet sind. |

| Hassrede | Unhöfliche, respektlose oder vulgäre Inhalte. |

| Sexuell explizite Inhalte | Enthält Verweise auf sexuelle Handlungen oder andere vulgäre Inhalte |

| Gefährlich | Inhalte, die gefährliche Handlungen fördern oder erleichtern bzw. dazu ermuntern. |

Diese Kategorien sind in HarmCategory definiert. Sie können diese Filter verwenden, um die für Ihren Anwendungsfall passenden Einstellungen vorzunehmen. Wenn Sie beispielsweise Dialoge für ein Videospiel erstellen, halten Sie es aufgrund der Art des Spiels möglicherweise für akzeptabel, mehr Inhalte zuzulassen, die als gefährlich eingestuft wurden.

Zusätzlich zu den anpassbaren Sicherheitsfiltern bietet die Gemini API integrierte Schutzmaßnahmen gegen grundlegend schädliche Inhalte, wie solche, die die Sicherheit von Kindern gefährden. Diese Arten von Schäden werden immer blockiert und können nicht angepasst werden.

Filterstufe für die Sicherheit von Inhalten

In der Gemini API wird die Wahrscheinlichkeit, dass Inhalte unsicher sind, in die Kategorien HIGH, MEDIUM, LOW oder NEGLIGIBLE eingeteilt.

Die Gemini API blockiert Inhalte auf Grundlage der Wahrscheinlichkeit, dass Inhalte unsicher sind, nicht auf dem Schweregrad der Probleme. Dies ist wichtig, da einige Inhalte mit geringer Wahrscheinlichkeit unsicher sind, obwohl der Schweregrad des Schadens hoch sein kann. Vergleichen Sie beispielsweise folgende Sätze:

- Der Roboter hat mich geboxt.

- Der Roboter hat mich in Stücke geschnitten.

Der erste Satz kann zu einer höheren Wahrscheinlichkeit führen, dass er unsicher ist, aber Sie können den zweiten Satz in Bezug auf Gewalt als schwerwiegender einstufen. Daher ist es wichtig, dass Sie Tests sorgfältig durchführen und überlegen, welches Maß an Sicherheitsblockaden zur Unterstützung Ihrer wichtigsten Anwendungsfälle erforderlich ist, während gleichzeitig der Schaden für Endnutzer minimiert wird.

Sicherheitsfilterung pro Anfrage

Sie können die Sicherheitseinstellungen für jede Anfrage an die API anpassen. Wenn Sie eine Anfrage stellen, wird der Inhalt analysiert und erhält eine Sicherheitsbewertung. Die Sicherheitsbewertung umfasst sowohl die jeweilige Kategorie als auch die Wahrscheinlichkeit einer Klassifizierung als schädlich. Wenn die Inhalte beispielsweise blockiert wurden, weil die Kategorie „Belästigung“ eine hohe Wahrscheinlichkeit aufwies, würde die zurückgegebene Sicherheitsbewertung die Kategorie HARASSMENT und die Wahrscheinlichkeit für Schäden HIGH enthalten.

Aufgrund der inhärenten Sicherheit des Modells sind zusätzliche Filter standardmäßig deaktiviert. Wenn Sie sie aktivieren, können Sie das System so konfigurieren, dass Inhalte basierend auf der Wahrscheinlichkeit, dass sie unsicher sind, blockiert werden. Das Standardverhalten des Modells deckt die meisten Anwendungsfälle ab. Passen Sie diese Einstellungen also nur an, wenn dies durchgehend für Ihre Anwendung erforderlich ist.

In der folgenden Tabelle werden die Blockierungseinstellungen beschrieben, die Sie für jede Kategorie anpassen können. Wenn Sie beispielsweise die Blockierungseinstellung für die Kategorie Hassrede auf Wenige blockieren setzen, werden alle Inhalte blockiert, die mit hoher Wahrscheinlichkeit Hassrede enthalten. Alles mit einer niedrigeren Wahrscheinlichkeit ist zulässig.

| Grenzwert (Google AI Studio) | Grenzwert (API) | Beschreibung |

|---|---|---|

| Aus | OFF |

Sicherheitsfilter deaktivieren |

| Keine blockieren | BLOCK_NONE |

Unabhängig von der Wahrscheinlichkeit unsicherer Inhalte immer anzeigen |

| Wenige blockieren | BLOCK_ONLY_HIGH |

Blockieren, wenn die Wahrscheinlichkeit für unsichere Inhalte hoch ist |

| Einige blockieren | BLOCK_MEDIUM_AND_ABOVE |

Blockieren, wenn die Wahrscheinlichkeit für unsichere Inhalte mittel oder hoch ist |

| Meiste blockieren | BLOCK_LOW_AND_ABOVE |

Blockieren, wenn die Wahrscheinlichkeit für unsichere Inhalte niedrig, mittel oder hoch ist |

| – | HARM_BLOCK_THRESHOLD_UNSPECIFIED |

Der Grenzwert ist nicht angegeben, nach dem Standardschwellenwert blockieren |

Wenn der Schwellenwert nicht festgelegt ist, ist der Standard-Blockierungsschwellenwert für Gemini 2.5- und 3-Modelle Aus.

Sie können diese Einstellungen für jede Anfrage festlegen, die Sie an den generativen Dienst senden.

Weitere Informationen finden Sie in der API-Referenz zu HarmBlockThreshold.

Sicherheitsfeedback

generateContent gibt eine GenerateContentResponse zurück, die Sicherheitsfeedback enthält.

Prompt-Feedback ist in promptFeedback enthalten. Wenn promptFeedback.blockReason festgelegt ist, wurde der Inhalt des Prompts blockiert.

Das Feedback zu Antwortkandidaten ist in Candidate.finishReason und Candidate.safetyRatings enthalten. Wenn Antwortinhalte blockiert wurden und finishReason SAFETY war, können Sie safetyRatings auf weitere Details prüfen. Die blockierten Inhalte werden nicht zurückgegeben.

Sicherheitseinstellungen anpassen

In diesem Abschnitt wird beschrieben, wie Sie die Sicherheitseinstellungen sowohl in Google AI Studio als auch in Ihrem Code anpassen.

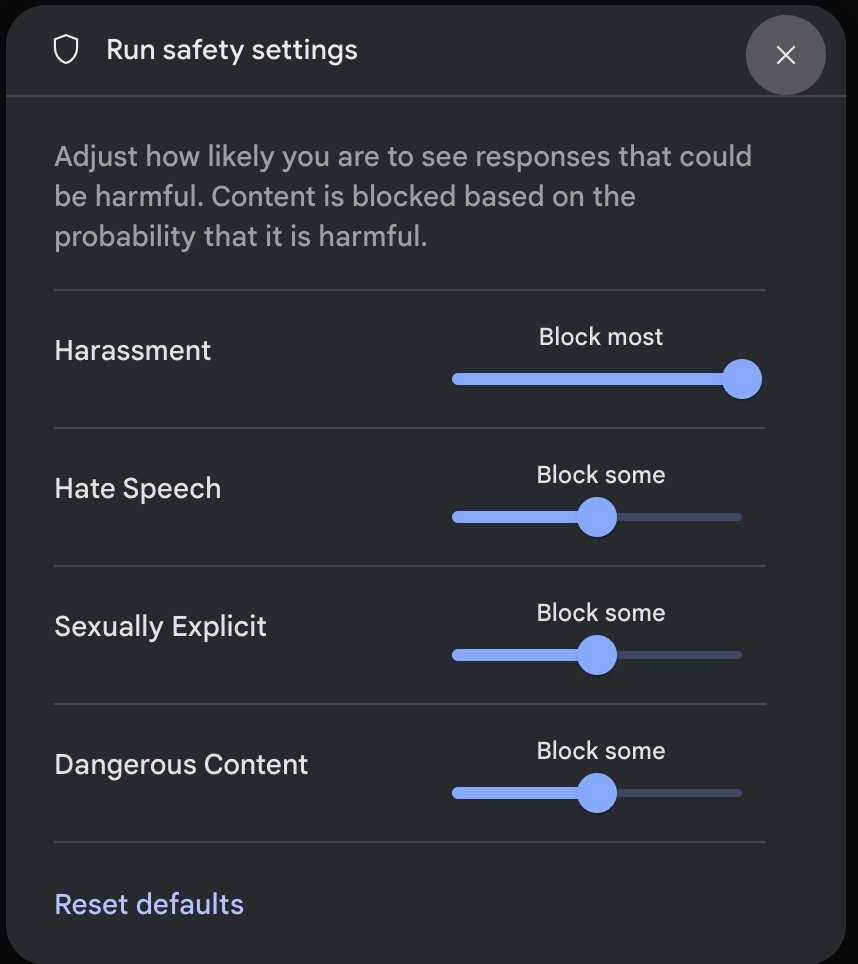

Google AI Studio

Sie können die Sicherheitseinstellungen in Google AI Studio anpassen.

Klicken Sie im Bereich Ausführungseinstellungen unter Erweiterte Einstellungen auf Sicherheitseinstellungen, um das Modal Sicherheitseinstellungen für die Ausführung zu öffnen. Im Modal können Sie mit den Schiebereglern die Stufe der Inhaltsfilterung für jede Sicherheitskategorie anpassen:

Wenn Sie eine Anfrage senden (z. B. indem Sie dem Modell eine Frage stellen), wird die Meldung Inhalt blockiert angezeigt, wenn der Inhalt der Anfrage blockiert ist. Wenn Sie weitere Details sehen möchten, bewegen Sie den Mauszeiger auf den Text Inhalte blockiert, um die Kategorie und die Wahrscheinlichkeit der Schadensklassifizierung zu sehen.

Codebeispiele

Das folgende Code-Snippet zeigt, wie Sie Sicherheitseinstellungen in Ihrem GenerateContent-Aufruf festlegen. Damit wird der Schwellenwert für die Kategorie „Hassrede“ (HARM_CATEGORY_HATE_SPEECH) festgelegt. Wenn Sie diese Kategorie auf BLOCK_LOW_AND_ABOVE setzen, werden alle Inhalte blockiert, die mit niedriger oder höherer Wahrscheinlichkeit Hassrede enthalten. Weitere Informationen zu den Schwellenwerteinstellungen finden Sie unter Sicherheitsfilterung pro Anfrage.

Python

from google import genai

from google.genai import types

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="Some potentially unsafe prompt",

config=types.GenerateContentConfig(

safety_settings=[

types.SafetySetting(

category=types.HarmCategory.HARM_CATEGORY_HATE_SPEECH,

threshold=types.HarmBlockThreshold.BLOCK_LOW_AND_ABOVE,

),

]

)

)

print(response.text)

Ok

package main

import (

"context"

"fmt"

"log"

"google.golang.org/genai"

)

func main() {

ctx := context.Background()

client, err := genai.NewClient(ctx, nil)

if err != nil {

log.Fatal(err)

}

config := &genai.GenerateContentConfig{

SafetySettings: []*genai.SafetySetting{

{

Category: "HARM_CATEGORY_HATE_SPEECH",

Threshold: "BLOCK_LOW_AND_ABOVE",

},

},

}

response, err := client.Models.GenerateContent(

ctx,

"gemini-3-flash-preview",

genai.Text("Some potentially unsafe prompt."),

config,

)

if err != nil {

log.Fatal(err)

}

fmt.Println(response.Text())

}

JavaScript

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

const safetySettings = [

{

category: "HARM_CATEGORY_HATE_SPEECH",

threshold: "BLOCK_LOW_AND_ABOVE",

},

];

async function main() {

const response = await ai.models.generateContent({

model: "gemini-3-flash-preview",

contents: "Some potentially unsafe prompt.",

config: {

safetySettings: safetySettings,

},

});

console.log(response.text);

}

await main();

Java

SafetySetting hateSpeechSafety = new SafetySetting(HarmCategory.HATE_SPEECH,

BlockThreshold.LOW_AND_ABOVE);

GenerativeModel gm = new GenerativeModel(

"gemini-3-flash-preview",

BuildConfig.apiKey,

null, // generation config is optional

Arrays.asList(hateSpeechSafety)

);

GenerativeModelFutures model = GenerativeModelFutures.from(gm);

REST

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-flash-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H "Content-Type: application/json" \

-X POST \

-d '{

"safetySettings": [

{"category": "HARM_CATEGORY_HATE_SPEECH", "threshold": "BLOCK_LOW_AND_ABOVE"}

],

"contents": [{

"parts":[{

"text": "'\''Some potentially unsafe prompt.'\''"

}]

}]

}'

Nächste Schritte

- Weitere Informationen zur vollständigen API finden Sie in der API-Referenz.

- Sicherheitshinweise bieten einen allgemeinen Überblick über Sicherheitsaspekte bei der Entwicklung mit LLMs.

- Weitere Informationen zum Bewerten von Wahrscheinlichkeit und Schweregrad

- Weitere Informationen zu den Produkten, die zu Sicherheitslösungen wie der Perspective API beitragen * Mit diesen Sicherheitseinstellungen können Sie einen Klassifikator für Toxizität erstellen. Beispiel für die Klassifizierung