هوش مصنوعی را در تلفن همراه، وب و برنامه های جاسازی شده مستقر کنید

روی دستگاه

تأخیر را کاهش دهید. آفلاین کار کنید داده های خود را محلی و خصوصی نگه دارید.

کراس پلتفرم

همان مدل را در اندروید، iOS، وب و جاسازی شده اجرا کنید.

چند چارچوبی

سازگار با مدل های JAX، Keras، PyTorch و TensorFlow.

پشته لبه هوش مصنوعی کامل

چارچوب های انعطاف پذیر، راه حل های کلید در دست، شتاب دهنده های سخت افزاری

راه حل های آماده و چارچوب های انعطاف پذیر

APIهای کم کد برای کارهای رایج هوش مصنوعی

APIهای چند پلتفرمی برای مقابله با وظایف متداول هوش مصنوعی، بینایی، نوشتاری و صوتی.

با وظایف MediaPipe شروع کنیداستقرار مدل های سفارشی در پلتفرم های مختلف

مدلهای JAX، Keras، PyTorch، و TensorFlow را در Android، iOS، وب و دستگاههای جاسازی شده، بهینهسازی شده برای ML سنتی و هوش مصنوعی مولد، اجرا کنید.

با LiteRT شروع کنید

چرخه های توسعه را با تجسم کوتاه کنید

تبدیل مدل خود را از طریق تبدیل و کوانتیزه کردن تجسم کنید. نقاط مهم را با همپوشانی نتایج معیارها رفع اشکال کنید.

با Model Explorer شروع کنید

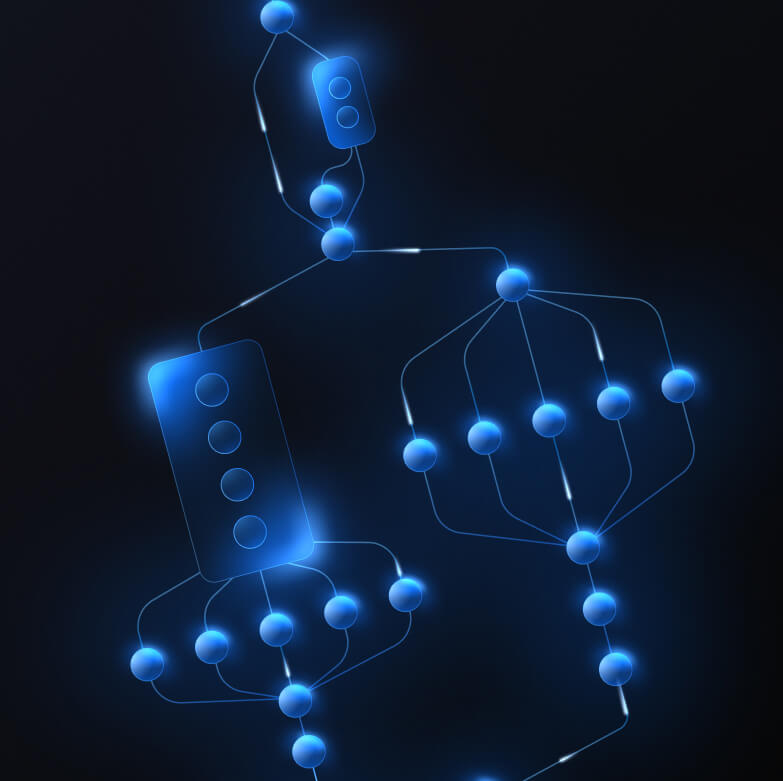

خطوط لوله سفارشی برای ویژگی های پیچیده ML بسازید

با زنجیر کردن چندین مدل ML به همراه منطق پردازش قبل و بعد، وظیفه خود را بسازید. خطوط لوله تسریع شده (GPU & NPU) را بدون مسدود کردن CPU اجرا کنید.

با MediaPipe Framework شروع کنید

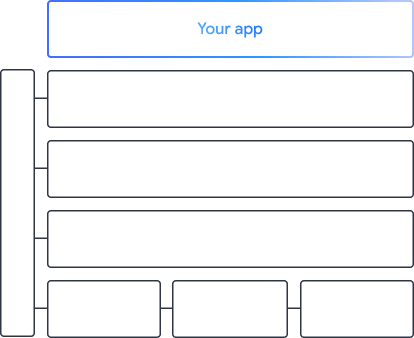

ابزارها و چارچوب هایی که برنامه های Google را تقویت می کنند

پشته لبه هوش مصنوعی کامل را با محصولات در هر سطح کاوش کنید - از APIهای کم کد گرفته تا کتابخانههای شتاب ویژه سختافزار.

وظایف MediaPipe

وظایف MediaPipe

به سرعت ویژگیهای هوش مصنوعی را در برنامههای تلفن همراه و وب با استفاده از APIهای کمکد برای کارهای متداول شامل هوش مصنوعی، بینایی رایانه، متن و صدا ایجاد کنید.

هوش مصنوعی مولد

با استفاده از APIهای آماده، مدلهای زبان و تصویر را مستقیماً در برنامههای خود ادغام کنید.

چشم انداز

طیف وسیعی از وظایف بینایی را که شامل تقسیمبندی، طبقهبندی، تشخیص، تشخیص و نشانههای بدن میشود، کاوش کنید.

متن و صوت

متن و صدا را در بسیاری از دستهها از جمله زبان، احساسات و دستههای سفارشی خود طبقهبندی کنید.

شروع کنید

مستندات وظایف

همه کارهای MediaPipe کم کد آماده ما را با اسناد و نمونه کد پیدا کنید.

وظایف هوش مصنوعی مولد

با وظایف هوش مصنوعی مولد MediaPipe، LLM و مدلهای انتشار را در لبه اجرا کنید.

دموها را امتحان کنید

کتابخانه MediaPipe Tasks ما را کاوش کنید و خودتان آنها را امتحان کنید.

مستندات سازنده مدل

مدل های موجود در وظایف MediaPipe ما را با داده های خود سفارشی کنید.