Deployment di ML e AI generativa ad alte prestazioni su piattaforme edge

Conversione, runtime e ottimizzazione efficienti per il machine learning sul dispositivo.

Basato sulle fondamenta collaudate di TensorFlow Lite

LiteRT non è solo una novità, ma la nuova generazione del runtime di machine learning più ampiamente implementato al mondo. Alimenta le app che usi tutti i giorni, offrendo bassa latenza e alta privacy su miliardi di dispositivi.

Considerato attendibile dalle app Google più importanti

Oltre 100.000 applicazioni, miliardi di utenti in tutto il mondo

Punti salienti di LiteRT

Pronto per il cross-platform

Sfruttare l'AI generativa

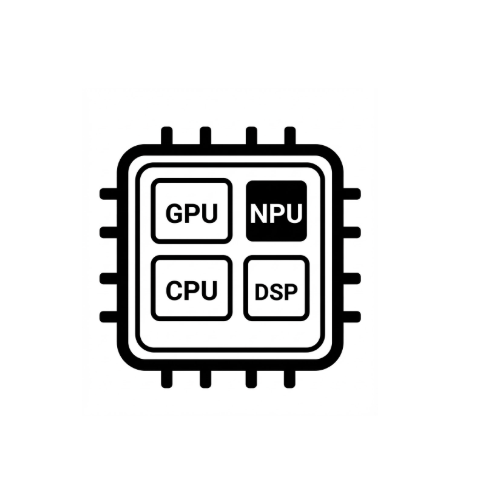

Accelerazione hardware semplificata

Supporto di più framework

Deployment tramite LiteRT

Ottenere un modello

Utilizza modelli preaddestrati .tflite o converti modelli PyTorch, JAX o TensorFlow in .tflite

Ottimizza il modello

(Facoltativo) Quantizza il modello

Esegui

Scegli l'acceleratore che preferisci ed eseguilo su LiteRT

Esempi, modelli e demo

Visualizza l'app di esempio

I tutorial mostrano come utilizzare LiteRT con esempi completi end-to-end.

Visualizza i modelli di AI generativa

Modelli di AI generativa preaddestrati e pronti all'uso.

Guarda le demo - App galleria Google AI Edge

Una galleria che mostra i casi d'uso di ML/AI generativa sul dispositivo