A API Live permite interações de voz e vídeo em tempo real e de baixa latência com o Gemini. Ele processa fluxos contínuos de áudio, vídeo ou texto para oferecer respostas faladas imediatas e semelhantes às humanas, criando uma experiência de conversa natural para os usuários.

A API Live oferece um conjunto abrangente de recursos, como detecção de atividade de voz, uso de ferramentas e chamadas de função, gerenciamento de sessão (para gerenciar conversas longas) e tokens efêmeros (para autenticação segura do lado do cliente).

Esta página mostra como começar a usar exemplos e amostras de código básicas.

Teste a API Live no Google AI Studio

Escolher uma abordagem de implementação

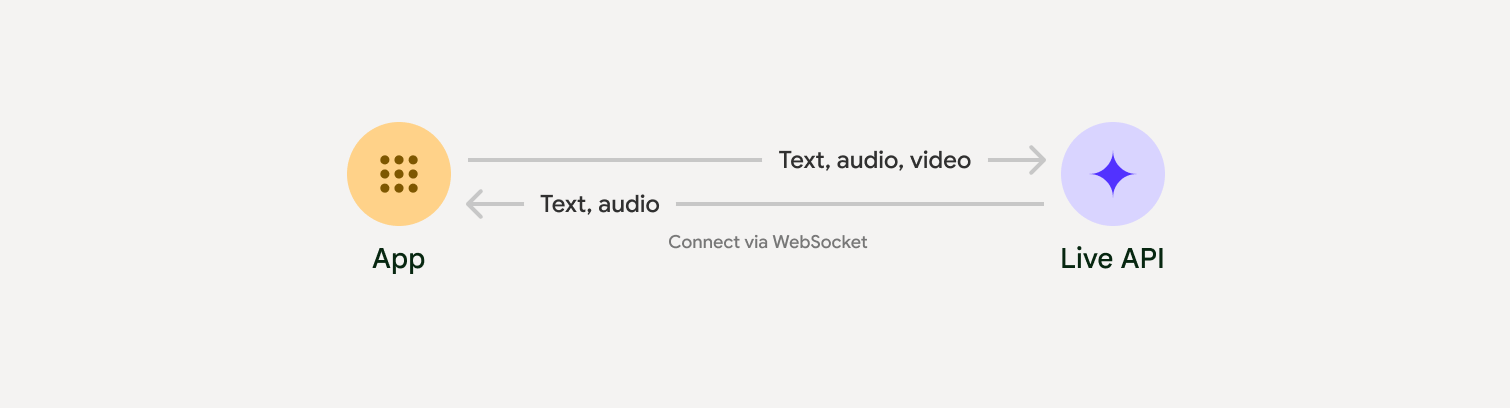

Ao fazer a integração com a API Live, você precisa escolher uma das seguintes abordagens de implementação:

- De servidor para servidor: seu back-end se conecta à API Live usando WebSockets. Normalmente, o cliente envia dados de stream (áudio, vídeo, texto) para o servidor, que os encaminha para a API Live.

- Cliente para servidor: seu código de front-end se conecta diretamente à API Live usando WebSockets para transmitir dados, ignorando o back-end.

Integrações com parceiros

Para simplificar o desenvolvimento de apps de áudio e vídeo em tempo real, use uma integração de terceiros que ofereça suporte à API Gemini Live via WebRTC ou WebSockets.

Pipecat da Daily

Crie um chatbot de IA em tempo real usando o Gemini Live e o Pipecat.

LiveKit

Use a API Gemini Live com agentes do LiveKit.

Fishjam da Software Mansion

Crie aplicativos de streaming de áudio e vídeo ao vivo com o Fishjam.

Kit de Desenvolvimento de Agente (ADK)

Implemente a API Live com o Kit de Desenvolvimento de Agente (ADK).

Agentes do Vision por stream

Crie aplicativos de IA de voz e vídeo em tempo real com os agentes de visão.

Voximplant

Conecte chamadas recebidas e efetuadas à API Live com o Voximplant.

Primeiros passos

Este exemplo do lado do servidor transmite áudio do microfone e reproduz o áudio retornado. Para exemplos completos, incluindo um aplicativo cliente, consulte Exemplos de aplicativos.

O formato de áudio de entrada precisa ser PCM de 16 bits, 16 kHz, mono, e o áudio recebido usa uma taxa de amostragem de 24 kHz.

Python

Instale helpers para transmissão de áudio. Outras dependências no nível do sistema (por exemplo, portaudio) podem ser necessárias. Consulte a documentação do PyAudio para ver as etapas detalhadas de instalação.

pip install pyaudioimport asyncio

from google import genai

import pyaudio

client = genai.Client()

# --- pyaudio config ---

FORMAT = pyaudio.paInt16

CHANNELS = 1

SEND_SAMPLE_RATE = 16000

RECEIVE_SAMPLE_RATE = 24000

CHUNK_SIZE = 1024

pya = pyaudio.PyAudio()

# --- Live API config ---

MODEL = "gemini-2.5-flash-native-audio-preview-12-2025"

CONFIG = {

"response_modalities": ["AUDIO"],

"system_instruction": "You are a helpful and friendly AI assistant.",

}

audio_queue_output = asyncio.Queue()

audio_queue_mic = asyncio.Queue(maxsize=5)

audio_stream = None

async def listen_audio():

"""Listens for audio and puts it into the mic audio queue."""

global audio_stream

mic_info = pya.get_default_input_device_info()

audio_stream = await asyncio.to_thread(

pya.open,

format=FORMAT,

channels=CHANNELS,

rate=SEND_SAMPLE_RATE,

input=True,

input_device_index=mic_info["index"],

frames_per_buffer=CHUNK_SIZE,

)

kwargs = {"exception_on_overflow": False} if __debug__ else {}

while True:

data = await asyncio.to_thread(audio_stream.read, CHUNK_SIZE, **kwargs)

await audio_queue_mic.put({"data": data, "mime_type": "audio/pcm"})

async def send_realtime(session):

"""Sends audio from the mic audio queue to the GenAI session."""

while True:

msg = await audio_queue_mic.get()

await session.send_realtime_input(audio=msg)

async def receive_audio(session):

"""Receives responses from GenAI and puts audio data into the speaker audio queue."""

while True:

turn = session.receive()

async for response in turn:

if (response.server_content and response.server_content.model_turn):

for part in response.server_content.model_turn.parts:

if part.inline_data and isinstance(part.inline_data.data, bytes):

audio_queue_output.put_nowait(part.inline_data.data)

# Empty the queue on interruption to stop playback

while not audio_queue_output.empty():

audio_queue_output.get_nowait()

async def play_audio():

"""Plays audio from the speaker audio queue."""

stream = await asyncio.to_thread(

pya.open,

format=FORMAT,

channels=CHANNELS,

rate=RECEIVE_SAMPLE_RATE,

output=True,

)

while True:

bytestream = await audio_queue_output.get()

await asyncio.to_thread(stream.write, bytestream)

async def run():

"""Main function to run the audio loop."""

try:

async with client.aio.live.connect(

model=MODEL, config=CONFIG

) as live_session:

print("Connected to Gemini. Start speaking!")

async with asyncio.TaskGroup() as tg:

tg.create_task(send_realtime(live_session))

tg.create_task(listen_audio())

tg.create_task(receive_audio(live_session))

tg.create_task(play_audio())

except asyncio.CancelledError:

pass

finally:

if audio_stream:

audio_stream.close()

pya.terminate()

print("\nConnection closed.")

if __name__ == "__main__":

try:

asyncio.run(run())

except KeyboardInterrupt:

print("Interrupted by user.")

JavaScript

Instale helpers para transmissão de áudio. Outras dependências no nível do sistema podem ser necessárias (sox para Mac/Windows ou ALSA para Linux). Consulte os documentos do alto-falante e do microfone para ver as etapas detalhadas de instalação.

npm install mic speakerimport { GoogleGenAI, Modality } from '@google/genai';

import mic from 'mic';

import Speaker from 'speaker';

const ai = new GoogleGenAI({});

// WARNING: Do not use API keys in client-side (browser based) applications

// Consider using Ephemeral Tokens instead

// More information at: https://ai.google.dev/gemini-api/docs/ephemeral-tokens

// --- Live API config ---

const model = 'gemini-2.5-flash-native-audio-preview-12-2025';

const config = {

responseModalities: [Modality.AUDIO],

systemInstruction: "You are a helpful and friendly AI assistant.",

};

async function live() {

const responseQueue = [];

const audioQueue = [];

let speaker;

async function waitMessage() {

while (responseQueue.length === 0) {

await new Promise((resolve) => setImmediate(resolve));

}

return responseQueue.shift();

}

function createSpeaker() {

if (speaker) {

process.stdin.unpipe(speaker);

speaker.end();

}

speaker = new Speaker({

channels: 1,

bitDepth: 16,

sampleRate: 24000,

});

speaker.on('error', (err) => console.error('Speaker error:', err));

process.stdin.pipe(speaker);

}

async function messageLoop() {

// Puts incoming messages in the audio queue.

while (true) {

const message = await waitMessage();

if (message.serverContent && message.serverContent.interrupted) {

// Empty the queue on interruption to stop playback

audioQueue.length = 0;

continue;

}

if (message.serverContent && message.serverContent.modelTurn && message.serverContent.modelTurn.parts) {

for (const part of message.serverContent.modelTurn.parts) {

if (part.inlineData && part.inlineData.data) {

audioQueue.push(Buffer.from(part.inlineData.data, 'base64'));

}

}

}

}

}

async function playbackLoop() {

// Plays audio from the audio queue.

while (true) {

if (audioQueue.length === 0) {

if (speaker) {

// Destroy speaker if no more audio to avoid warnings from speaker library

process.stdin.unpipe(speaker);

speaker.end();

speaker = null;

}

await new Promise((resolve) => setImmediate(resolve));

} else {

if (!speaker) createSpeaker();

const chunk = audioQueue.shift();

await new Promise((resolve) => {

speaker.write(chunk, () => resolve());

});

}

}

}

// Start loops

messageLoop();

playbackLoop();

// Connect to Gemini Live API

const session = await ai.live.connect({

model: model,

config: config,

callbacks: {

onopen: () => console.log('Connected to Gemini Live API'),

onmessage: (message) => responseQueue.push(message),

onerror: (e) => console.error('Error:', e.message),

onclose: (e) => console.log('Closed:', e.reason),

},

});

// Setup Microphone for input

const micInstance = mic({

rate: '16000',

bitwidth: '16',

channels: '1',

});

const micInputStream = micInstance.getAudioStream();

micInputStream.on('data', (data) => {

// API expects base64 encoded PCM data

session.sendRealtimeInput({

audio: {

data: data.toString('base64'),

mimeType: "audio/pcm;rate=16000"

}

});

});

micInputStream.on('error', (err) => {

console.error('Microphone error:', err);

});

micInstance.start();

console.log('Microphone started. Speak now...');

}

live().catch(console.error);

Exemplos de aplicativos

Confira os seguintes exemplos de aplicativos que ilustram como usar a API Live para casos de uso completos:

- App inicial de áudio ao vivo no AI Studio, usando bibliotecas JavaScript para se conectar à API Live e transmitir áudio bidirecional pelo microfone e pelos alto-falantes.

- Consulte as integrações de parceiros para ver mais exemplos e guias de início.

A seguir

- Leia o guia completo de Recursos da API Live para conhecer os principais recursos e configurações, incluindo detecção de atividade de voz e recursos de áudio nativos.

- Leia o guia Uso de ferramentas para saber como integrar a API Live com ferramentas e chamadas de função.

- Leia o guia Gerenciamento de sessões para gerenciar conversas longas.

- Leia o guia Tokens efêmeros para autenticação segura em aplicativos cliente-servidor.

- Para mais informações sobre a API WebSockets subjacente, consulte a referência da API WebSockets.