توفّر Gemini API إعدادات أمان يمكنك تعديلها خلال مرحلة إنشاء النموذج الأوّلي لتحديد ما إذا كان تطبيقك يتطلّب إعدادات أمان أكثر أو أقل تقييدًا. يمكنك تعديل هذه الإعدادات في أربع فئات من الفلاتر لحظر أنواع معيّنة من المحتوى أو السماح بها.

يتناول هذا الدليل كيفية تعامل Gemini API مع إعدادات الأمان وعمليات الفلترة، وكيفية تغيير إعدادات الأمان لتطبيقك.

فلاتر السلامة

تغطي فلاتر الأمان القابلة للضبط في Gemini API الفئات التالية:

| الفئة | الوصف |

|---|---|

| التحرش | التعليقات السلبية أو المؤذية التي تستهدف الهوية و/أو السمات المحمية |

| الكلام الذي يحضّ على الكراهية | المحتوى الفظ أو المهين أو البذيء |

| محتوى جنسي فاضح | تتضمّن السمة إشارات إلى أفعال جنسية أو محتوًى بذيئًا آخر. |

| الفئات الخطيرة | الترويج لأفعال ضارّة أو تسهيل تنفيذها أو التشجيع عليها |

يتم تحديد هذه الفئات في HarmCategory. يمكنك استخدام هذه الفلاتر لتعديل ما هو مناسب لحالة الاستخدام. على سبيل المثال، إذا كنت تعمل على إنشاء حوارات في ألعاب الفيديو، قد يكون من المقبول السماح بالمزيد من المحتوى الذي تم تقييمه على أنّه خطير بسبب طبيعة اللعبة.

بالإضافة إلى فلاتر الأمان القابلة للتعديل، تتضمّن Gemini API وسائل حماية مدمجة ضد الأضرار الأساسية، مثل المحتوى الذي يعرّض سلامة الأطفال للخطر. يتم حظر هذه الأنواع من المحتوى الضار دائمًا ولا يمكن تعديلها.

مستوى فلترة أمان المحتوى

تصنّف Gemini API مستوى احتمال أن يكون المحتوى غير آمن على النحو التالي:

HIGH أو MEDIUM أو LOW أو NEGLIGIBLE.

تحظر Gemini API المحتوى استنادًا إلى احتمال أن يكون المحتوى غير آمن، وليس إلى مدى خطورته. من المهم أخذ ذلك في الاعتبار لأنّ بعض المحتوى قد يكون احتمال أن يكون غير آمن منخفضًا، مع أنّ درجة الضرر قد تظل عالية. على سبيل المثال، عند مقارنة الجملتين:

- لقد لكمني الروبوت.

- وقد جرحني الروبوت.

قد تؤدي الجملة الأولى إلى زيادة احتمال أن تكون غير آمنة، ولكن قد تعتبر الجملة الثانية أكثر خطورة من حيث العنف. وبناءً على ذلك، من المهم أن تختبر بعناية مستوى الحظر المناسب المطلوب لدعم حالات الاستخدام الرئيسية مع تقليل الضرر الذي قد يلحق بالمستخدمين النهائيين.

فلترة السلامة لكل طلب

يمكنك تعديل إعدادات الأمان لكل طلب ترسله إلى واجهة برمجة التطبيقات. عندما تقدّم طلبًا، يتم تحليل المحتوى وتعيين تقييم أمان له. يتضمّن تقييم الأمان الفئة واحتمالية تصنيف الضرر. على سبيل المثال، إذا تم حظر المحتوى بسبب ارتفاع احتمال تصنيفه ضمن فئة المضايقة، سيكون التقييم الخاص بالأمان الذي تم إرجاعه يتضمّن فئة تساوي HARASSMENT واحتمال حدوث ضرر يساوي HIGH.

بسبب الأمان المتأصّل في النموذج، تكون الفلاتر الإضافية غير مفعَّلة تلقائيًا. في حال اختيار تفعيلها، يمكنك ضبط النظام لحظر المحتوى استنادًا إلى احتمال أن يكون غير آمن. يغطي السلوك التلقائي للنموذج معظم حالات الاستخدام، لذا يجب عدم تعديل هذه الإعدادات إلا إذا كان التطبيق يتطلب اتساقًا.

يوضّح الجدول التالي إعدادات الحظر التي يمكنك تعديلها لكل فئة. على سبيل المثال، إذا ضبطت إعدادات الحظر على حظر عدد قليل لفئة خطاب الكراهية، سيتم حظر كل المحتوى الذي يُحتمل أن يكون خطاب كراهية. ولكن يُسمح بأي قيمة احتمالية أقل.

| الحدّ (Google AI Studio) | الحدّ (واجهة برمجة التطبيقات) | الوصف |

|---|---|---|

| إيقاف | OFF |

إيقاف فلتر الأمان |

| عدم حظر أي شيء | BLOCK_NONE |

العرض دائمًا بغض النظر عن احتمال وجود محتوى غير آمن |

| حظر عدد قليل من المستخدمين | BLOCK_ONLY_HIGH |

الحظر عند وجود احتمال كبير بأن يكون المحتوى غير آمن |

| حظر بعض المحتوى | BLOCK_MEDIUM_AND_ABOVE |

الحظر عند وجود احتمال متوسط أو كبير بأن يكون المحتوى غير آمن |

| حظر معظم | BLOCK_LOW_AND_ABOVE |

الحظر عند وجود احتمال منخفض أو متوسط أو مرتفع بأن يكون المحتوى غير آمن |

| لا ينطبق | HARM_BLOCK_THRESHOLD_UNSPECIFIED |

لم يتم تحديد الحدّ الأدنى، يتم الحظر باستخدام الحدّ الأدنى التلقائي |

إذا لم يتم ضبط الحد، يكون الحد التلقائي للحظر هو إيقاف لطُرز Gemini 2.5 و3.

يمكنك ضبط هذه الإعدادات لكل طلب ترسله إلى الخدمة التوليدية.

يمكنك الاطّلاع على مرجع واجهة برمجة التطبيقات HarmBlockThreshold لمعرفة التفاصيل.

ملاحظات حول الأمان

تعرض الدالة generateContent

GenerateContentResponse التي

تتضمّن ملاحظات حول السلامة.

يتم تضمين الملاحظات الفورية في

promptFeedback. إذا تم ضبط promptFeedback.blockReason، يعني ذلك أنّه تم حظر محتوى الطلب.

يتم تضمين الملاحظات حول المرشحين للردود في

Candidate.finishReason و

Candidate.safetyRatings. إذا تم حظر محتوى الردّ وكان finishReason هو SAFETY، يمكنك فحص safetyRatings للحصول على مزيد من التفاصيل. لا يتم إرجاع المحتوى الذي تم حظره.

تعديل إعدادات الأمان

يتناول هذا القسم كيفية تعديل إعدادات الأمان في كلّ من Google AI Studio وفي الرمز البرمجي.

Google AI Studio

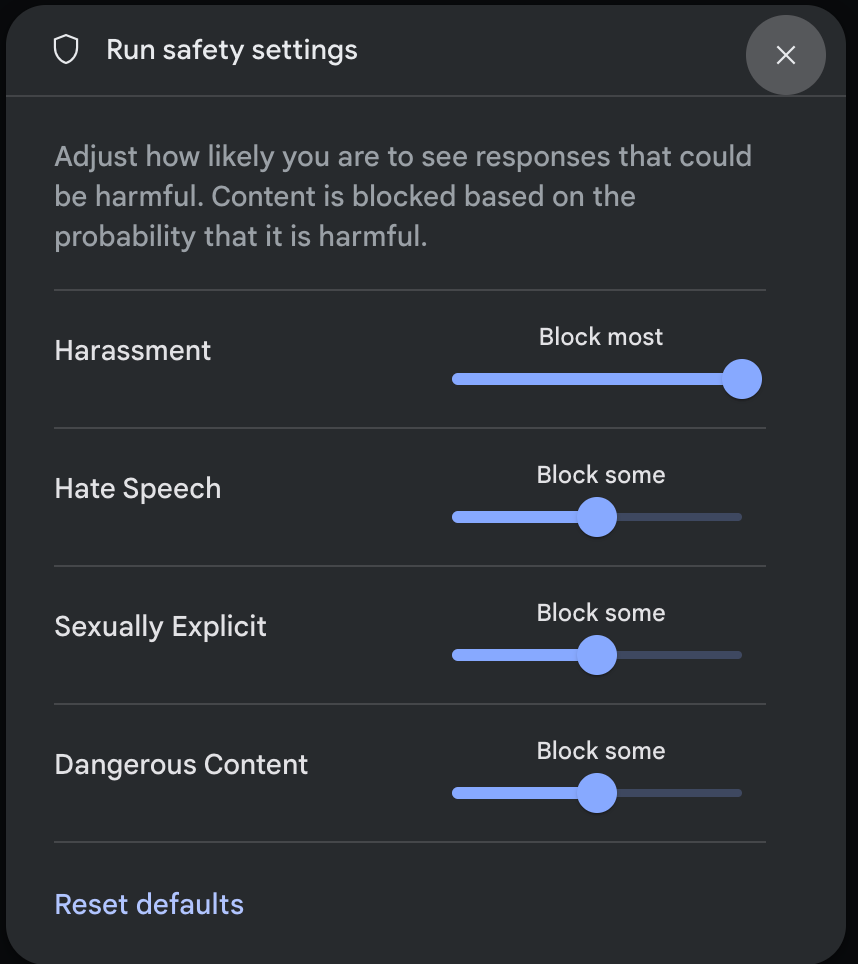

يمكنك تعديل إعدادات الأمان في Google AI Studio.

انقر على إعدادات الأمان ضمن الإعدادات المتقدّمة في لوحة إعدادات التنفيذ لفتح النافذة المنبثقة إعدادات الأمان. في النافذة المنبثقة، يمكنك استخدام أشرطة التمرير لضبط مستوى فلترة المحتوى لكل فئة من فئات الأمان:

عند إرسال طلب (على سبيل المثال، طرح سؤال على النموذج)، ستظهر الرسالة تم حظر المحتوى إذا كان محتوى الطلب محظورًا. للاطّلاع على مزيد من التفاصيل، مرِّر المؤشر فوق النص تم حظر المحتوى للاطّلاع على الفئة واحتمالية تصنيف المحتوى على أنّه ضار.

أمثلة على الرموز

يوضّح مقتطف الرمز التالي كيفية ضبط إعدادات الأمان في GenerateContent مكالمتك. يؤدي ذلك إلى ضبط الحد الأدنى لفئة المحتوى الذي يحض على الكراهية (HARM_CATEGORY_HATE_SPEECH). يؤدي ضبط هذه الفئة على

BLOCK_LOW_AND_ABOVE إلى حظر أي محتوى لديه احتمال منخفض أو أعلى بأن يكون

كلامًا يحض على الكراهية. للتعرّف على إعدادات الحدّ، راجِع فلترة المحتوى غير الملائم

لكل طلب.

Python

from google import genai

from google.genai import types

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="Some potentially unsafe prompt",

config=types.GenerateContentConfig(

safety_settings=[

types.SafetySetting(

category=types.HarmCategory.HARM_CATEGORY_HATE_SPEECH,

threshold=types.HarmBlockThreshold.BLOCK_LOW_AND_ABOVE,

),

]

)

)

print(response.text)

Go

package main

import (

"context"

"fmt"

"log"

"google.golang.org/genai"

)

func main() {

ctx := context.Background()

client, err := genai.NewClient(ctx, nil)

if err != nil {

log.Fatal(err)

}

config := &genai.GenerateContentConfig{

SafetySettings: []*genai.SafetySetting{

{

Category: "HARM_CATEGORY_HATE_SPEECH",

Threshold: "BLOCK_LOW_AND_ABOVE",

},

},

}

response, err := client.Models.GenerateContent(

ctx,

"gemini-3-flash-preview",

genai.Text("Some potentially unsafe prompt."),

config,

)

if err != nil {

log.Fatal(err)

}

fmt.Println(response.Text())

}

JavaScript

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

const safetySettings = [

{

category: "HARM_CATEGORY_HATE_SPEECH",

threshold: "BLOCK_LOW_AND_ABOVE",

},

];

async function main() {

const response = await ai.models.generateContent({

model: "gemini-3-flash-preview",

contents: "Some potentially unsafe prompt.",

config: {

safetySettings: safetySettings,

},

});

console.log(response.text);

}

await main();

جافا

SafetySetting hateSpeechSafety = new SafetySetting(HarmCategory.HATE_SPEECH,

BlockThreshold.LOW_AND_ABOVE);

GenerativeModel gm = new GenerativeModel(

"gemini-3-flash-preview",

BuildConfig.apiKey,

null, // generation config is optional

Arrays.asList(hateSpeechSafety)

);

GenerativeModelFutures model = GenerativeModelFutures.from(gm);

REST

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-flash-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H "Content-Type: application/json" \

-X POST \

-d '{

"safetySettings": [

{"category": "HARM_CATEGORY_HATE_SPEECH", "threshold": "BLOCK_LOW_AND_ABOVE"}

],

"contents": [{

"parts":[{

"text": "'\''Some potentially unsafe prompt.'\''"

}]

}]

}'

الخطوات التالية

- اطّلِع على مرجع واجهة برمجة التطبيقات لمعرفة المزيد عن واجهة برمجة التطبيقات الكاملة.

- راجِع إرشادات السلامة للحصول على نظرة عامة حول اعتبارات السلامة عند التطوير باستخدام النماذج اللغوية الكبيرة.

- مزيد من المعلومات حول تقييم الاحتمالية مقابل الخطورة من فريق Jigsaw

- مزيد من المعلومات حول المنتجات التي تساهم في توفير حلول الأمان، مثل Perspective API * يمكنك استخدام إعدادات الأمان هذه لإنشاء مصنّف للمحتوى السام. يمكنك الاطّلاع على مثال التصنيف للبدء.