Zadanie MediaPipe Object Detector umożliwia wykrywanie obecności i lokalizacji wielu klas obiektów. Z tych instrukcji dowiesz się, jak korzystać z zadania detekcji obiektów w Pythonie. Przykład kodu opisany w tych instrukcjach jest dostępny na GitHub.

Aby zobaczyć, jak to zadanie działa w praktyce, obejrzyj prezentację internetową. Więcej informacji o możliwościach, modelach i opcjach konfiguracji tego zadania znajdziesz w sekcji Omówienie.

Przykładowy kod

Przykładowy kod dla usługi Object Detector zawiera kompletną implementację tego zadania w języku Python. Ten kod pomoże Ci przetestować to zadanie i rozpocząć tworzenie własnej aplikacji do klasyfikacji tekstu. Możesz wyświetlać, uruchamiać i edytować przykładowy kod usługi Object Detector, korzystając tylko z przeglądarki internetowej.

Jeśli wdrażasz moduł wykrywania obiektów na Raspberry Pi, zapoznaj się z przykładową aplikacją na Raspberry Pi.

Konfiguracja

W tej sekcji opisaliśmy najważniejsze kroki konfigurowania środowiska programistycznego i projektów kodu na potrzeby używania usługi Object Detector. Ogólne informacje o konfigurowaniu środowiska programistycznego na potrzeby korzystania z zadań MediaPipe, w tym wymagania dotyczące wersji platformy, znajdziesz w przewodniku po konfigurowaniu Pythona.

Pakiety

Zadanie Wykrywanie obiektów wymaga pakietu mediapipe pip. Wymagane pakiety możesz zainstalować za pomocą tych poleceń:

$ python -m pip install mediapipe

Importy

Aby uzyskać dostęp do funkcji zadania Object Detector, zaimportuj te klasy:

import mediapipe as mp

from mediapipe.tasks import python

from mediapipe.tasks.python import vision

Model

Zadanie Wykrywanie obiektów MediaPipe wymaga wytrenowanego modelu zgodnego z tym zadaniem. Więcej informacji o dostępnych wytrenowanych modelach usługi Detektor obiektów znajdziesz w sekcji Modele w omówieniu zadania.

Wybierz i pobierz model, a potem zapisz go w katalogu lokalnym:

model_path = '/absolute/path/to/lite-model_efficientdet_lite0_detection_metadata_1.tflite'

Aby określić ścieżkę do modelu, użyj parametru BaseOptions obiektu model_asset_path. Przykład kodu znajdziesz w następnej sekcji.

Tworzenie zadania

Utwórz zadanie, używając funkcji create_from_options. Funkcja create_from_options akceptuje opcje konfiguracji, takie jak tryb działania, lokalizacja wyświetlania nazw, maksymalna liczba wyników, próg ufności, lista dozwolonych kategorii i lista zabronionych kategorii. Jeśli nie ustawisz opcji konfiguracji, zadanie użyje wartości domyślnej. Więcej informacji o opcjach konfiguracji znajdziesz w sekcji Opcje konfiguracji.

Zadanie Wykrywanie obiektów obsługuje kilka typów danych wejściowych: obrazy, pliki wideo i transmisje wideo na żywo. Wybierz kartę odpowiadającą typowi danych wejściowych, aby dowiedzieć się, jak utworzyć zadanie i przeprowadzić wnioskowanie.

Obraz

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions ObjectDetector = mp.tasks.vision.ObjectDetector ObjectDetectorOptions = mp.tasks.vision.ObjectDetectorOptions VisionRunningMode = mp.tasks.vision.RunningMode options = ObjectDetectorOptions( base_options=BaseOptions(model_asset_path='/path/to/model.tflite'), max_results=5, running_mode=VisionRunningMode.IMAGE) with ObjectDetector.create_from_options(options) as detector: # The detector is initialized. Use it here. # ...

Wideo

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions ObjectDetector = mp.tasks.vision.ObjectDetector ObjectDetectorOptions = mp.tasks.vision.ObjectDetectorOptions VisionRunningMode = mp.tasks.vision.RunningMode options = ObjectDetectorOptions( base_options=BaseOptions(model_asset_path='/path/to/model.tflite'), max_results=5, running_mode=VisionRunningMode.VIDEO) with ObjectDetector.create_from_options(options) as detector: # The detector is initialized. Use it here. # ...

Transmisja na żywo

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions DetectionResult = mp.tasks.components.containers.detections.DetectionResult ObjectDetector = mp.tasks.vision.ObjectDetector ObjectDetectorOptions = mp.tasks.vision.ObjectDetectorOptions VisionRunningMode = mp.tasks.vision.RunningMode def print_result(result: DetectionResult, output_image: mp.Image, timestamp_ms: int): print('detection result: {}'.format(result)) options = ObjectDetectorOptions( base_options=BaseOptions(model_asset_path='/path/to/model.tflite'), running_mode=VisionRunningMode.LIVE_STREAM, max_results=5, result_callback=print_result) with ObjectDetector.create_from_options(options) as detector: # The detector is initialized. Use it here. # ...

Pełny przykład tworzenia modułu Object Detector do użycia z obrazem znajdziesz w przykładowym kodzie.

Opcje konfiguracji

W tym zadaniu dostępne są te opcje konfiguracji aplikacji Pythona:

| Nazwa opcji | Opis | Zakres wartości | Wartość domyślna |

|---|---|---|---|

running_mode |

Ustawia tryb działania zadania. Dostępne są 3 tryby: OBRAZ: tryb dla pojedynczych obrazów wejściowych. VIDEO: tryb dekodowanych klatek filmu. LIVE_STREAM: tryb transmisji na żywo danych wejściowych, takich jak dane z kamery. W tym trybie należy wywołać metodę resultListener, aby skonfigurować odbiornik, który będzie asynchronicznie odbierał wyniki. |

{IMAGE, VIDEO, LIVE_STREAM} |

IMAGE |

display_names |

Określa język etykiet, których należy używać do wyświetlanych nazw podanych w metadanych modelu zadania (jeśli są dostępne). Wartość domyślna to en w przypadku języka angielskiego. Możesz dodawać zlokalizowane etykiety do metadanych modelu niestandardowego, korzystając z interfejsu TensorFlow Lite Metadata Writer API.

|

Kod języka | en |

max_results |

Ustawia opcjonalną maksymalną liczbę wyników wykrywania o najwyższym wyniku, które mają zostać zwrócone. | dowolne liczby dodatnie. | -1 (zwracane są wszystkie wyniki). |

score_threshold |

Ustawia próg wyniku prognozy, który zastępuje próg podany w metadanych modelu (jeśli takie istnieją). Wyniki poniżej tej wartości są odrzucane. | Dowolna liczba zmiennych typu float | Nie ustawiono |

category_allowlist |

Ustawia opcjonalną listę dozwolonych nazw kategorii. Jeśli wyniki wykrywania nie są puste, a nazwa kategorii nie znajduje się w tym zbiorze, zostaną odfiltrowane. Powtarzające się lub nieznane nazwy kategorii są ignorowane.

Ta opcja jest wzajemnie wykluczająca się z opcją category_denylist. Użycie obu spowoduje błąd. |

dowolne ciągi znaków; | Nie ustawiono |

category_denylist |

Ustawia opcjonalną listę nazw kategorii, które są niedozwolone. Jeśli nie jest pusty, wyniki wykrywania, których nazwa kategorii znajduje się w tym zbiorze, zostaną odfiltrowane. Powtarzające się lub nieznane nazwy kategorii są ignorowane. Ta opcja jest wzajemnie wykluczająca się z opcją category_allowlist, a użycie obu spowoduje błąd. |

dowolne ciągi znaków; | Nie ustawiono |

Przygotuj dane

Przygotuj dane wejściowe jako plik obrazu lub tablicę numpy, a następnie przekształć je w obiekt mediapipe.Image. Jeśli dane wejściowe to plik wideo lub transmisja na żywo z kamery internetowej, możesz użyć biblioteki zewnętrznej, takiej jak OpenCV, aby załadować ramki wejściowe jako tablice numpy.

W przypadku każdego z dostępnych typów danych znajdziesz przykłady, które pokazują, jak przygotować dane do przetwarzania:

Obraz

import mediapipe as mp # Load the input image from an image file. mp_image = mp.Image.create_from_file('/path/to/image') # Load the input image from a numpy array. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_image)

Wideo

import mediapipe as mp # Use OpenCV’s VideoCapture to load the input video. # Load the frame rate of the video using OpenCV’s CV_CAP_PROP_FPS # You’ll need it to calculate the timestamp for each frame. # Loop through each frame in the video using VideoCapture#read() # Convert the frame received from OpenCV to a MediaPipe’s Image object. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_frame_from_opencv)

Transmisja na żywo

import mediapipe as mp # Use OpenCV’s VideoCapture to start capturing from the webcam. # Create a loop to read the latest frame from the camera using VideoCapture#read() # Convert the frame received from OpenCV to a MediaPipe’s Image object. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_frame_from_opencv)

Uruchamianie zadania

Aby wywołać wnioskowanie, możesz wywołać jedną z funkcji wykrywania. Zadanie wykrywania obiektów zwróci obiekty wykryte na wejściowym obrazie lub klatce.

Obraz

# Perform object detection on the provided single image. detection_result = detector.detect(mp_image)

Wideo

# Calculate the timestamp of the current frame frame_timestamp_ms = 1000 * frame_index / video_file_fps # Perform object detection on the video frame. detection_result = detector.detect_for_video(mp_image, frame_timestamp_ms)

Transmisja na żywo

# Send the latest frame to perform object detection. # Results are sent to the `result_callback` provided in the `ObjectDetectorOptions`. detector.detect_async(mp_image, frame_timestamp_ms)

Pełny przykład użycia modułu Object Detection na obrazie znajdziesz w przykładowym kodzie.

Pamiętaj:

- W trybie wideo lub transmisji na żywo musisz też przekazać zadaniu detektora obiektów sygnaturę czasową klatki wejściowej.

- Gdy działa w modelu obrazu lub filmu, zadanie Wykrywanie obiektów blokuje bieżący wątek, dopóki nie zakończy przetwarzania obrazu wejściowego lub klatki.

- W trybie transmisji na żywo zadanie detektora obiektów nie blokuje bieżącego wątku, ale zwraca wynik natychmiast. Za każdym razem, gdy zakończy przetwarzanie ramki wejściowej, wywoła swojego słuchacza z wynikiem wykrywania. Jeśli funkcja wykrywania jest wywoływana, gdy zadanie detektora obiektów jest zajęte przetwarzaniem innego kadru, nowy kadr wejściowy zostanie zignorowany.

Obsługa i wyświetlanie wyników

Po przeprowadzeniu wnioskowania zadanie detektora obiektów zwraca obiekt ObjectDetectionResult, który opisuje obiekty znalezione na wejściowym obrazie.

Poniżej znajdziesz przykład danych wyjściowych z tego zadania:

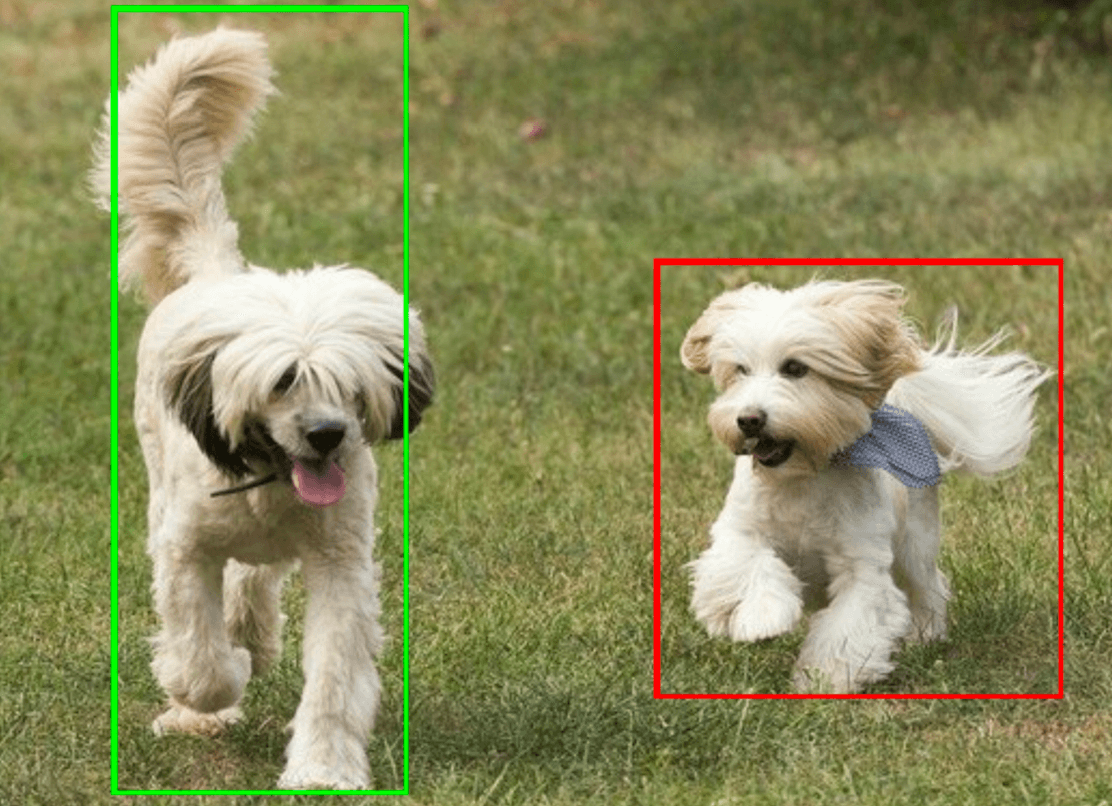

ObjectDetectorResult:

Detection #0:

Box: (x: 355, y: 133, w: 190, h: 206)

Categories:

index : 17

score : 0.73828

class name : dog

Detection #1:

Box: (x: 103, y: 15, w: 138, h: 369)

Categories:

index : 17

score : 0.73047

class name : dog

Na ilustracji poniżej widać wynik wykonania zadania:

Przykładowy kod usługi Object Detector pokazuje, jak wyświetlać wyniki wykrywania zwrócone przez zadanie. Szczegółowe informacje znajdziesz w przykładowym kodzie.