Live API, Gemini ile düşük gecikmeli ve anlık sesli ve görüntülü etkileşimler sağlar. Kullanıcılarınıza doğal bir sohbet deneyimi sunmak için anında, insan benzeri sözlü yanıtlar vermek üzere sürekli ses, video veya metin akışlarını işler.

Live API; ses etkinliği algılama, araç kullanımı ve işlev çağırma, oturum yönetimi (uzun süren sohbetleri yönetmek için) ve kısa ömürlü jetonlar (güvenli istemci taraflı kimlik doğrulama için) gibi kapsamlı bir özellik seti sunar.

Bu sayfada, örnekler ve temel kod örnekleriyle çalışmaya başlayabilirsiniz.

Google AI Studio'da Live API'yi deneyin

Bir uygulama yaklaşımı seçin

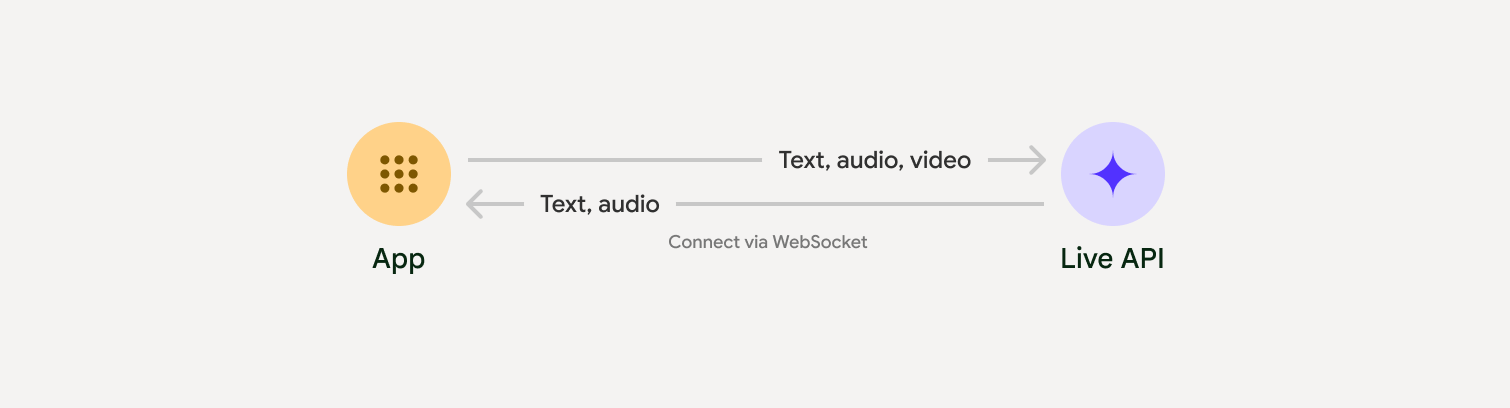

Live API ile entegrasyon yaparken aşağıdaki uygulama yaklaşımlarından birini seçmeniz gerekir:

- Sunucudan sunucuya: Arka ucunuz, WebSockets kullanarak Live API'ye bağlanır. Genellikle istemciniz, akış verilerini (ses, video, metin) sunucunuza gönderir. Sunucunuz da bu verileri Live API'ye iletir.

- İstemciden sunucuya: Ön uç kodunuz, verileri yayınlamak için WebSockets kullanarak doğrudan Live API'ye bağlanır ve arka ucunuzu atlar.

İş ortağı entegrasyonları

Gerçek zamanlı ses ve video uygulamalarının geliştirilmesini kolaylaştırmak için WebRTC veya WebSocket'ler üzerinden Gemini Live API'yi destekleyen bir üçüncü taraf entegrasyonu kullanabilirsiniz.

Pipecat by Daily

Gemini Live ve Pipecat'i kullanarak anlık yapay zeka sohbet botu oluşturun.

LiveKit

Gemini Live API'yi LiveKit Agents ile kullanma

Software Mansion tarafından geliştirilen Fishjam

Fishjam ile canlı video ve ses akışı uygulamaları oluşturun.

Agent Development Kit (ADK)

Live API'yi Agent Development Kit (ADK) ile uygulayın.

Akışa Göre Vision Agents

Vision Agents ile gerçek zamanlı ses ve video yapay zeka uygulamaları oluşturun.

Voximplant

Gelen ve giden aramaları Voximplant ile Live API'ye bağlayın.

Başlayın

Bu sunucu tarafı örneği, mikrofondaki sesi yayınlar ve döndürülen sesi çalar. İstemci uygulaması da dahil olmak üzere uçtan uca örneklerin tamamı için Örnek uygulamalar bölümüne bakın.

Giriş ses biçimi 16 bit PCM, 16 kHz, mono biçiminde olmalı ve alınan ses 24 kHz örnekleme hızını kullanmalıdır.

Python

Ses akışı için yardımcıları yükleyin. Ek sistem düzeyinde bağımlılıklar (ör. portaudio) gerekebilir. Ayrıntılı yükleme adımları için PyAudio belgelerine bakın.

pip install pyaudioimport asyncio

from google import genai

import pyaudio

client = genai.Client()

# --- pyaudio config ---

FORMAT = pyaudio.paInt16

CHANNELS = 1

SEND_SAMPLE_RATE = 16000

RECEIVE_SAMPLE_RATE = 24000

CHUNK_SIZE = 1024

pya = pyaudio.PyAudio()

# --- Live API config ---

MODEL = "gemini-2.5-flash-native-audio-preview-12-2025"

CONFIG = {

"response_modalities": ["AUDIO"],

"system_instruction": "You are a helpful and friendly AI assistant.",

}

audio_queue_output = asyncio.Queue()

audio_queue_mic = asyncio.Queue(maxsize=5)

audio_stream = None

async def listen_audio():

"""Listens for audio and puts it into the mic audio queue."""

global audio_stream

mic_info = pya.get_default_input_device_info()

audio_stream = await asyncio.to_thread(

pya.open,

format=FORMAT,

channels=CHANNELS,

rate=SEND_SAMPLE_RATE,

input=True,

input_device_index=mic_info["index"],

frames_per_buffer=CHUNK_SIZE,

)

kwargs = {"exception_on_overflow": False} if __debug__ else {}

while True:

data = await asyncio.to_thread(audio_stream.read, CHUNK_SIZE, **kwargs)

await audio_queue_mic.put({"data": data, "mime_type": "audio/pcm"})

async def send_realtime(session):

"""Sends audio from the mic audio queue to the GenAI session."""

while True:

msg = await audio_queue_mic.get()

await session.send_realtime_input(audio=msg)

async def receive_audio(session):

"""Receives responses from GenAI and puts audio data into the speaker audio queue."""

while True:

turn = session.receive()

async for response in turn:

if (response.server_content and response.server_content.model_turn):

for part in response.server_content.model_turn.parts:

if part.inline_data and isinstance(part.inline_data.data, bytes):

audio_queue_output.put_nowait(part.inline_data.data)

# Empty the queue on interruption to stop playback

while not audio_queue_output.empty():

audio_queue_output.get_nowait()

async def play_audio():

"""Plays audio from the speaker audio queue."""

stream = await asyncio.to_thread(

pya.open,

format=FORMAT,

channels=CHANNELS,

rate=RECEIVE_SAMPLE_RATE,

output=True,

)

while True:

bytestream = await audio_queue_output.get()

await asyncio.to_thread(stream.write, bytestream)

async def run():

"""Main function to run the audio loop."""

try:

async with client.aio.live.connect(

model=MODEL, config=CONFIG

) as live_session:

print("Connected to Gemini. Start speaking!")

async with asyncio.TaskGroup() as tg:

tg.create_task(send_realtime(live_session))

tg.create_task(listen_audio())

tg.create_task(receive_audio(live_session))

tg.create_task(play_audio())

except asyncio.CancelledError:

pass

finally:

if audio_stream:

audio_stream.close()

pya.terminate()

print("\nConnection closed.")

if __name__ == "__main__":

try:

asyncio.run(run())

except KeyboardInterrupt:

print("Interrupted by user.")

JavaScript

Ses akışı için yardımcıları yükleyin. Ek sistem düzeyinde bağımlılıklar gerekebilir (Mac/Windows için sox veya Linux için ALSA). Ayrıntılı yükleme adımları için hoparlör ve mikrofon belgelerine bakın.

npm install mic speakerimport { GoogleGenAI, Modality } from '@google/genai';

import mic from 'mic';

import Speaker from 'speaker';

const ai = new GoogleGenAI({});

// WARNING: Do not use API keys in client-side (browser based) applications

// Consider using Ephemeral Tokens instead

// More information at: https://ai.google.dev/gemini-api/docs/ephemeral-tokens

// --- Live API config ---

const model = 'gemini-2.5-flash-native-audio-preview-12-2025';

const config = {

responseModalities: [Modality.AUDIO],

systemInstruction: "You are a helpful and friendly AI assistant.",

};

async function live() {

const responseQueue = [];

const audioQueue = [];

let speaker;

async function waitMessage() {

while (responseQueue.length === 0) {

await new Promise((resolve) => setImmediate(resolve));

}

return responseQueue.shift();

}

function createSpeaker() {

if (speaker) {

process.stdin.unpipe(speaker);

speaker.end();

}

speaker = new Speaker({

channels: 1,

bitDepth: 16,

sampleRate: 24000,

});

speaker.on('error', (err) => console.error('Speaker error:', err));

process.stdin.pipe(speaker);

}

async function messageLoop() {

// Puts incoming messages in the audio queue.

while (true) {

const message = await waitMessage();

if (message.serverContent && message.serverContent.interrupted) {

// Empty the queue on interruption to stop playback

audioQueue.length = 0;

continue;

}

if (message.serverContent && message.serverContent.modelTurn && message.serverContent.modelTurn.parts) {

for (const part of message.serverContent.modelTurn.parts) {

if (part.inlineData && part.inlineData.data) {

audioQueue.push(Buffer.from(part.inlineData.data, 'base64'));

}

}

}

}

}

async function playbackLoop() {

// Plays audio from the audio queue.

while (true) {

if (audioQueue.length === 0) {

if (speaker) {

// Destroy speaker if no more audio to avoid warnings from speaker library

process.stdin.unpipe(speaker);

speaker.end();

speaker = null;

}

await new Promise((resolve) => setImmediate(resolve));

} else {

if (!speaker) createSpeaker();

const chunk = audioQueue.shift();

await new Promise((resolve) => {

speaker.write(chunk, () => resolve());

});

}

}

}

// Start loops

messageLoop();

playbackLoop();

// Connect to Gemini Live API

const session = await ai.live.connect({

model: model,

config: config,

callbacks: {

onopen: () => console.log('Connected to Gemini Live API'),

onmessage: (message) => responseQueue.push(message),

onerror: (e) => console.error('Error:', e.message),

onclose: (e) => console.log('Closed:', e.reason),

},

});

// Setup Microphone for input

const micInstance = mic({

rate: '16000',

bitwidth: '16',

channels: '1',

});

const micInputStream = micInstance.getAudioStream();

micInputStream.on('data', (data) => {

// API expects base64 encoded PCM data

session.sendRealtimeInput({

audio: {

data: data.toString('base64'),

mimeType: "audio/pcm;rate=16000"

}

});

});

micInputStream.on('error', (err) => {

console.error('Microphone error:', err);

});

micInstance.start();

console.log('Microphone started. Speak now...');

}

live().catch(console.error);

Örnek uygulamalar

Uçtan uca kullanım alanlarında Live API'nin nasıl kullanılacağını gösteren aşağıdaki örnek uygulamalara göz atın:

- AI Studio'da canlı ses başlangıç uygulaması. Bu uygulama, Live API'ye bağlanmak ve mikrofonunuz ile hoparlörleriniz üzerinden çift yönlü ses akışı sağlamak için JavaScript kitaplıklarını kullanır.

- Ek örnekler ve başlangıç kılavuzları için İş ortağı entegrasyonları bölümüne bakın.

Sırada ne var?

- Konuşma Etkinliği Algılama ve yerel ses özellikleri de dahil olmak üzere temel özellikler ve yapılandırmalar için Live API Özellikleri kılavuzunun tamamını okuyun.

- Live API'yi araçlarla ve işlev çağırmayla nasıl entegre edeceğinizi öğrenmek için Araç kullanımı kılavuzunu okuyun.

- Uzun süren görüşmeleri yönetmek için Oturum yönetimi kılavuzunu okuyun.

- İstemciden sunucuya uygulamalarda güvenli kimlik doğrulama için Geçici jetonlar kılavuzunu okuyun.

- Temel alınan WebSocket API'si hakkında daha fazla bilgi için WebSocket API referansı başlıklı makaleyi inceleyin.