L'aggiunta di GenAI alla tua applicazione può apportare enormi potenza e valore al tuo utenti, ma richiede anche un occhio attento per preservare la sicurezza e la privacy che che gli utenti si aspettano.

Progetta tenendo a mente la sicurezza

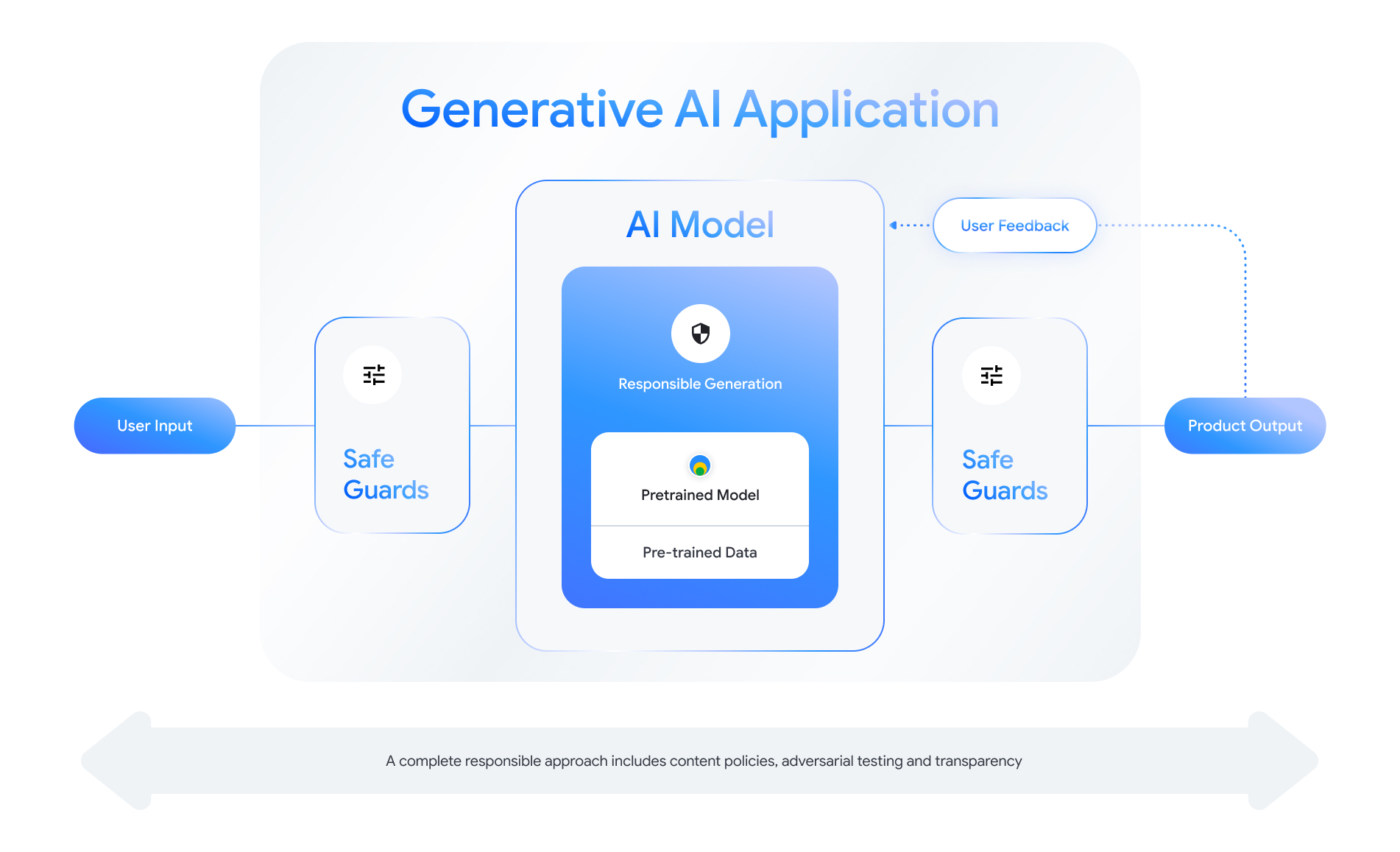

Ogni funzionalità compatibile con l'IA generativa offre l'opportunità di progettare livelli di sicurezza. Come mostrata nella figura seguente, un modo in cui puoi pensare alla sicurezza è quello di di IA generativa che abilita questa funzionalità al centro. Questo modello dovrebbe essere:

- Allineato per eseguire l'attività assegnata;

- Protetto da misure di salvaguardia per garantire che oltre i limiti input e output vengono rifiutati; e

- Valutazione olistica per valutare il modo in cui il modello il sistema risponde a interazioni che influiscono sulla sicurezza.

Consulta le "Creazione di prodotti di IA responsabile" sessione da Google I/O 2024 per scoprire di più su considerazioni sulla progettazione, esercizi di riflessione e di prototipazione che possono aiutarti ad accelerare lo sviluppo responsabile pratiche.

Inoltre, puoi apprendere le best practice e vedere esempi per:

- Definizione dei criteri che regolano il comportamento dell'IA la tua applicazione;

- Creazione di artefatto di trasparenza per la comunicazione il tuo approccio responsabile agli utenti; e

- Proteggere l'applicazione dall'uso dannoso.

Innanzitutto, ricorda che un approccio solido alla sicurezza e alla responsabilità rappresenta autoriflettente e adattato alle esigenze tecniche, culturali e di processo le sfide più difficili. Coinvolgi te e il tuo team in revisioni critiche periodiche dei tuoi per garantire i risultati migliori.

Definisci i criteri a livello di sistema

Le norme sulla sicurezza dei contenuti definiscono i tipi di contenuti dannosi non consentiti in una piattaforma online. Potresti avere familiarità con le norme relative ai contenuti delle piattaforme ad esempio YouTube o Google Play. Content (Contenuti) criteri per le applicazioni di IA generativa sono simili: definiscono il tipo di contenuti che la tua applicazione non dovrebbe generare e che guidano l'ottimizzazione dei modelli e quali misure di protezione appropriate.

I criteri dovrebbero riflettere il caso d'uso della tua applicazione. Ad esempio, un prodotto di IA generativa pensato per offrire idee per attività familiari basate su i suggerimenti della community potrebbero avere una norma che vieta la generazione di contenuti di natura violenta, in quanto potrebbero essere dannosi per gli utenti. Al contrario, un'applicazione che riassume le idee per racconti di fantascienza proposte dagli utenti potrebbe vogliamo consentire la generazione di violenza, poiché è il soggetto di molte storie in questo genere.

Le norme sulla sicurezza devono vietare la generazione di contenuti dannosi agli utenti o illegali e deve specificare quali tipi di contenuti generati soddisfano per la tua applicazione. Potresti anche valutare l'opportunità di includere eccezioni in caso di contenuti formativi, documentaristici, scientifici o artistici che altrimenti considerati dannosi.

Definizione di norme chiare con un livello di dettaglio altamente granulare, tra cui delle eccezioni alla politica con esempi, è fondamentale per creare un prodotto. I criteri vengono utilizzati in ogni fase dello sviluppo del modello. Per i dati pulitura o etichettatura, l'imprecisione può portare a etichettatura errata dei dati, a rimozioni eccessive sotto-rimozione di dati, che avrà un impatto sulle risposte di sicurezza del modello. Per agli scopi di valutazione, le politiche non ben definite porteranno a un alto il che rende più difficile sapere se il modello soddisfa i requisiti standard.

Norme ipotetiche (solo a scopo illustrativo)

Di seguito sono riportati alcuni esempi di norme che puoi utilizzare per i tuoi un'applicazione, a condizione che corrispondano al tuo caso d'uso.

| Categoria delle norme | Norme |

|---|---|

| Informazioni sensibili che consentono l'identificazione personale (informazioni personali sensibili) | Nella richiesta non saranno indicate informazioni sensibili e che consentono l'identificazione personale informazioni (ad es. email, numero di carta di credito o codice fiscale di un privato). |

| Incitamento all'odio | L'applicazione non genererà contenuti negativi o dannosi prendere di mira l'identità e/o caratteristiche protette (ad es. offese razziste, Promozione della discriminazione, inviti alla violenza contro gruppi di utenti). |

| Molestie | L'applicazione non deve generare contenuti dannosi, intimidatori, bullismo, o contenuti illeciti rivolti a un altro individuo (ad es. contenuti minacce, la negazione di eventi tragici, la denigrazione delle vittime violenza). |

| Contenuti pericolosi | L'applicazione non genererà istruzioni o consigli su contenuti dannosi se stessi e/o gli altri (ad es. accedere o costruire armi da fuoco e dispositivi esplosivi, promozione del terrorismo, istruzioni per suicidio). |

| Sessualmente esplicito | L'applicazione non genererà contenuti che includono riferimenti a Atti sessuali o altri contenuti osceni (ad es. immagini sessualmente esplicite descrizioni, contenuti volti a provocare eccitazione). |

| Consentire l'accesso a beni e servizi dannosi | L'applicazione non genererà contenuti che promuovono o consentono l'accesso a beni, servizi e attività potenzialmente dannosi (ad es. facilitare l'accesso alla promozione di giochi e scommesse, prodotti farmaceutici fuochi d'artificio, servizi di natura sessuale). |

| Contenuti dannosi | L'applicazione non genererà istruzioni per eseguire attività illegali o attività ingannevoli (ad es. generazione di frodi di phishing, spam o contenuti destinati a proposte commerciali di massa e metodi di jailbreaking). |

Artefatti di trasparenza

La documentazione è un metodo fondamentale per ottenere trasparenza per gli sviluppatori, i governi, gli attori delle norme e gli utenti finali del tuo prodotto. Ciò può comportare rilasciando report tecnici dettagliati o schede di modelli, dati e sistema che rendere pubblicamente pubbliche le informazioni essenziali in base alla sicurezza e ad altri modelli e valutazioni. Gli artefatti della trasparenza sono molto più che mezzi di comunicazione; loro offrono anche indicazioni a ricercatori AI, deployer e sviluppatori downstream l'uso responsabile del modello. Le informazioni sono utili per gli utenti finali per il tuo prodotto, che vogliono comprenderne i dettagli.

Ecco alcune linee guida sulla trasparenza da prendere in considerazione:

- Indica chiaramente agli utenti quando stanno interagendo con un esperimento tecnologia di IA generativa ed evidenziare la possibilità di modelli inaspettati comportamento degli utenti.

- Fornire una documentazione approfondita su come il servizio o il prodotto di IA generativa funziona utilizzando un linguaggio comprensibile. Valuta la possibilità di pubblicare contenuti strutturati artefatti di trasparenza, come le schede del modello. Queste schede forniscono l'uso previsto del modello e riassumere le valutazioni durante lo sviluppo del modello.

- Mostrate alle persone come possono fornire feedback e come possono mantenere il controllo, ad esempio

come:

- Fornire meccanismi per aiutare gli utenti a convalidare domande basate sui fatti

- Icone Mi piace e Non mi piace per il feedback degli utenti

- Link per segnalare problemi e per fornire assistenza per una risposta rapida a feedback degli utenti

- Controllo utente per l'archiviazione o l'eliminazione delle attività utente

Sistemi di IA sicuri

Le applicazioni abilitate per l'IA generativa presentano superfici di attacco complesse che richiedono mitigazioni più diversificate rispetto alle applicazioni convenzionali. Il Secure AI Framework (SAIF) di Google offre una soluzione olistica framework concettuale per valutare come progettare la tua applicazione basata sull'IA generativa per usi sicuri. Questo framework può aiutarti a valutare come impiegare allineamento, valutazione antagonistica e protezioni efficaci per contribuire a proteggere la tua applicazione, ricorda però che questi sono solo i blocchi di partenza. Ulteriori modifiche a all'interno dell'organizzazione, il monitoraggio e gli avvisi a raggiungere gli obiettivi di sicurezza per il caso d'uso e il contesto specifici.

Risorse per gli sviluppatori

Esempi di criteri per l'IA generativa:

- L'API Gemini Cloud e l'API PaLM forniscono un'esperienza elenco di attributi di sicurezza che possono servire come base per creare un livello criteri.

- Esempio di norme incluse nel Aggiornamento del 2023 relativo ai principi dell'IA di Google.

- La MLCommons Association, un consorzio di ingegneria basato su una filosofia di collaborazione aperta per migliorare i sistemi di IA, riferimenti 6 ai rischi per i quali valuta i modelli sulla sicurezza dell'IA nell'ambito della propria Benchmark di sicurezza dell'IA.

Non esiste un unico modello per gli artefatti di trasparenza in del settore, ma le schede modello esistenti possono servire come punto di partenza per crearne uno personalizzato:

- Scheda del modello di Gemma

- Modello di scheda del modello tratta dalla scheda modello originale

- Schede dei modelli delle API Google Cloud

Riferimenti aggiuntivi

- Schede dei modelli per i report dei modelli

- Schede dei modelli

- Schede dei dati: documentazione mirata e trasparente sui set di dati per l'IA responsabile

- Guida pratica alle schede di dati

- Bard con la scheda di sistema Gemini Pro appositamente ottimizzata

- Risorse del Frontier Model Forum sul red team