জেমিনি এপিআই সুরক্ষা সেটিংস প্রদান করে যা আপনি প্রোটোটাইপিং পর্যায়ে সামঞ্জস্য করতে পারেন যাতে আপনার অ্যাপ্লিকেশনটির জন্য কমবেশি সীমাবদ্ধ সুরক্ষা কনফিগারেশন প্রয়োজন কিনা তা নির্ধারণ করা যায়। নির্দিষ্ট ধরণের সামগ্রী সীমাবদ্ধ বা অনুমতি দেওয়ার জন্য আপনি চারটি ফিল্টার বিভাগে এই সেটিংস সামঞ্জস্য করতে পারেন।

এই নির্দেশিকাটিতে জেমিনি এপিআই কীভাবে সুরক্ষা সেটিংস এবং ফিল্টারিং পরিচালনা করে এবং আপনি কীভাবে আপনার অ্যাপ্লিকেশনের জন্য সুরক্ষা সেটিংস পরিবর্তন করতে পারেন তা আলোচনা করা হয়েছে।

নিরাপত্তা ফিল্টার

জেমিনি এপিআই-এর সামঞ্জস্যযোগ্য সুরক্ষা ফিল্টারগুলি নিম্নলিখিত বিভাগগুলিকে অন্তর্ভুক্ত করে:

| বিভাগ | বিবরণ |

|---|---|

| হয়রানি | পরিচয় এবং/অথবা সুরক্ষিত বৈশিষ্ট্যগুলিকে লক্ষ্য করে নেতিবাচক বা ক্ষতিকারক মন্তব্য। |

| ঘৃণামূলক বক্তব্য | অভদ্র, অসম্মানজনক, বা অপবিত্র কন্টেন্ট। |

| যৌন স্পষ্ট | যৌন কার্যকলাপ বা অন্যান্য অশ্লীল বিষয়বস্তুর উল্লেখ রয়েছে। |

| বিপজ্জনক | ক্ষতিকারক কাজগুলিকে প্রচার করে, সহায়তা করে, অথবা উৎসাহিত করে। |

এই বিভাগগুলি HarmCategory তে সংজ্ঞায়িত করা হয়েছে। আপনার ব্যবহারের ক্ষেত্রে যা উপযুক্ত তা সামঞ্জস্য করতে আপনি এই ফিল্টারগুলি ব্যবহার করতে পারেন। উদাহরণস্বরূপ, যদি আপনি ভিডিও গেম সংলাপ তৈরি করেন, তাহলে গেমের প্রকৃতির কারণে বিপজ্জনক হিসাবে রেট দেওয়া আরও সামগ্রীকে অনুমতি দেওয়া আপনার পক্ষে গ্রহণযোগ্য বলে মনে হতে পারে।

সামঞ্জস্যযোগ্য সুরক্ষা ফিল্টার ছাড়াও, জেমিনি এপিআই-তে মূল ক্ষতির বিরুদ্ধে অন্তর্নির্মিত সুরক্ষা রয়েছে, যেমন এমন সামগ্রী যা শিশুদের সুরক্ষাকে বিপন্ন করে। এই ধরণের ক্ষতি সর্বদা ব্লক করা হয় এবং সামঞ্জস্য করা যায় না।

কন্টেন্ট সুরক্ষা ফিল্টারিং লেভেল

জেমিনি এপিআই কন্টেন্টের অনিরাপদ হওয়ার সম্ভাব্যতার স্তরকে HIGH , MEDIUM , LOW , অথবা NEGLIGIBLE হিসেবে শ্রেণীবদ্ধ করে।

জেমিনি এপিআই কন্টেন্ট ব্লক করে কন্টেন্টের তীব্রতার উপর নয় বরং অনিরাপদ হওয়ার সম্ভাবনার উপর ভিত্তি করে। এটি বিবেচনা করা গুরুত্বপূর্ণ কারণ কিছু কন্টেন্টের অনিরাপদ হওয়ার সম্ভাবনা কম হতে পারে যদিও ক্ষতির তীব্রতা এখনও বেশি হতে পারে। উদাহরণস্বরূপ, বাক্যগুলির তুলনা করা:

- রোবটটা আমাকে ঘুষি মেরেছে।

- রোবটটা আমাকে থেঁতলে দিল।

প্রথম বাক্যটি অনিরাপদ হওয়ার সম্ভাবনা বেশি হতে পারে, কিন্তু আপনি দ্বিতীয় বাক্যটিকে সহিংসতার দিক থেকে আরও তীব্র বলে বিবেচনা করতে পারেন। এই বিবেচনায়, আপনার গুরুত্বপূর্ণ ব্যবহারের ক্ষেত্রে সমর্থন করার জন্য এবং শেষ ব্যবহারকারীদের ক্ষতি কমানোর জন্য উপযুক্ত স্তরের ব্লকিং কী প্রয়োজন তা সাবধানতার সাথে পরীক্ষা করা এবং বিবেচনা করা গুরুত্বপূর্ণ।

অনুরোধ প্রতি নিরাপত্তা ফিল্টারিং

API-তে করা প্রতিটি অনুরোধের জন্য আপনি নিরাপত্তা সেটিংস সামঞ্জস্য করতে পারেন। যখন আপনি একটি অনুরোধ করেন, তখন বিষয়বস্তু বিশ্লেষণ করা হয় এবং একটি নিরাপত্তা রেটিং নির্ধারণ করা হয়। নিরাপত্তা রেটিংটিতে বিভাগ এবং ক্ষতির শ্রেণীবিভাগের সম্ভাব্যতা অন্তর্ভুক্ত থাকে। উদাহরণস্বরূপ, যদি হয়রানি বিভাগের উচ্চ সম্ভাবনার কারণে সামগ্রীটি ব্লক করা হয়, তাহলে ফেরত দেওয়া নিরাপত্তা রেটিংটিতে HARASSMENT এর সমান বিভাগ থাকবে এবং ক্ষতির সম্ভাবনা HIGH এ সেট করা হবে।

মডেলের অন্তর্নিহিত নিরাপত্তার কারণে, অতিরিক্ত ফিল্টারগুলি ডিফল্টরূপে বন্ধ থাকে। আপনি যদি এগুলি সক্ষম করতে চান, তাহলে আপনি সিস্টেমটিকে তার অনিরাপদ হওয়ার সম্ভাবনার উপর ভিত্তি করে সামগ্রী ব্লক করার জন্য কনফিগার করতে পারেন। ডিফল্ট মডেল আচরণ বেশিরভাগ ব্যবহারের ক্ষেত্রে প্রযোজ্য, তাই আপনার অ্যাপ্লিকেশনের জন্য ধারাবাহিকভাবে প্রয়োজন হলেই কেবল এই সেটিংসগুলি সামঞ্জস্য করা উচিত।

নিম্নলিখিত সারণীতে প্রতিটি বিভাগের জন্য আপনি যে ব্লক সেটিংস সামঞ্জস্য করতে পারেন তার বর্ণনা দেওয়া হয়েছে। উদাহরণস্বরূপ, যদি আপনি ঘৃণাত্মক বক্তব্য বিভাগের জন্য ব্লক সেটিংটি ব্লক কয়েকটিতে সেট করেন, তাহলে ঘৃণাত্মক বক্তব্যের সামগ্রী হওয়ার সম্ভাবনা বেশি এমন সবকিছুই ব্লক করা হবে। তবে কম সম্ভাবনাযুক্ত যেকোনো কিছু অনুমোদিত।

| থ্রেশহোল্ড (গুগল এআই স্টুডিও) | থ্রেশহোল্ড (API) | বিবরণ |

|---|---|---|

| বন্ধ | OFF | নিরাপত্তা ফিল্টার বন্ধ করুন |

| কোনওটিই ব্লক করো না | BLOCK_NONE | অনিরাপদ কন্টেন্টের সম্ভাবনা যাই হোক না কেন, সর্বদা দেখান |

| কয়েকটি ব্লক করুন | BLOCK_ONLY_HIGH | অনিরাপদ কন্টেন্টের সম্ভাবনা বেশি থাকলে ব্লক করুন |

| কিছু ব্লক করুন | BLOCK_MEDIUM_AND_ABOVE | যখন অনিরাপদ কন্টেন্টের মাঝারি বা উচ্চ সম্ভাবনা থাকে তখন ব্লক করুন |

| বেশিরভাগ ব্লক করুন | BLOCK_LOW_AND_ABOVE | অনিরাপদ কন্টেন্টের সম্ভাবনা কম, মাঝারি বা বেশি হলে ব্লক করুন |

| নিষিদ্ধ | HARM_BLOCK_THRESHOLD_UNSPECIFIED | থ্রেশহোল্ড নির্দিষ্ট করা নেই, ডিফল্ট থ্রেশহোল্ড ব্যবহার করে ব্লক করুন |

যদি থ্রেশহোল্ড সেট না করা থাকে, তাহলে জেমিনি 2.5 এবং 3 মডেলের জন্য ডিফল্ট ব্লক থ্রেশহোল্ড বন্ধ থাকে।

জেনারেটিভ সার্ভিসে করা প্রতিটি অনুরোধের জন্য আপনি এই সেটিংস সেট করতে পারেন। বিস্তারিত জানার জন্য HarmBlockThreshold API রেফারেন্স দেখুন।

নিরাপত্তা প্রতিক্রিয়া

generateContent একটি GenerateContentResponse প্রদান করে যার মধ্যে নিরাপত্তা প্রতিক্রিয়া অন্তর্ভুক্ত থাকে।

promptFeedback এ প্রম্পট ফিডব্যাক অন্তর্ভুক্ত থাকে। যদি promptFeedback.blockReason সেট করা থাকে, তাহলে প্রম্পটের বিষয়বস্তু ব্লক করা হয়েছে।

প্রতিক্রিয়া প্রার্থীর প্রতিক্রিয়া Candidate.finishReason এবং Candidate.safetyRatings এ অন্তর্ভুক্ত। যদি প্রতিক্রিয়ার বিষয়বস্তু ব্লক করা থাকে এবং finishReason SAFETY হয়, তাহলে আপনি আরও বিস্তারিত জানার জন্য safetyRatings পরিদর্শন করতে পারেন। ব্লক করা বিষয়বস্তু ফেরত দেওয়া হয় না।

নিরাপত্তা সেটিংস সামঞ্জস্য করুন

এই বিভাগে গুগল এআই স্টুডিও এবং আপনার কোড উভয়ের নিরাপত্তা সেটিংস কীভাবে সামঞ্জস্য করবেন তা আলোচনা করা হয়েছে।

গুগল এআই স্টুডিও

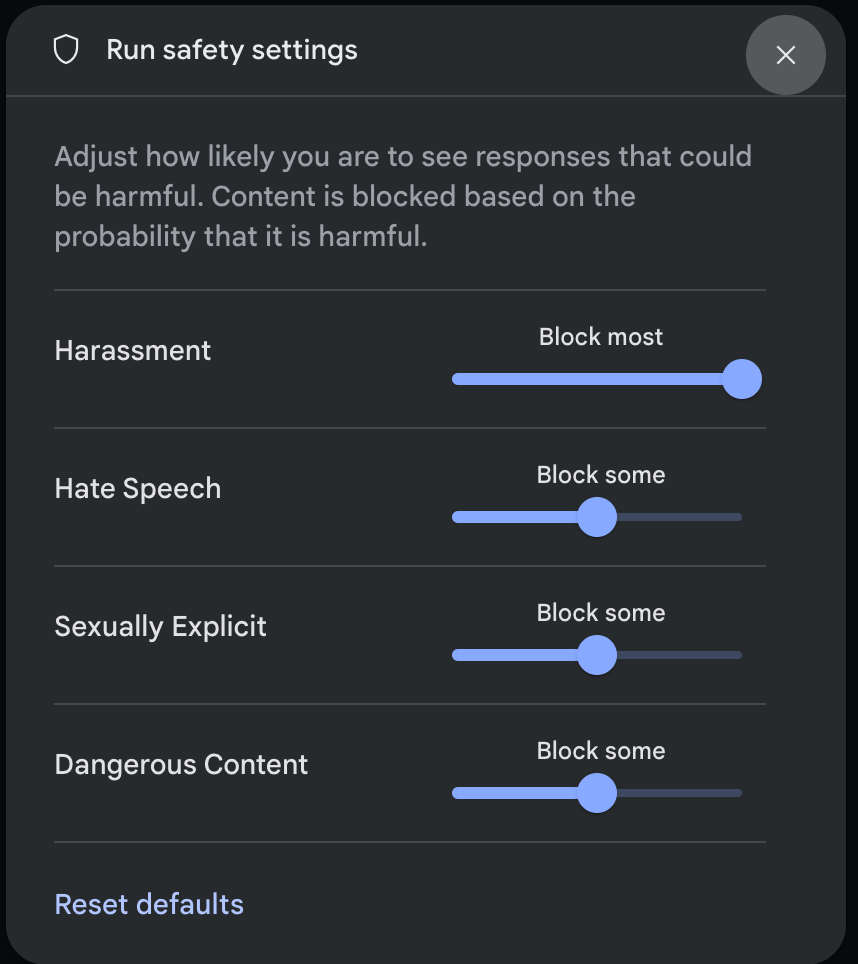

আপনি গুগল এআই স্টুডিওতে নিরাপত্তা সেটিংস সামঞ্জস্য করতে পারেন।

রান সেফটি সেটিংস মোডাল খুলতে রান সেটিংস প্যানেলে অ্যাডভান্সড সেটিংসের অধীনে সেফটি সেটিংসে ক্লিক করুন। মোডালে, আপনি প্রতিটি সেফটি বিভাগের জন্য কন্টেন্ট ফিল্টারিং স্তর সামঞ্জস্য করতে স্লাইডার ব্যবহার করতে পারেন:

যখন আপনি একটি অনুরোধ পাঠান (উদাহরণস্বরূপ, মডেলটিকে একটি প্রশ্ন জিজ্ঞাসা করে), অনুরোধের বিষয়বস্তু ব্লক করা থাকলে একটি সামগ্রী অবরুদ্ধ বার্তা প্রদর্শিত হয়। আরও বিশদ দেখতে, বিভাগ এবং ক্ষতির শ্রেণীবিভাগের সম্ভাবনা দেখতে সামগ্রী অবরুদ্ধ পাঠ্যের উপর পয়েন্টারটি ধরে রাখুন।

কোড উদাহরণ

নিচের কোড স্নিপেটটি আপনার GenerateContent কলে নিরাপত্তা সেটিংস কীভাবে সেট করবেন তা দেখায়। এটি ঘৃণাত্মক বক্তব্য ( HARM_CATEGORY_HATE_SPEECH ) বিভাগের জন্য থ্রেশহোল্ড সেট করে। এই বিভাগটিকে BLOCK_LOW_AND_ABOVE এ সেট করলে ঘৃণাত্মক বক্তব্য হওয়ার সম্ভাবনা কম বা বেশি এমন যেকোনো কন্টেন্ট ব্লক হয়ে যায়। থ্রেশহোল্ড সেটিংস বুঝতে, প্রতি অনুরোধে নিরাপত্তা ফিল্টারিং দেখুন।

পাইথন

from google import genai

from google.genai import types

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="Some potentially unsafe prompt",

config=types.GenerateContentConfig(

safety_settings=[

types.SafetySetting(

category=types.HarmCategory.HARM_CATEGORY_HATE_SPEECH,

threshold=types.HarmBlockThreshold.BLOCK_LOW_AND_ABOVE,

),

]

)

)

print(response.text)

যাও

package main

import (

"context"

"fmt"

"log"

"google.golang.org/genai"

)

func main() {

ctx := context.Background()

client, err := genai.NewClient(ctx, nil)

if err != nil {

log.Fatal(err)

}

config := &genai.GenerateContentConfig{

SafetySettings: []*genai.SafetySetting{

{

Category: "HARM_CATEGORY_HATE_SPEECH",

Threshold: "BLOCK_LOW_AND_ABOVE",

},

},

}

response, err := client.Models.GenerateContent(

ctx,

"gemini-3-flash-preview",

genai.Text("Some potentially unsafe prompt."),

config,

)

if err != nil {

log.Fatal(err)

}

fmt.Println(response.Text())

}

জাভাস্ক্রিপ্ট

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

const safetySettings = [

{

category: "HARM_CATEGORY_HATE_SPEECH",

threshold: "BLOCK_LOW_AND_ABOVE",

},

];

async function main() {

const response = await ai.models.generateContent({

model: "gemini-3-flash-preview",

contents: "Some potentially unsafe prompt.",

config: {

safetySettings: safetySettings,

},

});

console.log(response.text);

}

await main();

জাভা

SafetySetting hateSpeechSafety = new SafetySetting(HarmCategory.HATE_SPEECH,

BlockThreshold.LOW_AND_ABOVE);

GenerativeModel gm = new GenerativeModel(

"gemini-3-flash-preview",

BuildConfig.apiKey,

null, // generation config is optional

Arrays.asList(hateSpeechSafety)

);

GenerativeModelFutures model = GenerativeModelFutures.from(gm);

বিশ্রাম

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-flash-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H "Content-Type: application/json" \

-X POST \

-d '{

"safetySettings": [

{"category": "HARM_CATEGORY_HATE_SPEECH", "threshold": "BLOCK_LOW_AND_ABOVE"}

],

"contents": [{

"parts":[{

"text": "'\''Some potentially unsafe prompt.'\''"

}]

}]

}'

পরবর্তী পদক্ষেপ

- সম্পূর্ণ API সম্পর্কে আরও জানতে API রেফারেন্সটি দেখুন।

- LLM-এর সাথে উন্নয়নের সময় নিরাপত্তার বিবেচ্য বিষয়গুলির একটি সাধারণ ধারণার জন্য নিরাপত্তা নির্দেশিকা পর্যালোচনা করুন।

- জিগস টিম থেকে সম্ভাব্যতা বনাম তীব্রতা মূল্যায়ন সম্পর্কে আরও জানুন।

- Perspective API এর মতো নিরাপত্তা সমাধানে অবদান রাখে এমন পণ্য সম্পর্কে আরও জানুন। * আপনি একটি বিষাক্ততা শ্রেণীবদ্ধকারী তৈরি করতে এই নিরাপত্তা সেটিংস ব্যবহার করতে পারেন। শুরু করতে শ্রেণীবদ্ধকরণের উদাহরণটি দেখুন।