La API de Gemini proporciona una herramienta de ejecución de código que permite que el modelo genere y ejecute código de Python. Luego, el modelo puede aprender de forma iterativa a partir de los resultados de la ejecución del código hasta llegar a un resultado final. Puedes usar la ejecución de código para crear aplicaciones que se beneficien del razonamiento basado en código. Por ejemplo, puedes usar la ejecución de código para resolver ecuaciones o procesar texto. También puedes usar las bibliotecas incluidas en el entorno de ejecución de código para realizar tareas más especializadas.

Gemini solo puede ejecutar código en Python. Aun así, puedes pedirle a Gemini que genere código en otro lenguaje, pero el modelo no puede usar la herramienta de ejecución de código para ejecutarlo.

Habilitar la ejecución de código

Para habilitar la ejecución de código, configura la herramienta de ejecución de código en el modelo. Esto permite que el modelo genere y ejecute código.

Python

from google import genai

from google.genai import types

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="What is the sum of the first 50 prime numbers? "

"Generate and run code for the calculation, and make sure you get all 50.",

config=types.GenerateContentConfig(

tools=[types.Tool(code_execution=types.ToolCodeExecution)]

),

)

for part in response.candidates[0].content.parts:

if part.text is not None:

print(part.text)

if part.executable_code is not None:

print(part.executable_code.code)

if part.code_execution_result is not None:

print(part.code_execution_result.output)

JavaScript

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

let response = await ai.models.generateContent({

model: "gemini-3-flash-preview",

contents: [

"What is the sum of the first 50 prime numbers? " +

"Generate and run code for the calculation, and make sure you get all 50.",

],

config: {

tools: [{ codeExecution: {} }],

},

});

const parts = response?.candidates?.[0]?.content?.parts || [];

parts.forEach((part) => {

if (part.text) {

console.log(part.text);

}

if (part.executableCode && part.executableCode.code) {

console.log(part.executableCode.code);

}

if (part.codeExecutionResult && part.codeExecutionResult.output) {

console.log(part.codeExecutionResult.output);

}

});

Go

package main

import (

"context"

"fmt"

"os"

"google.golang.org/genai"

)

func main() {

ctx := context.Background()

client, err := genai.NewClient(ctx, nil)

if err != nil {

log.Fatal(err)

}

config := &genai.GenerateContentConfig{

Tools: []*genai.Tool{

{CodeExecution: &genai.ToolCodeExecution{}},

},

}

result, _ := client.Models.GenerateContent(

ctx,

"gemini-3-flash-preview",

genai.Text("What is the sum of the first 50 prime numbers? " +

"Generate and run code for the calculation, and make sure you get all 50."),

config,

)

fmt.Println(result.Text())

fmt.Println(result.ExecutableCode())

fmt.Println(result.CodeExecutionResult())

}

REST

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-flash-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-d ' {"tools": [{"code_execution": {}}],

"contents": {

"parts":

{

"text": "What is the sum of the first 50 prime numbers? Generate and run code for the calculation, and make sure you get all 50."

}

},

}'

El resultado podría ser similar al siguiente, que se formateó para facilitar la lectura:

Okay, I need to calculate the sum of the first 50 prime numbers. Here's how I'll

approach this:

1. **Generate Prime Numbers:** I'll use an iterative method to find prime

numbers. I'll start with 2 and check if each subsequent number is divisible

by any number between 2 and its square root. If not, it's a prime.

2. **Store Primes:** I'll store the prime numbers in a list until I have 50 of

them.

3. **Calculate the Sum:** Finally, I'll sum the prime numbers in the list.

Here's the Python code to do this:

def is_prime(n):

"""Efficiently checks if a number is prime."""

if n <= 1:

return False

if n <= 3:

return True

if n % 2 == 0 or n % 3 == 0:

return False

i = 5

while i * i <= n:

if n % i == 0 or n % (i + 2) == 0:

return False

i += 6

return True

primes = []

num = 2

while len(primes) < 50:

if is_prime(num):

primes.append(num)

num += 1

sum_of_primes = sum(primes)

print(f'{primes=}')

print(f'{sum_of_primes=}')

primes=[2, 3, 5, 7, 11, 13, 17, 19, 23, 29, 31, 37, 41, 43, 47, 53, 59, 61, 67,

71, 73, 79, 83, 89, 97, 101, 103, 107, 109, 113, 127, 131, 137, 139, 149, 151,

157, 163, 167, 173, 179, 181, 191, 193, 197, 199, 211, 223, 227, 229]

sum_of_primes=5117

The sum of the first 50 prime numbers is 5117.

Este resultado combina varias partes de contenido que el modelo devuelve cuando se usa la ejecución de código:

text: Texto intercalado generado por el modeloexecutableCode: Código generado por el modelo que se debe ejecutarcodeExecutionResult: Resultado del código ejecutable

Las convenciones de nomenclatura para estas partes varían según el lenguaje de programación.

Ejecución de código con imágenes (Gemini 3)

El modelo Gemini 3 Flash ahora puede escribir y ejecutar código de Python para manipular e inspeccionar imágenes de forma activa.

Casos de uso

- Acercar y examinar: El modelo detecta de forma implícita cuando los detalles son demasiado pequeños (p.ej., leer un medidor distante) y escribe código para recortar y volver a examinar el área con una resolución más alta.

- Cálculos visuales: El modelo puede ejecutar cálculos de varios pasos con código (p.ej., sumar los artículos de una factura).

- Anotación de imágenes: El modelo puede anotar imágenes para responder preguntas, como dibujar flechas para mostrar relaciones.

Habilita la ejecución de código con imágenes

La ejecución de código con imágenes se admite oficialmente en Gemini 3 Flash. Puedes activar este comportamiento habilitando tanto la Ejecución de código como herramienta como el Pensamiento.

Python

from google import genai

from google.genai import types

import requests

from PIL import Image

import io

image_path = "https://goo.gle/instrument-img"

image_bytes = requests.get(image_path).content

image = types.Part.from_bytes(

data=image_bytes, mime_type="image/jpeg"

)

# Ensure you have your API key set

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents=[image, "Zoom into the expression pedals and tell me how many pedals are there?"],

config=types.GenerateContentConfig(

tools=[types.Tool(code_execution=types.ToolCodeExecution)]

),

)

for part in response.candidates[0].content.parts:

if part.text is not None:

print(part.text)

if part.executable_code is not None:

print(part.executable_code.code)

if part.code_execution_result is not None:

print(part.code_execution_result.output)

if part.as_image() is not None:

# display() is a standard function in Jupyter/Colab notebooks

display(Image.open(io.BytesIO(part.as_image().image_bytes)))

JavaScript

async function main() {

const ai = new GoogleGenAI({ });

// 1. Prepare Image Data

const imageUrl = "https://goo.gle/instrument-img";

const response = await fetch(imageUrl);

const imageArrayBuffer = await response.arrayBuffer();

const base64ImageData = Buffer.from(imageArrayBuffer).toString('base64');

// 2. Call the API with Code Execution enabled

const result = await ai.models.generateContent({

model: "gemini-3-flash-preview",

contents: [

{

inlineData: {

mimeType: 'image/jpeg',

data: base64ImageData,

},

},

{ text: "Zoom into the expression pedals and tell me how many pedals are there?" }

],

config: {

tools: [{ codeExecution: {} }],

},

});

// 3. Process the response (Text, Code, and Execution Results)

const candidates = result.candidates;

if (candidates && candidates[0].content.parts) {

for (const part of candidates[0].content.parts) {

if (part.text) {

console.log("Text:", part.text);

}

if (part.executableCode) {

console.log(`\nGenerated Code (${part.executableCode.language}):\n`, part.executableCode.code);

}

if (part.codeExecutionResult) {

console.log(`\nExecution Output (${part.codeExecutionResult.outcome}):\n`, part.codeExecutionResult.output);

}

}

}

}

main();

Go

package main

import (

"context"

"fmt"

"io"

"log"

"net/http"

"os"

"google.golang.org/genai"

)

func main() {

ctx := context.Background()

// Initialize Client (Reads GEMINI_API_KEY from env)

client, err := genai.NewClient(ctx, nil)

if err != nil {

log.Fatal(err)

}

// 1. Download the image

imageResp, err := http.Get("https://goo.gle/instrument-img")

if err != nil {

log.Fatal(err)

}

defer imageResp.Body.Close()

imageBytes, err := io.ReadAll(imageResp.Body)

if err != nil {

log.Fatal(err)

}

// 2. Configure Code Execution Tool

config := &genai.GenerateContentConfig{

Tools: []*genai.Tool{

{CodeExecution: &genai.ToolCodeExecution{}},

},

}

// 3. Generate Content

result, err := client.Models.GenerateContent(

ctx,

"gemini-3-flash-preview",

[]*genai.Content{

{

Parts: []*genai.Part{

{InlineData: &genai.Blob{MIMEType: "image/jpeg", Data: imageBytes}},

{Text: "Zoom into the expression pedals and tell me how many pedals are there?"},

},

Role: "user",

},

},

config,

)

if err != nil {

log.Fatal(err)

}

// 4. Parse Response (Text, Code, Output)

for _, cand := range result.Candidates {

for _, part := range cand.Content.Parts {

if part.Text != "" {

fmt.Println("Text:", part.Text)

}

if part.ExecutableCode != nil {

fmt.Printf("\nGenerated Code (%s):\n%s\n",

part.ExecutableCode.Language,

part.ExecutableCode.Code)

}

if part.CodeExecutionResult != nil {

fmt.Printf("\nExecution Output (%s):\n%s\n",

part.CodeExecutionResult.Outcome,

part.CodeExecutionResult.Output)

}

}

}

}

REST

IMG_URL="https://goo.gle/instrument-img"

MODEL="gemini-3-flash-preview"

MIME_TYPE=$(curl -sIL "$IMG_URL" | grep -i '^content-type:' | awk -F ': ' '{print $2}' | sed 's/\r$//' | head -n 1)

if [[ -z "$MIME_TYPE" || ! "$MIME_TYPE" == image/* ]]; then

MIME_TYPE="image/jpeg"

fi

if [[ "$(uname)" == "Darwin" ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -b 0)

elif [[ "$(base64 --version 2>&1)" = *"FreeBSD"* ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64)

else

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -w0)

fi

curl "https://generativelanguage.googleapis.com/v1beta/models/$MODEL:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts":[

{

"inline_data": {

"mime_type":"'"$MIME_TYPE"'",

"data": "'"$IMAGE_B64"'"

}

},

{"text": "Zoom into the expression pedals and tell me how many pedals are there?"}

]

}],

"tools": [

{

"code_execution": {}

}

]

}'

Cómo usar la ejecución de código en el chat

También puedes usar la ejecución de código como parte de un chat.

Python

from google import genai

from google.genai import types

client = genai.Client()

chat = client.chats.create(

model="gemini-3-flash-preview",

config=types.GenerateContentConfig(

tools=[types.Tool(code_execution=types.ToolCodeExecution)]

),

)

response = chat.send_message("I have a math question for you.")

print(response.text)

response = chat.send_message(

"What is the sum of the first 50 prime numbers? "

"Generate and run code for the calculation, and make sure you get all 50."

)

for part in response.candidates[0].content.parts:

if part.text is not None:

print(part.text)

if part.executable_code is not None:

print(part.executable_code.code)

if part.code_execution_result is not None:

print(part.code_execution_result.output)

JavaScript

import {GoogleGenAI} from "@google/genai";

const ai = new GoogleGenAI({});

const chat = ai.chats.create({

model: "gemini-3-flash-preview",

history: [

{

role: "user",

parts: [{ text: "I have a math question for you:" }],

},

{

role: "model",

parts: [{ text: "Great! I'm ready for your math question. Please ask away." }],

},

],

config: {

tools: [{codeExecution:{}}],

}

});

const response = await chat.sendMessage({

message: "What is the sum of the first 50 prime numbers? " +

"Generate and run code for the calculation, and make sure you get all 50."

});

console.log("Chat response:", response.text);

Go

package main

import (

"context"

"fmt"

"os"

"google.golang.org/genai"

)

func main() {

ctx := context.Background()

client, err := genai.NewClient(ctx, nil)

if err != nil {

log.Fatal(err)

}

config := &genai.GenerateContentConfig{

Tools: []*genai.Tool{

{CodeExecution: &genai.ToolCodeExecution{}},

},

}

chat, _ := client.Chats.Create(

ctx,

"gemini-3-flash-preview",

config,

nil,

)

result, _ := chat.SendMessage(

ctx,

genai.Part{Text: "What is the sum of the first 50 prime numbers? " +

"Generate and run code for the calculation, and " +

"make sure you get all 50.",

},

)

fmt.Println(result.Text())

fmt.Println(result.ExecutableCode())

fmt.Println(result.CodeExecutionResult())

}

REST

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-flash-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-d '{"tools": [{"code_execution": {}}],

"contents": [

{

"role": "user",

"parts": [{

"text": "Can you print \"Hello world!\"?"

}]

},{

"role": "model",

"parts": [

{

"text": ""

},

{

"executable_code": {

"language": "PYTHON",

"code": "\nprint(\"hello world!\")\n"

}

},

{

"code_execution_result": {

"outcome": "OUTCOME_OK",

"output": "hello world!\n"

}

},

{

"text": "I have printed \"hello world!\" using the provided python code block. \n"

}

],

},{

"role": "user",

"parts": [{

"text": "What is the sum of the first 50 prime numbers? Generate and run code for the calculation, and make sure you get all 50."

}]

}

]

}'

Entrada y salida (E/S)

A partir de Gemini 2.0 Flash, la ejecución de código admite la entrada de archivos y la salida de gráficos. Con estas capacidades de entrada y salida, puedes subir archivos CSV y de texto, hacer preguntas sobre los archivos y generar gráficos de Matplotlib como parte de la respuesta. Los archivos de salida se muestran como imágenes intercaladas en la respuesta.

Precios de E/S

Cuando usas la E/S de ejecución de código, se te cobran los tokens de entrada y los tokens de salida:

Tokens de entrada:

- Instrucción del usuario

Tokens de salida:

- Código generado por el modelo

- Resultado de la ejecución del código en el entorno de código

- Tokens de pensamiento

- Resumen generado por el modelo

Detalles de E/S

Cuando trabajes con E/S de ejecución de código, ten en cuenta los siguientes detalles técnicos:

- El tiempo de ejecución máximo del entorno de código es de 30 segundos.

- Si el entorno de código genera un error, es posible que el modelo decida volver a generar el resultado del código. Esto puede suceder hasta 5 veces.

- El tamaño máximo de entrada de archivos está limitado por la ventana de tokens del modelo. En AI Studio, con Gemini Flash 2.0, el tamaño máximo del archivo de entrada es de 1 millón de tokens (aproximadamente 2 MB para archivos de texto de los tipos de entrada admitidos). Si subes un archivo demasiado grande, AI Studio no te permitirá enviarlo.

- La ejecución de código funciona mejor con archivos de texto y CSV.

- El archivo de entrada se puede pasar en

part.inlineDataopart.fileData(se sube a través de la API de Files), y el archivo de salida siempre se devuelve comopart.inlineData.

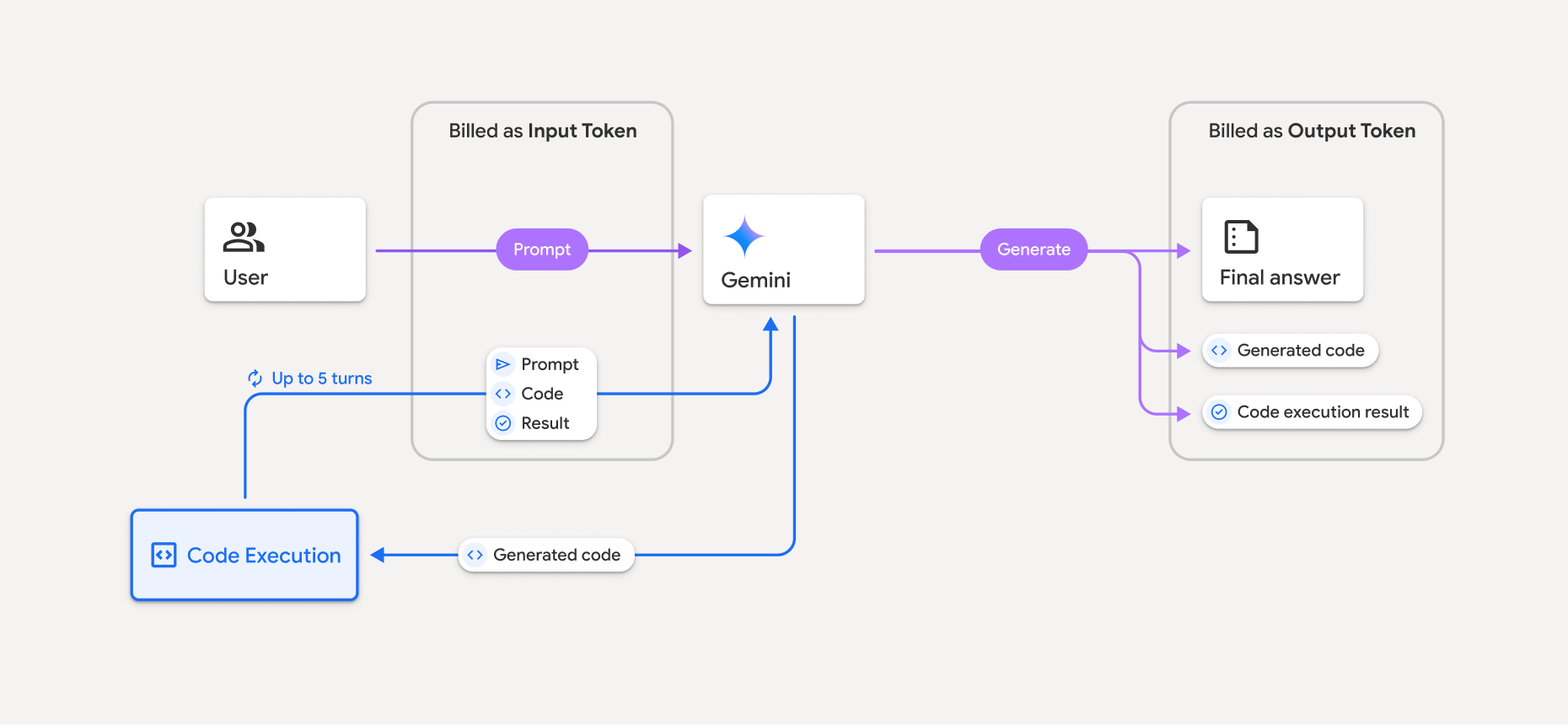

Facturación

No se aplican cargos adicionales por habilitar la ejecución de código desde la API de Gemini. Se te facturará según la tarifa actual de los tokens de entrada y salida en función del modelo de Gemini que uses.

Estas son algunas otras cosas que debes saber sobre la facturación de la ejecución de código:

- Solo se te factura una vez por los tokens de entrada que pasas al modelo y se te factura por los tokens de salida finales que te devuelve el modelo.

- Los tokens que representan el código generado se cuentan como tokens de salida. El código generado puede incluir texto y resultados multimodales, como imágenes.

- Los resultados de la ejecución del código también se contabilizan como tokens de salida.

El modelo de facturación se muestra en el siguiente diagrama:

- Se te facturará según la tarifa actual de los tokens de entrada y salida en función del modelo de Gemini que uses.

- Si Gemini usa la ejecución de código cuando genera tu respuesta, la instrucción original, el código generado y el resultado del código ejecutado se etiquetan como tokens intermedios y se facturan como tokens de entrada.

- Luego, Gemini genera un resumen y muestra el código generado, el resultado del código ejecutado y el resumen final. Estos se facturan como tokens de salida.

- La API de Gemini incluye un recuento de tokens intermedio en la respuesta de la API, por lo que sabrás por qué recibes tokens de entrada adicionales más allá de tu instrucción inicial.

Limitaciones

- El modelo solo puede generar y ejecutar código. No puede devolver otros artefactos, como archivos multimedia.

- En algunos casos, habilitar la ejecución de código puede generar regresiones en otras áreas del resultado del modelo (por ejemplo, escribir un cuento).

- La capacidad de los diferentes modelos para usar la ejecución de código con éxito varía.

Combinaciones de herramientas compatibles

La herramienta de ejecución de código se puede combinar con la Fundamentación con la Búsqueda de Google para potenciar casos de uso más complejos.

Bibliotecas compatibles

El entorno de ejecución de código incluye las siguientes bibliotecas:

- attrs

- ajedrez

- contourpy

- fpdf

- geopandas

- imageio

- jinja2

- joblib

- jsonschema

- jsonschema-specifications

- lxml

- matplotlib

- mpmath

- numpy

- opencv-python

- openpyxl

- empaquetado

- pandas

- almohada

- protobuf

- pylatex

- pyparsing

- PyPDF2

- python-dateutil

- python-docx

- python-pptx

- reportlab

- scikit-learn

- scipy

- seaborn

- six

- striprtf

- sympy

- tabulación

- tensorflow

- toolz

- xlrd

No puedes instalar tus propias bibliotecas.

¿Qué sigue?

- Prueba el Colab de ejecución de código.

- Obtén información sobre otras herramientas de la API de Gemini: