La API de Gemini habilita la generación mejorada por recuperación ("RAG") a través de la herramienta File Search. La Búsqueda de archivos importa, divide en fragmentos y, luego, indexa tus datos para permitir la recuperación rápida de información pertinente según una instrucción proporcionada. Luego, esta información se usa como contexto para el modelo, lo que le permite brindar respuestas más precisas y pertinentes.

Para que la Búsqueda de archivos sea simple y asequible para los desarrolladores, ofrecemos el almacenamiento de archivos y la generación de embeddings en el momento de la consulta sin cargo. Solo pagas por crear incorporaciones cuando indexas tus archivos por primera vez (al costo del modelo de incorporación aplicable) y el costo normal de los tokens de entrada y salida del modelo de Gemini. Este nuevo paradigma de facturación hace que la Herramienta de búsqueda de archivos sea más fácil y rentable de crear y escalar.

Subir directamente a la tienda de File Search

En este ejemplo, se muestra cómo subir directamente un archivo al almacén de búsqueda de archivos:

Python

from google import genai

from google.genai import types

import time

client = genai.Client()

# File name will be visible in citations

file_search_store = client.file_search_stores.create(config={'display_name': 'your-fileSearchStore-name'})

operation = client.file_search_stores.upload_to_file_search_store(

file='sample.txt',

file_search_store_name=file_search_store.name,

config={

'display_name' : 'display-file-name',

}

)

while not operation.done:

time.sleep(5)

operation = client.operations.get(operation)

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="""Can you tell me about [insert question]""",

config=types.GenerateContentConfig(

tools=[

types.Tool(

file_search=types.FileSearch(

file_search_store_names=[file_search_store.name]

)

)

]

)

)

print(response.text)

JavaScript

const { GoogleGenAI } = require('@google/genai');

const ai = new GoogleGenAI({});

async function run() {

// File name will be visible in citations

const fileSearchStore = await ai.fileSearchStores.create({

config: { displayName: 'your-fileSearchStore-name' }

});

let operation = await ai.fileSearchStores.uploadToFileSearchStore({

file: 'file.txt',

fileSearchStoreName: fileSearchStore.name,

config: {

displayName: 'file-name',

}

});

while (!operation.done) {

await new Promise(resolve => setTimeout(resolve, 5000));

operation = await ai.operations.get({ operation });

}

const response = await ai.models.generateContent({

model: "gemini-3-flash-preview",

contents: "Can you tell me about [insert question]",

config: {

tools: [

{

fileSearch: {

fileSearchStoreNames: [fileSearchStore.name]

}

}

]

}

});

console.log(response.text);

}

run();

Consulta la referencia de la API de uploadToFileSearchStore para obtener más información.

Importación de archivos

También puedes subir un archivo existente y importarlo a tu tienda de búsqueda de archivos:

Python

from google import genai

from google.genai import types

import time

client = genai.Client()

# File name will be visible in citations

sample_file = client.files.upload(file='sample.txt', config={'name': 'display_file_name'})

file_search_store = client.file_search_stores.create(config={'display_name': 'your-fileSearchStore-name'})

operation = client.file_search_stores.import_file(

file_search_store_name=file_search_store.name,

file_name=sample_file.name

)

while not operation.done:

time.sleep(5)

operation = client.operations.get(operation)

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="""Can you tell me about [insert question]""",

config=types.GenerateContentConfig(

tools=[

types.Tool(

file_search=types.FileSearch(

file_search_store_names=[file_search_store.name]

)

)

]

)

)

print(response.text)

JavaScript

const { GoogleGenAI } = require('@google/genai');

const ai = new GoogleGenAI({});

async function run() {

// File name will be visible in citations

const sampleFile = await ai.files.upload({

file: 'sample.txt',

config: { name: 'file-name' }

});

const fileSearchStore = await ai.fileSearchStores.create({

config: { displayName: 'your-fileSearchStore-name' }

});

let operation = await ai.fileSearchStores.importFile({

fileSearchStoreName: fileSearchStore.name,

fileName: sampleFile.name

});

while (!operation.done) {

await new Promise(resolve => setTimeout(resolve, 5000));

operation = await ai.operations.get({ operation: operation });

}

const response = await ai.models.generateContent({

model: "gemini-3-flash-preview",

contents: "Can you tell me about [insert question]",

config: {

tools: [

{

fileSearch: {

fileSearchStoreNames: [fileSearchStore.name]

}

}

]

}

});

console.log(response.text);

}

run();

Consulta la referencia de la API de importFile para obtener más información.

Configuración de fragmentación

Cuando importas un archivo a un almacén de File Search, se divide automáticamente en fragmentos, se incorpora, se indexa y se sube a tu almacén de File Search. Si necesitas más control sobre la estrategia de fragmentación, puedes especificar un parámetro de configuración chunking_config para establecer una cantidad máxima de tokens por fragmento y una cantidad máxima de tokens superpuestos.

Python

from google import genai

from google.genai import types

import time

client = genai.Client()

operation = client.file_search_stores.upload_to_file_search_store(

file_search_store_name=file_search_store.name,

file_name=sample_file.name,

config={

'chunking_config': {

'white_space_config': {

'max_tokens_per_chunk': 200,

'max_overlap_tokens': 20

}

}

}

)

while not operation.done:

time.sleep(5)

operation = client.operations.get(operation)

print("Custom chunking complete.")

JavaScript

const { GoogleGenAI } = require('@google/genai');

const ai = new GoogleGenAI({});

let operation = await ai.fileSearchStores.uploadToFileSearchStore({

file: 'file.txt',

fileSearchStoreName: fileSearchStore.name,

config: {

displayName: 'file-name',

chunkingConfig: {

whiteSpaceConfig: {

maxTokensPerChunk: 200,

maxOverlapTokens: 20

}

}

}

});

while (!operation.done) {

await new Promise(resolve => setTimeout(resolve, 5000));

operation = await ai.operations.get({ operation });

}

console.log("Custom chunking complete.");

Para usar tu tienda de File Search, pásala como una herramienta al método generateContent, como se muestra en los ejemplos de Upload y Import.

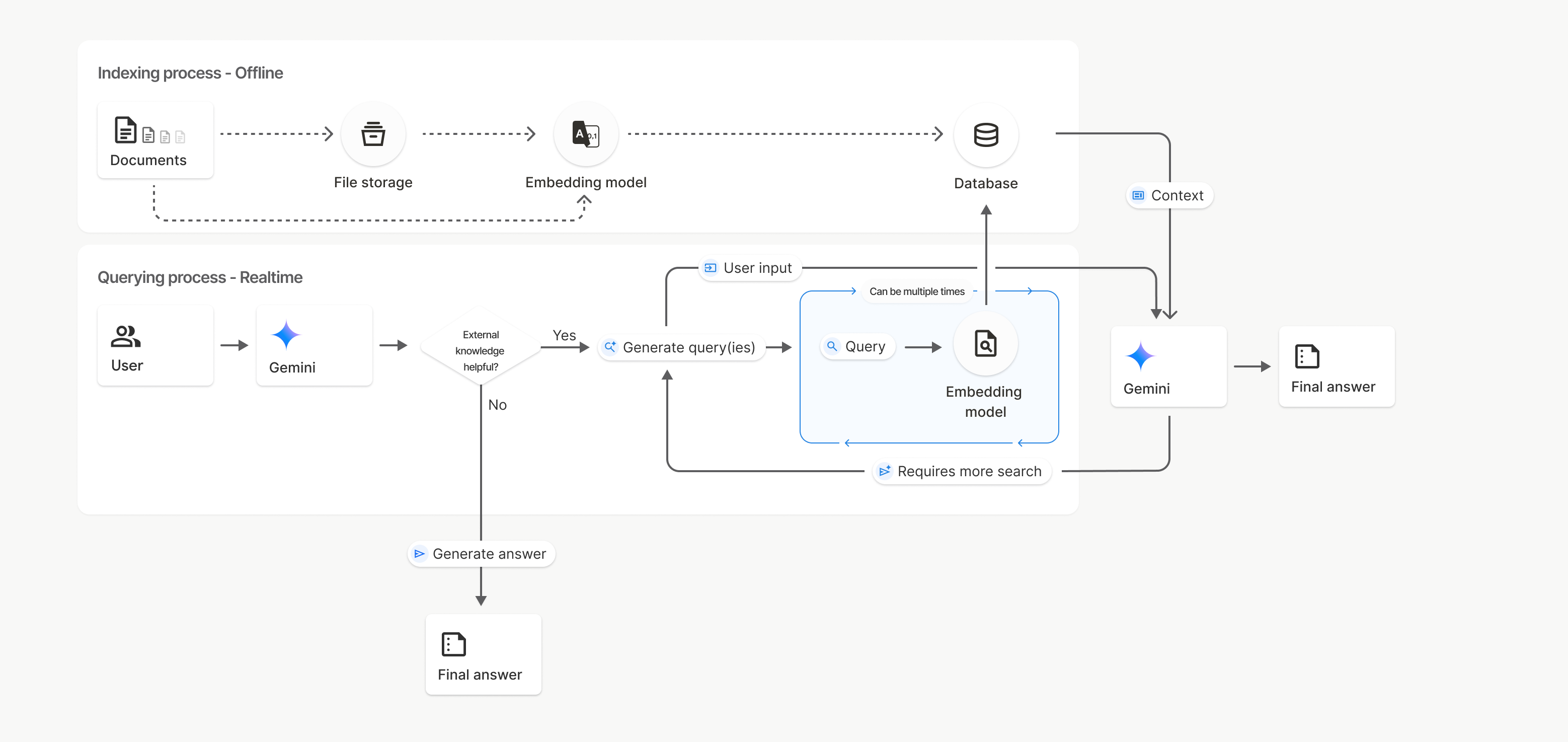

Cómo funciona

La Búsqueda de archivos usa una técnica llamada búsqueda semántica para encontrar información pertinente para la instrucción del usuario. A diferencia de la búsqueda estándar basada en palabras clave, la búsqueda semántica comprende el significado y el contexto de tu búsqueda.

Cuando importas un archivo, se convierte en representaciones numéricas llamadas embeddings, que capturan el significado semántico del texto. Estos embeddings se almacenan en una base de datos especializada de File Search. Cuando haces una búsqueda, esta también se convierte en un embedding. Luego, el sistema realiza una búsqueda de archivos para encontrar los fragmentos de documentos más similares y relevantes del almacén de búsqueda de archivos.

No hay un tiempo de actividad (TTL) para las incorporaciones y los archivos; estos persisten hasta que se borran de forma manual o cuando el modelo deja de estar disponible.

A continuación, se detalla el proceso para usar la API de File Search uploadToFileSearchStore:

Crea un almacén de búsqueda de archivos: Un almacén de búsqueda de archivos contiene los datos procesados de tus archivos. Es el contenedor persistente para los embeddings en los que operará la búsqueda semántica.

Sube un archivo y, luego, impórtalo a un almacén de File Search: Sube un archivo y, luego, importa los resultados a tu almacén de File Search de forma simultánea. Esto crea un objeto

Filetemporal, que es una referencia a tu documento sin procesar. Luego, esos datos se dividen en fragmentos, se convierten en incorporaciones de la Búsqueda de archivos y se indexan. El objetoFilese borra después de 48 horas, mientras que los datos importados en el almacén de la Búsqueda de archivos se almacenarán de forma indefinida hasta que decidas borrarlos.Consulta con la Búsqueda de archivos: Por último, usas la herramienta

FileSearchen una llamada agenerateContent. En la configuración de la herramienta, especificas unFileSearchRetrievalResource, que apunta alFileSearchStoreque deseas buscar. Esto le indica al modelo que realice una búsqueda semántica en ese almacén específico de File Search para encontrar información pertinente que fundamente su respuesta.

En este diagrama, la línea punteada que va de Documents a Embedding model (con gemini-embedding-001) representa la API de uploadToFileSearchStore (sin pasar por File storage).

De lo contrario, usar la API de Files para crear y, luego, importar archivos por separado traslada el proceso de indexación de Documents a File storage y, luego, a Embedding model.

Almacenes de búsqueda de archivos

Un almacén de File Search es un contenedor para los embeddings de tus documentos. Si bien los archivos sin procesar que se suben a través de la API de File se borran después de 48 horas, los datos que se importan a un almacén de File Search se almacenan de forma indefinida hasta que los borres de forma manual. Puedes crear varios almacenes de File Search para organizar tus documentos. La API de FileSearchStore te permite crear, enumerar, obtener y borrar para administrar tus tiendas de búsqueda de archivos. Los nombres de la tienda de Búsqueda de archivos tienen un alcance global.

Estos son algunos ejemplos de cómo administrar tus tiendas de Búsqueda de archivos:

Python

file_search_store = client.file_search_stores.create(config={'display_name': 'my-file_search-store-123'})

for file_search_store in client.file_search_stores.list():

print(file_search_store)

my_file_search_store = client.file_search_stores.get(name='fileSearchStores/my-file_search-store-123')

client.file_search_stores.delete(name='fileSearchStores/my-file_search-store-123', config={'force': True})

JavaScript

const fileSearchStore = await ai.fileSearchStores.create({

config: { displayName: 'my-file_search-store-123' }

});

const fileSearchStores = await ai.fileSearchStores.list();

for await (const store of fileSearchStores) {

console.log(store);

}

const myFileSearchStore = await ai.fileSearchStores.get({

name: 'fileSearchStores/my-file_search-store-123'

});

await ai.fileSearchStores.delete({

name: 'fileSearchStores/my-file_search-store-123',

config: { force: true }

});

REST

curl -X POST "https://generativelanguage.googleapis.com/v1beta/fileSearchStores?key=${GEMINI_API_KEY}" \

-H "Content-Type: application/json"

-d '{ "displayName": "My Store" }'

curl "https://generativelanguage.googleapis.com/v1beta/fileSearchStores?key=${GEMINI_API_KEY}" \

curl "https://generativelanguage.googleapis.com/v1beta/fileSearchStores/my-file_search-store-123?key=${GEMINI_API_KEY}"

curl -X DELETE "https://generativelanguage.googleapis.com/v1beta/fileSearchStores/my-file_search-store-123?key=${GEMINI_API_KEY}"

Documentos de búsqueda de archivos

Puedes administrar documentos individuales en tus almacenes de archivos con la API de File Search Documents para list cada documento en un almacén de búsqueda de archivos, get información sobre un documento y delete un documento por nombre.

Python

for document_in_store in client.file_search_stores.documents.list(parent='fileSearchStores/my-file_search-store-123'):

print(document_in_store)

file_search_document = client.file_search_stores.documents.get(name='fileSearchStores/my-file_search-store-123/documents/my_doc')

print(file_search_document)

client.file_search_stores.documents.delete(name='fileSearchStores/my-file_search-store-123/documents/my_doc')

JavaScript

const documents = await ai.fileSearchStores.documents.list({

parent: 'fileSearchStores/my-file_search-store-123'

});

for await (const doc of documents) {

console.log(doc);

}

const fileSearchDocument = await ai.fileSearchStores.documents.get({

name: 'fileSearchStores/my-file_search-store-123/documents/my_doc'

});

await ai.fileSearchStores.documents.delete({

name: 'fileSearchStores/my-file_search-store-123/documents/my_doc'

});

REST

curl "https://generativelanguage.googleapis.com/v1beta/fileSearchStores/my-file_search-store-123/documents?key=${GEMINI_API_KEY}"

curl "https://generativelanguage.googleapis.com/v1beta/fileSearchStores/my-file_search-store-123/documents/my_doc?key=${GEMINI_API_KEY}"

curl -X DELETE "https://generativelanguage.googleapis.com/v1beta/fileSearchStores/my-file_search-store-123/documents/my_doc?key=${GEMINI_API_KEY}"

Metadatos de archivos

Puedes agregar metadatos personalizados a tus archivos para filtrarlos o proporcionar contexto adicional. Los metadatos son un conjunto de pares clave-valor.

Python

op = client.file_search_stores.import_file(

file_search_store_name=file_search_store.name,

file_name=sample_file.name,

custom_metadata=[

{"key": "author", "string_value": "Robert Graves"},

{"key": "year", "numeric_value": 1934}

]

)

JavaScript

let operation = await ai.fileSearchStores.importFile({

fileSearchStoreName: fileSearchStore.name,

fileName: sampleFile.name,

config: {

customMetadata: [

{ key: "author", stringValue: "Robert Graves" },

{ key: "year", numericValue: 1934 }

]

}

});

Esto es útil cuando tienes varios documentos en un almacén de File Search y quieres buscar solo un subconjunto de ellos.

Python

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="Tell me about the book 'I, Claudius'",

config=types.GenerateContentConfig(

tools=[

types.Tool(

file_search=types.FileSearch(

file_search_store_names=[file_search_store.name],

metadata_filter="author=Robert Graves",

)

)

]

)

)

print(response.text)

JavaScript

const response = await ai.models.generateContent({

model: "gemini-3-flash-preview",

contents: "Tell me about the book 'I, Claudius'",

config: {

tools: [

{

fileSearch: {

fileSearchStoreNames: [fileSearchStore.name],

metadataFilter: 'author="Robert Graves"',

}

}

]

}

});

console.log(response.text);

REST

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-flash-preview:generateContent?key=${GEMINI_API_KEY}" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts":[{"text": "Tell me about the book I, Claudius"}]

}],

"tools": [{

"file_search": {

"file_search_store_names":["'$STORE_NAME'"],

"metadata_filter": "author = \"Robert Graves\""

}

}]

}' 2> /dev/null > response.json

cat response.json

Puedes encontrar orientación para implementar la sintaxis del filtro de lista para metadata_filter en google.aip.dev/160.

Citas

Cuando usas la Búsqueda de archivos, la respuesta del modelo puede incluir citas que especifican qué partes de los documentos que subiste se usaron para generar la respuesta. Esto ayuda con la verificación de datos.

Puedes acceder a la información de citas a través del atributo grounding_metadata de la respuesta.

Python

print(response.candidates[0].grounding_metadata)

JavaScript

console.log(JSON.stringify(response.candidates?.[0]?.groundingMetadata, null, 2));

Resultados estructurados

A partir de los modelos de Gemini 3, puedes combinar la herramienta de búsqueda de archivos con resultados estructurados.

Python

from pydantic import BaseModel, Field

class Money(BaseModel):

amount: str = Field(description="The numerical part of the amount.")

currency: str = Field(description="The currency of amount.")

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="What is the minimum hourly wage in Tokyo right now?",

config=types.GenerateContentConfig(

tools=[

types.Tool(

file_search=types.FileSearch(

file_search_store_names=[file_search_store.name]

)

)

],

response_mime_type="application/json",

response_schema=Money.model_json_schema()

)

)

result = Money.model_validate_json(response.text)

print(result)

JavaScript

import { z } from "zod";

const moneySchema = z.object({

amount: z.string().describe("The numerical part of the amount."),

currency: z.string().describe("The currency of amount."),

});

async function run() {

const response = await ai.models.generateContent({

model: "gemini-3-flash-preview",

contents: "What is the minimum hourly wage in Tokyo right now?",

config: {

tools: [

{

fileSearch: {

fileSearchStoreNames: [file_search_store.name],

},

},

],

responseMimeType: "application/json",

responseJsonSchema: z.toJSONSchema(moneySchema),

},

});

const result = moneySchema.parse(JSON.parse(response.text));

console.log(result);

}

run();

REST

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-flash-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "What is the minimum hourly wage in Tokyo right now?"}]

}],

"tools": [

{

"fileSearch": {

"fileSearchStoreNames": ["$FILE_SEARCH_STORE_NAME"]

}

}

],

"generationConfig": {

"responseMimeType": "application/json",

"responseJsonSchema": {

"type": "object",

"properties": {

"amount": {"type": "string", "description": "The numerical part of the amount."},

"currency": {"type": "string", "description": "The currency of amount."}

},

"required": ["amount", "currency"]

}

}

}'

Modelos compatibles

Los siguientes modelos admiten la Búsqueda de archivos:

| Modelo | Búsqueda de archivos |

|---|---|

| Versión preliminar de Gemini 3.1 Pro | ✔️ |

| Versión preliminar de Gemini 3 Pro | ✔️ |

| Versión preliminar de Gemini 3 Flash | ✔️ |

| Gemini 2.5 Pro | ✔️ |

| Gemini 2.5 Flash-Lite | ✔️ |

Tipos de archivos admitidos

La Búsqueda de archivos admite una amplia variedad de formatos de archivo, que se enumeran en las siguientes secciones.

Tipos de archivos de aplicación

application/dartapplication/ecmascriptapplication/jsonapplication/ms-javaapplication/mswordapplication/pdfapplication/sqlapplication/typescriptapplication/vnd.curlapplication/vnd.dartapplication/vnd.ibm.secure-containerapplication/vnd.jupyterapplication/vnd.ms-excelapplication/vnd.oasis.opendocument.textapplication/vnd.openxmlformats-officedocument.presentationml.presentationapplication/vnd.openxmlformats-officedocument.spreadsheetml.sheetapplication/vnd.openxmlformats-officedocument.wordprocessingml.documentapplication/vnd.openxmlformats-officedocument.wordprocessingml.templateapplication/x-cshapplication/x-hwpapplication/x-hwp-v5application/x-latexapplication/x-phpapplication/x-powershellapplication/x-shapplication/x-shellscriptapplication/x-texapplication/x-zshapplication/xmlapplication/zip

Tipos de archivos de texto

text/1d-interleaved-parityfectext/REDtext/SGMLtext/cache-manifesttext/calendartext/cqltext/cql-extensiontext/cql-identifiertext/csstext/csvtext/csv-schematext/dnstext/encaprtptext/enrichedtext/exampletext/fhirpathtext/flexfectext/fwdredtext/gff3text/grammar-ref-listtext/hl7v2text/htmltext/javascripttext/jcr-cndtext/jsxtext/markdowntext/mizartext/n3text/parameterstext/parityfectext/phptext/plaintext/provenance-notationtext/prs.fallenstein.rsttext/prs.lines.tagtext/prs.prop.logictext/raptorfectext/rfc822-headerstext/rtftext/rtp-enc-aescm128text/rtploopbacktext/rtxtext/sgmltext/shaclctext/shextext/spdxtext/stringstext/t140text/tab-separated-valuestext/texmacstext/trofftext/tsvtext/tsxtext/turtletext/ulpfectext/uri-listtext/vcardtext/vnd.DMClientScripttext/vnd.IPTC.NITFtext/vnd.IPTC.NewsMLtext/vnd.atext/vnd.abctext/vnd.ascii-arttext/vnd.curltext/vnd.debian.copyrighttext/vnd.dvb.subtitletext/vnd.esmertec.theme-descriptortext/vnd.exchangeabletext/vnd.familysearch.gedcomtext/vnd.ficlab.flttext/vnd.flytext/vnd.fmi.flexstortext/vnd.gmltext/vnd.graphviztext/vnd.hanstext/vnd.hgltext/vnd.in3d.3dmltext/vnd.in3d.spottext/vnd.latex-ztext/vnd.motorola.reflextext/vnd.ms-mediapackagetext/vnd.net2phone.commcenter.commandtext/vnd.radisys.msml-basic-layouttext/vnd.senx.warpscripttext/vnd.sositext/vnd.sun.j2me.app-descriptortext/vnd.trolltech.linguisttext/vnd.wap.sitext/vnd.wap.sltext/vnd.wap.wmltext/vnd.wap.wmlscripttext/vtttext/wgsltext/x-asmtext/x-bibtextext/x-bootext/x-ctext/x-c++hdrtext/x-c++srctext/x-cassandratext/x-chdrtext/x-coffeescripttext/x-componenttext/x-cshtext/x-csharptext/x-csrctext/x-cudatext/x-dtext/x-difftext/x-dsrctext/x-emacs-lisptext/x-erlangtext/x-gff3text/x-gotext/x-haskelltext/x-javatext/x-java-propertiestext/x-java-sourcetext/x-kotlintext/x-lilypondtext/x-lisptext/x-literate-haskelltext/x-luatext/x-moctext/x-objcsrctext/x-pascaltext/x-pcs-gcdtext/x-perltext/x-perl-scripttext/x-pythontext/x-python-scripttext/x-r-markdowntext/x-rsrctext/x-rsttext/x-ruby-scripttext/x-rusttext/x-sasstext/x-scalatext/x-schemetext/x-script.pythontext/x-scsstext/x-setexttext/x-sfvtext/x-shtext/x-siestatext/x-sostext/x-sqltext/x-swifttext/x-tcltext/x-textext/x-vbasictext/x-vcalendartext/xmltext/xml-dtdtext/xml-external-parsed-entitytext/yaml

Limitaciones

- API en vivo: La búsqueda de archivos no es compatible con la API en vivo.

- Incompatibilidad de la herramienta: Por el momento, la Búsqueda de archivos no se puede combinar con otras herramientas, como Fundamentación con la Búsqueda de Google, Contexto de URL, etcétera.

Límites de frecuencia

La API de File Search tiene los siguientes límites para garantizar la estabilidad del servicio:

- Límite de tamaño de archivo o por documento: 100 MB

- Tamaño total de los almacenamientos de la Búsqueda de archivos del proyecto (según el nivel del usuario):

- Gratis: 1 GB

- Nivel 1: 10 GB

- Nivel 2: 100 GB

- Nivel 3: 1 TB

- Recomendación: Limita el tamaño de cada almacén de File Search a menos de 20 GB para garantizar latencias de recuperación óptimas.

Precios

- A los desarrolladores se les cobra por las incorporaciones en el momento de la indexación según los precios de las incorporaciones existentes (USD 0.15 por 1 millón de tokens).

- El almacenamiento es gratuito.

- Los embeddings de tiempo de consulta no tienen costo.

- Los tokens de documentos recuperados se cobran como tokens de contexto normales.

¿Qué sigue?

- Visita la referencia de la API de File Search Stores y Documents de File Search.