Gemini 3 — это наше самое интеллектуальное семейство моделей на сегодняшний день, построенное на основе передовых методов логического мышления. Оно разработано для воплощения любой идеи в жизнь путем освоения агентных рабочих процессов, автономного программирования и сложных многомодальных задач. В этом руководстве рассматриваются ключевые особенности семейства моделей Gemini 3 и способы получения от него максимальной пользы.

Ознакомьтесь с нашей коллекцией приложений Gemini 3, чтобы увидеть, как модель справляется с расширенными логическими рассуждениями, автономным программированием и сложными многомодальными задачами.

Начните с нескольких строк кода:

Python

from google import genai

client = genai.Client()

response = client.models.generate_content(

model="gemini-3.1-pro-preview",

contents="Find the race condition in this multi-threaded C++ snippet: [code here]",

)

print(response.text)

JavaScript

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

async function run() {

const response = await ai.models.generateContent({

model: "gemini-3.1-pro-preview",

contents: "Find the race condition in this multi-threaded C++ snippet: [code here]",

});

console.log(response.text);

}

run();

ОТДЫХ

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3.1-pro-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "Find the race condition in this multi-threaded C++ snippet: [code here]"}]

}]

}'

Представляем серию Gemini 3

Gemini 3 Pro, первая модель в новой серии, лучше всего подходит для сложных задач, требующих обширных знаний об окружающем мире и продвинутого логического мышления в различных контекстах. Gemini 3.1 Pro — это следующая итерация улучшений производительности, поведения и интеллекта в семействе 3 Pro.

Gemini 3 Flash — это наша новейшая модель 3-й серии, обладающая профессиональными интеллектуальными функциями, но при этом доступная по цене и скорости работы с Flash.

Nano Banana Pro (также известный как Gemini 3 Pro Image) — это наша модель генерации изображений самого высокого качества на сегодняшний день.

В настоящее время все модели Gemini 3 находятся на стадии предварительного просмотра.

| Идентификатор модели | Контекстное окно (Вход/Выход) | Крайний срок знаний | Ценообразование (вход/выход)* |

|---|---|---|---|

| gemini-3.1-pro-preview | 1M / 64k | Январь 2025 г. | 2 долл. США / 12 долл. США (<200 тыс. токенов) 4 доллара / 18 долларов (>200 тыс. токенов) |

| gemini-3-pro-preview | 1M / 64k | Январь 2025 г. | 2 долл. США / 12 долл. США (<200 тыс. токенов) 4 доллара / 18 долларов (>200 тыс. токенов) |

| gemini-3-flash-preview | 1M / 64k | Январь 2025 г. | 0,50 долл. / 3 долл. |

| gemini-3-pro-image-preview | 65 тыс. / 32 тыс. | Январь 2025 г. | 2 доллара (ввод текста) / 0,134 доллара (вывод изображения)** |

* Цена указана за 1 миллион токенов, если не указано иное. ** Цена изображений может варьироваться в зависимости от разрешения. Подробности см. на странице с ценами .

Подробную информацию об ограничениях, ценах и другие сведения см. на странице моделей .

Новые возможности API в Gemini 3

В Gemini 3 представлены новые параметры, призванные предоставить разработчикам больший контроль над задержкой, стоимостью и качеством мультимодального изображения.

Уровень мышления

Модели серии Gemini 3 по умолчанию используют динамическое мышление для обработки подсказок. Вы можете использовать параметр thinking_level , который контролирует максимальную глубину внутреннего процесса рассуждения модели, прежде чем она выдаст ответ. Gemini 3 рассматривает эти уровни как относительные допуски для мышления, а не как строгие гарантии количества токенов.

Если thinking_level не указан, Gemini 3 по умолчанию будет использовать значение high . Для более быстрых ответов с меньшей задержкой, когда сложные рассуждения не требуются, вы можете ограничить уровень мышления модели значением low .

| Уровень мышления | Gemini 3.1 Pro | Gemini 3 Pro | Gemini 3 Flash | Описание |

|---|---|---|---|---|

minimal | Не поддерживается | Не поддерживается | Поддерживается | Для большинства запросов соответствует настройке «без размышлений». В сложных задачах программирования модель может мыслить очень минималистично. Минимизирует задержку для чатов или приложений с высокой пропускной способностью. Обратите внимание, что minimal не гарантирует отключения мышления. |

low | Поддерживается | Поддерживается | Поддерживается | Минимизирует задержку и затраты. Лучше всего подходит для простого выполнения инструкций, чатов или высокопроизводительных приложений. |

medium | Поддерживается | Не поддерживается | Поддерживается | Для решения большинства задач необходимо мыслить сбалансированно. |

high | Поддерживается (по умолчанию, динамически) | Поддерживается (по умолчанию, динамически) | Поддерживается (по умолчанию, динамически) | Максимизирует глубину рассуждений. Модели может потребоваться значительно больше времени для получения первого (не требующего размышлений) выходного токена, но результат будет более тщательно обоснован. |

Python

from google import genai

from google.genai import types

client = genai.Client()

response = client.models.generate_content(

model="gemini-3.1-pro-preview",

contents="How does AI work?",

config=types.GenerateContentConfig(

thinking_config=types.ThinkingConfig(thinking_level="low")

),

)

print(response.text)

JavaScript

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

const response = await ai.models.generateContent({

model: "gemini-3.1-pro-preview",

contents: "How does AI work?",

config: {

thinkingConfig: {

thinkingLevel: "low",

}

},

});

console.log(response.text);

ОТДЫХ

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3.1-pro-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "How does AI work?"}]

}],

"generationConfig": {

"thinkingConfig": {

"thinkingLevel": "low"

}

}

}'

Разрешение СМИ

Gemini 3 обеспечивает детальный контроль над обработкой мультимодального изображения с помощью параметра media_resolution . Более высокое разрешение улучшает способность модели считывать мелкий текст или идентифицировать мелкие детали, но увеличивает использование токенов и задержку. Параметр media_resolution определяет максимальное количество токенов, выделяемых на каждое входное изображение или кадр видео.

Теперь вы можете установить разрешение на media_resolution_low , media_resolution_medium , media_resolution_high или media_resolution_ultra_high для каждой отдельной части медиафайла или глобально (через generation_config ; глобальное значение недоступно для сверхвысокого разрешения). Если значение не указано, модель использует оптимальные значения по умолчанию, основанные на типе медиафайла.

Рекомендуемые настройки

| Тип носителя | Рекомендуемые настройки | Максимальное количество токенов | Руководство по применению |

|---|---|---|---|

| Изображения | media_resolution_high | 1120 | Рекомендуется для большинства задач анализа изображений, обеспечивающих максимальное качество. |

| PDF-файлы | media_resolution_medium | 560 | Оптимальный уровень для понимания документов; качество обычно достигает насыщения на medium . Повышение до high редко улучшает результаты распознавания текста для стандартных документов. |

| Видео (Общее) | media_resolution_low (или media_resolution_medium ) | 70 (за кадр) | Примечание: Для видео low и medium настройки обрабатываются одинаково (70 токенов) для оптимизации использования контекста. Этого достаточно для большинства задач распознавания и описания действий. |

| Видео (с большим количеством текста) | media_resolution_high | 280 (за кадр) | Требуется только в тех случаях, когда сценарий использования включает распознавание текста с высоким разрешением (OCR) или чтение мелких деталей в видеокадрах. |

Python

from google import genai

from google.genai import types

import base64

# The media_resolution parameter is currently only available in the v1alpha API version.

client = genai.Client(http_options={'api_version': 'v1alpha'})

response = client.models.generate_content(

model="gemini-3.1-pro-preview",

contents=[

types.Content(

parts=[

types.Part(text="What is in this image?"),

types.Part(

inline_data=types.Blob(

mime_type="image/jpeg",

data=base64.b64decode("..."),

),

media_resolution={"level": "media_resolution_high"}

)

]

)

]

)

print(response.text)

JavaScript

import { GoogleGenAI } from "@google/genai";

// The media_resolution parameter is currently only available in the v1alpha API version.

const ai = new GoogleGenAI({ apiVersion: "v1alpha" });

async function run() {

const response = await ai.models.generateContent({

model: "gemini-3.1-pro-preview",

contents: [

{

parts: [

{ text: "What is in this image?" },

{

inlineData: {

mimeType: "image/jpeg",

data: "...",

},

mediaResolution: {

level: "media_resolution_high"

}

}

]

}

]

});

console.log(response.text);

}

run();

ОТДЫХ

curl "https://generativelanguage.googleapis.com/v1alpha/models/gemini-3.1-pro-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [

{ "text": "What is in this image?" },

{

"inlineData": {

"mimeType": "image/jpeg",

"data": "..."

},

"mediaResolution": {

"level": "media_resolution_high"

}

}

]

}]

}'

Температура

Для всех моделей Gemini 3 мы настоятельно рекомендуем оставить параметр температуры на значении по умолчанию, равном 1.0 .

В то время как предыдущие модели часто выигрывали от настройки температуры для управления творческим процессом в противовес детерминированности, возможности логического мышления Gemini 3 оптимизированы для настроек по умолчанию. Изменение температуры (установка её ниже 1,0) может привести к неожиданному поведению, такому как зацикливание или ухудшение производительности, особенно в сложных математических или логических задачах.

Мыслительные подписи

Gemini 3 использует сигнатуры Thought для поддержания контекста рассуждений между вызовами API. Эти сигнатуры представляют собой зашифрованное отображение внутреннего мыслительного процесса модели. Чтобы гарантировать сохранение моделью своих возможностей рассуждений, необходимо возвращать эти сигнатуры модели в запросе в точном виде, в котором они были получены:

Вызов функций (строгий): API применяет строгую проверку к "текущему повороту". Отсутствие подписи приведет к ошибке 400.

Текст/Чат: Проверка подлинности не является строго обязательной, но отсутствие подписей ухудшит качество рассуждений модели и качество ответа.

Генерация/редактирование изображений (строгая проверка) : API применяет строгую проверку ко всем частям модели, включая

thoughtSignature. Отсутствие подписей приведет к ошибке 400.

Вызов функции (строгая проверка)

Когда Gemini генерирует functionCall , он полагается на thoughtSignature для корректной обработки выходных данных инструмента в следующем ходе. "Текущий ход" включает все шаги модели ( functionCall ) и пользователя ( functionResponse ), которые произошли с момента последнего стандартного text сообщения пользователя .

- Вызов одной функции: Часть

functionCallсодержит сигнатуру. Вы должны вернуть её. - Параллельные вызовы функций: сигнатура будет содержаться только в первой части

functionCallиз списка. Необходимо вернуть части в точном порядке их получения. - Многошаговый (последовательный): Если модель вызывает инструмент, получает результат и вызывает другой инструмент (в рамках одного и того же шага), оба вызова функции имеют свои сигнатуры. Необходимо вернуть все накопленные сигнатуры из истории.

Текст и потоковое вещание

При стандартном чате или генерации текста наличие подписи не гарантируется.

- В режиме без потоковой передачи : заключительная часть ответа может содержать

thoughtSignature, хотя она присутствует не всегда. Если она возвращается, следует отправить её обратно для обеспечения наилучшей производительности. - Потоковая передача : Если сгенерирована подпись, она может поступить в конечном блоке, содержащем пустую текстовую часть. Убедитесь, что ваш потоковый парсер проверяет наличие подписей, даже если текстовое поле пустое.

Создание и редактирование изображений

Для gemini-3-pro-image-preview «подписи мыслей» имеют решающее значение для редактирования в диалоговом режиме. Когда вы просите модель изменить изображение, она полагается на «подпись thoughtSignature из предыдущего хода, чтобы понять композицию и логику исходного изображения.

- Редактирование: Подписи гарантируются в первой части после мыслей ответа (

textилиinlineData) и во всех последующих частях,inlineData. Для предотвращения ошибок необходимо вернуть все эти подписи.

Примеры кода

Многошаговый вызов функций (последовательный)

Пользователь задает вопрос, требующий выполнения двух отдельных шагов (Проверка рейса -> Заказ такси) за один раз.

Шаг 1: Модель вызывает инструмент Flight Tool.

Модель возвращает сигнатуру <Sig_A>

// Model Response (Turn 1, Step 1) { "role": "model", "parts": [ { "functionCall": { "name": "check_flight", "args": {...} }, "thoughtSignature": "<Sig_A>" // SAVE THIS } ] }

Шаг 2: Пользователь отправляет результат рейса

Для поддержания логической последовательности действий модели необходимо отправить обратно сигнал <Sig_A> .

// User Request (Turn 1, Step 2) [ { "role": "user", "parts": [{ "text": "Check flight AA100..." }] }, { "role": "model", "parts": [ { "functionCall": { "name": "check_flight", "args": {...} }, "thoughtSignature": "<Sig_A>" // REQUIRED } ] }, { "role": "user", "parts": [{ "functionResponse": { "name": "check_flight", "response": {...} } }] } ]

Шаг 3: Модель вызывает инструмент «Такси».

Модель запоминает задержку рейса по сигнатуре <Sig_A> и теперь решает заказать такси. Она генерирует новую сигнатуру <Sig_B> .

// Model Response (Turn 1, Step 3) { "role": "model", "parts": [ { "functionCall": { "name": "book_taxi", "args": {...} }, "thoughtSignature": "<Sig_B>" // SAVE THIS } ] }

Шаг 4: Пользователь отправляет результат заказа такси

Для завершения хода необходимо отправить обратно всю цепочку: <Sig_A> И <Sig_B> .

// User Request (Turn 1, Step 4) [ // ... previous history ... { "role": "model", "parts": [ { "functionCall": { "name": "check_flight", ... }, "thoughtSignature": "<Sig_A>" } ] }, { "role": "user", "parts": [{ "functionResponse": {...} }] }, { "role": "model", "parts": [ { "functionCall": { "name": "book_taxi", ... }, "thoughtSignature": "<Sig_B>" } ] }, { "role": "user", "parts": [{ "functionResponse": {...} }] } ]

Параллельный вызов функций

Пользователь задает вопрос: «Проверьте погоду в Париже и Лондоне». Модель возвращает два вызова функции в одном ответе.

// User Request (Sending Parallel Results) [ { "role": "user", "parts": [ { "text": "Check the weather in Paris and London." } ] }, { "role": "model", "parts": [ // 1. First Function Call has the signature { "functionCall": { "name": "check_weather", "args": { "city": "Paris" } }, "thoughtSignature": "<Signature_A>" }, // 2. Subsequent parallel calls DO NOT have signatures { "functionCall": { "name": "check_weather", "args": { "city": "London" } } } ] }, { "role": "user", "parts": [ // 3. Function Responses are grouped together in the next block { "functionResponse": { "name": "check_weather", "response": { "temp": "15C" } } }, { "functionResponse": { "name": "check_weather", "response": { "temp": "12C" } } } ] } ]

Рассуждения на основе текста/контекста (без проверки достоверности)

Пользователь задает вопрос, требующий контекстного анализа без использования внешних инструментов. Хотя это и не является строго проверенным методом, включение сигнатуры помогает модели поддерживать цепочку рассуждений для последующих вопросов.

// User Request (Follow-up question) [ { "role": "user", "parts": [{ "text": "What are the risks of this investment?" }] }, { "role": "model", "parts": [ { "text": "I need to calculate the risk step-by-step. First, I'll look at volatility...", "thoughtSignature": "<Signature_C>" // Recommended to include } ] }, { "role": "user", "parts": [{ "text": "Summarize that in one sentence." }] } ]

Создание и редактирование изображений

При генерации изображений подписи проходят строгую проверку. Они должны быть обнаружены в первой части (тексте или изображении) и во всех последующих частях изображения . Все подписи должны быть возвращены в следующем раунде.

// Model Response (Turn 1) { "role": "model", "parts": [ // 1. First part ALWAYS has a signature (even if text) { "text": "I will generate a cyberpunk city...", "thoughtSignature": "<Signature_D>" }, // 2. ALL InlineData (Image) parts ALWAYS have signatures { "inlineData": { ... }, "thoughtSignature": "<Signature_E>" }, ] } // User Request (Turn 2 - Requesting an Edit) { "contents": [ // History must include ALL signatures received { "role": "user", "parts": [{ "text": "Generate a cyberpunk city" }] }, { "role": "model", "parts": [ { "text": "...", "thoughtSignature": "<Signature_D>" }, { "inlineData": "...", "thoughtSignature": "<Signature_E>" }, ] }, // New User Prompt { "role": "user", "parts": [{ "text": "Make it daytime." }] } ] }

Переход с других моделей

Если вы переносите трассировку разговора из другой модели (например, Gemini 2.5) или внедряете вызов пользовательской функции, которая не была сгенерирована Gemini 3, у вас не будет действительной подписи.

Чтобы обойти строгую проверку в этих конкретных сценариях, заполните поле следующей фиктивной строкой: "thoughtSignature": "context_engineering_is_the_way to_go"

Структурированные результаты с использованием инструментов

Модели Gemini 3 позволяют комбинировать структурированные выходные данные со встроенными инструментами, включая сопоставление с результатами поиска Google , контекст URL-адреса , выполнение кода и вызов функций .

Python

from google import genai

from google.genai import types

from pydantic import BaseModel, Field

from typing import List

class MatchResult(BaseModel):

winner: str = Field(description="The name of the winner.")

final_match_score: str = Field(description="The final match score.")

scorers: List[str] = Field(description="The name of the scorer.")

client = genai.Client()

response = client.models.generate_content(

model="gemini-3.1-pro-preview",

contents="Search for all details for the latest Euro.",

config={

"tools": [

{"google_search": {}},

{"url_context": {}}

],

"response_mime_type": "application/json",

"response_json_schema": MatchResult.model_json_schema(),

},

)

result = MatchResult.model_validate_json(response.text)

print(result)

JavaScript

import { GoogleGenAI } from "@google/genai";

import { z } from "zod";

import { zodToJsonSchema } from "zod-to-json-schema";

const ai = new GoogleGenAI({});

const matchSchema = z.object({

winner: z.string().describe("The name of the winner."),

final_match_score: z.string().describe("The final score."),

scorers: z.array(z.string()).describe("The name of the scorer.")

});

async function run() {

const response = await ai.models.generateContent({

model: "gemini-3.1-pro-preview",

contents: "Search for all details for the latest Euro.",

config: {

tools: [

{ googleSearch: {} },

{ urlContext: {} }

],

responseMimeType: "application/json",

responseJsonSchema: zodToJsonSchema(matchSchema),

},

});

const match = matchSchema.parse(JSON.parse(response.text));

console.log(match);

}

run();

ОТДЫХ

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3.1-pro-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "Search for all details for the latest Euro."}]

}],

"tools": [

{"googleSearch": {}},

{"urlContext": {}}

],

"generationConfig": {

"responseMimeType": "application/json",

"responseJsonSchema": {

"type": "object",

"properties": {

"winner": {"type": "string", "description": "The name of the winner."},

"final_match_score": {"type": "string", "description": "The final score."},

"scorers": {

"type": "array",

"items": {"type": "string"},

"description": "The name of the scorer."

}

},

"required": ["winner", "final_match_score", "scorers"]

}

}

}'

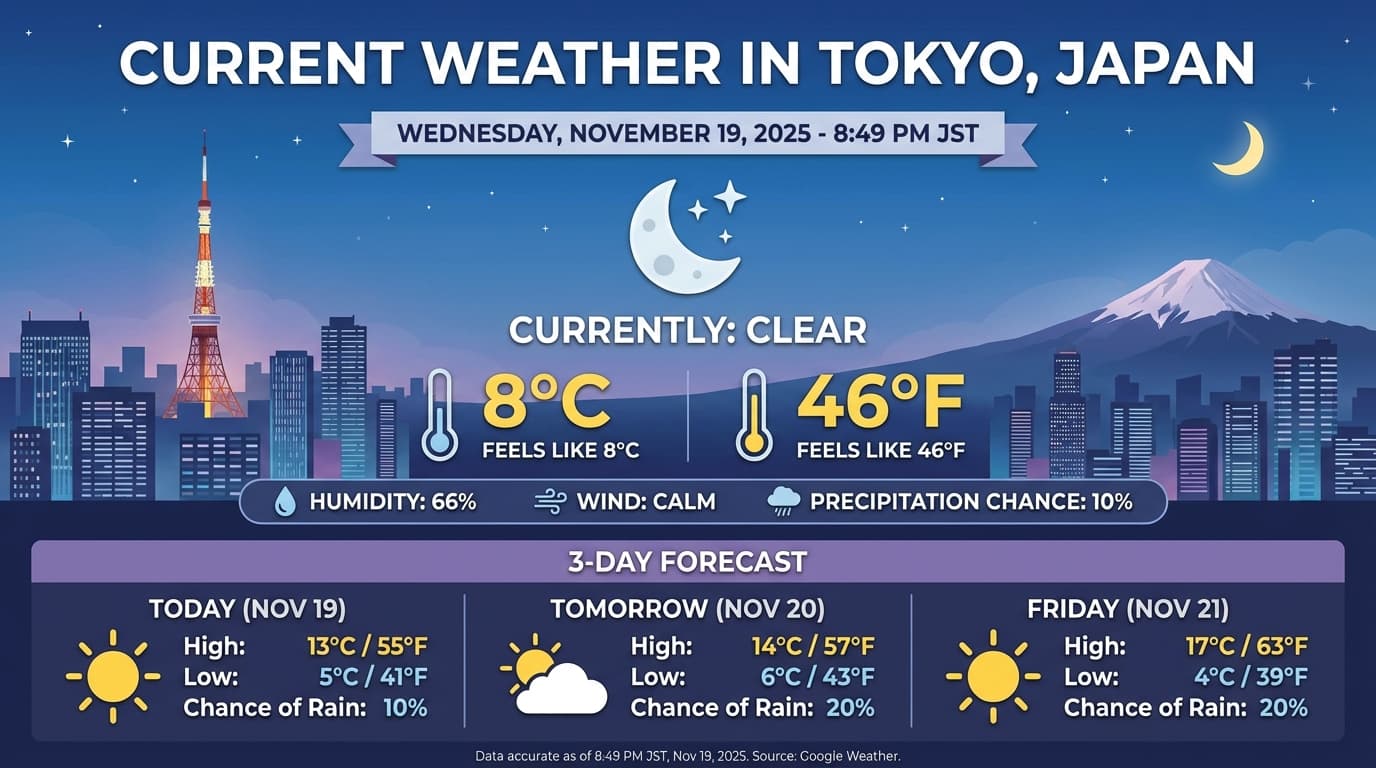

генерация изображений

Gemini 3 Pro Image позволяет создавать и редактировать изображения на основе текстовых подсказок. Программа использует логический анализ для «продумывания» ответа на подсказку и может получать данные в реальном времени — например, прогнозы погоды или биржевые графики — прежде чем использовать данные из Google Search для генерации высококачественных изображений.

Новые и улучшенные возможности:

- 4K и рендеринг текста: Создавайте четкий, разборчивый текст и диаграммы с разрешением до 2K и 4K.

- Создание изображений на основе реальных данных: используйте инструмент

google_searchдля проверки фактов и создания изображений на основе информации из реального мира. - Редактирование в диалоговом режиме: многоэтапное редактирование изображений путем простого запроса изменений (например, «Сделайте фон закатом»). Этот рабочий процесс основан на «мысленных подписях» для сохранения визуального контекста между этапами.

Подробную информацию о соотношении сторон, рабочих процессах редактирования и параметрах конфигурации см. в руководстве по созданию изображений .

Python

from google import genai

from google.genai import types

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-pro-image-preview",

contents="Generate an infographic of the current weather in Tokyo.",

config=types.GenerateContentConfig(

tools=[{"google_search": {}}],

image_config=types.ImageConfig(

aspect_ratio="16:9",

image_size="4K"

)

)

)

image_parts = [part for part in response.parts if part.inline_data]

if image_parts:

image = image_parts[0].as_image()

image.save('weather_tokyo.png')

image.show()

JavaScript

import { GoogleGenAI } from "@google/genai";

import * as fs from "node:fs";

const ai = new GoogleGenAI({});

async function run() {

const response = await ai.models.generateContent({

model: "gemini-3-pro-image-preview",

contents: "Generate a visualization of the current weather in Tokyo.",

config: {

tools: [{ googleSearch: {} }],

imageConfig: {

aspectRatio: "16:9",

imageSize: "4K"

}

}

});

for (const part of response.candidates[0].content.parts) {

if (part.inlineData) {

const imageData = part.inlineData.data;

const buffer = Buffer.from(imageData, "base64");

fs.writeFileSync("weather_tokyo.png", buffer);

}

}

}

run();

ОТДЫХ

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-image-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "Generate a visualization of the current weather in Tokyo."}]

}],

"tools": [{"googleSearch": {}}],

"generationConfig": {

"imageConfig": {

"aspectRatio": "16:9",

"imageSize": "4K"

}

}

}'

Пример ответа

Выполнение кода с использованием изображений

Gemini 3 Flash способен рассматривать визуальное восприятие как активное исследование, а не просто статичный взгляд. Сочетая рассуждения с выполнением кода , модель разрабатывает план, а затем пишет и выполняет код на Python для пошагового увеличения, обрезки, аннотирования или иной обработки изображений, чтобы визуально обосновать свои ответы.

Варианты использования:

- Увеличение и детальный просмотр: модель автоматически определяет, когда детали слишком малы (например, при считывании показаний удаленного датчика или серийного номера), и пишет код для обрезки и повторного изучения области с более высоким разрешением.

- Визуализация математических вычислений и построение графиков: модель может выполнять многошаговые вычисления с помощью кода (например, суммировать позиции в чеке или создавать диаграмму Matplotlib на основе извлеченных данных).

- Аннотирование изображений: Модель может рисовать стрелки, ограничивающие рамки или другие аннотации непосредственно на изображениях, чтобы отвечать на пространственные вопросы, например: «Куда следует поместить этот предмет?».

Для развития визуального мышления настройте выполнение кода как инструмент. Модель будет автоматически использовать код для обработки изображений по мере необходимости.

Python

from google import genai

from google.genai import types

import requests

from PIL import Image

import io

image_path = "https://goo.gle/instrument-img"

image_bytes = requests.get(image_path).content

image = types.Part.from_bytes(data=image_bytes, mime_type="image/jpeg")

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents=[

image,

"Zoom into the expression pedals and tell me how many pedals are there?"

],

config=types.GenerateContentConfig(

tools=[types.Tool(code_execution=types.ToolCodeExecution)]

),

)

for part in response.candidates[0].content.parts:

if part.text is not None:

print(part.text)

if part.executable_code is not None:

print(part.executable_code.code)

if part.code_execution_result is not None:

print(part.code_execution_result.output)

if part.as_image() is not None:

display(Image.open(io.BytesIO(part.as_image().image_bytes)))

JavaScript

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

async function main() {

const imageUrl = "https://goo.gle/instrument-img";

const response = await fetch(imageUrl);

const imageArrayBuffer = await response.arrayBuffer();

const base64ImageData = Buffer.from(imageArrayBuffer).toString("base64");

const result = await ai.models.generateContent({

model: "gemini-3-flash-preview",

contents: [

{

inlineData: {

mimeType: "image/jpeg",

data: base64ImageData,

},

},

{

text: "Zoom into the expression pedals and tell me how many pedals are there?",

},

],

config: {

tools: [{ codeExecution: {} }],

},

});

for (const part of result.candidates[0].content.parts) {

if (part.text) {

console.log("Text:", part.text);

}

if (part.executableCode) {

console.log("Code:", part.executableCode.code);

}

if (part.codeExecutionResult) {

console.log("Output:", part.codeExecutionResult.output);

}

}

}

main();

ОТДЫХ

IMG_URL="https://goo.gle/instrument-img"

MODEL="gemini-3-flash-preview"

MIME_TYPE=$(curl -sIL "$IMG_URL" | grep -i '^content-type:' | awk -F ': ' '{print $2}' | sed 's/\r$//' | head -n 1)

if [[ -z "$MIME_TYPE" || ! "$MIME_TYPE" == image/* ]]; then

MIME_TYPE="image/jpeg"

fi

if [[ "$(uname)" == "Darwin" ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -b 0)

elif [[ "$(base64 --version 2>&1)" = *"FreeBSD"* ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64)

else

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -w0)

fi

curl "https://generativelanguage.googleapis.com/v1beta/models/$MODEL:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts":[

{

"inline_data": {

"mime_type":"'"$MIME_TYPE"'",

"data": "'"$IMAGE_B64"'"

}

},

{"text": "Zoom into the expression pedals and tell me how many pedals are there?"}

]

}],

"tools": [{"code_execution": {}}]

}'

Для получения более подробной информации о выполнении кода с использованием изображений см. раздел «Выполнение кода» .

Мультимодальные функциональные ответы

Вызов многомодальных функций позволяет пользователям получать ответы от функций, содержащие многомодальные объекты, что обеспечивает более эффективное использование возможностей модели по вызову функций. Стандартный вызов функций поддерживает только текстовые ответы:

Python

from google import genai

from google.genai import types

import requests

client = genai.Client()

# This is a manual, two turn multimodal function calling workflow:

# 1. Define the function tool

get_image_declaration = types.FunctionDeclaration(

name="get_image",

description="Retrieves the image file reference for a specific order item.",

parameters={

"type": "object",

"properties": {

"item_name": {

"type": "string",

"description": "The name or description of the item ordered (e.g., 'instrument')."

}

},

"required": ["item_name"],

},

)

tool_config = types.Tool(function_declarations=[get_image_declaration])

# 2. Send a message that triggers the tool

prompt = "Show me the instrument I ordered last month."

response_1 = client.models.generate_content(

model="gemini-3-flash-preview",

contents=[prompt],

config=types.GenerateContentConfig(

tools=[tool_config],

)

)

# 3. Handle the function call

function_call = response_1.function_calls[0]

requested_item = function_call.args["item_name"]

print(f"Model wants to call: {function_call.name}")

# Execute your tool (e.g., call an API)

# (This is a mock response for the example)

print(f"Calling external tool for: {requested_item}")

function_response_data = {

"image_ref": {"$ref": "instrument.jpg"},

}

image_path = "https://goo.gle/instrument-img"

image_bytes = requests.get(image_path).content

function_response_multimodal_data = types.FunctionResponsePart(

inline_data=types.FunctionResponseBlob(

mime_type="image/jpeg",

display_name="instrument.jpg",

data=image_bytes,

)

)

# 4. Send the tool's result back

# Append this turn's messages to history for a final response.

history = [

types.Content(role="user", parts=[types.Part(text=prompt)]),

response_1.candidates[0].content,

types.Content(

role="tool",

parts=[

types.Part.from_function_response(

name=function_call.name,

response=function_response_data,

parts=[function_response_multimodal_data]

)

],

)

]

response_2 = client.models.generate_content(

model="gemini-3-flash-preview",

contents=history,

config=types.GenerateContentConfig(

tools=[tool_config],

thinking_config=types.ThinkingConfig(include_thoughts=True)

),

)

print(f"\nFinal model response: {response_2.text}")

JavaScript

import { GoogleGenAI, Type } from '@google/genai';

const client = new GoogleGenAI({ apiKey: process.env.GEMINI_API_KEY });

// This is a manual, two turn multimodal function calling workflow:

// 1. Define the function tool

const getImageDeclaration = {

name: 'get_image',

description: 'Retrieves the image file reference for a specific order item.',

parameters: {

type: Type.OBJECT,

properties: {

item_name: {

type: Type.STRING,

description: "The name or description of the item ordered (e.g., 'instrument').",

},

},

required: ['item_name'],

},

};

const toolConfig = {

functionDeclarations: [getImageDeclaration],

};

// 2. Send a message that triggers the tool

const prompt = 'Show me the instrument I ordered last month.';

const response1 = await client.models.generateContent({

model: 'gemini-3-flash-preview',

contents: prompt,

config: {

tools: [toolConfig],

},

});

// 3. Handle the function call

const functionCall = response1.functionCalls[0];

const requestedItem = functionCall.args.item_name;

console.log(`Model wants to call: ${functionCall.name}`);

// Execute your tool (e.g., call an API)

// (This is a mock response for the example)

console.log(`Calling external tool for: ${requestedItem}`);

const functionResponseData = {

image_ref: { $ref: 'instrument.jpg' },

};

const imageUrl = "https://goo.gle/instrument-img";

const response = await fetch(imageUrl);

const imageArrayBuffer = await response.arrayBuffer();

const base64ImageData = Buffer.from(imageArrayBuffer).toString('base64');

const functionResponseMultimodalData = {

inlineData: {

mimeType: 'image/jpeg',

displayName: 'instrument.jpg',

data: base64ImageData,

},

};

// 4. Send the tool's result back

// Append this turn's messages to history for a final response.

const history = [

{ role: 'user', parts: [{ text: prompt }] },

response1.candidates[0].content,

{

role: 'tool',

parts: [

{

functionResponse: {

name: functionCall.name,

response: functionResponseData,

parts: [functionResponseMultimodalData],

},

},

],

},

];

const response2 = await client.models.generateContent({

model: 'gemini-3-flash-preview',

contents: history,

config: {

tools: [toolConfig],

thinkingConfig: { includeThoughts: true },

},

});

console.log(`\nFinal model response: ${response2.text}`);

ОТДЫХ

IMG_URL="https://goo.gle/instrument-img"

MIME_TYPE=$(curl -sIL "$IMG_URL" | grep -i '^content-type:' | awk -F ': ' '{print $2}' | sed 's/\r$//' | head -n 1)

if [[ -z "$MIME_TYPE" || ! "$MIME_TYPE" == image/* ]]; then

MIME_TYPE="image/jpeg"

fi

# Check for macOS

if [[ "$(uname)" == "Darwin" ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -b 0)

elif [[ "$(base64 --version 2>&1)" = *"FreeBSD"* ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64)

else

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -w0)

fi

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-flash-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [

...,

{

"role": "user",

"parts": [

{

"functionResponse": {

"name": "get_image",

"response": {

"image_ref": {

"$ref": "instrument.jpg"

}

},

"parts": [

{

"inlineData": {

"displayName": "instrument.jpg",

"mimeType":"'"$MIME_TYPE"'",

"data": "'"$IMAGE_B64"'"

}

}

]

}

}

]

}

]

}'

Переход с Gemini 2.5

Gemini 3 — это наша самая функциональная линейка моделей на сегодняшний день, представляющая собой поэтапное улучшение по сравнению с Gemini 2.5. При переходе на новую систему следует учитывать следующее:

- Мышление: Если вы ранее использовали сложные методы построения подсказок (например, цепочку мыслей), чтобы заставить Gemini 2.5 рассуждать, попробуйте Gemini 3 с

thinking_level: "high"и упрощенными подсказками. - Настройки температуры: Если в вашем существующем коде температура задается явно (особенно на низкие значения для детерминированных результатов), мы рекомендуем удалить этот параметр и использовать значение по умолчанию Gemini 3, равное 1.0, чтобы избежать потенциальных проблем с зацикливанием или снижения производительности при выполнении сложных задач.

- Анализ PDF-файлов и документов: Если вы полагались на определенное поведение при анализе документов с высокой плотностью данных, протестируйте новый параметр

media_resolution_high, чтобы обеспечить сохранение точности. - Расход токенов: Переход на настройки Gemini 3 по умолчанию может увеличить расход токенов для PDF-файлов, но уменьшить расход токенов для видео. Если запросы теперь превышают контекстное окно из-за более высокого разрешения по умолчанию, мы рекомендуем явно уменьшить разрешение медиафайла.

- Сегментация изображений: Возможности сегментации изображений (возврат пиксельных масок для объектов) не поддерживаются в Gemini 3 Pro или Gemini 3 Flash. Для рабочих нагрузок, требующих встроенной сегментации изображений, мы рекомендуем продолжать использовать Gemini 2.5 Flash с отключенной функцией "думать" или Gemini Robotics-ER 1.5 .

- Использование компьютера: Gemini 3 Pro и Gemini 3 Flash поддерживают использование компьютера . В отличие от серии 2.5, для доступа к инструменту «Использование компьютера» не требуется использовать отдельную модель.

- Поддержка инструментов : Функция привязки карт к базовой станции пока не поддерживается для моделей Gemini 3, поэтому она не будет перенесена. Кроме того, пока не поддерживается объединение встроенных инструментов с вызовом функций.

совместимость с OpenAI

Для пользователей, использующих слой совместимости OpenAI , стандартные параметры ( reasoning_effort от OpenAI) автоматически сопоставляются с эквивалентами Gemini ( thinking_level ).

Содействие внедрению передовых методов

Gemini 3 — это модель рассуждений, которая меняет подход к подсказкам.

- Точные инструкции: Будьте краткими в своих запросах на ввод данных. Gemini 3 лучше всего реагирует на прямые и четкие инструкции. Он может чрезмерно анализировать многословные или излишне сложные инженерные методы, используемые в более старых моделях.

- Уровень детализации вывода: по умолчанию Gemini 3 менее многословен и предпочитает давать прямые и краткие ответы. Если для вашего сценария использования требуется более разговорчивый или "общительный" образ, необходимо явно указать модели направление в подсказке (например, "Объясните это как дружелюбный, разговорчивый помощник").

- Управление контекстом: При работе с большими наборами данных (например, целыми книгами, базами данных или длинными видеороликами) размещайте конкретные инструкции или вопросы в конце запроса, после описания контекста данных. Привяжите рассуждения модели к предоставленным данным, начав свой вопрос фразой типа: «На основании приведенной выше информации...».

Подробнее о стратегиях оперативного проектирования можно узнать в руководстве по оперативному проектированию .

Часто задаваемые вопросы

Какой минимальный уровень знаний необходим для моделей Gemini 3? Минимальный уровень знаний для моделей Gemini 3 — январь 2025 года. Для получения более актуальной информации воспользуйтесь инструментом «Поиск подтверждения» .

Каковы ограничения контекстного окна? Модели Gemini 3 поддерживают контекстное окно ввода в 1 миллион токенов и до 64 тысяч токенов вывода.

Есть ли бесплатный тариф для Gemini 3? Для Gemini 3 Flash

gemini-3-flash-previewдоступен бесплатный тариф в рамках API Gemini. Вы можете бесплатно попробовать Gemini 3, 3.1 Pro и 3 Flash в Google AI Studio, но дляgemini-3-pro-previewиgemini-3.1-pro-previewв API Gemini бесплатный тариф недоступен.Будет ли мой старый код

thinking_budgetпо-прежнему работать? Да,thinking_budgetпо-прежнему поддерживается для обратной совместимости, но мы рекомендуем перейти наthinking_levelдля более предсказуемой производительности. Не используйте оба кода в одном запросе.Поддерживает ли Gemini 3 пакетный API? Да, Gemini 3 поддерживает пакетный API .

Поддерживается ли контекстное кэширование? Да, контекстное кэширование поддерживается в Gemini 3.

Какие инструменты поддерживаются в Gemini 3? Gemini 3 поддерживает поиск Google , поиск файлов , выполнение кода и контекст URL . Он также поддерживает стандартный вызов функций для ваших собственных пользовательских инструментов (но не для встроенных инструментов). Обратите внимание, что привязка к Google Maps в настоящее время не поддерживается.

Что такое

gemini-3.1-pro-preview-customtools? Если вы используетеgemini-3.1-pro-preview, и модель игнорирует ваши пользовательские инструменты в пользу команд bash, попробуйте вместо этого модельgemini-3.1-pro-preview-customtools. Дополнительная информация здесь .

Следующие шаги

- Начните с поваренной книги Gemini 3.

- Ознакомьтесь со специальным руководством по уровням мышления и по тому, как перейти от бюджета мышления к уровням мышления.