জেমিনি রোবোটিক্স-ইআর ১.৫ হল একটি ভিশন-ল্যাঙ্গুয়েজ মডেল (ভিএলএম) যা জেমিনির এজেন্টিক ক্ষমতা রোবোটিক্সে নিয়ে আসে। এটি ভৌত জগতে উন্নত যুক্তির জন্য ডিজাইন করা হয়েছে, যা রোবটদের জটিল ভিজ্যুয়াল ডেটা ব্যাখ্যা করতে, স্থানিক যুক্তি সম্পাদন করতে এবং প্রাকৃতিক ভাষার কমান্ড ব্যবহার করে কর্ম পরিকল্পনা করতে দেয়।

মূল বৈশিষ্ট্য এবং সুবিধা:

- বর্ধিত স্বায়ত্তশাসন: রোবটগুলি উন্মুক্ত পরিবেশে পরিবর্তনের যুক্তি, অভিযোজন এবং প্রতিক্রিয়া জানাতে পারে।

- প্রাকৃতিক ভাষার মিথস্ক্রিয়া: প্রাকৃতিক ভাষা ব্যবহার করে জটিল কাজের অ্যাসাইনমেন্ট সক্ষম করে রোবটগুলিকে ব্যবহার করা সহজ করে তোলে।

- টাস্ক অর্কেস্ট্রেশন: প্রাকৃতিক ভাষার কমান্ডগুলিকে সাবটাস্কে বিভক্ত করে এবং দীর্ঘ-দিগন্তের কাজগুলি সম্পন্ন করার জন্য বিদ্যমান রোবট নিয়ন্ত্রক এবং আচরণের সাথে একীভূত করে।

- বহুমুখী ক্ষমতা: বস্তুগুলি সনাক্ত করে এবং সনাক্ত করে, বস্তুর সম্পর্ক বোঝে, ধারণা এবং গতিপথ পরিকল্পনা করে এবং গতিশীল দৃশ্যগুলি ব্যাখ্যা করে।

এই নথিতে মডেলটি কী করে তা বর্ণনা করা হয়েছে এবং মডেলের এজেন্টিক ক্ষমতা তুলে ধরার জন্য বেশ কয়েকটি উদাহরণের মধ্য দিয়ে আপনাকে নিয়ে যাওয়া হয়েছে।

আপনি যদি সরাসরি শুরু করতে চান, তাহলে গুগল এআই স্টুডিওতে মডেলটি ব্যবহার করে দেখতে পারেন।

গুগল এআই স্টুডিওতে চেষ্টা করে দেখুন

নিরাপত্তা

যদিও জেমিনি রোবোটিক্স-ইআর ১.৫ নিরাপত্তার কথা মাথায় রেখে তৈরি করা হয়েছে, রোবটের চারপাশে একটি নিরাপদ পরিবেশ বজায় রাখা আপনার দায়িত্ব। জেনারেটিভ এআই মডেলগুলি ভুল করতে পারে এবং ভৌত রোবটগুলি ক্ষতির কারণ হতে পারে। নিরাপত্তা একটি অগ্রাধিকার, এবং বাস্তব-বিশ্বের রোবোটিক্সের সাথে ব্যবহার করার সময় জেনারেটিভ এআই মডেলগুলিকে নিরাপদ করা আমাদের গবেষণার একটি সক্রিয় এবং গুরুত্বপূর্ণ ক্ষেত্র। আরও জানতে, গুগল ডিপমাইন্ড রোবোটিক্স সুরক্ষা পৃষ্ঠাটি দেখুন।

শুরু করা: একটি দৃশ্যে বস্তু খোঁজা

নিচের উদাহরণটি একটি সাধারণ রোবোটিক্স ব্যবহারের উদাহরণ প্রদর্শন করে। এটি দেখায় কিভাবে generateContent পদ্ধতি ব্যবহার করে মডেলে একটি ছবি এবং একটি টেক্সট প্রম্পট পাঠাতে হয় যাতে তাদের সংশ্লিষ্ট 2D পয়েন্ট সহ চিহ্নিত বস্তুর একটি তালিকা পাওয়া যায়। মডেলটি একটি ছবিতে চিহ্নিত আইটেমগুলির জন্য পয়েন্ট ফেরত দেয়, তাদের স্বাভাবিক 2D স্থানাঙ্ক এবং লেবেল ফেরত দেয়।

আপনি এই আউটপুটটি একটি রোবোটিক্স API-এর সাথে ব্যবহার করতে পারেন অথবা একটি ভিশন-ল্যাঙ্গুয়েজ-অ্যাকশন (VLA) মডেল বা অন্য কোনও তৃতীয়-পক্ষ ব্যবহারকারী-সংজ্ঞায়িত ফাংশন কল করে একটি রোবটের কার্য সম্পাদনের জন্য ক্রিয়া তৈরি করতে পারেন।

পাইথন

from google import genai

from google.genai import types

PROMPT = """

Point to no more than 10 items in the image. The label returned

should be an identifying name for the object detected.

The answer should follow the json format: [{"point": <point>,

"label": <label1>}, ...]. The points are in [y, x] format

normalized to 0-1000.

"""

client = genai.Client()

# Load your image

with open("my-image.png", 'rb') as f:

image_bytes = f.read()

image_response = client.models.generate_content(

model="gemini-robotics-er-1.5-preview",

contents=[

types.Part.from_bytes(

data=image_bytes,

mime_type='image/png',

),

PROMPT

],

config = types.GenerateContentConfig(

temperature=0.5,

thinking_config=types.ThinkingConfig(thinking_budget=0)

)

)

print(image_response.text)

বিশ্রাম

# First, ensure you have the image file locally.

# Encode the image to base64

IMAGE_BASE64=$(base64 -w 0 my-image.png)

curl -X POST \

"https://generativelanguage.googleapis.com/v1beta/models/gemini-robotics-er-1.5-preview:generateContent \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"contents": [

{

"parts": [

{

"inlineData": {

"mimeType": "image/png",

"data": "'"${IMAGE_BASE64}"'"

}

},

{

"text": "Point to no more than 10 items in the image. The label returned should be an identifying name for the object detected. The answer should follow the json format: [{\"point\": [y, x], \"label\": <label1>}, ...]. The points are in [y, x] format normalized to 0-1000."

}

]

}

],

"generationConfig": {

"temperature": 0.5,

"thinkingConfig": {

"thinkingBudget": 0

}

}

}'

আউটপুটটি হবে একটি JSON অ্যারে যেখানে অবজেক্ট থাকবে, প্রতিটিতে একটি point (স্বাভাবিক [y, x] স্থানাঙ্ক) এবং একটি label থাকবে যা অবজেক্টটিকে সনাক্ত করবে।

JSON সম্পর্কে

[

{"point": [376, 508], "label": "small banana"},

{"point": [287, 609], "label": "larger banana"},

{"point": [223, 303], "label": "pink starfruit"},

{"point": [435, 172], "label": "paper bag"},

{"point": [270, 786], "label": "green plastic bowl"},

{"point": [488, 775], "label": "metal measuring cup"},

{"point": [673, 580], "label": "dark blue bowl"},

{"point": [471, 353], "label": "light blue bowl"},

{"point": [492, 497], "label": "bread"},

{"point": [525, 429], "label": "lime"}

]

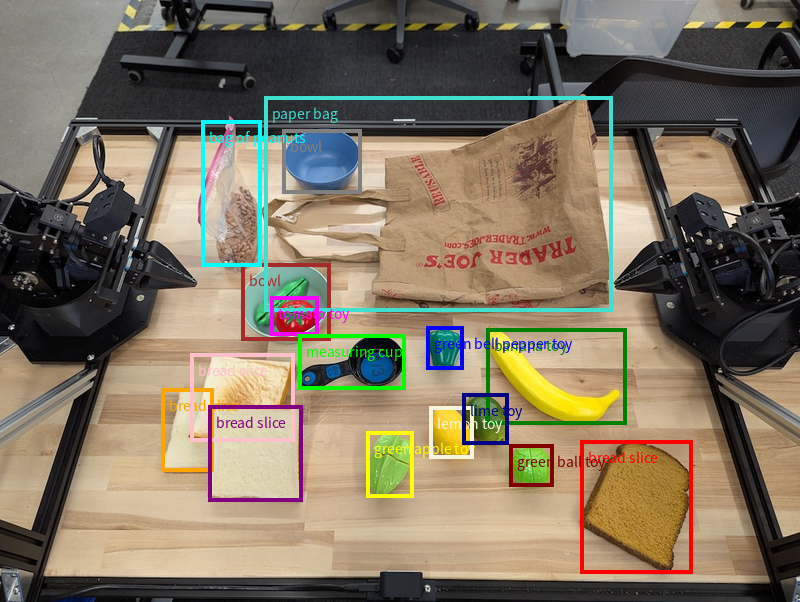

এই বিন্দুগুলি কীভাবে প্রদর্শিত হতে পারে তার একটি উদাহরণ হল নিম্নলিখিত চিত্রটি:

কিভাবে এটা কাজ করে

জেমিনি রোবোটিক্স-ইআর ১.৫ আপনার রোবটগুলিকে স্থানিক বোধগম্যতা ব্যবহার করে ভৌত জগতের প্রেক্ষাপট নির্ধারণ এবং কাজ করার সুযোগ দেয়। এটি চিত্র/ভিডিও/অডিও ইনপুট এবং প্রাকৃতিক ভাষার প্রম্পট গ্রহণ করে:

- বস্তু এবং দৃশ্যের প্রেক্ষাপট বুঝুন : বস্তুগুলি চিহ্নিত করুন এবং দৃশ্যের সাথে তাদের সম্পর্কের কারণগুলি চিহ্নিত করুন, যার মধ্যে তাদের সম্ভাবনাও অন্তর্ভুক্ত।

- কাজের নির্দেশাবলী বুঝুন : প্রাকৃতিক ভাষায় প্রদত্ত কাজগুলি ব্যাখ্যা করে, যেমন "কলাটি খুঁজে বের করুন"।

- স্থানিক এবং অস্থায়ীভাবে যুক্তি : ক্রিয়ার ক্রম এবং সময়ের সাথে সাথে বস্তুগুলি কীভাবে একটি দৃশ্যের সাথে মিথস্ক্রিয়া করে তা বুঝুন।

- কাঠামোগত আউটপুট প্রদান করুন : বস্তুর অবস্থানগুলি প্রতিনিধিত্ব করে স্থানাঙ্ক (পয়েন্ট বা বাউন্ডিং বাক্স) প্রদান করে।

এটি রোবটদের তাদের পরিবেশ প্রোগ্রাম্যাটিকভাবে "দেখতে" এবং "বোঝার" সক্ষম করে।

জেমিনি রোবোটিক্স-ইআর ১.৫ও এজেন্টিক, যার অর্থ এটি দীর্ঘ দিগন্তের কাজগুলি পরিচালনা করার জন্য জটিল কাজগুলিকে (যেমন "আপেলটি বাটিতে রাখুন") উপ-কাজে ভেঙে ফেলতে পারে:

- সিকোয়েন্সিং সাবটাস্ক : কমান্ডগুলিকে ধাপের একটি লজিক্যাল ক্রমে বিভক্ত করে।

- ফাংশন কল/কোড এক্সিকিউশন : আপনার বিদ্যমান রোবট ফাংশন/টুলগুলিকে কল করে বা জেনারেট করা কোড এক্সিকিউশন করে ধাপগুলি সম্পাদন করে।

জেমিনির সাথে ফাংশন কলিং কীভাবে কাজ করে সে সম্পর্কে আরও পড়ুন ফাংশন কলিং পৃষ্ঠায় ।

জেমিনি রোবোটিক্স-ইআর ১.৫ এর সাথে চিন্তাভাবনামূলক বাজেট ব্যবহার করা

জেমিনি রোবোটিক্স-ইআর ১.৫-এর একটি নমনীয় চিন্তাভাবনা বাজেট রয়েছে যা আপনাকে লেটেন্সি বনাম নির্ভুলতার ট্রেডঅফ নিয়ন্ত্রণ করতে দেয়। বস্তু সনাক্তকরণের মতো স্থানিক বোঝার কাজের জন্য, মডেলটি একটি ছোট চিন্তাভাবনা বাজেটের মাধ্যমে উচ্চ কর্মক্ষমতা অর্জন করতে পারে। গণনা এবং ওজন অনুমানের মতো আরও জটিল যুক্তির কাজগুলি বৃহত্তর চিন্তাভাবনা বাজেটের সুবিধা দেয়। এটি আপনাকে আরও চ্যালেঞ্জিং কাজের জন্য উচ্চ নির্ভুলতার ফলাফলের সাথে কম-বিলম্বিত প্রতিক্রিয়ার প্রয়োজনীয়তার ভারসাম্য বজায় রাখতে দেয়।

চিন্তাভাবনা বাজেট সম্পর্কে আরও জানতে, চিন্তাভাবনার মূল ক্ষমতা পৃষ্ঠাটি দেখুন।

রোবোটিক্সের জন্য এজেন্টিক ক্ষমতা

এই বিভাগে জেমিনি রোবোটিক্স-ইআর ১.৫ এর বিভিন্ন ক্ষমতা নিয়ে আলোচনা করা হয়েছে, যেখানে রোবোটিক উপলব্ধি, যুক্তি এবং পরিকল্পনা প্রয়োগের জন্য মডেলটি কীভাবে ব্যবহার করতে হয় তা দেখানো হয়েছে।

এই বিভাগের উদাহরণগুলি ছবিতে বস্তুগুলি নির্দেশ করা এবং খুঁজে বের করা থেকে শুরু করে ট্র্যাজেক্টোরি পরিকল্পনা করা এবং দীর্ঘ দিগন্তের কাজগুলি পরিচালনা করার ক্ষমতা প্রদর্শন করে। সরলতার জন্য, কোড স্নিপেটগুলিকে প্রম্পট এবং generate_content API-তে কল দেখানোর জন্য ছোট করা হয়েছে। সম্পূর্ণ রানেবল কোডের পাশাপাশি অতিরিক্ত উদাহরণগুলি রোবোটিক্স কুকবুক- এ পাওয়া যাবে।

বস্তুর দিকে ইঙ্গিত করা

ছবি বা ভিডিও ফ্রেমে বস্তু নির্দেশ করা এবং খুঁজে বের করা রোবোটিক্সে ভিশন-এন্ড-ল্যাঙ্গুয়েজ মডেল (VLM) এর একটি সাধারণ ব্যবহারের ক্ষেত্রে। নিম্নলিখিত উদাহরণটি মডেলটিকে একটি ছবির মধ্যে নির্দিষ্ট বস্তু খুঁজে বের করতে এবং একটি ছবিতে তাদের স্থানাঙ্ক ফেরত দিতে বলে।

পাইথন

from google import genai

from google.genai import types

client = genai.Client()

# Load your image and set up your prompt

with open('path/to/image-with-objects.jpg', 'rb') as f:

image_bytes = f.read()

queries = [

"bread",

"starfruit",

"banana",

]

prompt = f"""

Get all points matching the following objects: {', '.join(queries)}. The

label returned should be an identifying name for the object detected.

The answer should follow the json format:

[{{"point": , "label": }}, ...]. The points are in

[y, x] format normalized to 0-1000.

"""

image_response = client.models.generate_content(

model="gemini-robotics-er-1.5-preview",

contents=[

types.Part.from_bytes(

data=image_bytes,

mime_type='image/jpeg',

),

prompt

],

config = types.GenerateContentConfig(

temperature=0.5,

thinking_config=types.ThinkingConfig(thinking_budget=0)

)

)

print(image_response.text)

আউটপুটটি শুরু করার উদাহরণের মতোই হবে, একটি JSON যাতে পাওয়া বস্তুর স্থানাঙ্ক এবং তাদের লেবেল থাকবে।

[

{"point": [671, 317], "label": "bread"},

{"point": [738, 307], "label": "bread"},

{"point": [702, 237], "label": "bread"},

{"point": [629, 307], "label": "bread"},

{"point": [833, 800], "label": "bread"},

{"point": [609, 663], "label": "banana"},

{"point": [770, 483], "label": "starfruit"}

]

মডেলটিকে নির্দিষ্ট বস্তুর পরিবর্তে "ফল" এর মতো বিমূর্ত বিভাগগুলি ব্যাখ্যা করার জন্য এবং চিত্রের সমস্ত উদাহরণ সনাক্ত করার জন্য নিম্নলিখিত প্রম্পটটি ব্যবহার করুন।

পাইথন

prompt = f"""

Get all points for fruit. The label returned should be an identifying

name for the object detected.

""" + """The answer should follow the json format:

[{"point": <point>, "label": <label1>}, ...]. The points are in

[y, x] format normalized to 0-1000."""

অন্যান্য চিত্র প্রক্রিয়াকরণ কৌশলের জন্য চিত্র বোঝার পৃষ্ঠাটি দেখুন।

ভিডিওতে অবজেক্ট ট্র্যাক করা

জেমিনি রোবোটিক্স-ইআর ১.৫ সময়ের সাথে সাথে বস্তুগুলি ট্র্যাক করার জন্য ভিডিও ফ্রেম বিশ্লেষণ করতে পারে। সমর্থিত ভিডিও ফর্ম্যাটগুলির তালিকার জন্য ভিডিও ইনপুটগুলি দেখুন।

মডেলটি বিশ্লেষণ করে এমন প্রতিটি ফ্রেমের নির্দিষ্ট বস্তু খুঁজে পেতে ব্যবহৃত বেস প্রম্পটটি নিম্নরূপ:

পাইথন

# Define the objects to find

queries = [

"pen (on desk)",

"pen (in robot hand)",

"laptop (opened)",

"laptop (closed)",

]

base_prompt = f"""

Point to the following objects in the provided image: {', '.join(queries)}.

The answer should follow the json format:

[{{"point": , "label": }}, ...].

The points are in [y, x] format normalized to 0-1000.

If no objects are found, return an empty JSON list [].

"""

আউটপুটটি ভিডিও ফ্রেম জুড়ে একটি কলম এবং ল্যাপটপ ট্র্যাক করা দেখায়।

![]()

সম্পূর্ণ রানযোগ্য কোডের জন্য, রোবোটিক্স রান্নার বইটি দেখুন।

বস্তু সনাক্তকরণ এবং বাউন্ডিং বাক্স

একক বিন্দুর বাইরে, মডেলটি 2D বাউন্ডিং বক্সও ফেরত দিতে পারে, যা একটি বস্তুকে ঘিরে একটি আয়তক্ষেত্রাকার অঞ্চল প্রদান করে।

এই উদাহরণে টেবিলে শনাক্তযোগ্য বস্তুর জন্য 2D বাউন্ডিং বাক্সের অনুরোধ করা হয়েছে। মডেলটিকে 25টি বস্তুর মধ্যে আউটপুট সীমাবদ্ধ করতে এবং একাধিক উদাহরণকে অনন্যভাবে নামকরণ করতে নির্দেশ দেওয়া হয়েছে।

পাইথন

from google import genai

from google.genai import types

client = genai.Client()

# Load your image and set up your prompt

with open('path/to/image-with-objects.jpg', 'rb') as f:

image_bytes = f.read()

prompt = """

Return bounding boxes as a JSON array with labels. Never return masks

or code fencing. Limit to 25 objects. Include as many objects as you

can identify on the table.

If an object is present multiple times, name them according to their

unique characteristic (colors, size, position, unique characteristics, etc..).

The format should be as follows: [{"box_2d": [ymin, xmin, ymax, xmax],

"label": <label for the object>}] normalized to 0-1000. The values in

box_2d must only be integers

"""

image_response = client.models.generate_content(

model="gemini-robotics-er-1.5-preview",

contents=[

types.Part.from_bytes(

data=image_bytes,

mime_type='image/jpeg',

),

prompt

],

config = types.GenerateContentConfig(

temperature=0.5,

thinking_config=types.ThinkingConfig(thinking_budget=0)

)

)

print(image_response.text)

নিম্নলিখিতটি মডেল থেকে ফিরে আসা বাক্সগুলি প্রদর্শন করে।

সম্পূর্ণ রানযোগ্য কোডের জন্য, রোবোটিক্স কুকবুকটি দেখুন। চিত্র বোঝার পৃষ্ঠায় বিভাজন এবং বস্তু সনাক্তকরণের মতো ভিজ্যুয়াল কাজের অতিরিক্ত উদাহরণও রয়েছে।

অতিরিক্ত বাউন্ডিং বক্সের উদাহরণ চিত্র বোঝার পৃষ্ঠায় পাওয়া যাবে।

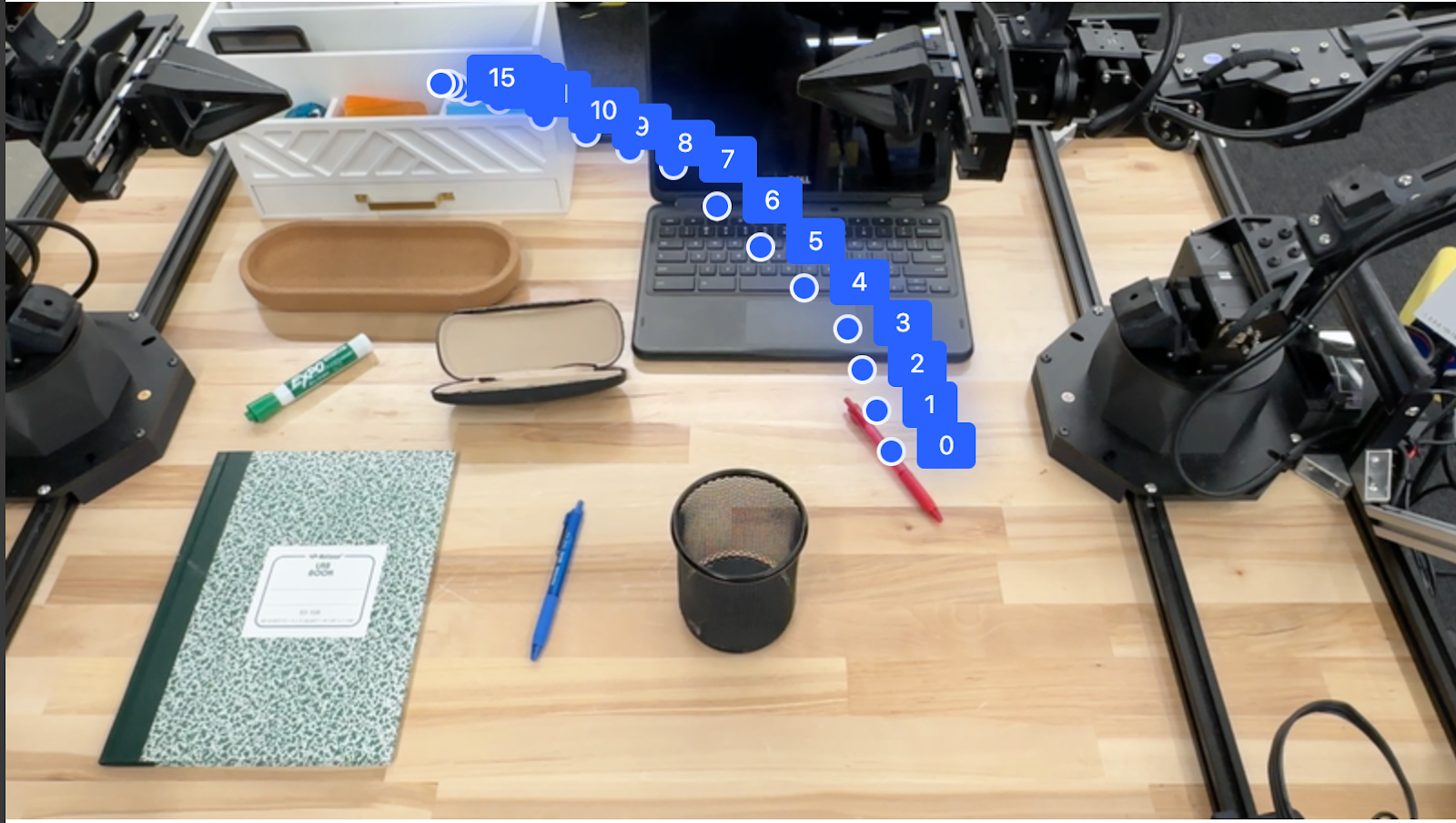

গতিপথ

জেমিনি রোবোটিক্স-ইআর ১.৫ এমন বিন্দুর ক্রম তৈরি করতে পারে যা একটি গতিপথ নির্ধারণ করে, যা রোবটের গতিবিধি পরিচালনার জন্য কার্যকর।

এই উদাহরণে একটি লাল কলমকে একটি সংগঠকের দিকে সরানোর জন্য একটি ট্র্যাজেক্টোরির অনুরোধ করা হয়েছে, যার মধ্যে শুরুর বিন্দু এবং মধ্যবর্তী বিন্দুগুলির একটি সিরিজ অন্তর্ভুক্ত রয়েছে।

পাইথন

from google import genai

from google.genai import types

client = genai.Client()

# Load your image and set up your prompt

with open('path/to/image-with-objects.jpg', 'rb') as f:

image_bytes = f.read()

points_data = []

prompt = """

Place a point on the red pen, then 15 points for the trajectory of

moving the red pen to the top of the organizer on the left.

The points should be labeled by order of the trajectory, from '0'

(start point at left hand) to <n> (final point)

The answer should follow the json format:

[{"point": <point>, "label": <label1>}, ...].

The points are in [y, x] format normalized to 0-1000.

"""

image_response = client.models.generate_content(

model="gemini-robotics-er-1.5-preview",

contents=[

types.Part.from_bytes(

data=image_bytes,

mime_type='image/jpeg',

),

prompt

],

config = types.GenerateContentConfig(

temperature=0.5,

)

)

print(image_response.text)

প্রতিক্রিয়াটি হল স্থানাঙ্কের একটি সেট যা লাল কলমটি সংগঠকের উপরে সরানোর কাজটি সম্পন্ন করার জন্য যে পথ অনুসরণ করবে তার গতিপথ বর্ণনা করে:

[

{"point": [550, 610], "label": "0"},

{"point": [500, 600], "label": "1"},

{"point": [450, 590], "label": "2"},

{"point": [400, 580], "label": "3"},

{"point": [350, 550], "label": "4"},

{"point": [300, 520], "label": "5"},

{"point": [250, 490], "label": "6"},

{"point": [200, 460], "label": "7"},

{"point": [180, 430], "label": "8"},

{"point": [160, 400], "label": "9"},

{"point": [140, 370], "label": "10"},

{"point": [120, 340], "label": "11"},

{"point": [110, 320], "label": "12"},

{"point": [105, 310], "label": "13"},

{"point": [100, 305], "label": "14"},

{"point": [100, 300], "label": "15"}

]

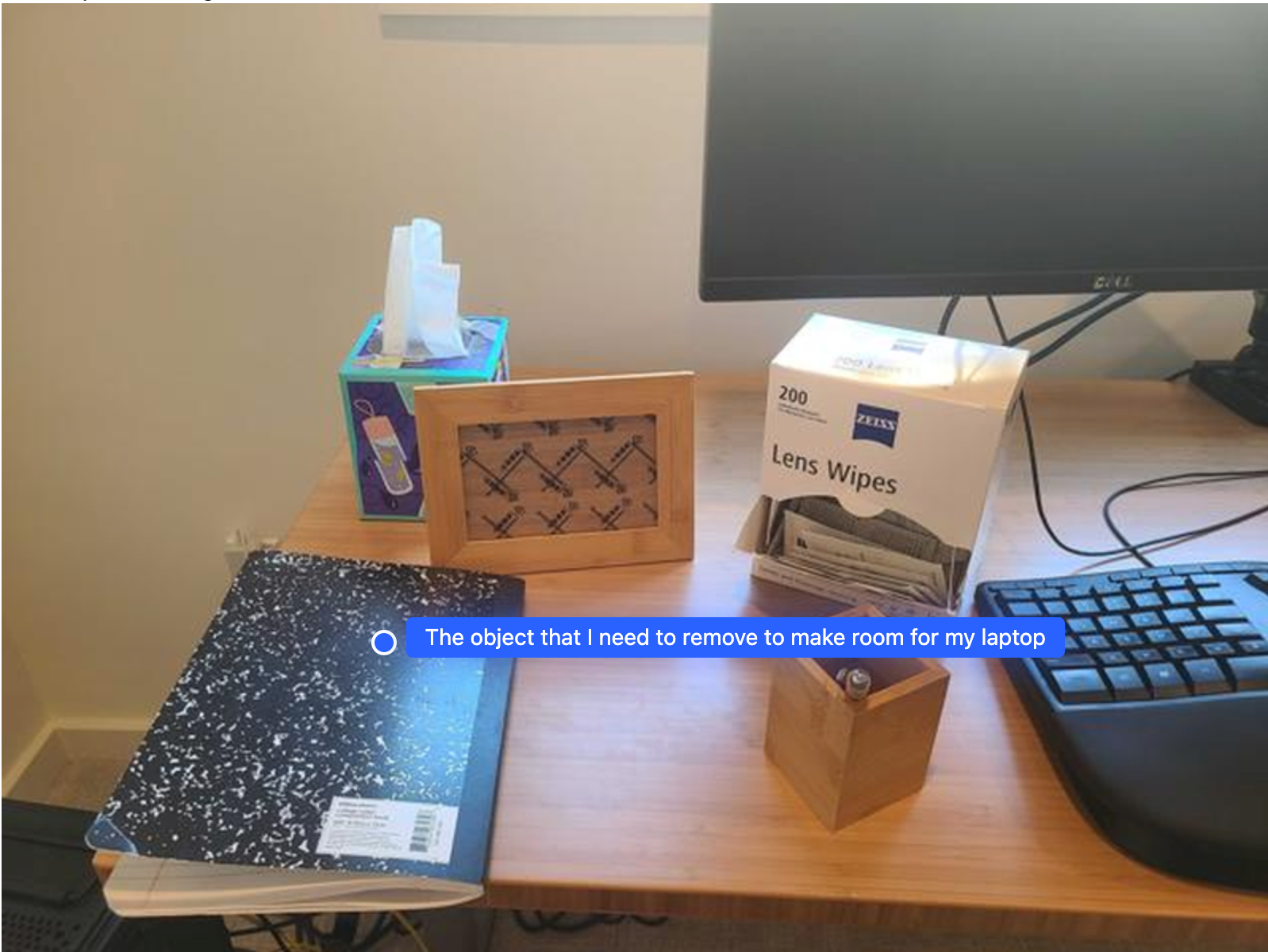

অর্কেস্ট্রেশন

জেমিনি রোবোটিক্স-ইআর ১.৫ উচ্চ-স্তরের স্থানিক যুক্তি সম্পাদন করতে পারে, ক্রিয়া অনুমান করতে পারে বা প্রাসঙ্গিক বোধগম্যতার উপর ভিত্তি করে সর্বোত্তম অবস্থান সনাক্ত করতে পারে।

ল্যাপটপের জন্য জায়গা তৈরি করা হচ্ছে

এই উদাহরণটি দেখায় যে জেমিনি রোবোটিক্স-ইআর কীভাবে একটি স্থান সম্পর্কে যুক্তি দিতে পারে। প্রম্পটটি মডেলটিকে অন্য কোনও আইটেমের জন্য স্থান তৈরি করতে কোন বস্তুটি সরানো প্রয়োজন তা সনাক্ত করতে বলে।

পাইথন

from google import genai

from google.genai import types

client = genai.Client()

# Load your image and set up your prompt

with open('path/to/image-with-objects.jpg', 'rb') as f:

image_bytes = f.read()

prompt = """

Point to the object that I need to remove to make room for my laptop

The answer should follow the json format: [{"point": <point>,

"label": <label1>}, ...]. The points are in [y, x] format normalized to 0-1000.

"""

image_response = client.models.generate_content(

model="gemini-robotics-er-1.5-preview",

contents=[

types.Part.from_bytes(

data=image_bytes,

mime_type='image/jpeg',

),

prompt

],

config = types.GenerateContentConfig(

temperature=0.5,

thinking_config=types.ThinkingConfig(thinking_budget=0)

)

)

print(image_response.text)

প্রতিক্রিয়াটিতে বস্তুর একটি 2D স্থানাঙ্ক রয়েছে যা ব্যবহারকারীর প্রশ্নের উত্তর দেয়, এই ক্ষেত্রে, যে বস্তুটি ল্যাপটপের জন্য জায়গা তৈরি করার জন্য সরানো উচিত।

[

{"point": [672, 301], "label": "The object that I need to remove to make room for my laptop"}

]

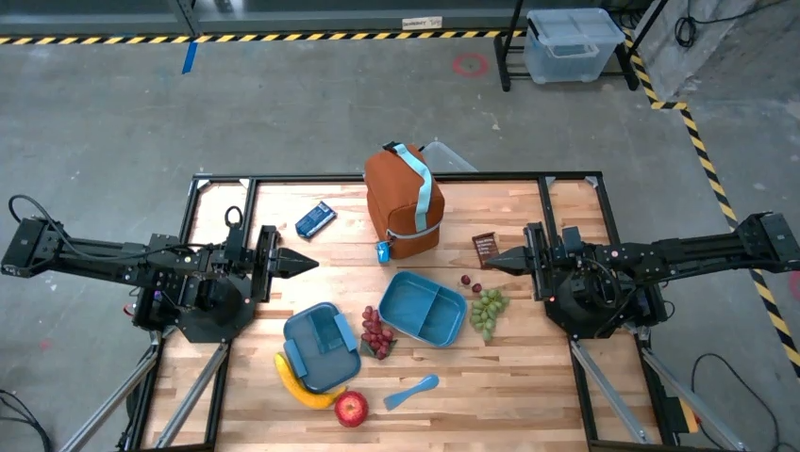

দুপুরের খাবার প্যাক করা

মডেলটি বহু-পদক্ষেপের কাজের জন্য নির্দেশাবলীও প্রদান করতে পারে এবং প্রতিটি ধাপের জন্য প্রাসঙ্গিক বিষয়গুলি নির্দেশ করতে পারে। এই উদাহরণটি দেখায় যে মডেলটি কীভাবে একটি লাঞ্চ ব্যাগ প্যাক করার জন্য কয়েকটি ধাপের পরিকল্পনা করে।

পাইথন

from google import genai

from google.genai import types

client = genai.Client()

# Load your image and set up your prompt

with open('path/to/image-of-lunch.jpg', 'rb') as f:

image_bytes = f.read()

prompt = """

Explain how to pack the lunch box and lunch bag. Point to each

object that you refer to. Each point should be in the format:

[{"point": [y, x], "label": }], where the coordinates are

normalized between 0-1000.

"""

image_response = client.models.generate_content(

model="gemini-robotics-er-1.5-preview",

contents=[

types.Part.from_bytes(

data=image_bytes,

mime_type='image/jpeg',

),

prompt

],

config = types.GenerateContentConfig(

temperature=0.5,

thinking_config=types.ThinkingConfig(thinking_budget=0)

)

)

print(image_response.text)

এই প্রম্পটের উত্তর হল ইমেজ ইনপুট থেকে লাঞ্চ ব্যাগ কীভাবে প্যাক করবেন তার ধাপে ধাপে নির্দেশাবলীর একটি সেট।

ইনপুট ছবি

মডেল আউটপুট

Based on the image, here is a plan to pack the lunch box and lunch bag:

1. **Pack the fruit into the lunch box.** Place the [apple](apple), [banana](banana), [red grapes](red grapes), and [green grapes](green grapes) into the [blue lunch box](blue lunch box).

2. **Add the spoon to the lunch box.** Put the [blue spoon](blue spoon) inside the lunch box as well.

3. **Close the lunch box.** Secure the lid on the [blue lunch box](blue lunch box).

4. **Place the lunch box inside the lunch bag.** Put the closed [blue lunch box](blue lunch box) into the [brown lunch bag](brown lunch bag).

5. **Pack the remaining items into the lunch bag.** Place the [blue snack bar](blue snack bar) and the [brown snack bar](brown snack bar) into the [brown lunch bag](brown lunch bag).

Here is the list of objects and their locations:

* [{"point": [899, 440], "label": "apple"}]

* [{"point": [814, 363], "label": "banana"}]

* [{"point": [727, 470], "label": "red grapes"}]

* [{"point": [675, 608], "label": "green grapes"}]

* [{"point": [706, 529], "label": "blue lunch box"}]

* [{"point": [864, 517], "label": "blue spoon"}]

* [{"point": [499, 401], "label": "blue snack bar"}]

* [{"point": [614, 705], "label": "brown snack bar"}]

* [{"point": [448, 501], "label": "brown lunch bag"}]

একটি কাস্টম রোবট API কল করা হচ্ছে

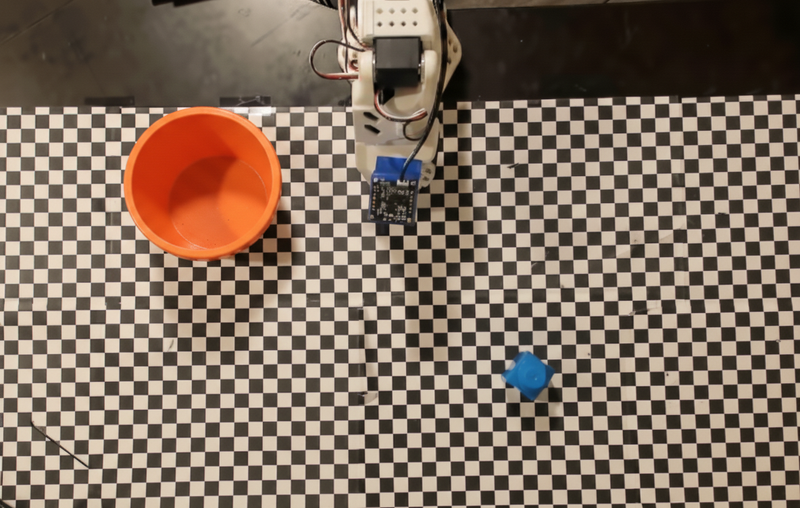

এই উদাহরণটি একটি কাস্টম রোবট API ব্যবহার করে টাস্ক অর্কেস্ট্রেশন প্রদর্শন করে। এটি একটি পিক-এন্ড-প্লেস অপারেশনের জন্য ডিজাইন করা একটি মক API প্রবর্তন করে। কাজটি হল একটি নীল ব্লক তুলে একটি কমলা বাটিতে রাখা:

এই পৃষ্ঠার অন্যান্য উদাহরণের মতো, সম্পূর্ণ রানেবল কোডটি রোবোটিক্স কুকবুকে পাওয়া যাবে।

প্রথম ধাপ হল নিম্নলিখিত প্রম্পট ব্যবহার করে উভয় আইটেম সনাক্ত করা:

পাইথন

prompt = """

Locate and point to the blue block and the orange bowl. The label

returned should be an identifying name for the object detected.

The answer should follow the json format: [{"point": <point>, "label": <label1>}, ...].

The points are in [y, x] format normalized to 0-1000.

"""

মডেল প্রতিক্রিয়াতে ব্লক এবং বাটির স্বাভাবিক স্থানাঙ্ক অন্তর্ভুক্ত রয়েছে:

[

{"point": [389, 252], "label": "orange bowl"},

{"point": [727, 659], "label": "blue block"}

]

এই উদাহরণে নিম্নলিখিত মক রোবট API ব্যবহার করা হয়েছে:

পাইথন

def move(x, y, high):

print(f"moving to coordinates: {x}, {y}, {15 if high else 5}")

def setGripperState(opened):

print("Opening gripper" if opened else "Closing gripper")

def returnToOrigin():

print("Returning to origin pose")

পরবর্তী ধাপ হল ক্রিয়াটি সম্পাদন করার জন্য প্রয়োজনীয় যুক্তি সহ API ফাংশনগুলির একটি ক্রম কল করা। নিম্নলিখিত প্রম্পটে রোবট API এর একটি বিবরণ রয়েছে যা মডেলটি এই কাজটি পরিচালনা করার সময় ব্যবহার করা উচিত।

পাইথন

prompt = f"""

You are a robotic arm with six degrees-of-freedom. You have the

following functions available to you:

def move(x, y, high):

# moves the arm to the given coordinates. The boolean value 'high' set

to True means the robot arm should be lifted above the scene for

avoiding obstacles during motion. 'high' set to False means the robot

arm should have the gripper placed on the surface for interacting with

objects.

def setGripperState(opened):

# Opens the gripper if opened set to true, otherwise closes the gripper

def returnToOrigin():

# Returns the robot to an initial state. Should be called as a cleanup

operation.

The origin point for calculating the moves is at normalized point

y={robot_origin_y}, x={robot_origin_x}. Use this as the new (0,0) for

calculating moves, allowing x and y to be negative.

Perform a pick and place operation where you pick up the blue block at

normalized coordinates ({block_x}, {block_y}) (relative coordinates:

{block_relative_x}, {block_relative_y}) and place it into the orange

bowl at normalized coordinates ({bowl_x}, {bowl_y})

(relative coordinates: {bowl_relative_x}, {bowl_relative_y}).

Provide the sequence of function calls as a JSON list of objects, where

each object has a "function" key (the function name) and an "args" key

(a list of arguments for the function).

Also, include your reasoning before the JSON output.

For example:

Reasoning: To pick up the block, I will first move the arm to a high

position above the block, open the gripper, move down to the block,

close the gripper, lift the arm, move to a high position above the bowl,

move down to the bowl, open the gripper, and then lift the arm back to

a high position.

"""

নিম্নলিখিতটি প্রম্পট এবং মক রোবট API এর উপর ভিত্তি করে মডেলের সম্ভাব্য আউটপুট দেখায়। আউটপুটে মডেল চিন্তাভাবনা প্রক্রিয়া এবং এর ফলে পরিকল্পনা করা কাজগুলি অন্তর্ভুক্ত থাকে। এটি মডেলটি একসাথে সিকোয়েন্স করা রোবট ফাংশন কলের আউটপুটও দেখায়।

Reasoning: To perform the pick and place operation, I will first move the

robotic arm to a high position above the blue block to ensure clearance. Then, I

will open the gripper in preparation for grasping. Next, I will lower the arm to

the surface level to position the gripper around the block and close the gripper

to secure it. After picking up the block, I will lift the arm to clear the

surface and move towards the orange bowl, maintaining a high position to avoid

collisions. Once positioned above the bowl, I will lower the arm to place the

block inside. I will then open the gripper to release the block. Finally, I will

lift the arm out of the bowl and call `returnToOrigin` to reset the robot's

state.

[

{

"function": "move",

"args": [

163,

427,

true

]

},

{

"function": "setGripperState",

"args": [

true

]

},

{

"function": "move",

"args": [

163,

427,

false

]

},

{

"function": "setGripperState",

"args": [

false

]

},

{

"function": "move",

"args": [

163,

427,

true

]

},

{

"function": "move",

"args": [

-247,

90,

true

]

},

{

"function": "move",

"args": [

-247,

90,

false

]

},

{

"function": "setGripperState",

"args": [

true

]

},

{

"function": "move",

"args": [

-247,

90,

true

]

},

{

"function": "returnToOrigin",

"args": []

}

]

Executing Function Calls:

moving to coordinates: 163, 427, 15

Opening gripper

moving to coordinates: 163, 427, 5

Closing gripper

moving to coordinates: 163, 427, 15

moving to coordinates: -247, 90, 15

moving to coordinates: -247, 90, 5

Opening gripper

moving to coordinates: -247, 90, 15

Returning to origin pose

কোড এক্সিকিউশন

জেমিনি রোবোটিক্স-ইআর ১.৫ এমন কাজ সম্পাদনের জন্য পাইথন কোডের পরামর্শ এবং সম্পাদন করতে পারে যার জন্য গতিশীল ক্রিয়া প্রয়োজন, যেমন আরও ভাল বিশদের জন্য একটি চিত্র অঞ্চলে জুম করা।

এই উদাহরণটি দেখায় যে মডেলটি কীভাবে কোড এক্সিকিউশন টুল ব্যবহার করে একটি ছবির নির্দিষ্ট অংশে "জুম ইন" করার পরামর্শ দিতে পারে, যা ব্যবহারকারীর প্রশ্নের উত্তর দেওয়ার জন্য এটি ব্যবহার করে।

পাইথন

from google import genai

from google.genai import types

client = genai.Client()

# Load your image and set up your prompt

with open('path/to/image-of-object.jpg', 'rb') as f:

image_bytes = f.read()

prompt = """

What is the air quality reading? Using the code execution feature,

zoom in on the image to take a closer look.

"""

response = client.models.generate_content(

model="gemini-robotics-er-1.5-preview",

contents=[

types.Part.from_bytes(

data=image_bytes,

mime_type='image/jpeg',

),

prompt

],

config = types.GenerateContentConfig(

temperature=0.5,

tools=[types.Tool(code_execution=types.ToolCodeExecution)]

)

)

for part in response.candidates[0].content.parts:

if part.text is not None:

print(part.text)

if part.executable_code is not None:

print(part.executable_code.code)

if part.code_execution_result is not None:

print(part.code_execution_result.output)

এই কাজের জন্য একটি সম্ভাব্য মডেল প্রতিক্রিয়া নীচে দেখানো হয়েছে। আউটপুটটি স্ক্রিনটি আরও ভালভাবে পড়ার জন্য চিত্রটি জুম করার জন্য মডেল জেনারেটিং কোড দেখায়। এটি ক্রপিংয়ে করা সমন্বয়গুলি সম্পর্কে চিন্তাভাবনা প্রক্রিয়াও দেখায়। সম্পূর্ণ নমুনা আউটপুটের জন্য, রোবোটিক্স কুকবুক দেখুন।

# Detect relevant objects and output in json format

# [{"box_2d": [379, 407, 481, 553], "label": "display"}]

from PIL import Image

# Open the image

img = Image.open("input_file_0.jpeg")

# Define the coordinates for cropping (normalized to 0-1000)

# Based on visual inspection, the display is roughly centered around [430, 430] to [500, 500] in a 1000x1000 scale.

# Let's try to zoom in on the display area.

# Bounding box for display: [ymin, xmin, ymax, xmax] in pixels.

# From visual inspection of the original image (size 90489 bytes, resolution

unknown but let's assume a standard aspect ratio and roughly 1000x1000 for

relative positioning),

# the display is located at approximately y=380-480, x=410-540.

# Let's define a larger area around it for context.

# Let's say we want to crop from y=350 to y=550 and x=350 to x=650.

...

thought

The crop was too tight and only captured part of the display. Let's adjust the bounding box.

The previous crop was `img.crop((400, 350, 600, 500))`. This means xmin=400, ymin=350, xmax=600, ymax=500.

The display is centered around x=480, y=430.

The previous crop captured the left side of the display.

Let's expand the x range to the right and y range to cover the whole circle.

New bounding box estimate: ymin=370, xmin=400, ymax=500, xmax=600.

Let's try again with a wider crop.

# Detect relevant objects and output in json format

# [{"box_2d": [379, 407, 481, 553], "label": "display"}]

from PIL import Image

# Open the image

img = Image.open("input_file_0.jpeg")

# Define the coordinates for cropping (normalized to 0-1000)

…

The reading of 14 falls into the "Moderate" category.

The prompt asks for the "air quality reading", which can be interpreted as

either the numerical value or the categorical description. Given the numerical

value is explicitly displayed, it's the primary reading.

Let's provide the numerical value as the reading.

The reading is 014.

Based on the display on the air purifier, the air quality reading is **014**.

সেরা অনুশীলন

আপনার রোবোটিক্স অ্যাপ্লিকেশনগুলির কর্মক্ষমতা এবং নির্ভুলতা অপ্টিমাইজ করার জন্য, জেমিনি মডেলের সাথে কীভাবে কার্যকরভাবে ইন্টারঅ্যাক্ট করা যায় তা বোঝা অত্যন্ত গুরুত্বপূর্ণ। এই বিভাগটি সবচেয়ে নির্ভরযোগ্য ফলাফল অর্জনের জন্য প্রম্পট তৈরি, ভিজ্যুয়াল ডেটা পরিচালনা এবং কার্য কাঠামোগত করার জন্য সেরা অনুশীলন এবং মূল কৌশলগুলির রূপরেখা দেয়।

স্পষ্ট এবং সহজ ভাষা ব্যবহার করুন।

স্বাভাবিক ভাষা গ্রহণ করুন : জেমিনি মডেলটি স্বাভাবিক, কথোপকথনের ভাষা বোঝার জন্য ডিজাইন করা হয়েছে। আপনার প্রম্পটগুলিকে এমনভাবে গঠন করুন যা শব্দার্থগতভাবে স্পষ্ট এবং একজন ব্যক্তি স্বাভাবিকভাবেই কীভাবে নির্দেশনা দেবেন তা প্রতিফলিত করে।

দৈনন্দিন পরিভাষা ব্যবহার করুন : প্রযুক্তিগত বা বিশেষায়িত শব্দভাণ্ডারের পরিবর্তে সাধারণ, দৈনন্দিন ভাষা বেছে নিন। যদি মডেলটি কোনও নির্দিষ্ট শব্দের প্রতি প্রত্যাশা অনুযায়ী সাড়া না দেয়, তাহলে আরও সাধারণ প্রতিশব্দ দিয়ে এটিকে পুনরায় ব্যবহার করার চেষ্টা করুন।

ভিজ্যুয়াল ইনপুট অপ্টিমাইজ করুন।

বিস্তারিত জানার জন্য জুম ইন করুন : ছোট বা বড় শটে চিহ্নিত করা কঠিন বস্তুর সাথে কাজ করার সময়, আগ্রহের বস্তুটি আলাদা করতে একটি বাউন্ডিং বক্স ফাংশন ব্যবহার করুন। তারপরে আপনি এই নির্বাচনটিতে ছবিটি ক্রপ করতে পারেন এবং আরও বিশদ বিশ্লেষণের জন্য নতুন, ফোকাসড চিত্রটি মডেলটিতে পাঠাতে পারেন।

আলো এবং রঙের পরীক্ষা-নিরীক্ষা : প্রতিকূল আলোর অবস্থা এবং দুর্বল রঙের বৈপরীত্যের কারণে মডেলটির উপলব্ধি প্রভাবিত হতে পারে।

জটিল সমস্যাগুলিকে ছোট ছোট ধাপে ভাগ করুন। প্রতিটি ছোট ধাপ পৃথকভাবে সমাধান করে, আপনি মডেলটিকে আরও সুনির্দিষ্ট এবং সফল ফলাফলের দিকে পরিচালিত করতে পারেন।

ঐক্যমত্যের মাধ্যমে নির্ভুলতা উন্নত করুন। যেসব কাজের জন্য উচ্চ মাত্রার নির্ভুলতার প্রয়োজন হয়, আপনি একই প্রম্পট ব্যবহার করে মডেলটিকে একাধিকবার জিজ্ঞাসা করতে পারেন। প্রাপ্ত ফলাফলের গড় নির্ধারণ করে, আপনি একটি "ঐক্যমত্য" অর্জন করতে পারেন যা প্রায়শই আরও সঠিক এবং নির্ভরযোগ্য।

সীমাবদ্ধতা

জেমিনি রোবোটিক্স-ইআর ১.৫ দিয়ে ডেভেলপ করার সময় নিম্নলিখিত সীমাবদ্ধতাগুলি বিবেচনা করুন:

- প্রিভিউ স্ট্যাটাস: মডেলটি বর্তমানে প্রিভিউতে রয়েছে। API এবং ক্ষমতা পরিবর্তিত হতে পারে, এবং পুঙ্খানুপুঙ্খ পরীক্ষা ছাড়া এটি উৎপাদন-সমালোচনামূলক অ্যাপ্লিকেশনের জন্য উপযুক্ত নাও হতে পারে।

- বিলম্ব: জটিল প্রশ্ন, উচ্চ-রেজোলিউশনের ইনপুট, অথবা বিস্তৃত

thinking_budgetফলে প্রক্রিয়াকরণের সময় বৃদ্ধি পেতে পারে। - হ্যালুসিনেশন: সমস্ত বৃহৎ ভাষা মডেলের মতো, জেমিনি রোবোটিক্স-ইআর 1.5 মাঝে মাঝে "হ্যালুসিনেট" করতে পারে বা ভুল তথ্য প্রদান করতে পারে, বিশেষ করে অস্পষ্ট প্রম্পট বা বিতরণের বাইরে থাকা ইনপুটগুলির জন্য।

- প্রম্পটের মানের উপর নির্ভরতা: মডেলের আউটপুটের মান ইনপুট প্রম্পটের স্পষ্টতা এবং নির্দিষ্টতার উপর অত্যন্ত নির্ভরশীল। অস্পষ্ট বা দুর্বল কাঠামোগত প্রম্পটগুলি সর্বোত্তম ফলাফলের দিকে নিয়ে যেতে পারে।

- গণনামূলক খরচ: মডেলটি চালানো, বিশেষ করে ভিডিও ইনপুট বা high

thinking_budgetদিয়ে, গণনামূলক সম্পদ খরচ করে এবং খরচ বহন করে। আরও বিস্তারিত জানার জন্য চিন্তাভাবনা পৃষ্ঠাটি দেখুন। - ইনপুট প্রকার: প্রতিটি মোডের সীমাবদ্ধতা সম্পর্কে বিস্তারিত জানতে নিম্নলিখিত বিষয়গুলি দেখুন।

গোপনীয়তা বিজ্ঞপ্তি

আপনি স্বীকার করছেন যে এই নথিতে উল্লেখিত মডেলগুলি ("রোবোটিক্স মডেল") আপনার নির্দেশাবলী অনুসারে আপনার হার্ডওয়্যার পরিচালনা এবং স্থানান্তর করার জন্য ভিডিও এবং অডিও ডেটা ব্যবহার করে। অতএব, আপনি রোবোটিক্স মডেলগুলি পরিচালনা করতে পারেন যাতে শনাক্তযোগ্য ব্যক্তিদের ডেটা, যেমন ভয়েস, চিত্র এবং অনুরূপ ডেটা ("ব্যক্তিগত ডেটা") রোবোটিক্স মডেলগুলি দ্বারা সংগ্রহ করা হয়। আপনি যদি রোবোটিক্স মডেলগুলি এমনভাবে পরিচালনা করতে চান যা ব্যক্তিগত ডেটা সংগ্রহ করে, তাহলে আপনি সম্মত হচ্ছেন যে আপনি কোনও শনাক্তযোগ্য ব্যক্তিকে রোবোটিক্স মডেলগুলির সাথে যোগাযোগ করতে বা আশেপাশের এলাকায় উপস্থিত থাকতে দেবেন না, যদি না এই ধরণের শনাক্তযোগ্য ব্যক্তিদের পর্যাপ্তভাবে অবহিত করা হয় এবং সম্মতি দেওয়া হয় যে তাদের ব্যক্তিগত ডেটা https://ai.google.dev/gemini-api/terms ("শর্তাবলী") এ পাওয়া জেমিনি API অতিরিক্ত পরিষেবার শর্তাবলীতে বর্ণিত হিসাবে Google দ্বারা সরবরাহ করা এবং ব্যবহার করা যেতে পারে, যার মধ্যে "Google কীভাবে আপনার ডেটা ব্যবহার করে" শিরোনামের বিভাগ অনুসারে অন্তর্ভুক্ত। আপনি নিশ্চিত করবেন যে এই ধরনের নোটিশ শর্তাবলীতে বর্ণিত ব্যক্তিগত তথ্য সংগ্রহ এবং ব্যবহারের অনুমতি দেয়, এবং আপনি ব্যক্তিগত তথ্য সংগ্রহ এবং বিতরণ কমানোর জন্য বাণিজ্যিকভাবে যুক্তিসঙ্গত প্রচেষ্টা ব্যবহার করবেন, যেমন মুখ ঝাপসা করা এবং শনাক্তযোগ্য ব্যক্তিদের ধারণক্ষমতা নেই এমন এলাকায় রোবোটিক্স মডেল পরিচালনা করার মতো কৌশল ব্যবহার করে।

মূল্য নির্ধারণ

মূল্য নির্ধারণ এবং উপলব্ধ অঞ্চল সম্পর্কে বিস্তারিত তথ্যের জন্য, মূল্য নির্ধারণ পৃষ্ঠাটি দেখুন।

মডেল সংস্করণ

| সম্পত্তি | বিবরণ |

|---|---|

| মডেল কোড | gemini-robotics-er-1.5-preview |

| সমর্থিত ডেটা প্রকারগুলি | ইনপুট টেক্সট, ছবি, ভিডিও, অডিও আউটপুট টেক্সট |

| টোকেন সীমা [*] | ইনপুট টোকেন সীমা ১,০৪৮,৫৭৬ আউটপুট টোকেন সীমা ৬৫,৫৩৬ |

| ক্ষমতা | অডিও জেনারেশন সমর্থিত নয় ব্যাচ এপিআই সমর্থিত নয় ক্যাশিং সমর্থিত নয় কোড এক্সিকিউশন সমর্থিত ফাংশন কলিং সমর্থিত গুগল ম্যাপের সাহায্যে গ্রাউন্ডিং সমর্থিত নয় চিত্র তৈরি সমর্থিত নয় লাইভ এপিআই সমর্থিত নয় অনুসন্ধান গ্রাউন্ডিং সমর্থিত কাঠামোগত আউটপুট সমর্থিত ভাবছি সমর্থিত URL প্রসঙ্গ সমর্থিত |

| সংস্করণ |

|

| সর্বশেষ আপডেট | সেপ্টেম্বর ২০২৫ |

| জ্ঞানের সীমাবদ্ধতা | জানুয়ারী ২০২৫ |

পরবর্তী পদক্ষেপ

- জেমিনি রোবোটিক্স-ইআর ১.৫ এর জন্য আরও অ্যাপ্লিকেশন আবিষ্কার করতে অন্যান্য ক্ষমতাগুলি অন্বেষণ করুন এবং বিভিন্ন প্রম্পট এবং ইনপুট নিয়ে পরীক্ষা-নিরীক্ষা চালিয়ে যান। আরও উদাহরণের জন্য রোবোটিক্স কুকবুকটি দেখুন।

- নিরাপত্তার কথা মাথায় রেখে জেমিনি রোবোটিক্স মডেলগুলি কীভাবে তৈরি করা হয়েছিল তা জানুন, গুগল ডিপমাইন্ড রোবোটিক্স সুরক্ষা পৃষ্ঠাটি দেখুন।

- জেমিনি রোবোটিক্স মডেলের সর্বশেষ আপডেট সম্পর্কে জেমিনি রোবোটিক্স ল্যান্ডিং পৃষ্ঠায় পড়ুন।