تتيح لك مهمة "إدراج النص" في MediaPipe إنشاء تمثيل رقمي لبيانات النص بهدف التقاط معناها الدلالي. تُستخدَم هذه الوظيفة كثيرًا لمقارنة التشابه الدلالي بين قطعتَي نص باستخدام أساليب مقارنة رياضية، مثل التشابه القائم على دالة الجيبّ cosine. تعمل هذه المهمة على بيانات النص باستخدام نموذج تعلُّم الآلة، وتُخرج تمثيلًا رقميًا لبيانات النص على شكل قائمة بمتجهات السمات العالية الأبعاد، والتي تُعرف أيضًا باسم متجهات التضمين، سواء بتنسيق النقطة العائمة أو بتنسيق الكمّي.

البدء

ابدأ استخدام هذه المهمة باتّباع أحد أدلة التنفيذ هذه ل منصّتك المستهدفة. ترشدك هذه الأدلة الخاصة بالنظام الأساسي إلى تنفيذ أساسي لهذه المهمة، بما في ذلك نموذج مقترَح ومثال على الرمز المبرمَج مع خيارات الإعداد المقترَحة:

- Android - مثال على الرمز المبرمَج - دليل

- Python - مثال على رمز - دليل

- الويب - مثال على الرمز البرمجي - الدليل

تفاصيل المهمة

يصف هذا القسم ميزات هذه المهمة ومدخلاتها ومخرجاتها وخيارات الضبط.

الميزات

- معالجة نص الإدخال: تتيح هذه الميزة تقسيم النصوص إلى وحدات خارج الرسم البياني للنماذج بدون تقسيم النصوص إلى وحدات داخل الرسم البياني.

- حساب التشابه في الدمج: دالة مساعدة مضمّنة لاحتساب تشابه جيب التمام بين متجهَين للميزات

- التكمية: تتيح هذه الطريقة استخدام الكمّات على مستوى العنصر الواحد في متجهات السمات.

| مدخلات المهام | نتائج المهام |

|---|---|

يقبل "مُضمِّن النصوص" نوع بيانات الإدخال التالي:

|

تُخرج أداة "إدراج النصوص" قائمة بإدراجات تتألف من:

|

خيارات الإعدادات

تتضمّن هذه المهمة خيارات الضبط التالية:

| اسم الخيار | الوصف | نطاق القيمة | القيمة التلقائية |

|---|---|---|---|

l2_normalize |

ما إذا كان يجب تطبيع متجه السمات المعروض باستخدام معيار L2 لا تستخدِم هذا الخيار إلا إذا كان النموذج لا يحتوي على خطوة معالجة برمجية أساسية L2_NORMALIZATION من TFLite. وفي معظم الحالات، يكون هذا هو الحال، وبالتالي يتم تحقيق تسويّة L2 من خلال الاستنتاج باستخدام TFLite بدون الحاجة إلى هذا الخيار. | Boolean |

False |

quantize |

ما إذا كان يجب تجزئة البيانات المضمّنة التي تم إرجاعها إلى وحدات بايت من خلال التجزئة على مستوى مقياس واحد يُفترض ضمنيًا أنّ القيم المضمّنة هي قيم عادية و بالتالي، يُضمن أن تكون قيمة أيّ سمة ضمن النطاق [-1.0, 1.0]. استخدِم الخيار l2_normalize إذا لم يكن الأمر كذلك. | Boolean |

False |

النماذج

نقدّم نموذجًا تلقائيًا مقترَحًا عند بدء التطوير باستخدام هذه المهمة.

نموذج Universal Sentence Encoder (مُقترَح)

يستخدم هذا النموذج بنية برنامج ترميز مزدوج وقد تم تدريبه على مجموعات بيانات مختلفة من الأسئلة والأجوبة.

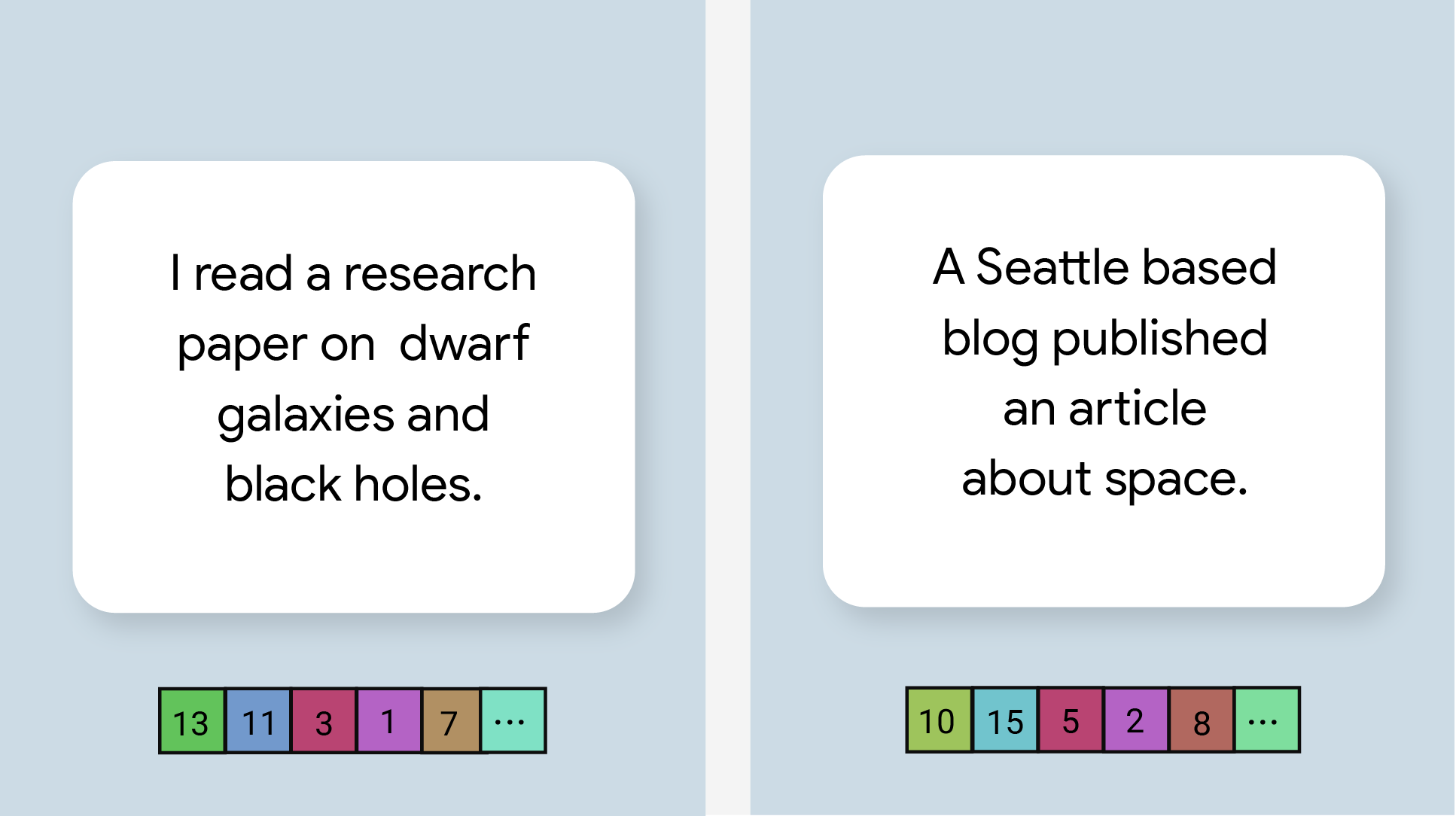

راجِع أزواج الجمل التالية:

- ("إنّها رحلة ساحرة ومؤثرة في كثير من الأحيان"، "ما أروع هذه الرحلة الرائعة")

- ("أحب هاتفي"، "أكره هاتفي")

- ("يقدّم هذا المطعم عروضًا رائعة"، "علينا التحقّق من تفاصيل خطّتنا مرة أخرى")

سيكون لتضمين النصوص في أول زوجَين من الجمل تشابهًا أكبر في دالة الجيب الزائد مقارنةً بالتضمين في الزوج الثالث من الجمل، لأنّ أول زوجَين من الجمل يتشاركان موضوعًا شائعًا هو "الشعور بالرحلة" و "رأي حول الهاتف" على التوالي، في حين أنّه لا يتشارك الزوج الثالث من الجمل موضوعًا شائعًا.

تجدر الإشارة إلى أنّه على الرغم من أنّ الجملتَين في الزوج الثاني تتضمّنان مشاعر متعارضة، تحصلان على نتيجة تشابه عالية لأنّهما تتشاركان موضوعًا مشتركًا.

| اسم الطراز | شكل الإدخال | نوع التقريب | الإصدارات |

|---|---|---|---|

| Universal Sentence Encoder | سلسلة، سلسلة، سلسلة | لا شيء (float32) | الأحدث |

مقاييس أداء المهام

في ما يلي مقاييس أداء المهام لعملية المعالجة بأكملها استنادًا إلى نماذج pretrained المدرَّبة مسبقًا أعلاه. نتيجة وقت الاستجابة هي متوسط وقت الاستجابة على هاتف Pixel 6 باستخدام وحدة المعالجة المركزية / وحدة معالجة الرسومات.

| اسم النموذج | وقت استجابة وحدة المعالجة المركزية | وقت استجابة وحدة معالجة الرسومات |

|---|---|---|

| Universal Sentence Encoder | 18.21 ملي ثانية | - |