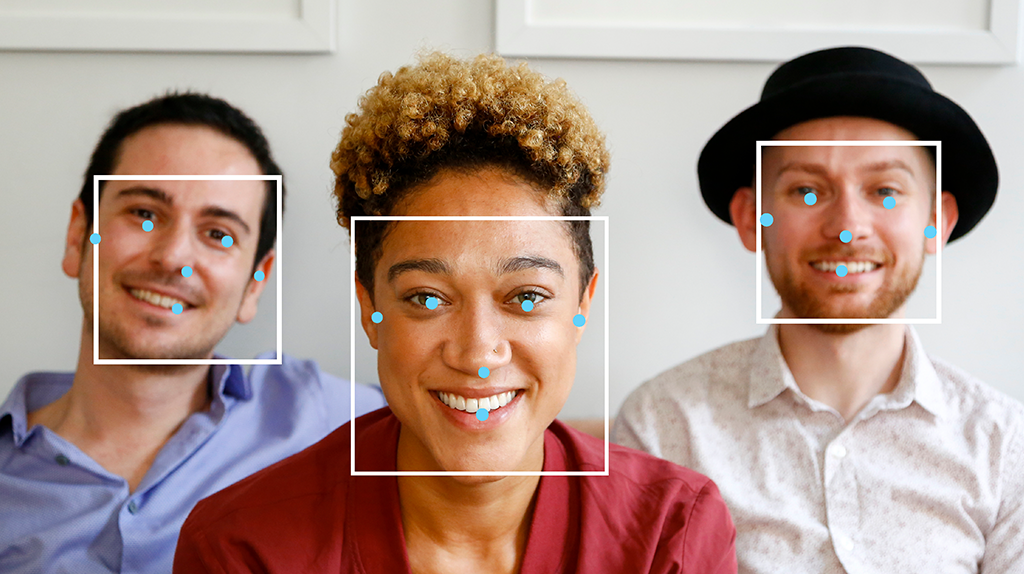

تتيح لك مهمة "مُعترِف الوجوه" من MediaPipe رصد الوجوه في صورة أو فيديو. يمكنك استخدام هذه المهمة لتحديد موقع الوجوه وملامح الوجه في إطار معيّن. تستخدِم هذه المهمة نموذجًا لتعلُّم الآلة يعمل مع صور فردية أو مجرى متواصل من الصور. تُخرج المهمة مواقع الوجوه، بالإضافة إلى النقاط الرئيسية التالية للوجه: العين اليسرى والعين اليمنى وطرف الأنف والفم ونقطة تراجيديون للعين اليسرى ونقطة تراجيديون للعين اليمنى.

البدء

ابدأ استخدام هذه المهمة باتّباع أحد أدلة التنفيذ هذه ل منصّتك المستهدفة. ترشدك هذه الأدلة الخاصة بالنظام الأساسي إلى تنفيذ أساسي لهذه المهمة، بما في ذلك نموذج مقترَح ومثال على الرمز المبرمَج مع خيارات الإعداد المقترَحة:

- Android - مثال على الرمز المبرمَج - دليل

- Python - مثال على رمز- دليل

- الويب - مثال على رمز برمجي - دليل

- iOS - مثال على الرمز المبرمَج - دليل

تفاصيل المهمة

يصف هذا القسم ميزات هذه المهمة ومدخلاتها ومخرجاتها وخيارات الضبط.

الميزات

- معالجة الصور المُدخلة: تشمل المعالجة تدوير الصور وتغيير حجمها وتسويتها وتحويل مساحة الألوان.

- الحدّ الأدنى للنتيجة: فلترة النتائج استنادًا إلى نتائج التوقّعات

| مدخلات المهام | نتائج المهام |

|---|---|

يقبل "مُعترِف الوجوه" إدخال أحد أنواع البيانات التالية:

|

يعرض "مُعترِف الوجوه" النتائج التالية:

|

خيارات الإعدادات

تتضمّن هذه المهمة خيارات الضبط التالية:

| اسم الخيار | الوصف | نطاق القيمة | القيمة التلقائية |

|---|---|---|---|

running_mode |

لضبط وضع التشغيل للمهمة هناك ثلاثة

أوضاع: IMAGE: وضع الإدخالات باستخدام صورة واحدة. VIDEO: وضع الإطارات التي تم فك ترميزها في الفيديو LIVE_STREAM: وضع البث المباشر لبيانات الإدخال ، مثل بيانات الكاميرا في هذا الوضع، يجب استدعاء resultListener لإعداد مستمع لتلقّي النتائج بشكل غير متزامن. |

{IMAGE, VIDEO, LIVE_STREAM} |

IMAGE |

min_detection_confidence |

الحد الأدنى لنتيجة الثقة ليعتبر رصد الوجه ناجحًا | Float [0,1] |

0.5 |

min_suppression_threshold |

الحد الأدنى لمستوى عدم قمع الحد الأقصى لميزة "اكتشاف الوجه" التي يتم اعتبارها متداخلة | Float [0,1] |

0.3 |

result_callback |

يضبط مستمع النتائج لتلقّي نتائج الكشف

بشكل غير متزامن عندما يكون "مُعترِف الوجوه" في وضع البث المباشر. لا يمكن استخدامها إلا عند ضبط وضع التشغيل على LIVE_STREAM. |

N/A |

Not set |

النماذج

يمكن أن تختلف نماذج التعرّف على الوجوه حسب حالات الاستخدام المقصودة، مثل التعرّف على الوجوه من مسافات قصيرة وبعيدة. توازن النماذج أيضًا عادةً بين الأداء والدقة ودرجة الدقة ومتطلبات الموارد، وفي بعض الحالات، تتضمّن ميزات إضافية.

النماذج المدرَجة في هذا القسم هي أنواع من BlazeFace، وهو عبارة عن أداة خفيفة الوزن و دقيقة لرصد الوجوه ومحسَّنة للاستخدام مع وحدات معالجة الرسومات في الأجهزة الجوّالة. نماذج BlazeFace مناسبة لتطبيقات مثل تقدير نقاط الوجه الثلاثية الأبعاد وتصنيف تعابير الوجه وتقسيم مناطق الوجه. يستخدم BlazeFace شبكة خفيفة الوزن لاستخراج الخصائص تشبه MobileNetV1/V2.

BlazeFace (قصيرة المدى)

نموذج خفيف لرصد وجوه فردية أو متعددة في صور تشبه صور السيلفي من كاميرا هاتف ذكي أو كاميرا ويب تم تحسين النموذج لمعالجة الصور التي تلتقطها كاميرا الهاتف الأمامية من مسافة قصيرة. تستخدِم بنية النموذج تقنية شبكة تحويلية لنظام "كاشف اللقطة الواحدة" (SSD) مع ملف رمز مخصّص لتشفير البيانات. لمزيد من المعلومات، يُرجى الاطّلاع على الورقة البحثية حول Single Shot MultiBox Detector.

| اسم الطراز | شكل الإدخال | نوع التقريب | بطاقة النموذج | الإصدارات |

|---|---|---|---|---|

| BlazeFace (النطاق القريب) | 128 × 128 | float 16 | info | الأحدث |

BlazeFace (النطاق الكامل)

نموذج خفيف نسبيًا لرصد وجوه فردية أو متعددة في الصور من كاميرا هاتف ذكي أو كاميرا ويب تم تحسين النموذج للتعامل مع كاميرا الهاتف المزوّدة بكاميرا خلفية لالتقاط صور بجودة عالية. تستخدِم بنية النموذج تقنية مشابهة لشبكة CenterNet التدرّجية مع برنامج ترميز مخصّص.

| اسم الطراز | شكل الإدخال | نوع التقريب | بطاقة النموذج | الإصدارات |

|---|---|---|---|---|

| BlazeFace (النطاق الكامل) | 128 × 128 | float 16 | معلومات | قريبًا |

BlazeFace Sparse (النطاق الكامل)

نسخة أخف من نموذج BlazeFace العادي الكامل النطاق، أصغر حجمًا بنسبة 60% تقريبًا تم تحسين النموذج للصور ذات النطاق الكامل، مثل الصور التي تم التقاطها باستخدام كاميرا الهاتف الخلفية. تستخدِم بنية النموذج تقنية مشابهة لشبكة CenterNet التفافية مع برنامج ترميز مخصّص.

| اسم الطراز | شكل الإدخال | نوع التقريب | بطاقة النموذج | الإصدارات |

|---|---|---|---|---|

| BlazeFace Sparse (النطاق الكامل) | 128 × 128 | float 16 | معلومات | قريبًا |

مقاييس أداء المهام

في ما يلي مقاييس أداء المهام لعملية المعالجة بأكملها استنادًا إلى نماذج pretrained المدرَّبة مسبقًا أعلاه. نتيجة وقت الاستجابة هي متوسط وقت الاستجابة على هاتف Pixel 6 باستخدام وحدة المعالجة المركزية / وحدة معالجة الرسومات.

| اسم النموذج | وقت استجابة وحدة المعالجة المركزية | وقت استجابة وحدة معالجة الرسومات |

|---|---|---|

| BlazeFace (قصيرة المدى) | 2.94 ملي ثانية | 7.41 ملي ثانية |