Mit der MediaPipe Face Landmark-Aufgabe können Sie Gesichtsmerkmale und Gesichtsausdrücke in Bildern und Videos erkennen. Sie können menschliche Gesichtsausdrücke erkennen, Gesichtsfilter und -effekte anwenden und virtuelle Avatare erstellen. Bei dieser Aufgabe werden Modelle für maschinelles Lernen (ML) verwendet, die mit einzelnen Bildern oder einem kontinuierlichen Bilderstream arbeiten können. Die Aufgabe gibt dreidimensionale Gesichtsmerkmale, Blendshape-Werte (Koeffizienten, die den Gesichtsausdruck darstellen) aus, um detaillierte Gesichtsflächen in Echtzeit abzuleiten, und Transformationsmatrizen, um die für das Rendern von Effekten erforderlichen Transformationen durchzuführen.

Jetzt starten

Beginnen Sie mit dieser Aufgabe, indem Sie einem der Implementierungsleitfäden für Ihre Zielplattform folgen. Diese plattformspezifischen Leitfäden führen Sie durch eine grundlegende Implementierung dieser Aufgabe, einschließlich eines empfohlenen Modells und eines Codebeispiels mit empfohlenen Konfigurationsoptionen:

- Android – Codebeispiel – Leitfaden

- Python – Codebeispiel – Anleitung

- Web – Codebeispiel – Leitfaden

Taskdetails

In diesem Abschnitt werden die Funktionen, Eingaben, Ausgaben und Konfigurationsoptionen dieser Aufgabe beschrieben.

Funktionen

- Eingabebildverarbeitung: Die Verarbeitung umfasst Bilddrehung, Größenanpassung, Normalisierung und Farbraumkonvertierung.

- Punktzahl-Schwellenwert: Filtern Sie Ergebnisse basierend auf den Vorhersagewerten.

| Aufgabeneingaben | Aufgabenausgaben |

|---|---|

Für Face Landmarks sind folgende Datentypen zulässig:

|

Die Gesichtsmarkierung gibt die folgenden Ergebnisse aus:

|

Konfigurationsoptionen

Diese Aufgabe hat die folgenden Konfigurationsoptionen:

| Option | Beschreibung | Wertebereich | Standardwert |

|---|---|---|---|

running_mode |

Legt den Ausführungsmodus für die Task fest. Es gibt drei Modi: IMAGE: Der Modus für Einzelbildeingaben. VIDEO: Der Modus für decodierte Frames eines Videos. LIVE_STREAM: Der Modus für einen Livestream der Eingabedaten, z. B. von einer Kamera. In diesem Modus muss resultListener aufgerufen werden, um einen Listener einzurichten, der die Ergebnisse asynchron empfängt. |

{IMAGE, VIDEO, LIVE_STREAM} |

IMAGE |

num_faces |

Die maximale Anzahl der Gesichter, die vom FaceLandmarker erkannt werden können. Die Glättung wird nur angewendet, wenn num_faces auf 1 gesetzt ist.

|

Integer > 0 |

1 |

min_face_detection_confidence |

Der minimale Konfidenzwert, damit die Gesichtserkennung als erfolgreich gilt. | Float [0.0,1.0] |

0.5 |

min_face_presence_confidence |

Der minimale Konfidenzwert für die Gesichtserkennung bei der Erkennung von Sehenswürdigkeiten. | Float [0.0,1.0] |

0.5 |

min_tracking_confidence |

Der Mindestkonfidenzwert, der für eine erfolgreiche Gesichtserkennung erforderlich ist. | Float [0.0,1.0] |

0.5 |

output_face_blendshapes |

Legt fest, ob Gesichtsmarkierer Gesichtsverzerrungsformen ausgibt. Gesichtsmischformen werden für das Rendern des 3D-Gesichtsmodells verwendet. | Boolean |

False |

output_facial_transformation_matrixes |

Gibt an, ob FaceLandmarker die Matrix für die Gesichtstransformation ausgibt. FaceLandmarker verwendet die Matrix, um die Gesichtsmerkmale von einem kanonischen Gesichtsmodell in das erkannte Gesicht umzuwandeln, sodass Nutzer Effekte auf erkannte Orientierungspunkte anwenden können. | Boolean |

False |

result_callback |

Legt den Ergebnis-Listener so fest, dass die Landmarker-Ergebnisse asynchron empfangen werden, wenn sich FaceLandmarker im Livestreammodus befindet.

Kann nur verwendet werden, wenn der Laufmodus auf LIVE_STREAM festgelegt ist |

ResultListener |

N/A |

Modelle

Face Landmarker verwendet eine Reihe von Modellen, um Gesichtsmerkmale vorherzusagen. Das erste Modell erkennt Gesichter, ein zweites Modell ermittelt Orientierungspunkte auf den erkannten Gesichtern und ein drittes Modell verwendet diese Orientierungspunkte, um Gesichtsmerkmale und Gesichtsausdrücke zu identifizieren.

Die folgenden Modelle sind in einem herunterladbaren Modell-Bundle verpackt:

- Gesichtserkennungsmodell: Erkennt das Vorhandensein von Gesichtern mit einigen wichtigen Gesichtsmerkmalen.

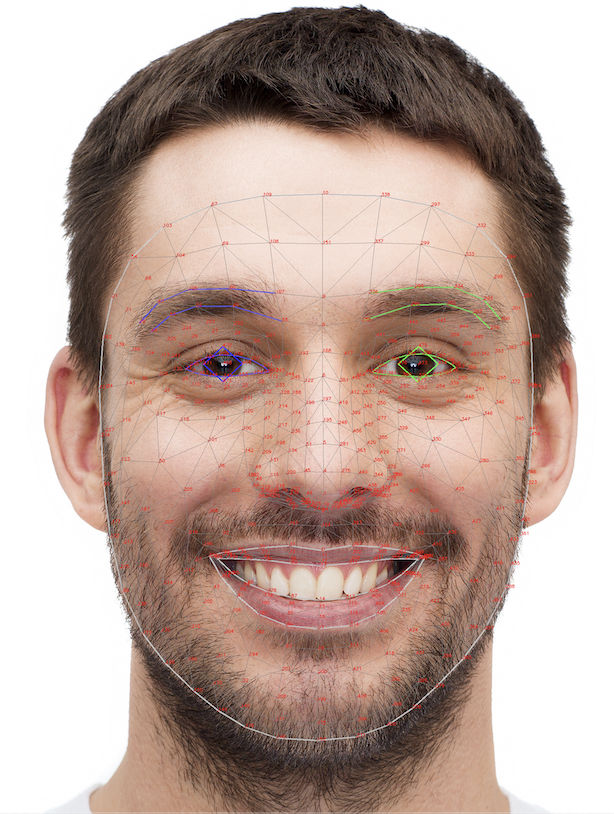

- Face-Mesh-Modell: Damit wird eine vollständige Zuordnung des Gesichts hinzugefügt. Das Modell gibt eine Schätzung von 478 3-dimensionalen Gesichtsmerkmalen aus.

- Blendshape-Vorhersagemodell: Das Modell empfängt 52 Mischformwerte, bei denen es sich um Koeffizienten handelt, die Gesichtsausdrücke darstellen.

Das Gesichtserkennungsmodell ist das BlazeFace-Modell mit kurzer Reichweite, ein schlankes und präzises Gesichtserkennungsmodell, das für GPU-Inferenzen auf Mobilgeräten optimiert ist. Weitere Informationen finden Sie unter Gesichtserkennung.

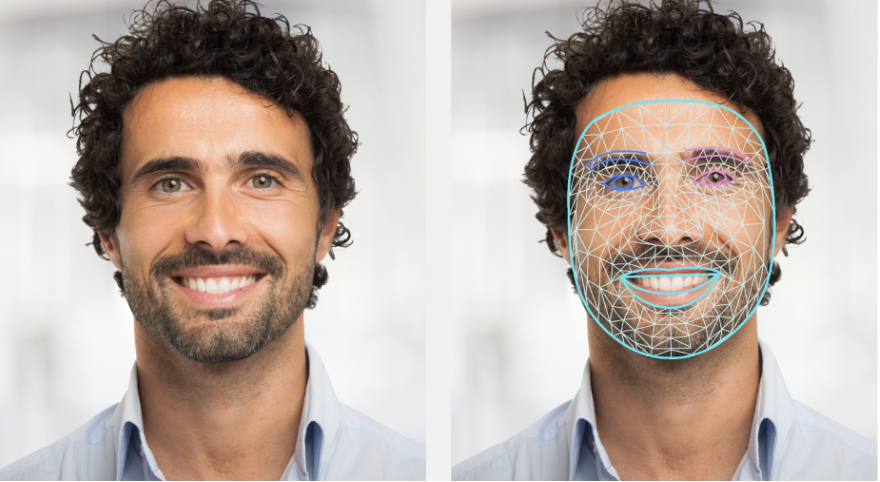

Die folgende Abbildung zeigt eine vollständige Zuordnung der Gesichtsmerkmale aus der Ausgabe des Modell-Bundles.

Eine detailliertere Ansicht der Gesichtsmerkmale finden Sie in der Vollbildansicht.

| Modell-Bundle | Form eingeben | Datentyp | Modellkarten | Versionen |

|---|---|---|---|---|

| FaceLandmarker | FaceDetector: 192 × 192 FaceMesh-V2: 256 × 256 Blendshape: 1 × 146 × 2 |

Gleitkommazahl 16 |

FaceDetector FaceMesh-V2 Blendshape |

Neueste |