המשימה MediaPipe Gesture Recognizer מאפשרת לזהות תנועות ידיים בזמן אמת, ומספקת את התוצאות של תנועות היד שזוהו ואת נקודות הציון של הידיים שזוהו. בהוראות הבאות מוסבר איך להשתמש ב-Gesture Recognizer עם אפליקציות Python.

אתם יכולים לראות את המשימה הזו בפעולה בהדגמה באינטרנט. מידע נוסף על היכולות, המודלים ואפשרויות ההגדרה של המשימה הזו זמין בסקירה הכללית.

קוד לדוגמה

קוד הדוגמה לזיהוי תנועות מספק הטמעה מלאה של המשימה הזו ב-Python, לעיונך. הקוד הזה יעזור לכם לבדוק את המשימה הזו ולהתחיל לפתח מערכת משלכם לזיהוי תנועות ידיים. אתם יכולים להציג, להריץ ולערוך את קוד הדוגמה של ה-Gesture Recognizer רק באמצעות דפדפן האינטרנט.

אם אתם מטמיעים את ה-Gesture Recognizer ל-Raspberry Pi, תוכלו לעיין באפליקציית הדוגמה ל-Raspberry Pi.

הגדרה

בקטע הזה מתוארים השלבים העיקריים להגדרת סביבת הפיתוח ופרויקטי הקוד, במיוחד לשימוש ב-Gesture Recognizer. מידע כללי על הגדרת סביבת הפיתוח לשימוש במשימות של MediaPipe, כולל דרישות לגרסאות הפלטפורמה, זמין במדריך ההגדרה ל-Python.

חבילות

כדי לבצע את המשימה של זיהוי התנועות ב-MediaPipe, צריך את חבילת mediapipe PyPI. אפשר להתקין ולייבא את יחסי התלות האלה באמצעות:

$ python -m pip install mediapipe

יבוא

כדי לגשת לפונקציות של המשימה 'זיהוי תנועות', מייבאים את הכיתות הבאות:

import mediapipe as mp

from mediapipe.tasks import python

from mediapipe.tasks.python import vision

דגם

כדי לבצע את המשימה 'זיהוי תנועות' ב-MediaPipe, צריך חבילה של מודל מאומן שתואמת למשימה הזו. מידע נוסף על המודלים המאומנים הזמינים לזיהוי תנועות זמין בקטע 'מודלים' בסקירה הכללית של המשימה.

בוחרים את המודל ומורידים אותו, ולאחר מכן שומרים אותו בספרייה מקומית:

model_path = '/absolute/path/to/gesture_recognizer.task'

מציינים את הנתיב של המודל בפרמטר Model Name (שם המודל), כפי שמתואר בהמשך:

base_options = BaseOptions(model_asset_path=model_path)

יצירת המשימה

כדי להגדיר את המשימה של MediaPipe Gesture Recognizer, משתמשים בפונקציה create_from_options. הפונקציה create_from_options מקבלת ערכים של אפשרויות תצורה לטיפול. מידע נוסף על אפשרויות ההגדרה זמין במאמר אפשרויות הגדרה.

הקוד הבא מראה איך ליצור את המשימה הזו ולהגדיר אותה.

הדוגמאות האלה גם מציגות את הווריאציות של בניית המשימות לתמונות, לקובצי וידאו ולשידורי וידאו חיים.

תמונה

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions GestureRecognizer = mp.tasks.vision.GestureRecognizer GestureRecognizerOptions = mp.tasks.vision.GestureRecognizerOptions VisionRunningMode = mp.tasks.vision.RunningMode # Create a gesture recognizer instance with the image mode: options = GestureRecognizerOptions( base_options=BaseOptions(model_asset_path='/path/to/model.task'), running_mode=VisionRunningMode.IMAGE) with GestureRecognizer.create_from_options(options) as recognizer: # The detector is initialized. Use it here. # ...

וידאו

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions GestureRecognizer = mp.tasks.vision.GestureRecognizer GestureRecognizerOptions = mp.tasks.vision.GestureRecognizerOptions VisionRunningMode = mp.tasks.vision.RunningMode # Create a gesture recognizer instance with the video mode: options = GestureRecognizerOptions( base_options=BaseOptions(model_asset_path='/path/to/model.task'), running_mode=VisionRunningMode.VIDEO) with GestureRecognizer.create_from_options(options) as recognizer: # The detector is initialized. Use it here. # ...

שידור חי

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions GestureRecognizer = mp.tasks.vision.GestureRecognizer GestureRecognizerOptions = mp.tasks.vision.GestureRecognizerOptions GestureRecognizerResult = mp.tasks.vision.GestureRecognizerResult VisionRunningMode = mp.tasks.vision.RunningMode # Create a gesture recognizer instance with the live stream mode: def print_result(result: GestureRecognizerResult, output_image: mp.Image, timestamp_ms: int): print('gesture recognition result: {}'.format(result)) options = GestureRecognizerOptions( base_options=BaseOptions(model_asset_path='/path/to/model.task'), running_mode=VisionRunningMode.LIVE_STREAM, result_callback=print_result) with GestureRecognizer.create_from_options(options) as recognizer: # The detector is initialized. Use it here. # ...

אפשרויות הגדרה

למשימה הזו יש את אפשרויות התצורה הבאות לאפליקציות Python:

| שם האפשרות | תיאור | טווח ערכים | ערך ברירת מחדל | |

|---|---|---|---|---|

running_mode |

הגדרת מצב ההפעלה של המשימה. יש שלושה מצבים: IMAGE: המצב להזנת תמונה אחת. VIDEO: המצב של פריימים מפוענחים של סרטון. LIVE_STREAM: המצב של סטרימינג בשידור חי של נתוני קלט, למשל ממצלמה. במצב הזה, צריך להפעיל את resultListener כדי להגדיר מאזין שיקבל את התוצאות באופן אסינכרוני. |

{IMAGE, VIDEO, LIVE_STREAM} |

IMAGE |

|

num_hands |

המספר המקסימלי של ידיים שאפשר לזהות באמצעות GestureRecognizer הוא 10.

|

Any integer > 0 |

1 |

|

min_hand_detection_confidence |

ציון האמון המינימלי שדרוש כדי שזיהוי היד ייחשב מוצלח במודל לזיהוי כף היד. | 0.0 - 1.0 |

0.5 |

|

min_hand_presence_confidence |

דירוג הוודאות המינימלי של נוכחות היד במודל לזיהוי ציוני ציון של נקודות ציון בכף היד. במצב וידאו ובמצב שידור חי של זיהוי התנועות, אם ציון הוודאות לנוכחות היד ממודל ציוני הנקודות המאפיינות של היד נמוך מהסף הזה, מופעלת הפעלה של מודל זיהוי כף היד. אחרת, נעשה שימוש באלגוריתם מעקב קל אחרי הידיים כדי לקבוע את המיקום שלהן לצורך זיהוי של נקודות ציון בהמשך. | 0.0 - 1.0 |

0.5 |

|

min_tracking_confidence |

דירוג האמון המינימלי שדרוש כדי שהמעקב אחר הידיים יחשב כהצלחה. זהו סף IoU של תיבת ההיקף בין הידיים בפריים הנוכחי לבין הפריים האחרון. במצב וידאו ובמצב סטרימינג של הכלי לזיהוי תנועות, אם המעקב נכשל, הכלי לזיהוי תנועות מפעיל זיהוי ידיים. אחרת, תהליך זיהוי היד ינוข้าม. | 0.0 - 1.0 |

0.5 |

|

canned_gestures_classifier_options |

אפשרויות להגדרת ההתנהגות של הסיווג של תנועות מוכנות מראש. התנועות המוגדרות מראש הן ["None", "Closed_Fist", "Open_Palm", "Pointing_Up", "Thumb_Down", "Thumb_Up", "Victory", "ILoveYou"] |

|

|

|

custom_gestures_classifier_options |

אפשרויות להגדרת ההתנהגות של הסיווג של התנועות בהתאמה אישית. |

|

|

|

result_callback |

מגדיר את מאזין התוצאות לקבל את תוצאות הסיווג באופן אסינכרוני כשמתבצע זיהוי תנועות במצב של שידור חי.

אפשר להשתמש בה רק כשמצב ההפעלה מוגדר כ-LIVE_STREAM |

ResultListener |

לא רלוונטי | לא רלוונטי |

הכנת הנתונים

מכינים את הקלט כקובץ תמונה או כמערך numpy, ואז ממירים אותו לאובייקט mediapipe.Image. אם הקלט הוא קובץ וידאו או שידור חי ממצלמת אינטרנט, אפשר להשתמש בספרייה חיצונית כמו OpenCV כדי לטעון את הפריימים של הקלט כמערכי numpy.

תמונה

import mediapipe as mp # Load the input image from an image file. mp_image = mp.Image.create_from_file('/path/to/image') # Load the input image from a numpy array. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_image)

וידאו

import mediapipe as mp # Use OpenCV’s VideoCapture to load the input video. # Load the frame rate of the video using OpenCV’s CV_CAP_PROP_FPS # You’ll need it to calculate the timestamp for each frame. # Loop through each frame in the video using VideoCapture#read() # Convert the frame received from OpenCV to a MediaPipe’s Image object. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_frame_from_opencv)

שידור חי

import mediapipe as mp # Use OpenCV’s VideoCapture to start capturing from the webcam. # Create a loop to read the latest frame from the camera using VideoCapture#read() # Convert the frame received from OpenCV to a MediaPipe’s Image object. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_frame_from_opencv)

הרצת המשימה

הכלי לזיהוי תנועות משתמש בפונקציות recognize, recognize_for_video ו-recognize_async כדי להפעיל מסקנות. בתהליך זיהוי התנועות, המערכת מבצעת עיבוד מקדים של נתוני הקלט, זיהוי של הידיים בתמונה, זיהוי של נקודות ציון בידיים וזיהוי של תנועות הידיים על סמך נקודות הציון.

הקוד הבא מראה איך לבצע את העיבוד באמצעות מודל המשימה.

תמונה

# Perform gesture recognition on the provided single image. # The gesture recognizer must be created with the image mode. gesture_recognition_result = recognizer.recognize(mp_image)

וידאו

# Perform gesture recognition on the provided single image. # The gesture recognizer must be created with the video mode. gesture_recognition_result = recognizer.recognize_for_video(mp_image, frame_timestamp_ms)

שידור חי

# Send live image data to perform gesture recognition. # The results are accessible via the `result_callback` provided in # the `GestureRecognizerOptions` object. # The gesture recognizer must be created with the live stream mode. recognizer.recognize_async(mp_image, frame_timestamp_ms)

שימו לב לנקודות הבאות:

- כשמריצים את הקוד במצב וידאו או במצב של שידור חי, צריך לספק למשימות של זיהוי התנועות גם את חותמת הזמן של פריים הקלט.

- כשהיא פועלת במודל התמונה או הסרטון, המשימה 'זיהוי תנועות' תמנע את המשך הפעילות של השרשור הנוכחי עד שהיא תסיים לעבד את התמונה או את הפריים של הקלט.

- כשהיא פועלת במצב של שידור חי, המשימה של זיהוי התנועות לא חוסמת את השרשור הנוכחי אלא חוזרת מיד. הוא יפעיל את מאזין התוצאות שלו עם תוצאת הזיהוי בכל פעם שהוא יסיים לעבד פריים קלט. אם פונקציית הזיהוי נקראת כשמשימה של זיהוי תנועות עסוקה בעיבוד של פריים אחר, המשימה תתעלם מפריים הקלט החדש.

דוגמה מלאה להפעלת מערכת זיהוי תנועות בתמונה מפורטת בדוגמת הקוד.

טיפול בתוצאות והצגתן

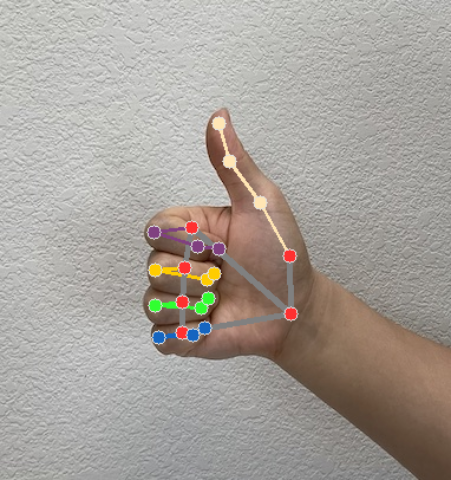

הכלי לזיהוי תנועות יוצר אובייקט של תוצאת זיהוי תנועה לכל הפעלה של הזיהוי. אובייקט התוצאה מכיל ציוני דרך של היד בקואורדינטות התמונה, ציוני דרך של היד בקואורדינטות העולם, צד היד(יד ימין/יד שמאל) וקטגוריות של תנועות היד של הידיים שזוהו.

בהמשך מוצגת דוגמה לנתוני הפלט של המשימה הזו:

הערך שמתקבל ב-GestureRecognizerResult מכיל ארבעה רכיבים, וכל רכיב הוא מערך, שבו כל רכיב מכיל את התוצאה שזוהתה של יד אחת שזוהתה.

יד דומיננטית

היד הדומיננטית מייצגת אם הידיים שזוהו הן יד שמאל או יד ימין.

תנועות

קטגוריות התנועות שזוהו של הידיים שזוהו.

ציוני דרך

יש 21 נקודות ציון ביד, כל אחת מורכבת מהקואורדינטות

x, yו-z. הקואורדינטותxו-yמתכווננות לטווח [0.0, 1.0] לפי רוחב התמונה וגובהה, בהתאמה. הקואורדינטהzמייצגת את עומק ציון הדרך, כאשר עומק פרק כף היד הוא המקור. ככל שהערך קטן יותר, כך ציון הדרך קרוב יותר למצלמה. הערך שלzמשתמש בערך באותו סולם כמוx.אתרים חשובים בעולם

21 נקודות הציון של היד מוצגות גם בקואורדינטות גלובליות. כל ציון דרך מורכב מ-

x, yו-z, שמייצגים קואורדינטות תלת-ממדיות בעולם האמיתי במטרים, כאשר המקור נמצא במרכז הגיאומטרי של היד.

GestureRecognizerResult:

Handedness:

Categories #0:

index : 0

score : 0.98396

categoryName : Left

Gestures:

Categories #0:

score : 0.76893

categoryName : Thumb_Up

Landmarks:

Landmark #0:

x : 0.638852

y : 0.671197

z : -3.41E-7

Landmark #1:

x : 0.634599

y : 0.536441

z : -0.06984

... (21 landmarks for a hand)

WorldLandmarks:

Landmark #0:

x : 0.067485

y : 0.031084

z : 0.055223

Landmark #1:

x : 0.063209

y : -0.00382

z : 0.020920

... (21 world landmarks for a hand)

בתמונות הבאות מוצגת תצוגה חזותית של הפלט של המשימה:

בקוד לדוגמה של Gesture Recognizer מוסבר איך להציג את תוצאות הזיהוי שהוחזרו מהמשימה. פרטים נוספים זמינים בקוד לדוגמה.