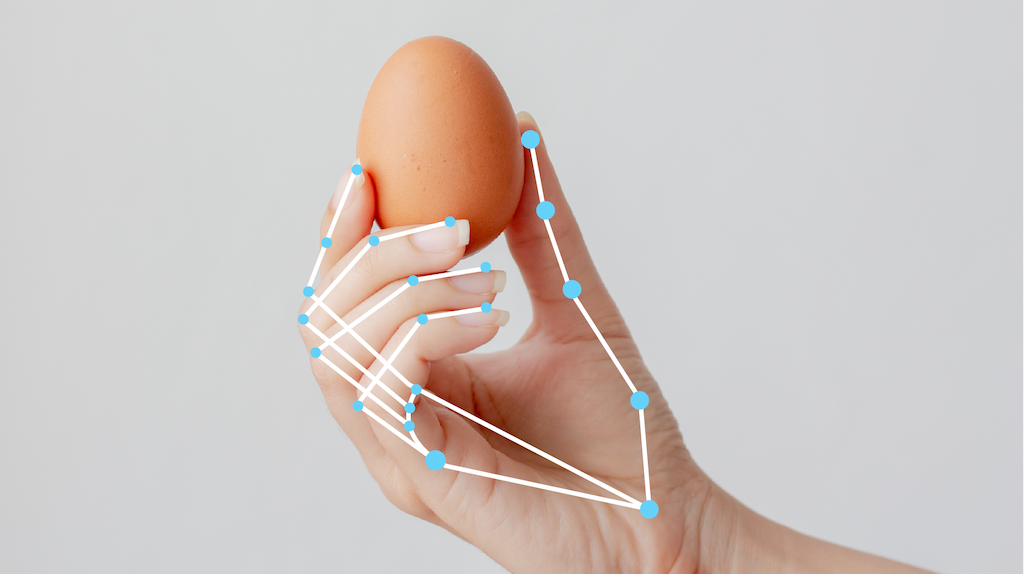

تتيح لك مهمة "وضع علامات على أيدي الأشخاص" من MediaPipe رصد معالم الأيدي في الصورة. يمكنك استخدام هذه المهمة لتحديد مواضع النقاط الرئيسية لليدين وعرض تأثيرات مرئية عليها. تعمل هذه المهمة على بيانات الصور باستخدام نموذج تعلُّم الآلة (ML) كข้อมูล static أو بث مستمر، وتُخرج معالم اليد في إحداثيات الصورة ومعالم اليد في إحداثيات العالم وتحديد اليد(اليد اليسرى/اليمنى) لعدة أيدي تم رصدها.

البدء

ابدأ استخدام هذه المهمة باتّباع أحد أدلة التنفيذ هذه ل منصّتك المستهدفة. ترشدك هذه الأدلة الخاصة بالنظام الأساسي إلى تنفيذ أساسي لهذه المهمة، بما في ذلك نموذج مقترَح ومثال على الرمز المبرمَج مع خيارات الإعداد المقترَحة:

- Android - مثال على رمز برمجي

- Python - مثال على رمز

- الويب - مثال على الرمز البرمجي - الدليل

تفاصيل المهمة

يصف هذا القسم ميزات هذه المهمة ومدخلاتها ومخرجاتها وخيارات الضبط.

الميزات

- معالجة الصور المُدخلة: تشمل المعالجة تدوير الصور وتغيير حجمها وتسويتها وتحويل مساحة الألوان.

- الحدّ الأدنى للنتيجة: فلترة النتائج استنادًا إلى نتائج التوقّعات

| مدخلات المهام | نتائج المهام |

|---|---|

يقبل "مُحدِّد معالم اليد" إدخال أحد أنواع البيانات التالية:

|

يعرض "مُحدِّد معالم اليد" النتائج التالية:

|

خيارات الإعدادات

تتضمّن هذه المهمة خيارات الضبط التالية:

| اسم الخيار | الوصف | نطاق القيمة | القيمة التلقائية |

|---|---|---|---|

running_mode |

لضبط وضع التشغيل للمهمة هناك ثلاثة

أوضاع: IMAGE: وضع الإدخالات باستخدام صورة واحدة. VIDEO: وضع الإطارات التي تم فك ترميزها في الفيديو LIVE_STREAM: وضع البث المباشر لبيانات الإدخال ، مثل بيانات الكاميرا في هذا الوضع، يجب استدعاء resultListener لإعداد مستمع لتلقّي النتائج بشكل غير متزامن. |

{IMAGE, VIDEO, LIVE_STREAM} |

IMAGE |

num_hands |

الحد الأقصى لعدد الأيدي التي يرصدها "كاشف معالم اليد" | Any integer > 0 |

1 |

min_hand_detection_confidence |

الحد الأدنى لنتيجة الثقة لرصد اليد ليكون ناجحًا في نموذج رصد راحة اليد | 0.0 - 1.0 |

0.5 |

min_hand_presence_confidence |

الحد الأدنى لنتيجة الثقة لنتيجة توفُّر اليد في نموذج رصد معالم اليد في وضع "الفيديو" ووضع "البث المباشر"، إذا كانت نتيجة الثقة في توفّر اليد من نموذج معالِم اليد أقل من هذا الحدّ الأدنى، يشغِّل "معالِم اليد" نموذج "اكتشاف راحة اليد". بخلاف ذلك، تحدِّد خوارزمية تتبُّع اليدين الخفيفة وزنًا موقع اليدَين لرصد المعالم اللاحقة. | 0.0 - 1.0 |

0.5 |

min_tracking_confidence |

الحد الأدنى لنتيجة الثقة ليعتبر تتبع اليد ناجحًا هذا هو الحدّ الأدنى لمقياس IoU للحدود المربّعة بين اليدين في الإطار الحالي والإطار الأخير. في وضعَي "الفيديو" و"البث" في "أداة وضع علامات على أيدي المستخدمين"، إذا تعذّر التتبّع، تبدأ أداة وضع علامات على أيدي المستخدمين في رصد اليد. وفي حال عدم توفّر هذه البيانات، يتم تخطي ميزة "رصد اليد". | 0.0 - 1.0 |

0.5 |

result_callback |

ضبط مستمع النتائج لتلقّي نتائج رصد العناصر

بشكل غير متزامن عندما يكون علامة موضع اليد في وضع البث المباشر

لا ينطبق ذلك إلا عند ضبط وضع التشغيل على LIVE_STREAM |

لا ينطبق | لا ينطبق |

النماذج

يستخدم "أداة وضع علامات على أجزاء اليد" حِزمة نماذج تتضمّن نموذجَين مُعَلَّبَين: نموذج رصد راحة اليد ونموذج رصد معالِم اليد. تحتاج إلى حِزمة نماذج تحتوي على هذين النموذجَين لتشغيل هذه المهمة.

| اسم الطراز | شكل الإدخال | نوع التقريب | بطاقة النموذج | الإصدارات |

|---|---|---|---|---|

| HandLandmarker (full) | 192 x 192، 224 x 224 | float 16 | info | الأحدث |

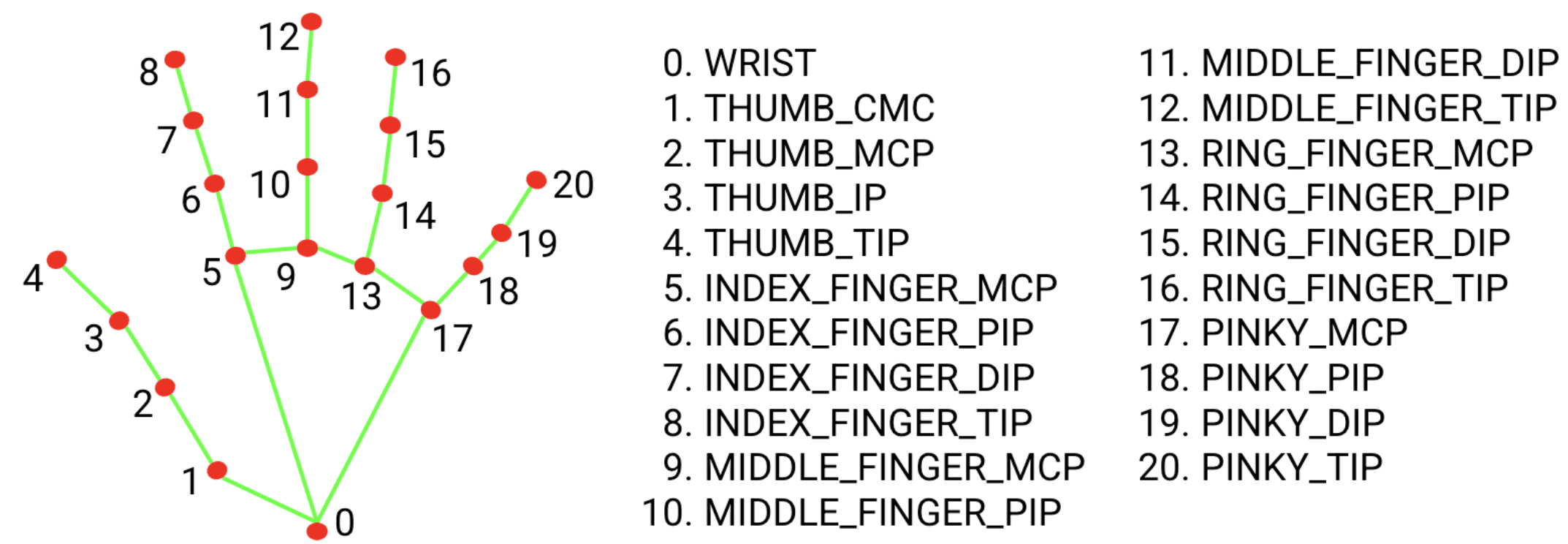

ترصد حِزمة نماذج معالم اليد مواقع نقاط 21 إحداثية مفاصل اليد ضمن مناطق اليد التي تم رصدها. تم تدريب النموذج على 30 ألف صورة تقريبًا من الواقع، بالإضافة إلى العديد من نماذج اليدين الاصطناعية المعروضة على خلفيات مختلفة.

تحتوي حِزمة نماذج علامات النقاط على اليد على نموذج لرصد راحة اليد ونموذج لرصد علامات النقاط على اليد. يحدِّد نموذج رصد راحة اليد مواضع الأيدي في الصورة المُدخلة، ويحدِّد نموذج رصد معالِم اليد معالِم يد معيّنة في صورة اليد المقتطعة التي حدَّدها نموذج رصد راحة اليد.

بما أنّ تشغيل نموذج رصد راحة اليد يستغرق وقتًا طويلاً، يستخدم "أداة وضع علامات على أجزاء اليد" مربّع الحدود الذي يحدّده نموذج علامات اليد في إطار واحد لتحديد منطقة اليدين في اللقطات التالية، وذلك عند تشغيل الفيديو أو البث المباشر. لا يُعيد نظام "وضع علامات على أجزاء اليد" تنشيط نموذج "التعرّف على راحة اليد" إلا إذا لم يعُد نموذج "وضع علامات على أجزاء اليد" يرصد وجود الأيدي أو تعذّر عليه تتبُّع الأيدي ضمن اللقطة. ويؤدي ذلك إلى تقليل عدد المرات التي يشغِّل فيها "مُحدِّد معالم اليد" نموذج رصد راحة اليد.

مقاييس أداء المهام

في ما يلي مقاييس أداء المهام لعملية المعالجة بأكملها استنادًا إلى نماذج التدريب المُسبَق أعلاه. نتيجة وقت الاستجابة هي متوسط وقت الاستجابة على هاتف Pixel 6 باستخدام وحدة المعالجة المركزية (CPU) أو وحدة معالجة الرسومات (GPU).

| اسم النموذج | وقت استجابة وحدة المعالجة المركزية | وقت استجابة وحدة معالجة الرسومات |

|---|---|---|

| HandLandmarker (full) | 17.12 ملي ثانية | 12.27 ملي ثانية |