Tugas Pendeteksi Objek memungkinkan Anda mendeteksi kehadiran dan lokasi beberapa class objek. Misalnya, pendeteksi objek dapat menemukan dalam gambar. Petunjuk ini menunjukkan cara menggunakan tugas Pendeteksi Objek di Android. Contoh kode yang dijelaskan dalam petunjuk ini tersedia di GitHub. Anda dapat melihat cara kerja tugas ini dengan melihat Demo web ini. Untuk informasi selengkapnya tentang kemampuan, model, dan opsi konfigurasi tugas ini, lihat Ringkasan.

Contoh kode

Kode contoh MediaPipe Tasks adalah implementasi sederhana dari aplikasi Object Detector untuk Android. Contoh ini menggunakan kamera di perangkat Android fisik untuk terus mendeteksi objek, dan juga dapat menggunakan gambar dan video dari galeri perangkat untuk mendeteksi objek secara statis.

Anda dapat menggunakan aplikasi ini sebagai titik awal untuk aplikasi Android Anda sendiri, atau merujuknya saat mengubah aplikasi yang ada. Kode contoh Detektor Objek dihosting di GitHub.

Mendownload kode

Petunjuk berikut menunjukkan cara membuat salinan lokal contoh kode menggunakan alat command line git.

Untuk mendownload kode contoh:

- Clone repositori git menggunakan perintah berikut:

git clone https://github.com/google-ai-edge/mediapipe-samples

- Secara opsional, konfigurasikan instance git Anda untuk menggunakan checkout jarang,

sehingga Anda hanya memiliki file untuk aplikasi contoh Object Detector:

cd mediapipe-samples git sparse-checkout init --cone git sparse-checkout set examples/object_detection/android

Setelah membuat versi lokal kode contoh, Anda dapat mengimpor project ke Android Studio dan menjalankan aplikasi. Untuk mendapatkan petunjuk, lihat Panduan Penyiapan untuk Android.

Komponen utama

File berikut berisi kode penting untuk aplikasi contoh Object Detector:

- ObjectDetectorHelper.kt - Menginisialisasi detektor objek dan menangani model serta pemilihan delegasi

- MainActivity.kt - Mengimplementasikan aplikasi dan menyusun komponen antarmuka pengguna

- OverlayView.kt - Menangani dan menampilkan hasil

Penyiapan

Bagian ini menjelaskan langkah-langkah utama untuk menyiapkan lingkungan pengembangan dan project kode untuk menggunakan Object Detector. Untuk informasi umum tentang menyiapkan lingkungan pengembangan untuk menggunakan tugas MediaPipe, termasuk persyaratan versi platform, lihat Panduan penyiapan untuk Android.

Dependensi

Detektor Objek menggunakan library com.google.mediapipe:tasks-vision. Tambahkan dependensi

ini ke file build.gradle

project pengembangan aplikasi Android Anda. Impor dependensi yang diperlukan dengan

kode berikut:

dependencies {

implementation 'com.google.mediapipe:tasks-vision:latest.release'

}

Model

Tugas MediaPipe Object Detector memerlukan model terlatih yang kompatibel dengan tugas ini. Untuk mengetahui informasi selengkapnya tentang model terlatih yang tersedia untuk Object Detector, lihat bagian Model ringkasan tugas.

Pilih dan download model, lalu simpan dalam direktori project Anda:

<dev-project-root>/src/main/assets

Gunakan metode BaseOptions.Builder.setModelAssetPath() untuk menentukan jalur

yang digunakan oleh model. Untuk contoh kode, lihat bagian berikutnya.

Membuat tugas

Anda dapat menggunakan fungsi createFromOptions untuk membuat tugas. Fungsi

createFromOptions menerima opsi konfigurasi termasuk mode

berjalan, lokalitas nama tampilan, jumlah maksimum hasil, nilai minimum keyakinan,

daftar yang diizinkan dan ditolak kategori. Jika opsi konfigurasi tidak ditentukan, nilai default akan digunakan. Untuk informasi selengkapnya tentang opsi konfigurasi,

lihat Ringkasan Konfigurasi.

Tugas Pendeteksi Objek mendukung 3 jenis data input: gambar diam, file video, dan streaming video live. Anda harus menentukan mode operasi yang sesuai dengan jenis data input saat membuat tugas. Pilih tab yang sesuai dengan jenis data input Anda untuk melihat cara membuat tugas dan menjalankan inferensi.

Gambar

ObjectDetectorOptions options =

ObjectDetectorOptions.builder()

.setBaseOptions(BaseOptions.builder().setModelAssetPath(‘model.tflite’).build())

.setRunningMode(RunningMode.IMAGE)

.setMaxResults(5)

.build();

objectDetector = ObjectDetector.createFromOptions(context, options);

Video

ObjectDetectorOptions options =

ObjectDetectorOptions.builder()

.setBaseOptions(BaseOptions.builder().setModelAssetPath(‘model.tflite’).build())

.setRunningMode(RunningMode.VIDEO)

.setMaxResults(5)

.build();

objectDetector = ObjectDetector.createFromOptions(context, options);

Live stream

ObjectDetectorOptions options = ObjectDetectorOptions.builder() .setBaseOptions(BaseOptions.builder().setModelAssetPath(‘model.tflite’).build()) .setRunningMode(RunningMode.LIVE_STREAM) .setMaxResults(5) .setResultListener((result, inputImage) -> { // Process the detection result here. }) .setErrorListener((result, inputImage) -> { // Process the classification errors here. }) .build(); objectDetector = ObjectDetector.createFromOptions(context, options);

Implementasi kode contoh Pendeteksi Objek memungkinkan pengguna beralih antara

mode pemrosesan. Pendekatan ini membuat kode pembuatan tugas menjadi lebih rumit dan

mungkin tidak sesuai untuk kasus penggunaan Anda. Anda dapat melihat kode ini di

fungsi setupObjectDetector() class

ObjectDetectorHelper.

Opsi konfigurasi

Tugas ini memiliki opsi konfigurasi berikut untuk aplikasi Android:

| Nama Opsi | Deskripsi | Rentang Nilai | Nilai Default |

|---|---|---|---|

runningMode |

Menetapkan mode berjalan untuk tugas. Ada tiga

mode: GAMBAR: Mode untuk input gambar tunggal. VIDEO: Mode untuk frame video yang didekode. LIVE_STREAM: Mode untuk live stream data input, seperti dari kamera. Dalam mode ini, resultListener harus dipanggil untuk menyiapkan pemroses guna menerima hasil secara asinkron. |

{IMAGE, VIDEO, LIVE_STREAM} |

IMAGE |

displayNamesLocales |

Menetapkan bahasa label yang akan digunakan untuk nama tampilan yang diberikan dalam

metadata model tugas, jika tersedia. Default-nya adalah en untuk

bahasa Inggris. Anda dapat menambahkan label yang dilokalkan ke metadata model kustom

menggunakan TensorFlow Lite Metadata Writer API

|

Kode lokalitas | id |

maxResults |

Menetapkan jumlah maksimum opsional hasil deteksi dengan skor tertinggi yang akan ditampilkan. | Angka positif apa pun | -1 (semua hasil ditampilkan) |

scoreThreshold |

Menetapkan nilai minimum skor prediksi yang menggantikan nilai yang diberikan dalam metadata model (jika ada). Hasil di bawah nilai ini akan ditolak. | Semua float | Tidak ditetapkan |

categoryAllowlist |

Menetapkan daftar opsional nama kategori yang diizinkan. Jika tidak kosong,

hasil deteksi yang nama kategorinya tidak ada dalam kumpulan ini akan

difilter. Nama kategori duplikat atau tidak dikenal akan diabaikan.

Opsi ini saling eksklusif dengan categoryDenylist dan menggunakan

keduanya akan menghasilkan error. |

String apa pun | Tidak ditetapkan |

categoryDenylist |

Menetapkan daftar opsional nama kategori yang tidak diizinkan. Jika

tidak kosong, hasil deteksi yang nama kategorinya ada dalam set ini akan difilter

keluar. Nama kategori duplikat atau tidak dikenal akan diabaikan. Opsi ini saling

eksklusif dengan categoryAllowlist dan menggunakan keduanya akan menyebabkan error. |

String apa pun | Tidak ditetapkan |

resultListener |

Menetapkan pemroses hasil untuk menerima hasil deteksi secara asinkron saat detektor objek berada dalam mode live stream. Anda hanya dapat menggunakan opsi ini jika menetapkan runningMode ke LIVE_STREAM. | Tidak berlaku | Tidak ditetapkan |

Menyiapkan data

Anda perlu mengonversi gambar atau frame input menjadi objek com.google.mediapipe.framework.image.MPImage sebelum meneruskannya ke Pendeteksi Objek.

Contoh berikut menjelaskan dan menunjukkan cara menyiapkan data untuk diproses untuk setiap jenis data yang tersedia:

Gambar

import com.google.mediapipe.framework.image.BitmapImageBuilder; import com.google.mediapipe.framework.image.MPImage; // Load an image on the user’s device as a Bitmap object using BitmapFactory. // Convert an Android’s Bitmap object to a MediaPipe’s Image object. Image mpImage = new BitmapImageBuilder(bitmap).build();

Video

import com.google.mediapipe.framework.image.BitmapImageBuilder; import com.google.mediapipe.framework.image.MPImage; // Load a video file on the user's device using MediaMetadataRetriever // From the video’s metadata, load the METADATA_KEY_DURATION and // METADATA_KEY_VIDEO_FRAME_COUNT values. Use these values // to calculate the timestamp of each frame later. // Loop through the video and load each frame as a Bitmap object. // Convert the Android’s Bitmap object to a MediaPipe’s Image object. Image mpImage = new BitmapImageBuilder(frame).build();

Live stream

import com.google.mediapipe.framework.image.MediaImageBuilder; import com.google.mediapipe.framework.image.MPImage; // Create a CameraX’s ImageAnalysis to continuously receive frames // from the device’s camera. Configure it to output frames in RGBA_8888 // format to match with what is required by the model. // For each Android’s ImageProxy object received from the ImageAnalysis, // extract the encapsulated Android’s Image object and convert it to // a MediaPipe’s Image object. android.media.Image mediaImage = imageProxy.getImage() MPImage mpImage = new MediaImageBuilder(mediaImage).build();

Dalam kode contoh Pendeteksi Objek, persiapan data ditangani di class ObjectDetectorHelper dalam fungsi detectImage(), detectVideoFile(), detectLivestreamFrame().

Menjalankan tugas

Bergantung pada jenis data yang Anda gunakan, gunakan

metode ObjectDetector.detect...() yang khusus untuk jenis data tersebut. Gunakan

detect() untuk setiap gambar,

detectForVideo() untuk frame dalam file video, dan

detectAsync() untuk streaming video. Saat Anda melakukan deteksi pada

streaming video, pastikan Anda menjalankan deteksi pada thread terpisah untuk menghindari

pemblokiran thread antarmuka pengguna.

Contoh kode berikut menunjukkan contoh sederhana cara menjalankan Pendeteksi Objek dalam berbagai mode data ini:

Gambar

ObjectDetectorResult detectionResult = objectDetector.detect(image);

Video

// Calculate the timestamp in milliseconds of the current frame. long frame_timestamp_ms = 1000 * video_duration * frame_index / frame_count; // Run inference on the frame. ObjectDetectorResult detectionResult = objectDetector.detectForVideo(image, frameTimestampMs);

Live stream

// Run inference on the frame. The detection results will be available // via the `resultListener` provided in the `ObjectDetectorOptions` when // the object detector was created. objectDetector.detectAsync(image, frameTimestampMs);

Contoh kode Detektor Objek menunjukkan implementasi setiap mode

ini secara lebih mendetail

detect(),

detectVideoFile(),

dan detectAsync().

Kode contoh memungkinkan pengguna beralih di antara mode pemrosesan

yang mungkin tidak diperlukan untuk kasus penggunaan Anda.

Perhatikan hal berikut:

- Saat berjalan dalam mode video atau mode live stream, Anda juga harus memberikan stempel waktu frame input ke tugas Object Detector.

- Saat berjalan dalam mode gambar atau video, tugas Object Detector akan memblokir thread saat ini hingga selesai memproses gambar atau frame input. Untuk menghindari pemblokiran thread saat ini, jalankan pemrosesan di thread latar belakang.

- Saat berjalan dalam mode live stream, tugas Object Detector tidak memblokir thread saat ini, tetapi segera ditampilkan. Fungsi ini akan memanggil pemroses hasil dengan hasil deteksi setiap kali selesai memproses frame input. Jika fungsi deteksi dipanggil saat tugas Object Detector sibuk memproses frame lain, frame input baru akan diabaikan.

Menangani dan menampilkan hasil

Setelah menjalankan inferensi, tugas Pendeteksi Objek akan menampilkan

objek ObjectDetectorResult yang menjelaskan objek yang telah ditemukan dalam

gambar input.

Berikut adalah contoh data output dari tugas ini:

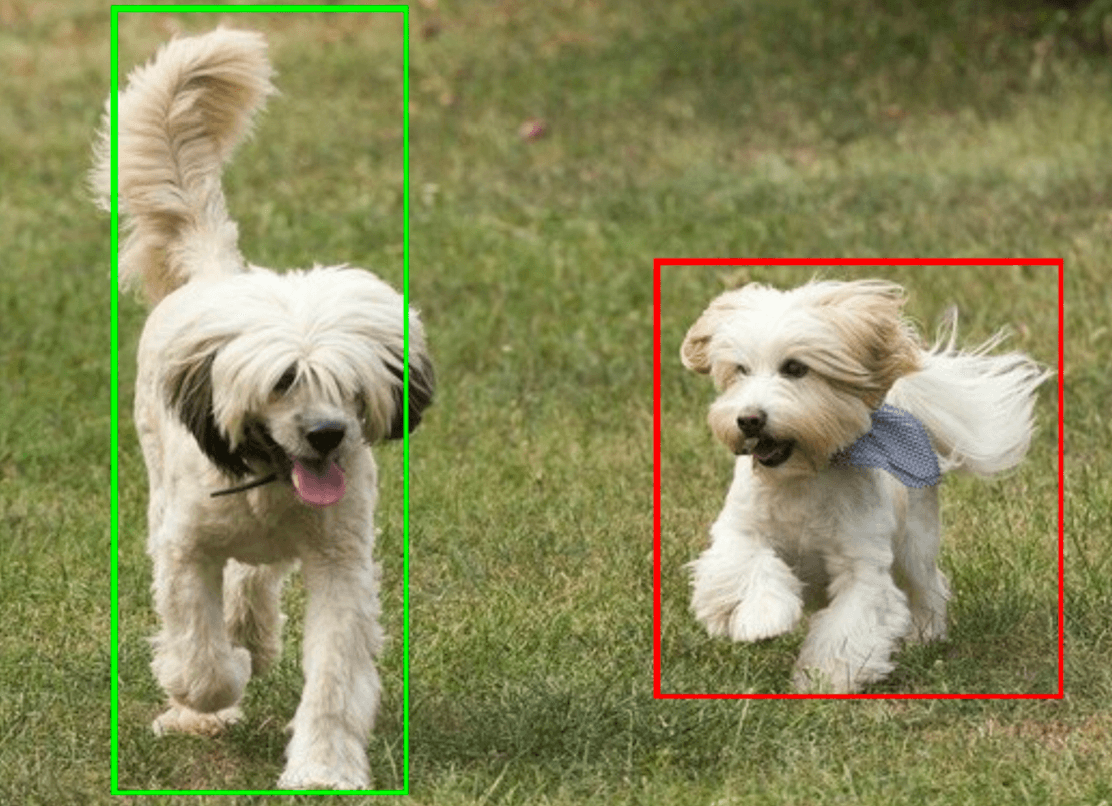

ObjectDetectorResult:

Detection #0:

Box: (x: 355, y: 133, w: 190, h: 206)

Categories:

index : 17

score : 0.73828

class name : dog

Detection #1:

Box: (x: 103, y: 15, w: 138, h: 369)

Categories:

index : 17

score : 0.73047

class name : dog

Gambar berikut menunjukkan visualisasi output tugas:

Kode contoh Pendeteksi Objek menunjukkan cara menampilkan hasil

deteksi yang ditampilkan dari tugas, lihat

class

OverlayView untuk mengetahui detail selengkapnya.