Gemini モデル ファミリーの最小バージョンである Gemini Nano は、Google Pixel 8 Pro や Samsung S24 シリーズ以降の対応 Android デバイスでオンデバイスで実行できます。

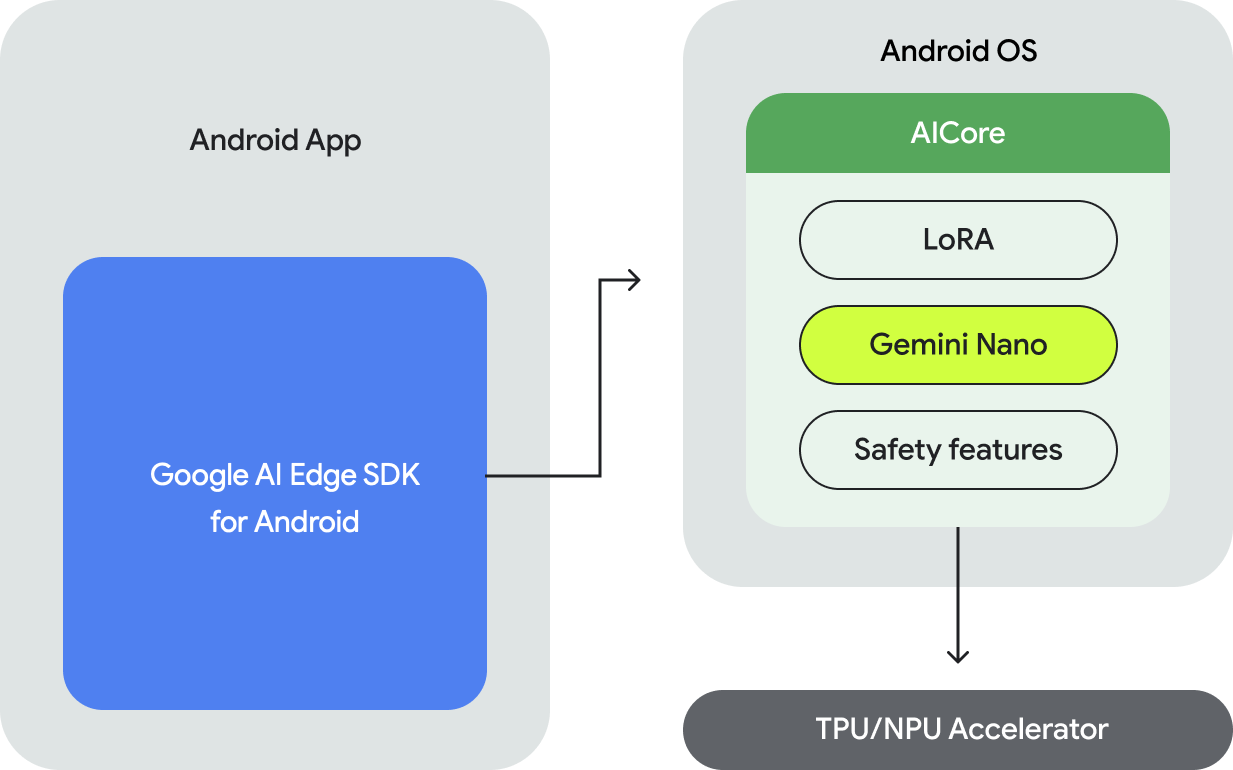

Android で Gemini Nano モデルを実行するには、Google AI Edge SDK for Android を使用する必要があります。この SDK には、次の API が用意されています。

- 基盤となる Android 搭載デバイスがサポートされているかどうかを確認します。

- Gemini Nano モデルにアクセスできます。

- 安全性設定を調整する。

- 高パフォーマンスで推論を実行し、フォールバックを実装する。

- 必要に応じて、LoRA ファインチューニング ブロックを指定して、ユースケースのモデルのパフォーマンスを改善します。

Gemini Nano にアクセスする API はテキストからテキストへのモダリティをサポートしており、今後さらに多くのモダリティがサポートされる予定です。

デバイス上での実行のメリット

デバイス上の実行により、次のことが可能になります。

- 機密データのローカル処理: データをローカルで処理すると、ユーザーデータをクラウドに送信する必要がなくなります。これは、エンドツーエンドの暗号化を備えたメッセージ アプリなど、機密データを処理するアプリにとって重要です。

- オフライン アクセス: インターネットに接続していなくても、AI 機能にアクセスできます。これは、オフラインまたは接続が不安定な環境で動作する必要があるアプリケーションに役立ちます。

- 費用の削減: 実行をコンシューマ ハードウェアにオフロードすることで、推論費用を削減できます。これにより、頻繁に使用されるユーザーフローの費用を大幅に削減できます。

Gemini をデバイス上で実行することには多くのメリットがありますが、大規模な Gemini モデルを必要とするユースケースや、幅広いデバイスをサポートするユースケースでは、サーバー上の Gemini にアクセスするために Gemini API の使用を検討することをおすすめします。これは、バックエンド統合(Python、Go、Node.js、REST を使用)または新しい Android 用 Google AI クライアント SDK を介して Android アプリから直接行うことができます。

仕組み

Gemini Nano のデバイス上の実行は、Android AICore によって提供されます。これは、Android 14 で導入された、デバイス上の実行用の基盤モデルにアクセスできる新しいシステムレベルの機能です。基盤モデルは AICore を使用してプリインストールされているため、アプリ内でダウンロードまたは配布する必要はありません。LoRa を使用して、ダウンストリーム タスク用にこれらのモデルをファインチューニングできます。Android AICore は、Google Pixel 8 Pro と Samsung S24 シリーズのデバイスで本番環境で利用可能になり、すでに Google アプリの革新的な機能に活用されています。

詳細については、Android AICore をご覧ください。

次のステップ

- Android アプリで Google のサーバー上で Gemini Pro 推論を利用する方法については、Android 向け Google AI クライアント SDK のクイックスタートをご覧ください。