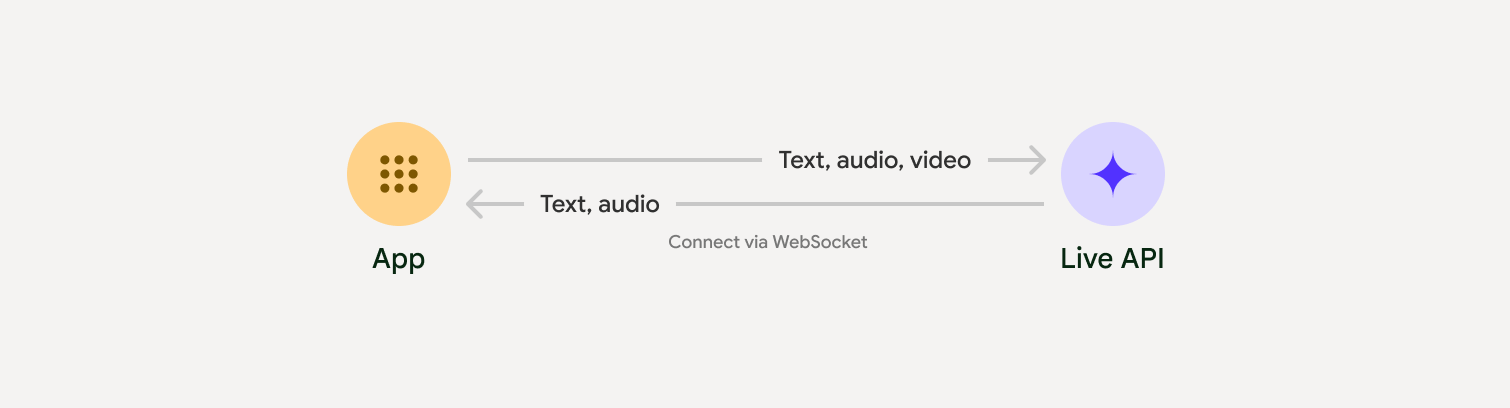

লাইভ এপিআই জেমিনির সাথে কম-বিলম্বিত, রিয়েল-টাইম ভয়েস এবং ভিডিও ইন্টারঅ্যাকশন সক্ষম করে। এটি তাৎক্ষণিক, মানুষের মতো কথ্য প্রতিক্রিয়া প্রদানের জন্য অডিও, ভিডিও বা টেক্সটের ক্রমাগত স্ট্রিম প্রক্রিয়া করে, যা আপনার ব্যবহারকারীদের জন্য একটি স্বাভাবিক কথোপকথনের অভিজ্ঞতা তৈরি করে।

লাইভ এপিআই ভয়েস অ্যাক্টিভিটি ডিটেকশন , টুল ব্যবহার এবং ফাংশন কলিং , সেশন ম্যানেজমেন্ট (দীর্ঘদিন ধরে চলমান কথোপকথন পরিচালনার জন্য) এবং ক্ষণস্থায়ী টোকেন (নিরাপদ ক্লায়েন্ট-পার্শ্বযুক্ত প্রমাণীকরণের জন্য) এর মতো বিস্তৃত বৈশিষ্ট্যগুলি অফার করে।

এই পৃষ্ঠাটি আপনাকে উদাহরণ এবং মৌলিক কোড নমুনা দিয়ে কাজ শুরু করতে সাহায্য করবে।

গুগল এআই স্টুডিও লাইভ এপিআই ব্যবহার করে দেখুন

একটি বাস্তবায়ন পদ্ধতি বেছে নিন

লাইভ এপিআই-এর সাথে ইন্টিগ্রেট করার সময়, আপনাকে নিম্নলিখিত বাস্তবায়ন পদ্ধতিগুলির মধ্যে একটি বেছে নিতে হবে:

- সার্ভার-টু-সার্ভার : আপনার ব্যাকএন্ড WebSockets ব্যবহার করে লাইভ API-এর সাথে সংযুক্ত হয়। সাধারণত, আপনার ক্লায়েন্ট আপনার সার্ভারে স্ট্রিম ডেটা (অডিও, ভিডিও, টেক্সট) পাঠায়, যা পরে এটি লাইভ API-তে ফরোয়ার্ড করে।

- ক্লায়েন্ট-টু-সার্ভার : আপনার ফ্রন্টএন্ড কোডটি আপনার ব্যাকএন্ডকে বাইপাস করে ডেটা স্ট্রিম করার জন্য ওয়েবসকেট ব্যবহার করে সরাসরি লাইভ API-এর সাথে সংযুক্ত হয়।

পার্টনার ইন্টিগ্রেশন

রিয়েল-টাইম অডিও এবং ভিডিও অ্যাপের ডেভেলপমেন্টকে সহজতর করার জন্য, আপনি একটি তৃতীয়-পক্ষ ইন্টিগ্রেশন ব্যবহার করতে পারেন যা WebRTC বা WebSockets এর মাধ্যমে Gemini Live API সমর্থন করে।

জেমিনি লাইভ এবং পাইপক্যাট ব্যবহার করে একটি রিয়েল-টাইম এআই চ্যাটবট তৈরি করুন।

লাইভকিটলাইভকিট এজেন্টদের সাথে জেমিনি লাইভ এপিআই ব্যবহার করুন।

সফটওয়্যার ম্যানশনের ফিশজ্যামফিশজ্যাম দিয়ে লাইভ ভিডিও এবং অডিও স্ট্রিমিং অ্যাপ্লিকেশন তৈরি করুন।

এজেন্ট ডেভেলপমেন্ট কিট (ADK)এজেন্ট ডেভেলপমেন্ট কিট (ADK) দিয়ে লাইভ API বাস্তবায়ন করুন।

স্ট্রিম দ্বারা ভিশন এজেন্টসভিশন এজেন্টদের সাথে রিয়েল-টাইম ভয়েস এবং ভিডিও এআই অ্যাপ্লিকেশন তৈরি করুন।

ভক্সিমপ্ল্যান্টVoximplant এর মাধ্যমে লাইভ API-তে ইনবাউন্ড এবং আউটবাউন্ড কল সংযুক্ত করুন।

শুরু করুন

এই সার্ভার-সাইড উদাহরণটি মাইক্রোফোন থেকে অডিও স্ট্রিম করে এবং ফিরে আসা অডিওটি চালায়। ক্লায়েন্ট অ্যাপ্লিকেশন সহ সম্পূর্ণ এন্ড-টু-এন্ড উদাহরণের জন্য, উদাহরণ অ্যাপ্লিকেশন দেখুন।

ইনপুট অডিও ফরম্যাটটি ১৬-বিট PCM, ১৬kHz, মনো ফরম্যাটে হওয়া উচিত এবং প্রাপ্ত অডিওটি ২৪kHz এর নমুনা হার ব্যবহার করে।

পাইথন

অডিও স্ট্রিমিংয়ের জন্য হেল্পার ইনস্টল করুন। অতিরিক্ত সিস্টেম-স্তরের নির্ভরতা (যেমন portaudio ) প্রয়োজন হতে পারে। বিস্তারিত ইনস্টলেশন ধাপগুলির জন্য PyAudio ডক্স দেখুন।

pip install pyaudioimport asyncio

from google import genai

import pyaudio

client = genai.Client()

# --- pyaudio config ---

FORMAT = pyaudio.paInt16

CHANNELS = 1

SEND_SAMPLE_RATE = 16000

RECEIVE_SAMPLE_RATE = 24000

CHUNK_SIZE = 1024

pya = pyaudio.PyAudio()

# --- Live API config ---

MODEL = "gemini-2.5-flash-native-audio-preview-12-2025"

CONFIG = {

"response_modalities": ["AUDIO"],

"system_instruction": "You are a helpful and friendly AI assistant.",

}

audio_queue_output = asyncio.Queue()

audio_queue_mic = asyncio.Queue(maxsize=5)

audio_stream = None

async def listen_audio():

"""Listens for audio and puts it into the mic audio queue."""

global audio_stream

mic_info = pya.get_default_input_device_info()

audio_stream = await asyncio.to_thread(

pya.open,

format=FORMAT,

channels=CHANNELS,

rate=SEND_SAMPLE_RATE,

input=True,

input_device_index=mic_info["index"],

frames_per_buffer=CHUNK_SIZE,

)

kwargs = {"exception_on_overflow": False} if __debug__ else {}

while True:

data = await asyncio.to_thread(audio_stream.read, CHUNK_SIZE, **kwargs)

await audio_queue_mic.put({"data": data, "mime_type": "audio/pcm"})

async def send_realtime(session):

"""Sends audio from the mic audio queue to the GenAI session."""

while True:

msg = await audio_queue_mic.get()

await session.send_realtime_input(audio=msg)

async def receive_audio(session):

"""Receives responses from GenAI and puts audio data into the speaker audio queue."""

while True:

turn = session.receive()

async for response in turn:

if (response.server_content and response.server_content.model_turn):

for part in response.server_content.model_turn.parts:

if part.inline_data and isinstance(part.inline_data.data, bytes):

audio_queue_output.put_nowait(part.inline_data.data)

# Empty the queue on interruption to stop playback

while not audio_queue_output.empty():

audio_queue_output.get_nowait()

async def play_audio():

"""Plays audio from the speaker audio queue."""

stream = await asyncio.to_thread(

pya.open,

format=FORMAT,

channels=CHANNELS,

rate=RECEIVE_SAMPLE_RATE,

output=True,

)

while True:

bytestream = await audio_queue_output.get()

await asyncio.to_thread(stream.write, bytestream)

async def run():

"""Main function to run the audio loop."""

try:

async with client.aio.live.connect(

model=MODEL, config=CONFIG

) as live_session:

print("Connected to Gemini. Start speaking!")

async with asyncio.TaskGroup() as tg:

tg.create_task(send_realtime(live_session))

tg.create_task(listen_audio())

tg.create_task(receive_audio(live_session))

tg.create_task(play_audio())

except asyncio.CancelledError:

pass

finally:

if audio_stream:

audio_stream.close()

pya.terminate()

print("\nConnection closed.")

if __name__ == "__main__":

try:

asyncio.run(run())

except KeyboardInterrupt:

print("Interrupted by user.")

জাভাস্ক্রিপ্ট

অডিও স্ট্রিমিংয়ের জন্য হেল্পার ইনস্টল করুন। অতিরিক্ত সিস্টেম-স্তরের নির্ভরতা প্রয়োজন হতে পারে (ম্যাক/উইন্ডোজের জন্য sox অথবা লিনাক্সের জন্য ALSA )। বিস্তারিত ইনস্টলেশন ধাপগুলির জন্য স্পিকার এবং মাইক ডক্স দেখুন।

npm install mic speakerimport { GoogleGenAI, Modality } from '@google/genai';

import mic from 'mic';

import Speaker from 'speaker';

const ai = new GoogleGenAI({});

// WARNING: Do not use API keys in client-side (browser based) applications

// Consider using Ephemeral Tokens instead

// More information at: https://ai.google.dev/gemini-api/docs/ephemeral-tokens

// --- Live API config ---

const model = 'gemini-2.5-flash-native-audio-preview-12-2025';

const config = {

responseModalities: [Modality.AUDIO],

systemInstruction: "You are a helpful and friendly AI assistant.",

};

async function live() {

const responseQueue = [];

const audioQueue = [];

let speaker;

async function waitMessage() {

while (responseQueue.length === 0) {

await new Promise((resolve) => setImmediate(resolve));

}

return responseQueue.shift();

}

function createSpeaker() {

if (speaker) {

process.stdin.unpipe(speaker);

speaker.end();

}

speaker = new Speaker({

channels: 1,

bitDepth: 16,

sampleRate: 24000,

});

speaker.on('error', (err) => console.error('Speaker error:', err));

process.stdin.pipe(speaker);

}

async function messageLoop() {

// Puts incoming messages in the audio queue.

while (true) {

const message = await waitMessage();

if (message.serverContent && message.serverContent.interrupted) {

// Empty the queue on interruption to stop playback

audioQueue.length = 0;

continue;

}

if (message.serverContent && message.serverContent.modelTurn && message.serverContent.modelTurn.parts) {

for (const part of message.serverContent.modelTurn.parts) {

if (part.inlineData && part.inlineData.data) {

audioQueue.push(Buffer.from(part.inlineData.data, 'base64'));

}

}

}

}

}

async function playbackLoop() {

// Plays audio from the audio queue.

while (true) {

if (audioQueue.length === 0) {

if (speaker) {

// Destroy speaker if no more audio to avoid warnings from speaker library

process.stdin.unpipe(speaker);

speaker.end();

speaker = null;

}

await new Promise((resolve) => setImmediate(resolve));

} else {

if (!speaker) createSpeaker();

const chunk = audioQueue.shift();

await new Promise((resolve) => {

speaker.write(chunk, () => resolve());

});

}

}

}

// Start loops

messageLoop();

playbackLoop();

// Connect to Gemini Live API

const session = await ai.live.connect({

model: model,

config: config,

callbacks: {

onopen: () => console.log('Connected to Gemini Live API'),

onmessage: (message) => responseQueue.push(message),

onerror: (e) => console.error('Error:', e.message),

onclose: (e) => console.log('Closed:', e.reason),

},

});

// Setup Microphone for input

const micInstance = mic({

rate: '16000',

bitwidth: '16',

channels: '1',

});

const micInputStream = micInstance.getAudioStream();

micInputStream.on('data', (data) => {

// API expects base64 encoded PCM data

session.sendRealtimeInput({

audio: {

data: data.toString('base64'),

mimeType: "audio/pcm;rate=16000"

}

});

});

micInputStream.on('error', (err) => {

console.error('Microphone error:', err);

});

micInstance.start();

console.log('Microphone started. Speak now...');

}

live().catch(console.error);

উদাহরণ অ্যাপ্লিকেশন

এন্ড-টু-এন্ড ব্যবহারের ক্ষেত্রে লাইভ API কীভাবে ব্যবহার করতে হয় তা ব্যাখ্যা করে নিম্নলিখিত উদাহরণ অ্যাপ্লিকেশনগুলি দেখুন:

- AI Studio-তে লাইভ অডিও স্টার্টার অ্যাপ , JavaScript লাইব্রেরি ব্যবহার করে লাইভ API-এর সাথে সংযোগ স্থাপন করে এবং আপনার মাইক্রোফোন এবং স্পিকারের মাধ্যমে দ্বিমুখী অডিও স্ট্রিম করে।

- অতিরিক্ত উদাহরণ এবং শুরু করার নির্দেশিকাগুলির জন্য অংশীদার ইন্টিগ্রেশনগুলি দেখুন।

এরপর কি?

- ভয়েস অ্যাক্টিভিটি ডিটেকশন এবং নেটিভ অডিও বৈশিষ্ট্য সহ মূল ক্ষমতা এবং কনফিগারেশনের জন্য সম্পূর্ণ লাইভ এপিআই সক্ষমতা নির্দেশিকাটি পড়ুন।

- টুল এবং ফাংশন কলিংয়ের সাথে লাইভ API কীভাবে সংহত করতে হয় তা শিখতে টুল ব্যবহারের নির্দেশিকাটি পড়ুন।

- দীর্ঘমেয়াদী কথোপকথন পরিচালনার জন্য সেশন ব্যবস্থাপনা নির্দেশিকাটি পড়ুন।

- ক্লায়েন্ট-টু-সার্ভার অ্যাপ্লিকেশনগুলিতে নিরাপদ প্রমাণীকরণের জন্য এফেমেরাল টোকেন নির্দেশিকাটি পড়ুন।

- অন্তর্নিহিত WebSockets API সম্পর্কে আরও তথ্যের জন্য, WebSockets API রেফারেন্স দেখুন।