La API de Gemini proporciona parámetros de seguridad que puedes ajustar durante la fase de creación de prototipos para determinar si tu aplicación requiere una configuración de seguridad más o menos restrictiva. Puedes ajustar estos parámetros de configuración en cinco categorías de filtros para restringir o permitir ciertos tipos de contenido.

En esta guía, se explica cómo la API de Gemini controla la configuración y el filtrado de seguridad, y cómo puedes cambiar la configuración de seguridad de tu aplicación.

Filtros de seguridad

Los filtros de seguridad ajustables de la API de Gemini abarcan las siguientes categorías:

| Categoría | Descripción |

|---|---|

| Acoso | Comentarios negativos o dañinos que se orientan a la identidad o los atributos protegidos. |

| Incitación al odio o a la violencia | Contenido grosero, irrespetuoso u obsceno. |

| Contenido sexual explícito | Incluye referencias a actos sexual o a otro contenido obsceno. |

| Peligroso | Promueve, facilita o fomenta actividades perjudiciales. |

| Integridad cívica | Consultas relacionadas con elecciones |

Puedes usar estos filtros para ajustar lo que sea apropiado para tu caso de uso. Por ejemplo, si estás creando diálogos para un videojuego, es posible que consideres aceptable permitir más contenido clasificado como Peligroso debido a la naturaleza del juego.

Además de los filtros de seguridad ajustables, la API de Gemini tiene protecciones integradas contra daños fundamentales, como el contenido que pone en peligro la seguridad de los niños. Estos tipos de daño siempre se bloquean y no se pueden ajustar.

Nivel de filtrado de seguridad del contenido

La API de Gemini clasifica el nivel de probabilidad de que el contenido sea inseguro como HIGH, MEDIUM, LOW o NEGLIGIBLE.

La API de Gemini bloquea el contenido en función de la probabilidad de que sea inseguro y no de la gravedad. Es importante saber esto porque algunos contenidos pueden tener una baja probabilidad de ser inseguros, aunque la gravedad del daño pueda seguir siendo alta. Por ejemplo, comparemos las siguientes oraciones:

- El robot me golpeó.

- El robot me acuchilló.

La primera oración podría tener una mayor probabilidad de ser insegura, pero podrías considerar que la segunda oración es de mayor gravedad en términos de violencia. Por lo tanto, es importante que pruebes y consideres con cuidado cuál es el nivel adecuado de bloqueo necesario para respaldar tus casos de uso clave y minimizar el daño a los usuarios finales.

Filtrado de seguridad por solicitud

Puedes ajustar la configuración de seguridad de cada solicitud que realices a la API. Cuando haces una solicitud, el contenido se analiza y se le asigna una calificación de seguridad. La clasificación de seguridad incluye la categoría y la probabilidad de la clasificación del daño. Por ejemplo, si el contenido se bloqueó porque la categoría de hostigamiento tenía una probabilidad alta, la clasificación de seguridad que se devolvió tendría la categoría igual a HARASSMENT y la probabilidad de daño establecida en HIGH.

De forma predeterminada, la configuración de seguridad bloquea el contenido (incluidas las instrucciones) con una probabilidad media o alta de ser poco seguro en cualquier filtro. La seguridad de este modelo de referencia está diseñada para funcionar en la mayoría de los casos de uso, por lo que solo debes ajustar la configuración de seguridad si es necesario para tu aplicación.

En la siguiente tabla, se describe la configuración de bloqueo que puedes ajustar para cada categoría. Por ejemplo, si estableces la configuración de bloqueo en Bloquear poco para la categoría de incitación al odio o a la violencia, se bloqueará todo lo que tenga una alta probabilidad de ser contenido de incitación al odio o a la violencia. Pero se permite cualquier cosa con una probabilidad menor.

| Umbral (Google AI Studio) | Umbral (API) | Descripción |

|---|---|---|

| Desactivado | OFF |

Desactiva el filtro de seguridad |

| No bloquear | BLOCK_NONE |

Mostrar siempre sin importar la probabilidad de que sea contenido no seguro |

| Bloquear poco | BLOCK_ONLY_HIGH |

Bloquear cuando haya una alta probabilidad de que sea contenido no seguro |

| Bloquear algo | BLOCK_MEDIUM_AND_ABOVE |

Bloquear cuando haya una probabilidad media o alta de que sea contenido no seguro |

| Bloquear la mayoría | BLOCK_LOW_AND_ABOVE |

Bloquear cuando haya una probabilidad baja, media o alta de que sea contenido no seguro |

| N/A | HARM_BLOCK_THRESHOLD_UNSPECIFIED |

No se especifica el umbral; se bloquea con el umbral predeterminado. |

Si no se establece el umbral, el umbral de bloqueo predeterminado es No bloquear (para todos los modelos de GA estables más recientes) o Bloquear algo (en todos los demás modelos) para todas las categorías excepto la categoría Integridad cívica.

El umbral de bloqueo predeterminado para la categoría Integridad cívica es No bloquear nada (para gemini-2.0-flash y gemini-2.0-flash-lite) tanto para Google AI Studio como para la API de Gemini, y Bloquear la mayoría para todos los demás modelos solo en Google AI Studio.

Puedes establecer estos parámetros de configuración para cada solicitud que realices al servicio generativo.

Consulta la referencia de la API de HarmBlockThreshold para obtener más detalles.

Comentarios sobre seguridad

generateContent devuelve un GenerateContentResponse que incluye comentarios sobre la seguridad.

Los comentarios sobre las instrucciones se incluyen en promptFeedback. Si se establece promptFeedback.blockReason, se bloqueó el contenido de la instrucción.

Los comentarios sobre los candidatos a respuesta se incluyen en Candidate.finishReason y Candidate.safetyRatings. Si se bloqueó el contenido de la respuesta y el finishReason era SAFETY, puedes inspeccionar safetyRatings para obtener más detalles. No se devuelve el contenido que se bloqueó.

Cómo ajustar la configuración de protección

En esta sección, se explica cómo ajustar la configuración de seguridad en Google AI Studio y en tu código.

Google AI Studio

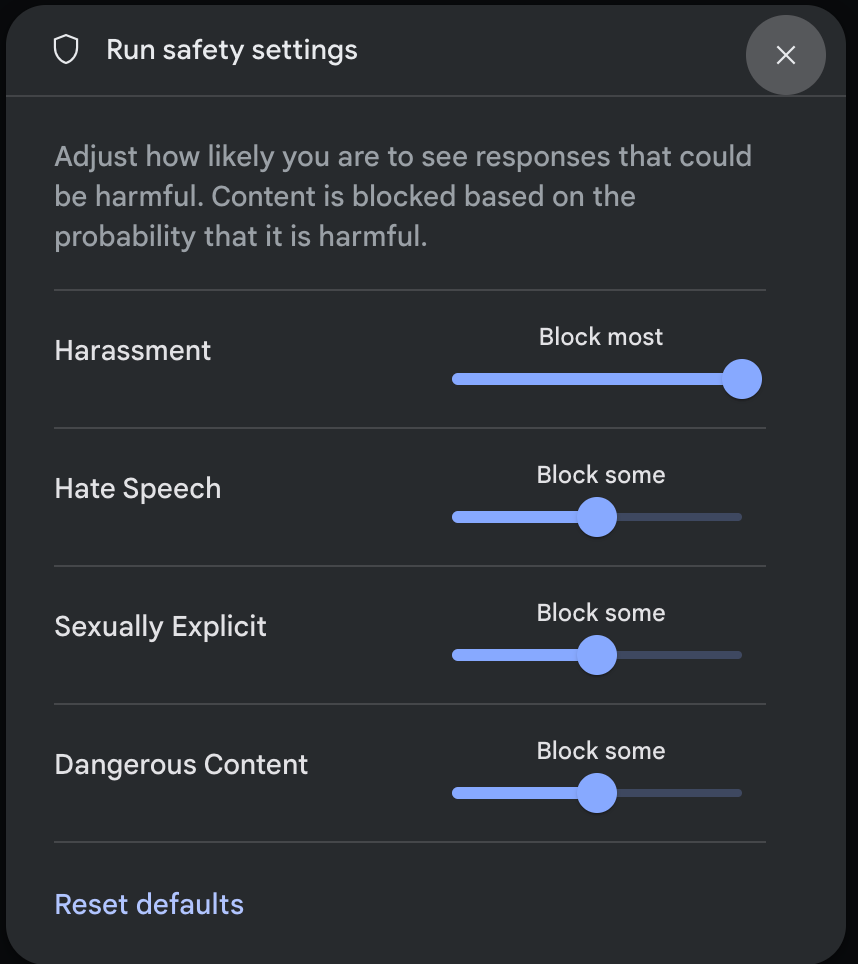

Puedes ajustar la configuración de seguridad en Google AI Studio, pero no puedes desactivarla.

Haz clic en Editar la configuración de seguridad en el panel Configuración de ejecución para abrir la ventana modal Configuración de seguridad de ejecución. En la ventana modal, puedes usar los controles deslizantes para ajustar el nivel de filtrado de contenido por categoría de seguridad:

Cuando envías una solicitud (por ejemplo, cuando le haces una pregunta al modelo), aparece el mensaje Sin contenido si se bloquea el contenido de la solicitud. Para ver más detalles, mantén el puntero sobre el texto Sin contenido y haz clic en Seguridad.

SDKs de la API de Gemini

En el siguiente fragmento de código, se muestra cómo establecer la configuración de seguridad en tu llamada a GenerateContent. Esto establece los umbrales para las categorías de hostigamiento (HARM_CATEGORY_HARASSMENT) y discurso de odio (HARM_CATEGORY_HATE_SPEECH). Por ejemplo, establecer estas categorías en BLOCK_LOW_AND_ABOVE bloquea todo el contenido que tenga una probabilidad baja o alta de ser hostigamiento o incitación al odio. Para comprender la configuración de los umbrales, consulta Filtrado de seguridad por solicitud.

Python

from google import genai

from google.genai import types

import PIL.Image

img = PIL.Image.open("cookies.jpg")

client = genai.Client()

response = client.models.generate_content(

model="gemini-2.0-flash",

contents=['Do these look store-bought or homemade?', img],

config=types.GenerateContentConfig(

safety_settings=[

types.SafetySetting(

category=types.HarmCategory.HARM_CATEGORY_HATE_SPEECH,

threshold=types.HarmBlockThreshold.BLOCK_LOW_AND_ABOVE,

),

]

)

)

print(response.text)

Go

package main

import (

"context"

"fmt"

"log"

"google.golang.org/genai"

)

func main() {

ctx := context.Background()

client, err := genai.NewClient(ctx, nil)

if err != nil {

log.Fatal(err)

}

config := &genai.GenerateContentConfig{

SafetySettings: []*genai.SafetySetting{

{

Category: "HARM_CATEGORY_HATE_SPEECH",

Threshold: "BLOCK_LOW_AND_ABOVE",

},

},

}

response, err := client.Models.GenerateContent(

ctx,

"gemini-2.0-flash",

genai.Text("Some potentially unsafe prompt."),

config,

)

if err != nil {

log.Fatal(err)

}

fmt.Println(response.Text())

}

JavaScript

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

const safetySettings = [

{

category: "HARM_CATEGORY_HARASSMENT",

threshold: "BLOCK_LOW_AND_ABOVE",

},

{

category: "HARM_CATEGORY_HATE_SPEECH",

threshold: "BLOCK_LOW_AND_ABOVE",

},

];

async function main() {

const response = await ai.models.generateContent({

model: "gemini-2.0-flash",

contents: "Some potentially unsafe prompt.",

config: {

safetySettings: safetySettings,

},

});

console.log(response.text);

}

await main();

Dart (Flutter)

final safetySettings = [

SafetySetting(HarmCategory.harassment, HarmBlockThreshold.low),

SafetySetting(HarmCategory.hateSpeech, HarmBlockThreshold.low),

];

final model = GenerativeModel(

model: 'gemini-1.5-flash',

apiKey: apiKey,

safetySettings: safetySettings,

);

Kotlin

val harassmentSafety = SafetySetting(HarmCategory.HARASSMENT, BlockThreshold.LOW_AND_ABOVE)

val hateSpeechSafety = SafetySetting(HarmCategory.HATE_SPEECH, BlockThreshold.LOW_AND_ABOVE)

val generativeModel = GenerativeModel(

modelName = "gemini-1.5-flash",

apiKey = BuildConfig.apiKey,

safetySettings = listOf(harassmentSafety, hateSpeechSafety)

)

Java

SafetySetting harassmentSafety = new SafetySetting(HarmCategory.HARASSMENT,

BlockThreshold.LOW_AND_ABOVE);

SafetySetting hateSpeechSafety = new SafetySetting(HarmCategory.HATE_SPEECH,

BlockThreshold.LOW_AND_ABOVE);

GenerativeModel gm = new GenerativeModel(

"gemini-1.5-flash",

BuildConfig.apiKey,

null, // generation config is optional

Arrays.asList(harassmentSafety, hateSpeechSafety)

);

GenerativeModelFutures model = GenerativeModelFutures.from(gm);

REST

echo '{ "safetySettings": [ {"category": "HARM_CATEGORY_HARASSMENT", "threshold": "BLOCK_ONLY_HIGH"}, {"category": "HARM_CATEGORY_HATE_SPEECH", "threshold": "BLOCK_MEDIUM_AND_ABOVE"} ], "contents": [{ "parts":[{ "text": "'I support Martians Soccer Club and I think Jupiterians Football Club sucks! Write a ironic phrase about them.'"}]}]}' > request.json

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-2.0-flash:generateContent" \ -H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d @request.json 2> /dev/null

Próximos pasos

- Consulta la referencia de la API para obtener más información sobre la API completa.

- Revisa la orientación sobre seguridad para obtener una visión general de las consideraciones de seguridad al desarrollar con LLMs.

- Más información para evaluar la probabilidad frente a la gravedad del equipo de Jigsaw

- Obtén más información sobre los productos que contribuyen a las soluciones de seguridad, como la API de Perspective. * Puedes usar estos parámetros de configuración de seguridad para crear un clasificador de toxicidad. Consulta el ejemplo de clasificación para comenzar.