অবজেক্ট ডিটেক্টরগুলি কোন কোন বস্তুর উপস্থিতি থাকতে পারে তা সনাক্ত করতে পারে এবং প্রদত্ত চিত্র বা ভিডিও স্ট্রিমের মধ্যে তাদের অবস্থান সম্পর্কে তথ্য সরবরাহ করতে পারে। একটি অবজেক্ট ডিটেক্টরকে একাধিক শ্রেণীর বস্তুর উপস্থিতি এবং অবস্থান সনাক্ত করার জন্য প্রশিক্ষণ দেওয়া হয়। উদাহরণস্বরূপ, একটি মডেলকে বিভিন্ন ফলের টুকরো ধারণকারী চিত্র, সেই সাথে একটি লেবেল সহ প্রশিক্ষণ দেওয়া যেতে পারে যা তারা প্রতিনিধিত্ব করে এমন ফলের শ্রেণী (যেমন একটি আপেল, একটি কলা, বা একটি স্ট্রবেরি) নির্দিষ্ট করে এবং ছবিতে প্রতিটি বস্তু কোথায় প্রদর্শিত হবে তা নির্দিষ্ট করে এমন ডেটা দিয়ে প্রশিক্ষণ দেওয়া যেতে পারে। অবজেক্ট ডিটেক্টর সম্পর্কে আরও তথ্যের জন্য অবজেক্ট ডিটেক্টর উদাহরণটি দেখুন।

আপনার মোবাইল অ্যাপে আপনার কাস্টম অবজেক্ট ডিটেক্টর বা প্রি-ট্রেনডেড অবজেক্ট ডিটেক্টর স্থাপন করতে টাস্ক লাইব্রেরি ObjectDetector API ব্যবহার করুন।

অবজেক্টডিটেক্টর API এর মূল বৈশিষ্ট্যগুলি

ইনপুট ইমেজ প্রসেসিং, যার মধ্যে রয়েছে ঘূর্ণন, আকার পরিবর্তন এবং রঙের স্থান রূপান্তর।

মানচিত্রের লোকেল লেবেল করুন।

ফলাফল ফিল্টার করার জন্য স্কোর থ্রেশহোল্ড।

টপ-কে সনাক্তকরণের ফলাফল।

অ্যালাউলিস্ট এবং ডিনাইলিস্ট লেবেল করুন।

সমর্থিত অবজেক্ট ডিটেক্টর মডেল

নিম্নলিখিত মডেলগুলি ObjectDetector API-এর সাথে সামঞ্জস্যপূর্ণ হওয়ার নিশ্চয়তা রয়েছে।

অটোএমএল ভিশন এজ অবজেক্ট ডিটেকশন দ্বারা তৈরি মডেল।

অবজেক্ট ডিটেক্টরের জন্য টেনসরফ্লো লাইট মডেল মেকার দ্বারা তৈরি মডেল।

কাস্টম মডেল যা মডেলের সামঞ্জস্যের প্রয়োজনীয়তা পূরণ করে।

জাভাতে অনুমান চালান

অ্যান্ড্রয়েড অ্যাপে ObjectDetector কীভাবে ব্যবহার করবেন তার উদাহরণের জন্য Object Detection রেফারেন্স অ্যাপটি দেখুন।

ধাপ ১: গ্রেডল নির্ভরতা এবং অন্যান্য সেটিংস আমদানি করুন

.tflite মডেল ফাইলটি অ্যান্ড্রয়েড মডিউলের সম্পদ ডিরেক্টরিতে কপি করুন যেখানে মডেলটি চালানো হবে। ফাইলটি সংকুচিত করা উচিত নয় তা নির্দিষ্ট করুন এবং মডিউলের build.gradle ফাইলে TensorFlow Lite লাইব্রেরি যোগ করুন:

android {

// Other settings

// Specify tflite file should not be compressed for the app apk

aaptOptions {

noCompress "tflite"

}

}

dependencies {

// Other dependencies

// Import the Task Vision Library dependency

implementation 'org.tensorflow:tensorflow-lite-task-vision'

// Import the GPU delegate plugin Library for GPU inference

implementation 'org.tensorflow:tensorflow-lite-gpu-delegate-plugin'

}

ধাপ ২: মডেল ব্যবহার করা

// Initialization

ObjectDetectorOptions options =

ObjectDetectorOptions.builder()

.setBaseOptions(BaseOptions.builder().useGpu().build())

.setMaxResults(1)

.build();

ObjectDetector objectDetector =

ObjectDetector.createFromFileAndOptions(

context, modelFile, options);

// Run inference

List<Detection> results = objectDetector.detect(image);

ObjectDetector কনফিগার করার আরও বিকল্পের জন্য সোর্স কোড এবং javadoc দেখুন।

iOS-এ অনুমান চালান

ধাপ ১: নির্ভরতা ইনস্টল করুন

টাস্ক লাইব্রেরি CocoaPods ব্যবহার করে ইনস্টলেশন সমর্থন করে। নিশ্চিত করুন যে আপনার সিস্টেমে CocoaPods ইনস্টল করা আছে। নির্দেশাবলীর জন্য অনুগ্রহ করে CocoaPods ইনস্টলেশন নির্দেশিকাটি দেখুন।

Xcode প্রকল্পে পড যোগ করার বিশদ বিবরণের জন্য অনুগ্রহ করে CocoaPods নির্দেশিকাটি দেখুন।

পডফাইলে TensorFlowLiteTaskVision পড যোগ করুন।

target 'MyAppWithTaskAPI' do

use_frameworks!

pod 'TensorFlowLiteTaskVision'

end

নিশ্চিত করুন যে আপনি যে .tflite মডেলটি অনুমানের জন্য ব্যবহার করবেন তা আপনার অ্যাপ বান্ডেলে উপস্থিত রয়েছে।

ধাপ ২: মডেল ব্যবহার করা

সুইফট

// Imports

import TensorFlowLiteTaskVision

// Initialization

guard let modelPath = Bundle.main.path(forResource: "ssd_mobilenet_v1",

ofType: "tflite") else { return }

let options = ObjectDetectorOptions(modelPath: modelPath)

// Configure any additional options:

// options.classificationOptions.maxResults = 3

let detector = try ObjectDetector.detector(options: options)

// Convert the input image to MLImage.

// There are other sources for MLImage. For more details, please see:

// https://developers.google.com/ml-kit/reference/ios/mlimage/api/reference/Classes/GMLImage

guard let image = UIImage (named: "cats_and_dogs.jpg"), let mlImage = MLImage(image: image) else { return }

// Run inference

let detectionResult = try detector.detect(mlImage: mlImage)

অবজেক্টিভ-সি

// Imports

#import <TensorFlowLiteTaskVision/TensorFlowLiteTaskVision.h>

// Initialization

NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"ssd_mobilenet_v1" ofType:@"tflite"];

TFLObjectDetectorOptions *options = [[TFLObjectDetectorOptions alloc] initWithModelPath:modelPath];

// Configure any additional options:

// options.classificationOptions.maxResults = 3;

TFLObjectDetector *detector = [TFLObjectDetector objectDetectorWithOptions:options

error:nil];

// Convert the input image to MLImage.

UIImage *image = [UIImage imageNamed:@"dogs.jpg"];

// There are other sources for GMLImage. For more details, please see:

// https://developers.google.com/ml-kit/reference/ios/mlimage/api/reference/Classes/GMLImage

GMLImage *gmlImage = [[GMLImage alloc] initWithImage:image];

// Run inference

TFLDetectionResult *detectionResult = [detector detectWithGMLImage:gmlImage error:nil];

TFLObjectDetector কনফিগার করার জন্য আরও বিকল্পের জন্য সোর্স কোডটি দেখুন।

পাইথনে ইনফারেন্স চালান

ধাপ ১: পিপ প্যাকেজ ইনস্টল করুন

pip install tflite-support

ধাপ ২: মডেল ব্যবহার করা

# Imports

from tflite_support.task import vision

from tflite_support.task import core

from tflite_support.task import processor

# Initialization

base_options = core.BaseOptions(file_name=model_path)

detection_options = processor.DetectionOptions(max_results=2)

options = vision.ObjectDetectorOptions(base_options=base_options, detection_options=detection_options)

detector = vision.ObjectDetector.create_from_options(options)

# Alternatively, you can create an object detector in the following manner:

# detector = vision.ObjectDetector.create_from_file(model_path)

# Run inference

image = vision.TensorImage.create_from_file(image_path)

detection_result = detector.detect(image)

ObjectDetector কনফিগার করার আরও বিকল্পের জন্য সোর্স কোডটি দেখুন।

C++ এ অনুমান চালান

// Initialization

ObjectDetectorOptions options;

options.mutable_base_options()->mutable_model_file()->set_file_name(model_path);

std::unique_ptr<ObjectDetector> object_detector = ObjectDetector::CreateFromOptions(options).value();

// Create input frame_buffer from your inputs, `image_data` and `image_dimension`.

// See more information here: tensorflow_lite_support/cc/task/vision/utils/frame_buffer_common_utils.h

std::unique_ptr<FrameBuffer> frame_buffer = CreateFromRgbRawBuffer(

image_data, image_dimension);

// Run inference

const DetectionResult result = object_detector->Detect(*frame_buffer).value();

ObjectDetector কনফিগার করার আরও বিকল্পের জন্য সোর্স কোডটি দেখুন।

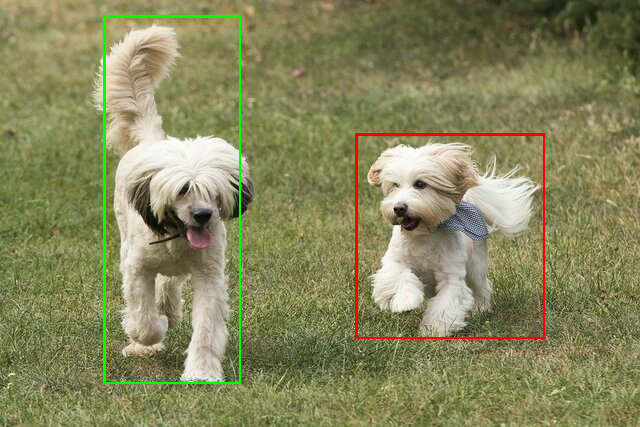

উদাহরণ ফলাফল

TensorFlow Hub থেকে ssd mobilenet v1 এর সনাক্তকরণ ফলাফলের একটি উদাহরণ এখানে দেওয়া হল।

Results:

Detection #0 (red):

Box: (x: 355, y: 133, w: 190, h: 206)

Top-1 class:

index : 17

score : 0.73828

class name : dog

Detection #1 (green):

Box: (x: 103, y: 15, w: 138, h: 369)

Top-1 class:

index : 17

score : 0.73047

class name : dog

ইনপুট ছবিতে বাউন্ডিং বাক্সগুলি রেন্ডার করুন:

আপনার নিজস্ব মডেল এবং পরীক্ষার ডেটা দিয়ে ObjectDetector-এর জন্য সহজ CLI ডেমো টুলটি ব্যবহার করে দেখুন।

মডেলের সামঞ্জস্যের প্রয়োজনীয়তা

ObjectDetector API একটি TFLite মডেল আশা করে যার বাধ্যতামূলক TFLite Model Metadata থাকবে। TensorFlow Lite Metadata Writer API ব্যবহার করে অবজেক্ট ডিটেক্টরের জন্য মেটাডেটা তৈরির উদাহরণ দেখুন।

সামঞ্জস্যপূর্ণ বস্তু সনাক্তকারী মডেলগুলিকে নিম্নলিখিত প্রয়োজনীয়তাগুলি পূরণ করতে হবে:

ইনপুট ইমেজ টেনসর: (kTfLiteUInt8/kTfLiteFloat32)

- আকারের চিত্র ইনপুট

[batch x height x width x channels]। - ব্যাচ ইনফারেন্স সমর্থিত নয় (

batch১ হতে হবে)। - শুধুমাত্র RGB ইনপুট সমর্থিত (

channels3 হতে হবে)। - যদি টাইপ kTfLiteFloat32 হয়, তাহলে ইনপুট নরমালাইজেশনের জন্য মেটাডেটার সাথে নরমালাইজেশন অপশন সংযুক্ত করতে হবে।

- আকারের চিত্র ইনপুট

আউটপুট টেনসর অবশ্যই একটি

DetectionPostProcessop এর 4 টি আউটপুট হতে হবে, অর্থাৎ:- অবস্থান টেনসর (kTfLiteFloat32)

- আকারের টেনসর

[1 x num_results x 4], ভিতরের অ্যারে যা [উপরে, বামে, ডানে, নীচে] আকারে বাউন্ডিং বাক্সগুলিকে প্রতিনিধিত্ব করে। - BoundingBoxProperties মেটাডেটার সাথে সংযুক্ত করতে হবে এবং

type=BOUNDARIESএবং `coordinate_type=RATIO` উল্লেখ করতে হবে। ক্লাস টেনসর (kTfLiteFloat32)

আকারের টেনসর

[1 x num_results], প্রতিটি মান একটি শ্রেণীর পূর্ণসংখ্যা সূচককে প্রতিনিধিত্ব করে।ঐচ্ছিক (কিন্তু প্রস্তাবিত) লেবেল মানচিত্র(গুলি) AssociatedFile-s হিসাবে সংযুক্ত করা যেতে পারে যার ধরণ TENSOR_VALUE_LABELS, প্রতি লাইনে একটি করে লেবেল থাকে। উদাহরণ লেবেল ফাইলটি দেখুন। ফলাফলের

class_nameক্ষেত্রটি পূরণ করতে প্রথম AssociatedFile (যদি থাকে) ব্যবহার করা হয়।display_nameক্ষেত্রটি AssociatedFile (যদি থাকে) থেকে পূরণ করা হয় যার লোকেল তৈরির সময় ব্যবহৃতObjectDetectorOptionsএরdisplay_names_localeক্ষেত্রের সাথে মেলে ("en" ডিফল্টরূপে, অর্থাৎ ইংরেজি)। যদি এর কোনটিই উপলব্ধ না থাকে, তবে শুধুমাত্র ফলাফলেরindexক্ষেত্রটি পূরণ করা হবে।স্কোর টেনসর (kTfLiteFloat32)

আকারের টেনসর

[1 x num_results], প্রতিটি মান সনাক্ত করা বস্তুর স্কোর প্রতিনিধিত্ব করে।সনাক্তকরণ টেনসরের সংখ্যা (kTfLiteFloat32)

আকারের টেনসর হিসেবে পূর্ণসংখ্যা num_results

[1]।