۷ نوامبر ۲۰۲۴

تقویت دستیاران کدنویسی هوش مصنوعی با متن طولانی مدلهای Gemini

یکی از هیجانانگیزترین مرزها در کاربرد پنجرههای متنی طولانی، تولید و درک کد است. پایگاههای کد بزرگ نیاز به درک عمیقی از روابط و وابستگیهای پیچیده دارند، چیزی که مدلهای سنتی هوش مصنوعی برای درک آن تلاش میکنند. با گسترش حجم کد با پنجرههای متنی بزرگ، میتوانیم سطح جدیدی از دقت و سودمندی را در تولید و درک کد به دست آوریم.

ما با Sourcegraph، خالق دستیار کدنویسی هوش مصنوعی Cody که از LLMهایی مانند Gemini 1.5 Pro و Flash پشتیبانی میکند، همکاری کردیم تا پتانسیل پنجرههای متنی طولانی را در سناریوهای کدنویسی دنیای واقعی بررسی کنیم. تمرکز Sourcegraph بر ادغام جستجوی کد و هوش در تولید کد هوش مصنوعی و استقرار موفقیتآمیز Cody در شرکتهایی با پایگاههای کد بزرگ و پیچیده مانند Palo Alto Networks و Leidos، آنها را به شریک ایدهآلی برای این بررسی تبدیل کرده است.

رویکرد و نتایج Sourcegraph

سورسگراف عملکرد کدی را با یک پنجره زمینه ۱ میلیون توکنی (با استفاده از Gemini 1.5 Flash گوگل) در مقایسه با نسخه تولیدی آن مقایسه کرد. این مقایسه مستقیم به آنها اجازه داد تا مزایای زمینه توسعهیافته را جدا کنند. آنها بر پاسخ به سؤالات فنی تمرکز کردند، یک کار حیاتی برای توسعهدهندگانی که با پایگاههای کد بزرگ کار میکنند. آنها از مجموعهای از سؤالات چالشبرانگیز استفاده کردند که نیاز به درک عمیق کد داشت.

نتایج قابل توجه بود. سه مورد از معیارهای کلیدی Sourcegraph - یادآوری ضروری، خلاصهسازی ضروری و مفید بودن - هنگام استفاده از متن طولانیتر، بهبودهای قابل توجهی را نشان دادند.

یادآوری ضروری: نسبت حقایق حیاتی در پاسخ به طور قابل توجهی افزایش یافت.

خلاصهسازی ضروری: نسبت حقایق ضروری که بر اساس طول پاسخ نرمالسازی شدهاند نیز بهبود یافته است، که نشاندهنده پاسخهای مختصرتر و مرتبطتر است.

مفید بودن: امتیاز کلی مفید بودن، که بر اساس طول پاسخ نرمالسازی شده است، به طور قابل توجهی افزایش یافته است که نشان دهنده یک تجربه کاربرپسندتر است.

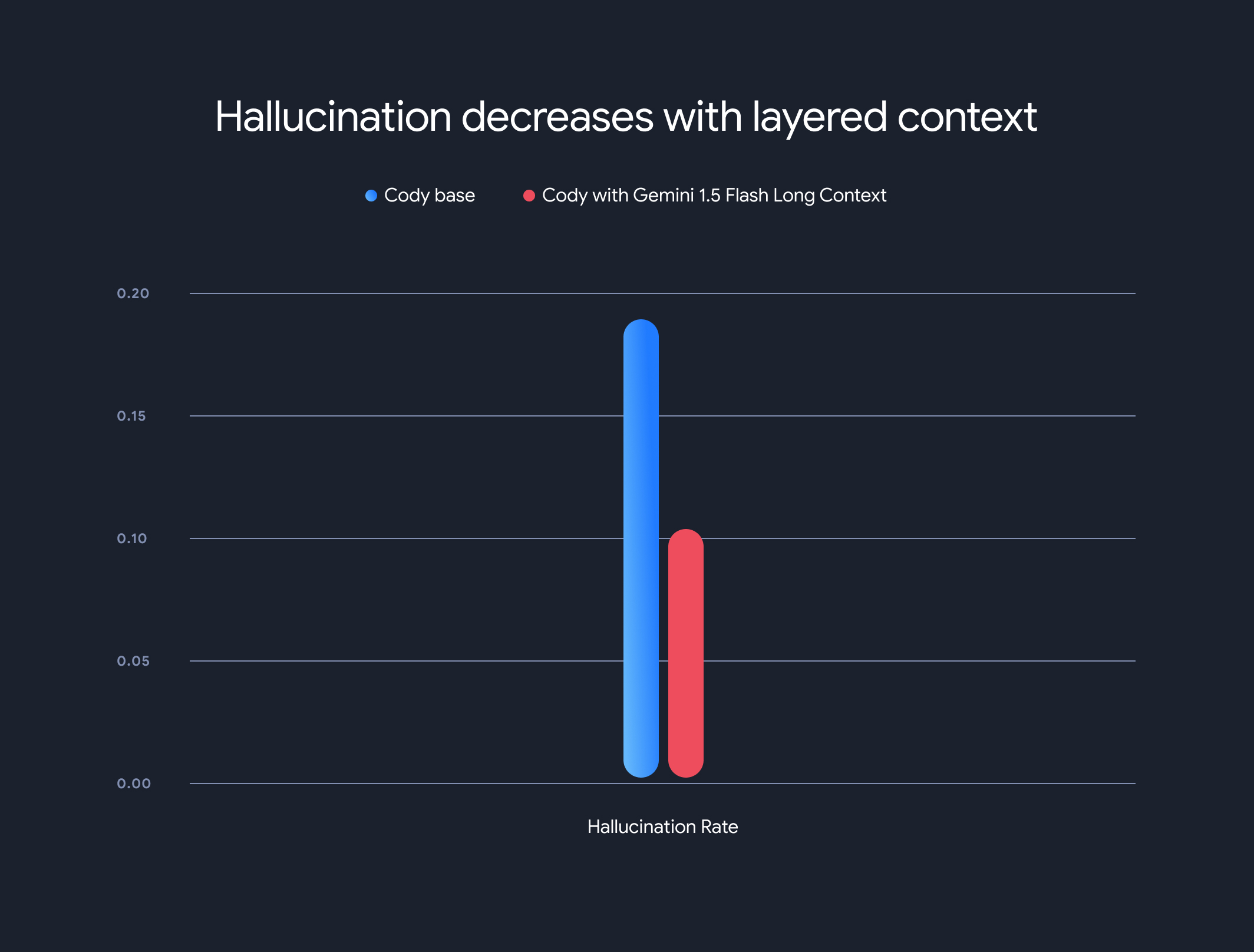

علاوه بر این، استفاده از مدلهای با زمینه طولانی، میزان کلی توهم (تولید اطلاعات نادرست واقعی) را به شدت کاهش داد. میزان توهم از ۱۸.۹۷٪ به ۱۰.۴۸٪ کاهش یافت که بهبود قابل توجهی در دقت و قابلیت اطمینان است.

بدهبستانها و جهتگیریهای آینده

اگرچه مزایای متن طولانی قابل توجه است، اما معایبی نیز وجود دارد. زمان اولین توکن به صورت خطی با طول متن افزایش مییابد. برای کاهش این مشکل، Sourcegraph یک مکانیسم پیشواکشی و یک معماری مدل متن لایهای برای ذخیرهسازی وضعیت اجرای مدل پیادهسازی کرد. با مدلهای متن طولانی Gemini 1.5 Flash و Pro، این امر زمان اولین توکن را از 30-40 ثانیه به حدود 5 ثانیه برای متنهای 1 مگابایتی بهینه کرد - پیشرفت قابل توجهی برای تولید کد در زمان واقعی و کمک فنی.

این همکاری، پتانسیل دگرگونکنندهی مدلهای long-context را در ایجاد انقلابی در درک و تولید کد نشان میدهد. ما از همکاری با شرکتهایی مانند Sourcegraph برای ادامهی باز کردن برنامهها و الگوهای نوآورانهتر با پنجرههای متنی بزرگ، هیجانزدهایم.

برای آشنایی عمیقتر با روششناسیهای ارزیابی دقیق، معیارها و تحلیلهای Sourcegraph، از جمله مثالهای کاربردی، پست وبلاگ مفصل آنها را از دست ندهید.

اتاقها

باز کردن قفل تعاملات غنیتر با آواتارها با قابلیتهای متنی و صوتی Gemini 2.0