物件偵測器工作可讓您偵測多個物件類別是否存在,以及這些物件的位置。舉例來說,物件偵測器可在圖片中找出狗。本操作說明將說明如何在 iOS 中使用物件偵測器工作。您可以在 GitHub 上找到這些操作說明中所述的程式碼範例。

您可以查看這個網頁示範,瞭解這項工作的實際運作情形。如要進一步瞭解此任務的功能、模型和設定選項,請參閱總覽。

程式碼範例

MediaPipe Tasks 範例程式碼是 iOS 物件偵測器應用程式的基本實作。這個範例會使用實體 iOS 裝置的相機持續偵測物體,也可以使用裝置相片庫中的圖片和影片,以靜態方式偵測物體。

您可以使用這個應用程式做為自有 iOS 應用程式的起點,或是在修改現有應用程式時參考。物體偵測器範例程式碼託管於 GitHub 上。

下載程式碼

以下操作說明說明如何使用 git 指令列工具,建立範例程式碼的本機副本。

下載程式碼範例:

使用下列指令複製 Git 存放區:

git clone https://github.com/google-ai-edge/mediapipe-samples您可以選擇將 Git 例項設為使用稀疏檢查,這樣就只會取得 Object Detector 範例應用程式的檔案:

cd mediapipe-samples git sparse-checkout init --cone git sparse-checkout set examples/object_detection/ios/

建立範例程式碼的本機版本後,您可以安裝 MediaPipe 工作程式庫、使用 Xcode 開啟專案,然後執行應用程式。如需操作說明,請參閱 iOS 設定指南。

重要元件

以下檔案包含物件偵測器範例應用程式的關鍵程式碼:

- ObjectDetectorService.swift:初始化偵測器、處理模型選取作業,並對輸入資料執行推論。

- CameraViewController.swift:實作即時攝影機影像輸入模式的 UI,並將偵測結果以視覺化方式呈現。

- MediaLibraryViewController.swift:實作靜態圖片和影片檔案輸入模式的 UI,並將偵測結果以視覺化方式呈現。

設定

本節將說明設定開發環境和程式碼專案以使用物體偵測器的關鍵步驟。如要進一步瞭解如何設定開發環境以使用 MediaPipe 工作,包括平台版本需求,請參閱 iOS 專用設定指南。

依附元件

物體偵測器會使用 MediaPipeTasksVision 程式庫,必須使用 CocoaPods 安裝。這個程式庫與 Swift 和 Objective-C 應用程式相容,且不需要任何額外的語言專屬設定。

如需在 macOS 上安裝 CocoaPods 的操作說明,請參閱 CocoaPods 安裝指南。如需有關如何為應用程式建立包含必要 Pod 的 Podfile 的操作說明,請參閱「使用 CocoaPods」一文。

使用下列程式碼,在 Podfile 中新增 MediaPipeTasksVision pod:

target 'MyObjectDetectorApp' do

use_frameworks!

pod 'MediaPipeTasksVision'

end

如果您的應用程式包含單元測試目標,請參閱「iOS 設定指南」,進一步瞭解如何設定 Podfile。

型號

MediaPipe 物件偵測器工作需要與此工作相容的已訓練模型。如要進一步瞭解 Object Detector 可用的訓練模型,請參閱任務總覽的「模型」一節。

選取並下載模型,然後使用 Xcode 將模型新增至專案目錄。如需在 Xcode 專案中新增檔案的操作說明,請參閱「管理 Xcode 專案中的檔案和資料夾」。

使用 BaseOptions.modelAssetPath 屬性指定應用程式套件中的模型路徑。如需程式碼範例,請參閱下一節。

建立工作

您可以呼叫其中一個初始化器,建立物體偵測器工作。ObjectDetector(options:) 初始化函式會設定設定選項的值,包括執行模式、顯示名稱語言代碼、結果上限、信心閾值、類別許可清單和拒絕清單。

如果您不需要使用自訂設定選項初始化的物體偵測器,可以使用 ObjectDetector(modelPath:) 初始化工具,以預設選項建立物體偵測器。如要進一步瞭解設定選項,請參閱「設定總覽」。

物件偵測器工作支援 3 種輸入資料類型:靜態圖片、影片檔案和即時影像串流。根據預設,ObjectDetector(modelPath:) 會初始化靜態圖片的工作。如果您希望工作初始化後處理影片檔案或直播影片串流,請使用 ObjectDetector(options:) 指定影片或直播的執行模式。直播模式也需要額外的 objectDetectorLiveStreamDelegate 設定選項,才能讓物件偵測器將偵測結果以非同步方式傳送至委派函。

請選擇對應於執行模式的分頁,瞭解如何建立工作並執行推論。

Swift

圖片

import MediaPipeTasksVision let modelPath = Bundle.main.path(forResource: "model", ofType: "tflite") let options = ObjectDetectorOptions() options.baseOptions.modelAssetPath = modelPath options.runningMode = .image options.maxResults = 5 let objectDetector = try ObjectDetector(options: options)

影片

import MediaPipeTasksVision let modelPath = Bundle.main.path(forResource: "model", ofType: "tflite") let options = ObjectDetectorOptions() options.baseOptions.modelAssetPath = modelPath options.runningMode = .video options.maxResults = 5 let objectDetector = try ObjectDetector(options: options)

直播

import MediaPipeTasksVision // Class that conforms to the `ObjectDetectorLiveStreamDelegate` protocol and // implements the method that the object detector calls once it // finishes performing detection on each input frame. class ObjectDetectorResultProcessor: NSObject, ObjectDetectorLiveStreamDelegate { func objectDetector( _ objectDetector: ObjectDetector, didFinishDetection objectDetectionResult: ObjectDetectorResult?, timestampInMilliseconds: Int, error: Error?) { // Process the detection result or errors here. } } let modelPath = Bundle.main.path(forResource: "model", ofType: "tflite") let options = ObjectDetectorOptions() options.baseOptions.modelAssetPath = modelPath options.runningMode = .liveStream options.maxResults = 5 // Assign an object of the class to the `objectDetectorLiveStreamDelegate` // property. let processor = ObjectDetectorResultProcessor() options.objectDetectorLiveStreamDelegate = processor let objectDetector = try ObjectDetector(options: options)

Objective-C

圖片

@import MediaPipeTasksVision; NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"model" ofType:@"tflite"]; MPPObjectDetectorOptions *options = [[MPPObjectDetectorOptions alloc] init]; options.baseOptions.modelAssetPath = modelPath; options.runningMode = MPPRunningModeImage; options.maxResults = 5; MPPObjectDetector *objectDetector = [[MPPObjectDetector alloc] initWithOptions:options error:nil];

影片

@import MediaPipeTasksVision; NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"model" ofType:@"tflite"]; MPPObjectDetectorOptions *options = [[MPPObjectDetectorOptions alloc] init]; options.baseOptions.modelAssetPath = modelPath; options.runningMode = MPPRunningModeVideo; options.maxResults = 5; MPPObjectDetector *objectDetector = [[MPPObjectDetector alloc] initWithOptions:options error:nil];

直播

@import MediaPipeTasksVision; // Class that conforms to the `ObjectDetectorLiveStreamDelegate` protocol and // implements the method that the object detector calls once it // finishes performing detection on each input frame. @interface APPObjectDetectorResultProcessor : NSObject@end @implementation MPPObjectDetectorResultProcessor - (void)objectDetector:(MPPObjectDetector *)objectDetector didFinishDetectionWithResult:(MPPObjectDetectorResult *)ObjectDetectorResult timestampInMilliseconds:(NSInteger)timestampInMilliseconds error:(NSError *)error { // Process the detection result or errors here. } @end NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"model" ofType:@"tflite"]; MPPObjectDetectorOptions *options = [[MPPObjectDetectorOptions alloc] init]; options.baseOptions.modelAssetPath = modelPath; options.runningMode = MPPRunningModeLiveStream; options.maxResults = 5; // Assign an object of the class to the `objectDetectorLiveStreamDelegate` // property. APPObjectDetectorResultProcessor *processor = [APPObjectDetectorResultProcessor new]; options.objectDetectorLiveStreamDelegate = processor; MPPObjectDetector *objectDetector = [[MPPObjectDetector alloc] initWithOptions:options error:nil];

設定選項

此工作包含下列 iOS 應用程式的設定選項:

| 選項名稱 | 說明 | 值範圍 | 預設值 |

|---|---|---|---|

runningMode |

設定工作執行模式。共有三種模式: IMAGE:單一圖片輸入模式。 VIDEO:影片解碼影格模式。 LIVE_STREAM:輸入資料 (例如來自攝影機的資料) 的直播模式。在這個模式中,必須呼叫 resultListener,才能設定事件監聽器,以非同步方式接收結果。 |

{RunningMode.image, RunningMode.video, RunningMode.liveStream} |

RunningMode.image |

displayNamesLocales |

設定標籤語言,用於工作模型中繼資料中提供的顯示名稱 (如有)。預設值為英文的 en。您可以使用 TensorFlow Lite Metadata Writer API,在自訂模型的中繼資料中新增本地化標籤。 |

語言代碼 | en |

maxResults |

設定要傳回的最高分數偵測結果選用數量上限。 | 任何正數 | -1 (傳回所有結果) |

scoreThreshold |

設定預測分數門檻,覆寫模型中繼資料中提供的門檻 (如果有)。低於這個值的結果會遭到拒絕。 | 任何浮點 | 未設定 |

categoryAllowlist |

設定允許的選項類別名稱清單。如果不為空白,則偵測結果的類別名稱若不在這個集合中,就會篩除。系統會忽略重複或不明的類別名稱。這個選項與 categoryDenylist 互斥,如果同時使用這兩個選項,系統會傳回錯誤。 |

任何字串 | 未設定 |

categoryDenylist |

設定選用的不允許類別名稱清單。如果不為空白,系統會篩除偵測結果中類別名稱屬於這個集合的結果。系統會忽略重複或不明的類別名稱。這個選項與 categoryAllowlist 互斥,如果同時使用這兩個選項,會導致錯誤。 |

任何字串 | 未設定 |

直播設定

當執行模式設為直播時,物件偵測器需要額外的 objectDetectorLiveStreamDelegate 設定選項,才能讓偵測器以非同步方式提供偵測結果。委派會實作 objectDetector(_objectDetector:didFinishDetection:timestampInMilliseconds:error:) 方法,物件偵測器會在處理每個影格偵測結果後呼叫此方法。

| 選項名稱 | 說明 | 值範圍 | 預設值 |

|---|---|---|---|

objectDetectorLiveStreamDelegate |

讓物件偵測器在直播模式下以非同步方式接收偵測結果。將例項設為此屬性的類別必須實作 objectDetector(_:didFinishDetection:timestampInMilliseconds:error:) 方法。 |

不適用 | 未設定 |

準備資料

您必須先將輸入圖片或影格轉換為 MPImage 物件,才能將其傳遞至物件偵測器。MPImage 支援不同類型的 iOS 圖片格式,並可在任何執行模式下用於推論。如要進一步瞭解 MPImage,請參閱 MPImage API。

請根據用途和應用程式所需的執行模式,選擇 iOS 圖片格式。MPImage 接受 UIImage、CVPixelBuffer 和 CMSampleBuffer iOS 圖片格式。

UIImage

UIImage 格式非常適合下列執行模式:

圖片:應用程式套件、使用者相片庫或檔案系統中的圖片,如果以

UIImage圖片格式編碼,即可轉換為MPImage物件。影片:使用 AVAssetImageGenerator 將影片影格擷取為 CGImage 格式,然後轉換為

UIImage圖片。

Swift

// Load an image on the user's device as an iOS `UIImage` object. // Convert the `UIImage` object to a MediaPipe's Image object having the default // orientation `UIImage.Orientation.up`. let image = try MPImage(uiImage: image)

Objective-C

// Load an image on the user's device as an iOS `UIImage` object. // Convert the `UIImage` object to a MediaPipe's Image object having the default // orientation `UIImageOrientationUp`. MPImage *image = [[MPPImage alloc] initWithUIImage:image error:nil];

這個範例會使用預設的 UIImage.Orientation.Up 方向初始化 MPImage。您可以使用任何支援的 UIImage.Orientation 值初始化 MPImage。物件偵測器不支援鏡像方向,例如 .upMirrored、.downMirrored、.leftMirrored、.rightMirrored。

如要進一步瞭解 UIImage,請參閱 UIImage Apple 開發人員說明文件。

CVPixelBuffer

CVPixelBuffer 格式非常適合用於產生影格,並使用 iOS CoreImage 架構進行處理的應用程式。

CVPixelBuffer 格式非常適合下列執行模式:

圖片:如果應用程式在使用 iOS 的

CoreImage架構進行一些處理後產生CVPixelBuffer圖片,則可在圖片執行模式下傳送至物件偵測器。影片:可將影片影格轉換為

CVPixelBuffer格式進行處理,然後以影片模式傳送至物件偵測器。直播:使用 iOS 相機產生影格時,應用程式可能會先將影格轉換為

CVPixelBuffer格式進行處理,再以直播模式傳送至物件偵測器。

Swift

// Obtain a CVPixelBuffer. // Convert the `CVPixelBuffer` object to a MediaPipe's Image object having the default // orientation `UIImage.Orientation.up`. let image = try MPImage(pixelBuffer: pixelBuffer)

Objective-C

// Obtain a CVPixelBuffer. // Convert the `CVPixelBuffer` object to a MediaPipe's Image object having the // default orientation `UIImageOrientationUp`. MPImage *image = [[MPPImage alloc] initWithUIImage:image error:nil];

如要進一步瞭解 CVPixelBuffer,請參閱 CVPixelBuffer Apple 開發人員說明文件。

CMSampleBuffer

CMSampleBuffer 格式會儲存統一媒體類型的媒體樣本,非常適合直播執行模式。iOS AVCaptureVideoDataOutput 會以 CMSampleBuffer 格式,以非同步方式傳送 iOS 攝影機的即時影格。

Swift

// Obtain a CMSampleBuffer. // Convert the `CMSampleBuffer` object to a MediaPipe's Image object having the default // orientation `UIImage.Orientation.up`. let image = try MPImage(sampleBuffer: sampleBuffer)

Objective-C

// Obtain a `CMSampleBuffer`. // Convert the `CMSampleBuffer` object to a MediaPipe's Image object having the // default orientation `UIImageOrientationUp`. MPImage *image = [[MPPImage alloc] initWithSampleBuffer:sampleBuffer error:nil];

如要進一步瞭解 CMSampleBuffer,請參閱 CMSampleBuffer Apple 開發人員說明文件。

執行工作

如要執行物體偵測器,請使用指派的執行模式專用的 detect() 方法:

- 靜態圖片:

detect(image:) - 影片:

detect(videoFrame:timestampInMilliseconds:) - livestream:

detectAsync(image:)

以下程式碼範例提供基本範例,說明如何在這些不同的執行模式下執行物體偵測器:

Swift

圖片

let objectDetector.detect(image:image)

影片

let objectDetector.detect(videoFrame:image)

直播

let objectDetector.detectAsync(image:image)

Objective-C

圖片

MPPObjectDetectorResult *result = [objectDetector detectInImage:image error:nil];

影片

MPPObjectDetectorResult *result = [objectDetector detectInVideoFrame:image timestampInMilliseconds:timestamp error:nil];

直播

BOOL success = [objectDetector detectAsyncInImage:image timestampInMilliseconds:timestamp error:nil];

物件偵測器程式碼範例會更詳細說明這些模式的實作方式,包括 detect(image:)、detect(videoFrame:) 和 detectAsync(image:)。程式碼範例可讓使用者切換處理模式,但這可能不是您用途所需。

注意事項:

在影片模式或直播模式下執行時,您也必須向物件偵測器工作提供輸入影格時間戳記。

在圖片或影片模式下執行時,物件偵測器工作會阻斷目前的執行緒,直到處理完輸入圖片或影格為止。為避免阻斷目前執行緒,請使用 iOS Dispatch 或 NSOperation 架構,在背景執行緒中執行處理作業。

在直播模式下執行時,物件偵測器工作會立即傳回,且不會封鎖目前的執行緒。在處理每個輸入影格後,會使用檢測結果呼叫

objectDetector(_objectDetector:didFinishDetection:timestampInMilliseconds:error:)方法。物件偵測器會在專屬的序列調度佇列上非同步叫用這個方法。如要在使用者介面上顯示結果,請在處理結果後將結果調度至主佇列。如果在物件偵測器工作忙於處理其他影格時呼叫detectAsync函式,物件偵測器會忽略新的輸入影格。

處理及顯示結果

執行推論後,物件偵測器工作會傳回 ObjectDetectorResult 物件,該物件會描述在輸入圖片中找到的物件。

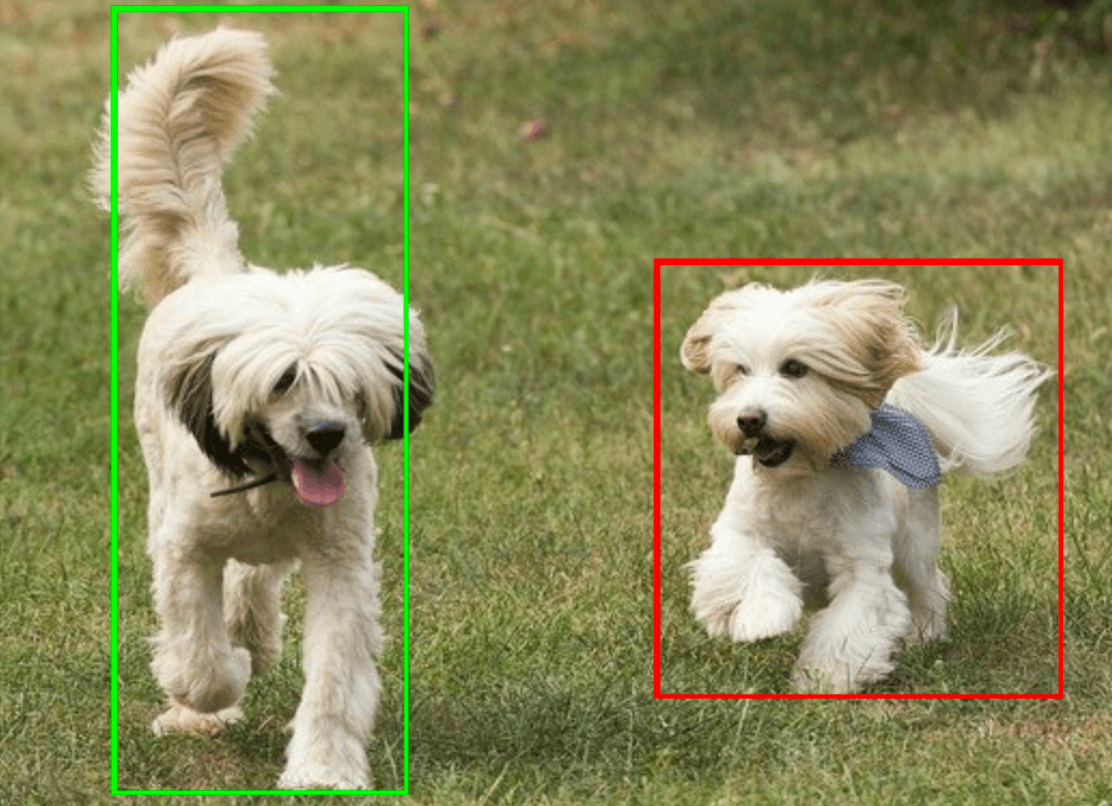

以下是這項工作的輸出資料範例:

ObjectDetectorResult:

Detection #0:

Box: (x: 355, y: 133, w: 190, h: 206)

Categories:

index : 17

score : 0.73828

class name : dog

Detection #1:

Box: (x: 103, y: 15, w: 138, h: 369)

Categories:

index : 17

score : 0.73047

class name : dog

下圖是工作輸出內容的視覺化呈現:

物件偵測器範例程式碼示範如何顯示工作傳回的偵測結果,請參閱程式碼範例瞭解詳情。