جمینی ۳ هوشمندترین خانواده مدل ما تا به امروز است که بر پایه استدلال پیشرفته ساخته شده است. این مدل به گونهای طراحی شده است که با تسلط بر گردشهای کاری عاملمحور، کدنویسی خودکار و وظایف پیچیده چندوجهی، هر ایدهای را به واقعیت تبدیل کند. این راهنما ویژگیهای کلیدی خانواده مدل جمینی ۳ و نحوه بهرهبرداری هرچه بیشتر از آن را پوشش میدهد.

مجموعه برنامههای Gemini 3 ما را بررسی کنید تا ببینید که چگونه این مدل، استدلال پیشرفته، کدنویسی خودکار و وظایف پیچیده چندوجهی را مدیریت میکند.

با چند خط کد شروع کنید:

پایتون

from google import genai

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents="Find the race condition in this multi-threaded C++ snippet: [code here]",

)

print(response.text)

جاوا اسکریپت

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

async function run() {

const response = await ai.models.generateContent({

model: "gemini-3-pro-preview",

contents: "Find the race condition in this multi-threaded C++ snippet: [code here]",

});

console.log(response.text);

}

run();

استراحت

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "Find the race condition in this multi-threaded C++ snippet: [code here]"}]

}]

}'

با سری Gemini 3 آشنا شوید

Gemini 3 Pro، اولین مدل از سری جدید، برای کارهای پیچیدهای که نیاز به دانش جهانی گسترده و استدلال پیشرفته در روشهای مختلف دارند، بهترین گزینه است.

جمینی ۳ فلش جدیدترین مدل سری ۳ ما است که از هوش حرفهای در سرعت و قیمت فلش بهره میبرد.

نانو موز پرو (که با نام Gemini 3 Pro Image نیز شناخته میشود) باکیفیتترین مدل تولید تصویر ما تاکنون است.

تمام مدلهای Gemini 3 در حال حاضر در مرحله پیشنمایش هستند.

| شناسه مدل | پنجره زمینه (ورودی/خروجی) | حد دانش | قیمتگذاری (ورودی / خروجی)* |

|---|---|---|---|

| پیشنمایش gemini-3-pro | ۱ میلیون / ۶۴ هزار | ژانویه ۲۰۲۵ | ۲ دلار / ۱۲ دلار (کمتر از ۲۰۰ هزار توکن) ۴ دلار / ۱۸ دلار (بیش از ۲۰۰ هزار توکن) |

| پیشنمایش gemini-3-flash | ۱ میلیون / ۶۴ هزار | ژانویه ۲۰۲۵ | ۰.۵۰ دلار / ۳ دلار |

| پیشنمایش تصویر gemini 3 pro | ۶۵ هزار / ۳۲ هزار | ژانویه ۲۰۲۵ | $2 (ورودی متن) / $0.134 (خروجی تصویر)** |

* قیمتگذاری به ازای هر ۱ میلیون توکن است، مگر اینکه خلاف آن ذکر شده باشد. ** قیمتگذاری تصویر بر اساس وضوح تصویر متفاوت است. برای جزئیات بیشتر به صفحه قیمتگذاری مراجعه کنید.

برای اطلاع از جزئیات محدودیتها، قیمتگذاری و اطلاعات بیشتر، به صفحه مدلها مراجعه کنید.

ویژگیهای جدید API در Gemini 3

Gemini 3 پارامترهای جدیدی را معرفی میکند که برای کنترل بیشتر توسعهدهندگان بر تأخیر، هزینه و وفاداری چندوجهی طراحی شدهاند.

سطح تفکر

مدلهای سری Gemini 3 به طور پیشفرض از تفکر پویا برای استدلال از طریق دستورالعملها استفاده میکنند. میتوانید از پارامتر thinking_level استفاده کنید که حداکثر عمق فرآیند استدلال داخلی مدل را قبل از تولید پاسخ کنترل میکند. Gemini 3 این سطوح را به عنوان مجوزهای نسبی برای تفکر در نظر میگیرد، نه به عنوان تضمینهای دقیق توکن.

اگر thinking_level مشخص نشده باشد، Gemini 3 به طور پیشفرض روی high تنظیم میشود. برای پاسخهای سریعتر و با تأخیر کمتر، زمانی که استدلال پیچیده مورد نیاز نیست، میتوانید سطح تفکر مدل را روی low محدود کنید.

سطوح تفکر Gemini 3 Pro و Flash:

سطوح تفکر زیر توسط Gemini 3 Pro و Flash پشتیبانی میشوند:

-

low: تأخیر و هزینه را به حداقل میرساند. بهترین گزینه برای دنبال کردن دستورالعملهای ساده، چت یا برنامههای کاربردی با توان عملیاتی بالا. -

high(پیشفرض، پویا): عمق استدلال را به حداکثر میرساند. ممکن است مدل برای رسیدن به اولین نشانه به طور قابل توجهی زمان بیشتری صرف کند، اما خروجی با دقت بیشتری استدلال خواهد شد.

سطح تفکر فلش Gemini 3

علاوه بر سطوح فوق، Gemini 3 Flash از سطوح تفکر زیر نیز پشتیبانی میکند که در حال حاضر توسط Gemini 3 Pro پشتیبانی نمیشوند:

minimal: با تنظیمات «بدون تفکر» برای اکثر پرسوجوها مطابقت دارد. مدل ممکن است برای وظایف کدنویسی پیچیده بسیار مینیمال فکر کند. تأخیر را برای چت یا برنامههای با توان عملیاتی بالا به حداقل میرساند.medium: تفکر متعادل برای اکثر وظایف.

پایتون

from google import genai

from google.genai import types

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents="How does AI work?",

config=types.GenerateContentConfig(

thinking_config=types.ThinkingConfig(thinking_level="low")

),

)

print(response.text)

جاوا اسکریپت

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

const response = await ai.models.generateContent({

model: "gemini-3-pro-preview",

contents: "How does AI work?",

config: {

thinkingConfig: {

thinkingLevel: "low",

}

},

});

console.log(response.text);

استراحت

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "How does AI work?"}]

}],

"generationConfig": {

"thinkingConfig": {

"thinkingLevel": "low"

}

}

}'

وضوح رسانه

Gemini 3 از طریق پارامتر media_resolution کنترل دقیقی بر پردازش بینایی چندوجهی ارائه میدهد. وضوح بالاتر، توانایی مدل را در خواندن متنهای ریز یا شناسایی جزئیات کوچک بهبود میبخشد، اما استفاده از توکن و تأخیر را افزایش میدهد. پارامتر media_resolution حداکثر تعداد توکنهای اختصاص داده شده به ازای هر تصویر یا فریم ویدیویی ورودی را تعیین میکند.

اکنون میتوانید وضوح را برای هر بخش رسانهای جداگانه یا به صورت سراسری (از طریق generation_config ، که برای وضوح فوقالعاده بالا در دسترس نیست) روی media_resolution_low ، media_resolution_medium ، media_resolution_high یا media_resolution_ultra_high تنظیم کنید. در صورت عدم تعیین مقدار، مدل از مقادیر پیشفرض بهینه بر اساس نوع رسانه استفاده میکند.

تنظیمات توصیه شده

| نوع رسانه | تنظیمات توصیه شده | حداکثر توکنها | راهنمای استفاده |

|---|---|---|---|

| تصاویر | media_resolution_high | ۱۱۲۰ | برای اطمینان از حداکثر کیفیت، برای اکثر وظایف تحلیل تصویر توصیه میشود. |

| فایلهای PDF | media_resolution_medium | ۵۶۰ | برای درک اسناد بهینه است؛ کیفیت معمولاً در medium اشباع میشود. افزایش به high به ندرت نتایج OCR را برای اسناد استاندارد بهبود میبخشد. |

| ویدئو (عمومی) | media_resolution_low (یا media_resolution_medium ) | ۷۰ (در هر فریم) | توجه: برای ویدیو، تنظیمات low و medium به طور یکسان (70 توکن) در نظر گرفته میشوند تا استفاده از متن بهینه شود. این برای اکثر وظایف تشخیص و توصیف عمل کافی است. |

| ویدئو (پر از متن) | media_resolution_high | ۲۸۰ (در هر فریم) | فقط زمانی مورد نیاز است که مورد استفاده شامل خواندن متنهای متراکم (OCR) یا جزئیات کوچک در فریمهای ویدیویی باشد. |

پایتون

from google import genai

from google.genai import types

import base64

# The media_resolution parameter is currently only available in the v1alpha API version.

client = genai.Client(http_options={'api_version': 'v1alpha'})

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents=[

types.Content(

parts=[

types.Part(text="What is in this image?"),

types.Part(

inline_data=types.Blob(

mime_type="image/jpeg",

data=base64.b64decode("..."),

),

media_resolution={"level": "media_resolution_high"}

)

]

)

]

)

print(response.text)

جاوا اسکریپت

import { GoogleGenAI } from "@google/genai";

// The media_resolution parameter is currently only available in the v1alpha API version.

const ai = new GoogleGenAI({ apiVersion: "v1alpha" });

async function run() {

const response = await ai.models.generateContent({

model: "gemini-3-pro-preview",

contents: [

{

parts: [

{ text: "What is in this image?" },

{

inlineData: {

mimeType: "image/jpeg",

data: "...",

},

mediaResolution: {

level: "media_resolution_high"

}

}

]

}

]

});

console.log(response.text);

}

run();

استراحت

curl "https://generativelanguage.googleapis.com/v1alpha/models/gemini-3-pro-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [

{ "text": "What is in this image?" },

{

"inlineData": {

"mimeType": "image/jpeg",

"data": "..."

},

"mediaResolution": {

"level": "media_resolution_high"

}

}

]

}]

}'

دما

برای Gemini 3، اکیداً توصیه میکنیم پارامتر دما را در مقدار پیشفرض 1.0 نگه دارید.

در حالی که مدلهای قبلی اغلب از تنظیم دما برای کنترل خلاقیت در مقابل جبرگرایی بهره میبردند، قابلیتهای استدلال Gemini 3 برای تنظیم پیشفرض بهینه شدهاند. تغییر دما (تنظیم آن زیر ۱.۰) ممکن است منجر به رفتار غیرمنتظرهای مانند حلقه زدن یا کاهش عملکرد، به ویژه در کارهای پیچیده ریاضی یا استدلالی شود.

امضاهای فکری

Gemini 3 از امضاهای فکری برای حفظ زمینه استدلال در طول فراخوانیهای API استفاده میکند. این امضاها، نمایشهای رمزگذاریشده از فرآیند تفکر داخلی مدل هستند. برای اطمینان از اینکه مدل قابلیتهای استدلال خود را حفظ میکند، باید این امضاها را دقیقاً همانطور که دریافت شدهاند، در درخواست خود به مدل برگردانید:

فراخوانی تابع (دقیق): API اعتبارسنجی دقیقی را روی "نوبت فعلی" اعمال میکند. فقدان امضاها منجر به خطای ۴۰۰ خواهد شد.

متن/چت: اعتبارسنجی به طور جدی اجرا نمیشود، اما حذف امضاها باعث کاهش کیفیت استدلال و پاسخ مدل میشود.

تولید/ویرایش تصویر (دقیق) : این API اعتبارسنجی دقیقی را روی تمام بخشهای مدل از جمله

thoughtSignatureاعمال میکند. فقدان امضاها منجر به خطای ۴۰۰ خواهد شد.

فراخوانی تابع (اعتبارسنجی دقیق)

وقتی Gemini یک functionCall تولید میکند، برای پردازش صحیح خروجی ابزار در نوبت بعدی به thoughtSignature متکی است. "نوبت فعلی" شامل تمام مراحل Model ( functionCall ) و User ( functionResponse ) است که از آخرین پیام text استاندارد User رخ دادهاند.

- فراخوانی تکتابع: بخش

functionCallشامل یک امضا است. شما باید آن را برگردانید. - فراخوانیهای موازی تابع: فقط اولین بخش

functionCallدر لیست شامل امضا خواهد بود. شما باید بخشها را دقیقاً به ترتیب دریافت شده برگردانید. - چند مرحلهای (ترتیبی): اگر مدل یک ابزار را فراخوانی کند، نتیجهای را دریافت کند و ابزار دیگری را (در همان نوبت) فراخوانی کند، هر دو فراخوانی تابع دارای امضا هستند. شما باید تمام امضاهای انباشته شده در تاریخچه را برگردانید.

متن و پخش جریانی

برای چت یا تولید متن استاندارد، وجود امضا تضمین نمیشود.

- غیر-جریانی : بخش پایانی محتوای پاسخ ممکن است حاوی یک

thoughtSignatureباشد، هرچند که همیشه وجود ندارد. اگر چنین چیزی برگردانده شود، باید آن را برای حفظ بهترین عملکرد، دوباره ارسال کنید. - جریانسازی : اگر امضایی تولید شود، ممکن است در یک بخش نهایی که حاوی یک بخش متنی خالی است، دریافت شود. مطمئن شوید که تجزیهگر جریان شما حتی اگر فیلد متنی خالی باشد، امضاها را بررسی میکند.

تولید و ویرایش تصویر

برای gemini-3-pro-image-preview ، امضاهای فکری برای ویرایش محاورهای بسیار مهم هستند. وقتی از مدل میخواهید تصویری را تغییر دهد، برای درک ترکیب و منطق تصویر اصلی به thoughtSignature نوبت قبلی متکی است.

- ویرایش: امضاها در اولین بخش پس از افکار پاسخ (

textیاinlineData) و در هر بخشinlineDataبعدی تضمین میشوند. برای جلوگیری از خطا، باید تمام این امضاها را برگردانید.

مثالهای کد

فراخوانی تابع چند مرحلهای (ترتیبی)

کاربر سوالی میپرسد که مستلزم دو مرحله جداگانه (بررسی پرواز -> رزرو تاکسی) در یک نوبت است.

مرحله ۱: فراخوانی مدل با ابزار پرواز.

مدل یک امضا <Sig_A> برمیگرداند.

// Model Response (Turn 1, Step 1) { "role": "model", "parts": [ { "functionCall": { "name": "check_flight", "args": {...} }, "thoughtSignature": "<Sig_A>" // SAVE THIS } ] }

مرحله ۲: کاربر نتیجه پرواز را ارسال میکند

ما باید <Sig_A> برای حفظ روند فکری مدل، برگردانیم.

// User Request (Turn 1, Step 2) [ { "role": "user", "parts": [{ "text": "Check flight AA100..." }] }, { "role": "model", "parts": [ { "functionCall": { "name": "check_flight", "args": {...} }, "thoughtSignature": "<Sig_A>" // REQUIRED } ] }, { "role": "user", "parts": [{ "functionResponse": { "name": "check_flight", "response": {...} } }] } ]

مرحله ۳: فراخوانیهای مدل ابزار تاکسی

مدل از طریق <Sig_A> تأخیر پرواز را به خاطر میسپارد و اکنون تصمیم میگیرد تاکسی رزرو کند. این مدل یک امضای جدید <Sig_B> تولید میکند.

// Model Response (Turn 1, Step 3) { "role": "model", "parts": [ { "functionCall": { "name": "book_taxi", "args": {...} }, "thoughtSignature": "<Sig_B>" // SAVE THIS } ] }

مرحله ۴: کاربر نتیجه تاکسی را ارسال میکند

برای تکمیل نوبت، باید کل زنجیره را برگردانید: <Sig_A> و <Sig_B> .

// User Request (Turn 1, Step 4) [ // ... previous history ... { "role": "model", "parts": [ { "functionCall": { "name": "check_flight", ... }, "thoughtSignature": "<Sig_A>" } ] }, { "role": "user", "parts": [{ "functionResponse": {...} }] }, { "role": "model", "parts": [ { "functionCall": { "name": "book_taxi", ... }, "thoughtSignature": "<Sig_B>" } ] }, { "role": "user", "parts": [{ "functionResponse": {...} }] } ]

فراخوانی موازی توابع

کاربر میپرسد: «آب و هوای پاریس و لندن را بررسی کن.» مدل دو فراخوانی تابع را در یک پاسخ برمیگرداند.

// User Request (Sending Parallel Results) [ { "role": "user", "parts": [ { "text": "Check the weather in Paris and London." } ] }, { "role": "model", "parts": [ // 1. First Function Call has the signature { "functionCall": { "name": "check_weather", "args": { "city": "Paris" } }, "thoughtSignature": "<Signature_A>" }, // 2. Subsequent parallel calls DO NOT have signatures { "functionCall": { "name": "check_weather", "args": { "city": "London" } } } ] }, { "role": "user", "parts": [ // 3. Function Responses are grouped together in the next block { "functionResponse": { "name": "check_weather", "response": { "temp": "15C" } } }, { "functionResponse": { "name": "check_weather", "response": { "temp": "12C" } } } ] } ]

استدلال متنی/درون متنی (بدون اعتبارسنجی)

کاربر سوالی میپرسد که نیاز به استدلال درون متنی و بدون ابزار خارجی دارد. اگرچه اعتبارسنجی دقیقی انجام نشده است، اما گنجاندن امضا به مدل کمک میکند تا زنجیره استدلال را برای سوالات بعدی حفظ کند.

// User Request (Follow-up question) [ { "role": "user", "parts": [{ "text": "What are the risks of this investment?" }] }, { "role": "model", "parts": [ { "text": "I need to calculate the risk step-by-step. First, I'll look at volatility...", "thoughtSignature": "<Signature_C>" // Recommended to include } ] }, { "role": "user", "parts": [{ "text": "Summarize that in one sentence." }] } ]

تولید و ویرایش تصویر

برای تولید تصویر، امضاها به شدت اعتبارسنجی میشوند. آنها در قسمت اول (متن یا تصویر) و تمام قسمتهای بعدی تصویر ظاهر میشوند. همه باید در نوبت بعدی بازگردانده شوند.

// Model Response (Turn 1) { "role": "model", "parts": [ // 1. First part ALWAYS has a signature (even if text) { "text": "I will generate a cyberpunk city...", "thoughtSignature": "<Signature_D>" }, // 2. ALL InlineData (Image) parts ALWAYS have signatures { "inlineData": { ... }, "thoughtSignature": "<Signature_E>" }, ] } // User Request (Turn 2 - Requesting an Edit) { "contents": [ // History must include ALL signatures received { "role": "user", "parts": [{ "text": "Generate a cyberpunk city" }] }, { "role": "model", "parts": [ { "text": "...", "thoughtSignature": "<Signature_D>" }, { "inlineData": "...", "thoughtSignature": "<Signature_E>" }, ] }, // New User Prompt { "role": "user", "parts": [{ "text": "Make it daytime." }] } ] }

مهاجرت از مدلهای دیگر

اگر در حال انتقال یک رد مکالمه از مدل دیگری (مثلاً Gemini 2.5) هستید یا یک فراخوانی تابع سفارشی را که توسط Gemini 3 تولید نشده است، تزریق میکنید، امضای معتبری نخواهید داشت.

برای دور زدن اعتبارسنجی دقیق در این سناریوهای خاص، فیلد را با این رشتهی ساختگی خاص پر کنید: "thoughtSignature": "context_engineering_is_the_way_to_go"

خروجیهای ساختاریافته با ابزارها

مدلهای Gemini 3 به شما امکان میدهند خروجیهای ساختاریافته را با ابزارهای داخلی، از جمله Grounding with Google Search ، URL Context ، Code Execution و Function Calling، ترکیب کنید.

پایتون

from google import genai

from google.genai import types

from pydantic import BaseModel, Field

from typing import List

class MatchResult(BaseModel):

winner: str = Field(description="The name of the winner.")

final_match_score: str = Field(description="The final match score.")

scorers: List[str] = Field(description="The name of the scorer.")

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents="Search for all details for the latest Euro.",

config={

"tools": [

{"google_search": {}},

{"url_context": {}}

],

"response_mime_type": "application/json",

"response_json_schema": MatchResult.model_json_schema(),

},

)

result = MatchResult.model_validate_json(response.text)

print(result)

جاوا اسکریپت

import { GoogleGenAI } from "@google/genai";

import { z } from "zod";

import { zodToJsonSchema } from "zod-to-json-schema";

const ai = new GoogleGenAI({});

const matchSchema = z.object({

winner: z.string().describe("The name of the winner."),

final_match_score: z.string().describe("The final score."),

scorers: z.array(z.string()).describe("The name of the scorer.")

});

async function run() {

const response = await ai.models.generateContent({

model: "gemini-3-pro-preview",

contents: "Search for all details for the latest Euro.",

config: {

tools: [

{ googleSearch: {} },

{ urlContext: {} }

],

responseMimeType: "application/json",

responseJsonSchema: zodToJsonSchema(matchSchema),

},

});

const match = matchSchema.parse(JSON.parse(response.text));

console.log(match);

}

run();

استراحت

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "Search for all details for the latest Euro."}]

}],

"tools": [

{"googleSearch": {}},

{"urlContext": {}}

],

"generationConfig": {

"responseMimeType": "application/json",

"responseJsonSchema": {

"type": "object",

"properties": {

"winner": {"type": "string", "description": "The name of the winner."},

"final_match_score": {"type": "string", "description": "The final score."},

"scorers": {

"type": "array",

"items": {"type": "string"},

"description": "The name of the scorer."

}

},

"required": ["winner", "final_match_score", "scorers"]

}

}

}'

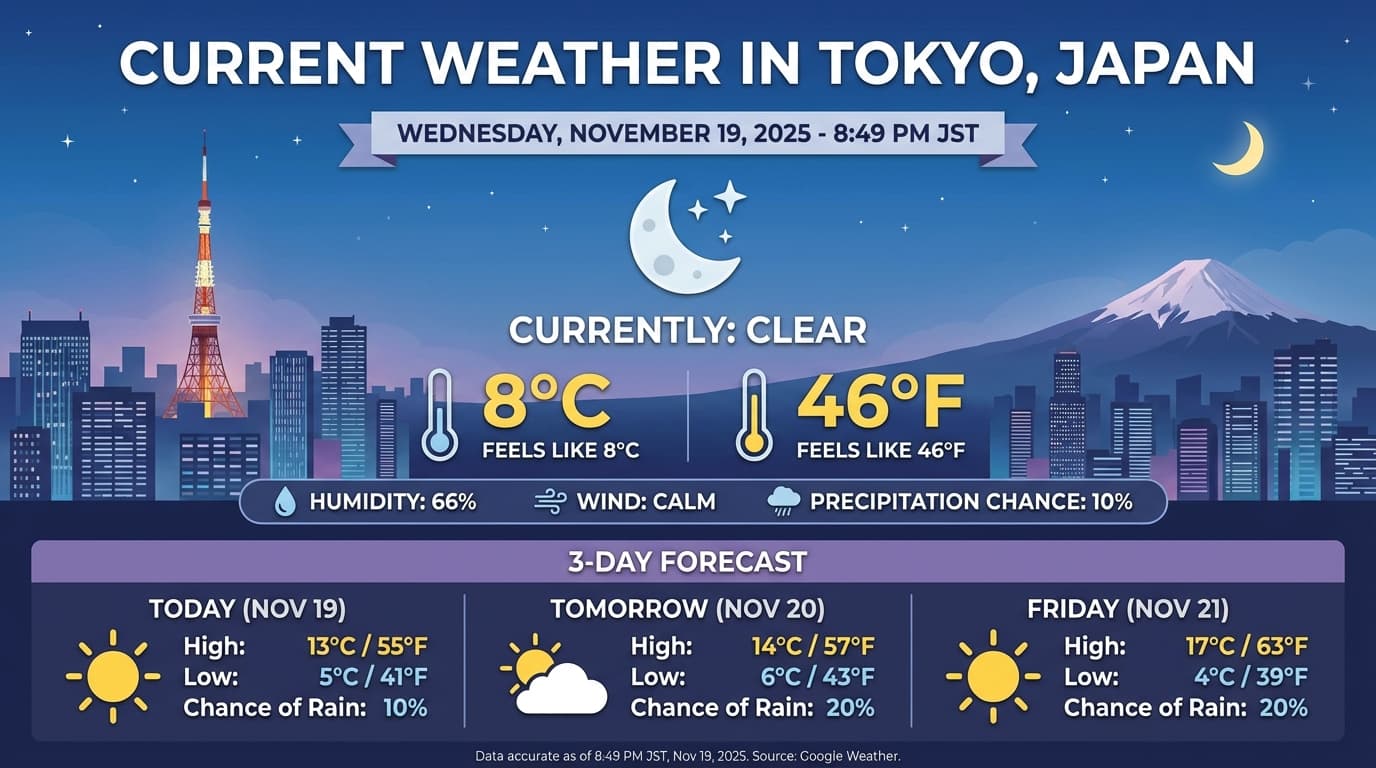

تولید تصویر

نرمافزار Gemini 3 Pro Image به شما امکان میدهد تصاویر را از متنهای پیشنهادی تولید و ویرایش کنید. این نرمافزار از استدلال برای «فکر کردن» در مورد یک متن پیشنهادی استفاده میکند و میتواند دادههای بلادرنگ - مانند پیشبینی آب و هوا یا نمودارهای سهام - را قبل از استفاده از جستجوی گوگل و قبل از تولید تصاویر با کیفیت بالا، بازیابی کند.

قابلیتهای جدید و بهبود یافته:

- رندر متن و کیفیت 4K: متن و نمودارهای واضح و خوانا را با وضوح حداکثر 2K و 4K تولید کنید.

- تولید مبتنی بر داده: از ابزار

google_searchبرای تأیید حقایق و تولید تصاویر بر اساس اطلاعات دنیای واقعی استفاده کنید. - ویرایش محاورهای: ویرایش تصویر چند مرحلهای با درخواست تغییرات ساده (مثلاً «پسزمینه را به غروب آفتاب تبدیل کنید»). این گردش کار برای حفظ زمینه بصری بین نوبتها به Thought Signatures متکی است.

برای جزئیات کامل در مورد نسبتهای ابعاد، گردشهای کاری ویرایش و گزینههای پیکربندی، به راهنمای تولید تصویر مراجعه کنید.

پایتون

from google import genai

from google.genai import types

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-pro-image-preview",

contents="Generate an infographic of the current weather in Tokyo.",

config=types.GenerateContentConfig(

tools=[{"google_search": {}}],

image_config=types.ImageConfig(

aspect_ratio="16:9",

image_size="4K"

)

)

)

image_parts = [part for part in response.parts if part.inline_data]

if image_parts:

image = image_parts[0].as_image()

image.save('weather_tokyo.png')

image.show()

جاوا اسکریپت

import { GoogleGenAI } from "@google/genai";

import * as fs from "node:fs";

const ai = new GoogleGenAI({});

async function run() {

const response = await ai.models.generateContent({

model: "gemini-3-pro-image-preview",

contents: "Generate a visualization of the current weather in Tokyo.",

config: {

tools: [{ googleSearch: {} }],

imageConfig: {

aspectRatio: "16:9",

imageSize: "4K"

}

}

});

for (const part of response.candidates[0].content.parts) {

if (part.inlineData) {

const imageData = part.inlineData.data;

const buffer = Buffer.from(imageData, "base64");

fs.writeFileSync("weather_tokyo.png", buffer);

}

}

}

run();

استراحت

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-image-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "Generate a visualization of the current weather in Tokyo."}]

}],

"tools": [{"googleSearch": {}}],

"generationConfig": {

"imageConfig": {

"aspectRatio": "16:9",

"imageSize": "4K"

}

}

}'

پاسخ نمونه

اجرای کد با تصاویر

Gemini 3 Flash میتواند بینایی را به عنوان یک بررسی فعال، نه فقط یک نگاه ایستا، در نظر بگیرد. با ترکیب استدلال با اجرای کد ، مدل یک طرح را تدوین میکند، سپس کد پایتون را برای بزرگنمایی، برش، حاشیهنویسی یا دستکاری گام به گام تصاویر مینویسد و اجرا میکند تا پاسخهای خود را به صورت بصری ارائه دهد.

موارد استفاده:

- بزرگنمایی و بازرسی: این مدل به طور ضمنی تشخیص میدهد که جزئیات چه زمانی خیلی کوچک هستند (مثلاً خواندن یک گیج یا شماره سریال از راه دور) و کدی را برای برش و بررسی مجدد ناحیه با وضوح بالاتر مینویسد.

- محاسبات و ترسیم بصری: این مدل میتواند محاسبات چند مرحلهای را با استفاده از کد انجام دهد (مثلاً جمع کردن اقلام خط روی رسید یا تولید نمودار Matplotlib از دادههای استخراج شده).

- حاشیهنویسی تصویر: مدل میتواند فلشها، کادرهای محدودکننده یا سایر حاشیهنویسیها را مستقیماً روی تصاویر رسم کند تا به سؤالات مکانی مانند «این مورد کجا باید قرار گیرد؟» پاسخ دهد.

برای فعال کردن تفکر بصری، اجرای کد را به عنوان یک ابزار پیکربندی کنید. مدل به طور خودکار از کد برای دستکاری تصاویر در صورت نیاز استفاده خواهد کرد.

پایتون

from google import genai

from google.genai import types

import requests

from PIL import Image

import io

image_path = "https://goo.gle/instrument-img"

image_bytes = requests.get(image_path).content

image = types.Part.from_bytes(data=image_bytes, mime_type="image/jpeg")

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents=[

image,

"Zoom into the expression pedals and tell me how many pedals are there?"

],

config=types.GenerateContentConfig(

tools=[types.Tool(code_execution=types.ToolCodeExecution)]

),

)

for part in response.candidates[0].content.parts:

if part.text is not None:

print(part.text)

if part.executable_code is not None:

print(part.executable_code.code)

if part.code_execution_result is not None:

print(part.code_execution_result.output)

if part.as_image() is not None:

display(Image.open(io.BytesIO(part.as_image().image_bytes)))

جاوا اسکریپت

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

async function main() {

const imageUrl = "https://goo.gle/instrument-img";

const response = await fetch(imageUrl);

const imageArrayBuffer = await response.arrayBuffer();

const base64ImageData = Buffer.from(imageArrayBuffer).toString("base64");

const result = await ai.models.generateContent({

model: "gemini-3-flash-preview",

contents: [

{

inlineData: {

mimeType: "image/jpeg",

data: base64ImageData,

},

},

{

text: "Zoom into the expression pedals and tell me how many pedals are there?",

},

],

config: {

tools: [{ codeExecution: {} }],

},

});

for (const part of result.candidates[0].content.parts) {

if (part.text) {

console.log("Text:", part.text);

}

if (part.executableCode) {

console.log("Code:", part.executableCode.code);

}

if (part.codeExecutionResult) {

console.log("Output:", part.codeExecutionResult.output);

}

}

}

main();

استراحت

IMG_URL="https://goo.gle/instrument-img"

MODEL="gemini-3-flash-preview"

MIME_TYPE=$(curl -sIL "$IMG_URL" | grep -i '^content-type:' | awk -F ': ' '{print $2}' | sed 's/\r$//' | head -n 1)

if [[ -z "$MIME_TYPE" || ! "$MIME_TYPE" == image/* ]]; then

MIME_TYPE="image/jpeg"

fi

if [[ "$(uname)" == "Darwin" ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -b 0)

elif [[ "$(base64 --version 2>&1)" = *"FreeBSD"* ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64)

else

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -w0)

fi

curl "https://generativelanguage.googleapis.com/v1beta/models/$MODEL:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts":[

{

"inline_data": {

"mime_type":"'"$MIME_TYPE"'",

"data": "'"$IMAGE_B64"'"

}

},

{"text": "Zoom into the expression pedals and tell me how many pedals are there?"}

]

}],

"tools": [{"code_execution": {}}]

}'

برای جزئیات بیشتر در مورد اجرای کد با تصاویر، به بخش اجرای کد مراجعه کنید.

پاسخهای تابع چندوجهی

فراخوانی تابع چندوجهی به کاربران این امکان را میدهد که پاسخهای تابعی حاوی اشیاء چندوجهی داشته باشند که امکان استفاده بهتر از قابلیتهای فراخوانی تابع مدل را فراهم میکند. فراخوانی تابع استاندارد فقط از پاسخهای تابع مبتنی بر متن پشتیبانی میکند:

پایتون

from google import genai

from google.genai import types

import requests

client = genai.Client()

# This is a manual, two turn multimodal function calling workflow:

# 1. Define the function tool

get_image_declaration = types.FunctionDeclaration(

name="get_image",

description="Retrieves the image file reference for a specific order item.",

parameters={

"type": "object",

"properties": {

"item_name": {

"type": "string",

"description": "The name or description of the item ordered (e.g., 'instrument')."

}

},

"required": ["item_name"],

},

)

tool_config = types.Tool(function_declarations=[get_image_declaration])

# 2. Send a message that triggers the tool

prompt = "Show me the instrument I ordered last month."

response_1 = client.models.generate_content(

model="gemini-3-flash-preview",

contents=[prompt],

config=types.GenerateContentConfig(

tools=[tool_config],

)

)

# 3. Handle the function call

function_call = response_1.function_calls[0]

requested_item = function_call.args["item_name"]

print(f"Model wants to call: {function_call.name}")

# Execute your tool (e.g., call an API)

# (This is a mock response for the example)

print(f"Calling external tool for: {requested_item}")

function_response_data = {

"image_ref": {"$ref": "instrument.jpg"},

}

image_path = "https://goo.gle/instrument-img"

image_bytes = requests.get(image_path).content

function_response_multimodal_data = types.FunctionResponsePart(

inline_data=types.FunctionResponseBlob(

mime_type="image/jpeg",

display_name="instrument.jpg",

data=image_bytes,

)

)

# 4. Send the tool's result back

# Append this turn's messages to history for a final response.

history = [

types.Content(role="user", parts=[types.Part(text=prompt)]),

response_1.candidates[0].content,

types.Content(

role="tool",

parts=[

types.Part.from_function_response(

name=function_call.name,

response=function_response_data,

parts=[function_response_multimodal_data]

)

],

)

]

response_2 = client.models.generate_content(

model="gemini-3-flash-preview",

contents=history,

config=types.GenerateContentConfig(

tools=[tool_config],

thinking_config=types.ThinkingConfig(include_thoughts=True)

),

)

print(f"\nFinal model response: {response_2.text}")

جاوا اسکریپت

import { GoogleGenAI, Type } from '@google/genai';

const client = new GoogleGenAI({ apiKey: process.env.GEMINI_API_KEY });

// This is a manual, two turn multimodal function calling workflow:

// 1. Define the function tool

const getImageDeclaration = {

name: 'get_image',

description: 'Retrieves the image file reference for a specific order item.',

parameters: {

type: Type.OBJECT,

properties: {

item_name: {

type: Type.STRING,

description: "The name or description of the item ordered (e.g., 'instrument').",

},

},

required: ['item_name'],

},

};

const toolConfig = {

functionDeclarations: [getImageDeclaration],

};

// 2. Send a message that triggers the tool

const prompt = 'Show me the instrument I ordered last month.';

const response1 = await client.models.generateContent({

model: 'gemini-3-flash-preview',

contents: prompt,

config: {

tools: [toolConfig],

},

});

// 3. Handle the function call

const functionCall = response1.functionCalls[0];

const requestedItem = functionCall.args.item_name;

console.log(`Model wants to call: ${functionCall.name}`);

// Execute your tool (e.g., call an API)

// (This is a mock response for the example)

console.log(`Calling external tool for: ${requestedItem}`);

const functionResponseData = {

image_ref: { $ref: 'instrument.jpg' },

};

const imageUrl = "https://goo.gle/instrument-img";

const response = await fetch(imageUrl);

const imageArrayBuffer = await response.arrayBuffer();

const base64ImageData = Buffer.from(imageArrayBuffer).toString('base64');

const functionResponseMultimodalData = {

inlineData: {

mimeType: 'image/jpeg',

displayName: 'instrument.jpg',

data: base64ImageData,

},

};

// 4. Send the tool's result back

// Append this turn's messages to history for a final response.

const history = [

{ role: 'user', parts: [{ text: prompt }] },

response1.candidates[0].content,

{

role: 'tool',

parts: [

{

functionResponse: {

name: functionCall.name,

response: functionResponseData,

parts: [functionResponseMultimodalData],

},

},

],

},

];

const response2 = await client.models.generateContent({

model: 'gemini-3-flash-preview',

contents: history,

config: {

tools: [toolConfig],

thinkingConfig: { includeThoughts: true },

},

});

console.log(`\nFinal model response: ${response2.text}`);

استراحت

IMG_URL="https://goo.gle/instrument-img"

MIME_TYPE=$(curl -sIL "$IMG_URL" | grep -i '^content-type:' | awk -F ': ' '{print $2}' | sed 's/\r$//' | head -n 1)

if [[ -z "$MIME_TYPE" || ! "$MIME_TYPE" == image/* ]]; then

MIME_TYPE="image/jpeg"

fi

# Check for macOS

if [[ "$(uname)" == "Darwin" ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -b 0)

elif [[ "$(base64 --version 2>&1)" = *"FreeBSD"* ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64)

else

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -w0)

fi

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-flash-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [

...,

{

"role": "user",

"parts": [

{

"functionResponse": {

"name": "get_image",

"response": {

"image_ref": {

"$ref": "instrument.jpg"

}

},

"parts": [

{

"inlineData": {

"displayName": "instrument.jpg",

"mimeType":"'"$MIME_TYPE"'",

"data": "'"$IMAGE_B64"'"

}

}

]

}

}

]

}

]

}'

مهاجرت از جمینی ۲.۵

جمینی ۳ توانمندترین خانواده مدل ما تا به امروز است و نسبت به جمینی ۲.۵ پیشرفت گام به گامی را ارائه میدهد. هنگام مهاجرت، موارد زیر را در نظر بگیرید:

- تفکر: اگر قبلاً از مهندسی پیچیدهی دستورالعملها (مانند زنجیرهی فکری) برای وادار کردن Gemini 2.5 به استدلال استفاده میکردید، Gemini 3 را با

thinking_level: "high"و دستورالعملهای سادهشده امتحان کنید. - تنظیمات دما: اگر کد موجود شما صریحاً دما را تنظیم میکند (بهویژه برای خروجیهای قطعی روی مقادیر پایین)، توصیه میکنیم این پارامتر را حذف کرده و از مقدار پیشفرض ۱.۰ در Gemini 3 استفاده کنید تا از مشکلات احتمالی حلقه یا کاهش عملکرد در کارهای پیچیده جلوگیری شود.

- درک PDF و اسناد: وضوح پیشفرض OCR برای PDFها تغییر کرده است. اگر برای تجزیه و تحلیل متراکم اسناد به رفتار خاصی متکی بودید، تنظیم جدید

media_resolution_highرا آزمایش کنید تا از دقت مداوم آن اطمینان حاصل شود. - مصرف توکن: مهاجرت به پیشفرضهای Gemini 3 ممکن است استفاده از توکن را برای فایلهای PDF افزایش دهد اما استفاده از توکن را برای ویدیو کاهش دهد . اگر درخواستها اکنون به دلیل وضوح پیشفرض بالاتر از پنجره زمینه فراتر میروند، توصیه میکنیم وضوح رسانه را به صراحت کاهش دهید.

- تقسیمبندی تصویر: قابلیتهای تقسیمبندی تصویر (بازگرداندن ماسکهای سطح پیکسل برای اشیاء) در Gemini 3 Pro یا Gemini 3 Flash پشتیبانی نمیشوند. برای بارهای کاری که نیاز به تقسیمبندی تصویر بومی دارند، توصیه میکنیم به استفاده از Gemini 2.5 Flash با خاموش بودن thinking یا Gemini Robotics-ER 1.5 ادامه دهید.

- استفاده از کامپیوتر: Gemini 3 Pro و Gemini 3 Flash از استفاده از کامپیوتر پشتیبانی میکنند. برخلاف سری ۲.۵، برای دسترسی به ابزار استفاده از کامپیوتر نیازی به استفاده از مدل جداگانهای ندارید.

- پشتیبانی ابزار : اتصال به زمین نقشهها هنوز برای مدلهای Gemini 3 پشتیبانی نمیشود، بنابراین منتقل نخواهد شد. علاوه بر این، ترکیب ابزارهای داخلی با فراخوانی تابع هنوز پشتیبانی نمیشود.

سازگاری با OpenAI

برای کاربرانی که از لایه سازگاری OpenAI استفاده میکنند، پارامترهای استاندارد به طور خودکار به معادلهای Gemini نگاشت میشوند:

-

reasoning_effort(OAI) بهthinking_level(Gemini) نگاشت میشود. توجه داشته باشید کهreasoning_effortمتوسط در Gemini 3 Flash بهthinking_levelبالا نگاشت میشود.

ارائه بهترین شیوهها

جمینی ۳ یک مدل استدلال است که نحوهی ارائهی پیشنهاد را تغییر میدهد.

- دستورالعملهای دقیق: در دستورالعملهای ورودی خود مختصر باشید. Gemini 3 به دستورالعملهای مستقیم و واضح بهترین پاسخ را میدهد. ممکن است تکنیکهای مهندسی دستورالعمل طولانی یا بیش از حد پیچیده مورد استفاده در مدلهای قدیمی را بیش از حد تجزیه و تحلیل کند.

- حجم خروجی: به طور پیشفرض، Gemini 3 کمتر حجم خروجی دارد و ترجیح میدهد پاسخهای مستقیم و کارآمد ارائه دهد. اگر مورد استفاده شما نیاز به یک شخصیت محاورهای یا "پرحرف" دارد، باید صریحاً مدل را در اعلان هدایت کنید (مثلاً "این را به عنوان یک دستیار دوستانه و پرحرف توضیح دهید").

- مدیریت زمینه: هنگام کار با مجموعه دادههای بزرگ (مثلاً کل کتابها، پایگاههای کد یا ویدیوهای طولانی)، دستورالعملها یا سوالات خاص خود را در انتهای دستور، پس از زمینه دادهها قرار دهید. با شروع سوال خود با عبارتی مانند «بر اساس اطلاعات بالا...»، استدلال مدل را به دادههای ارائه شده متصل کنید.

در راهنمای مهندسی سریع، درباره استراتژیهای طراحی سریع بیشتر بیاموزید.

سوالات متداول

حد نهایی دانش برای Gemini 3 چیست؟ مدلهای Gemini 3 دارای حد نهایی دانش ژانویه 2025 هستند. برای اطلاعات جدیدتر، از ابزار Search Grounding استفاده کنید.

محدودیتهای پنجره زمینه چیست؟ مدلهای Gemini 3 از یک پنجره زمینه ورودی ۱ میلیون توکن و تا ۶۴ هزار توکن خروجی پشتیبانی میکنند.

آیا نسخه رایگانی برای Gemini 3 وجود دارد؟ Gemini 3 Flash

gemini-3-flash-previewیک نسخه رایگان در Gemini API دارد. میتوانید Gemini 3 Pro و Flash را به صورت رایگان در Google AI Studio امتحان کنید، اما در حال حاضر، هیچ نسخه رایگانی برایgemini-3-pro-previewدر Gemini API موجود نیست.آیا کد قدیمی

thinking_budgetمن هنوز کار خواهد کرد؟ بله،thinking_budgetهنوز برای سازگاری با نسخههای قبلی پشتیبانی میشود، اما برای عملکرد قابل پیشبینیتر، توصیه میکنیم بهthinking_levelمهاجرت کنید. از هر دو در یک درخواست استفاده نکنید.آیا جمینی ۳ از Batch API پشتیبانی میکند؟ بله، جمینی ۳ از Batch API پشتیبانی میکند.

آیا از ذخیرهسازی زمینه (Context Caching) پشتیبانی میشود؟ بله، ذخیرهسازی زمینه برای Gemini 3 پشتیبانی میشود.

کدام ابزارها در Gemini 3 پشتیبانی میشوند؟ Gemini 3 از جستجوی گوگل ، جستجوی فایل ، اجرای کد و متن URL پشتیبانی میکند. همچنین از فراخوانی تابع استاندارد برای ابزارهای سفارشی شما پشتیبانی میکند (اما نه با ابزارهای داخلی). لطفاً توجه داشته باشید که اتصال به زمین با نقشههای گوگل و استفاده از رایانه در حال حاضر پشتیبانی نمیشوند.

مراحل بعدی

- با کتاب آشپزی Gemini 3 شروع کنید

- راهنمای اختصاصی کتاب آشپزی در مورد سطوح تفکر و نحوه مهاجرت از بودجه تفکر به سطوح تفکر را بررسی کنید.