Gemini 3 là bộ mô hình thông minh nhất của chúng tôi cho đến nay, được xây dựng dựa trên nền tảng suy luận tiên tiến. Công cụ này được thiết kế để hiện thực hoá mọi ý tưởng bằng cách thành thạo quy trình làm việc dựa trên tác nhân, lập trình tự động và các tác vụ đa phương thức phức tạp. Hướng dẫn này trình bày các tính năng chính của nhóm mô hình Gemini 3 và cách khai thác tối đa nhóm mô hình này.

Khám phá bộ sưu tập các ứng dụng Gemini 3 của chúng tôi để xem cách mô hình này xử lý hoạt động lý luận nâng cao, lập trình tự động và các nhiệm vụ phức tạp có nhiều phương thức.

Bắt đầu bằng một vài dòng mã:

Python

from google import genai

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents="Find the race condition in this multi-threaded C++ snippet: [code here]",

)

print(response.text)

JavaScript

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

async function run() {

const response = await ai.models.generateContent({

model: "gemini-3-pro-preview",

contents: "Find the race condition in this multi-threaded C++ snippet: [code here]",

});

console.log(response.text);

}

run();

REST

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "Find the race condition in this multi-threaded C++ snippet: [code here]"}]

}]

}'

Làm quen với dòng mô hình Gemini 3

Gemini 3 Pro là mô hình đầu tiên trong dòng mô hình mới, phù hợp nhất với những nhiệm vụ phức tạp đòi hỏi kiến thức rộng về thế giới và khả năng suy luận nâng cao trên nhiều phương thức.

Gemini 3 Flash là mô hình mới nhất thuộc dòng 3 của chúng tôi, sở hữu trí thông minh cấp độ Pro với tốc độ và mức giá của Flash.

Nano Banana Pro (còn được gọi là Gemini 3 Pro Image) là mô hình tạo ảnh có chất lượng cao nhất từ trước đến nay của chúng tôi.

Tất cả các mô hình Gemini 3 hiện đang ở giai đoạn dùng thử.

| Mã kiểu máy | Cửa sổ ngữ cảnh (Vào / Ra) | Điểm cắt kiến thức | Giá (Đầu vào / Đầu ra)* |

|---|---|---|---|

| gemini-3-pro-preview | 1M / 64k | Tháng 1 năm 2025 | 2 USD / 12 USD (<200.000 mã thông báo) 4 USD / 18 USD (>200.000 mã thông báo) |

| gemini-3-flash-preview | 1M / 64k | Tháng 1 năm 2025 | 0,5 USD / 3 USD |

| gemini-3-pro-image-preview | 65.000 / 32.000 | Tháng 1 năm 2025 | 2 USD (Nhập văn bản) / 0,134 USD (Xuất hình ảnh)** |

* Giá được tính cho mỗi 1 triệu mã thông báo, trừ phi có quy định khác. ** Giá hình ảnh thay đổi theo độ phân giải. Hãy xem trang giá để biết thông tin chi tiết.

Để biết thông tin chi tiết về giới hạn, giá cả và thông tin bổ sung, hãy xem trang mô hình.

Các tính năng mới của API trong Gemini 3

Gemini 3 giới thiệu các tham số mới được thiết kế để giúp nhà phát triển kiểm soát độ trễ, chi phí và độ trung thực của nhiều phương thức hiệu quả hơn.

Cấp độ tư duy

Các mô hình Gemini 3 sử dụng tư duy linh hoạt theo mặc định để suy luận thông qua các câu lệnh. Bạn có thể sử dụng tham số thinking_level để kiểm soát độ sâu tối đa của quy trình suy luận nội bộ của mô hình trước khi mô hình tạo ra một câu trả lời. Gemini 3 coi những cấp độ này là hạn mức tương đối cho hoạt động tư duy thay vì đảm bảo nghiêm ngặt về số lượng mã thông báo.

Nếu bạn không chỉ định thinking_level, Gemini 3 sẽ mặc định là high. Để có được các câu trả lời nhanh hơn và có độ trễ thấp hơn khi không cần suy luận phức tạp, bạn có thể giới hạn mức độ suy nghĩ của mô hình ở low.

Các cấp độ tư duy của Gemini 3 Pro và Flash:

Cả Gemini 3 Pro và Flash đều hỗ trợ các cấp độ tư duy sau:

low: Giảm thiểu độ trễ và chi phí. Phù hợp nhất với các ứng dụng tuân theo chỉ dẫn đơn giản, trò chuyện hoặc có thông lượng caohigh(Mặc định, linh động): Tối đa hoá độ sâu lý luận. Mô hình có thể mất nhiều thời gian hơn đáng kể để đạt được mã thông báo đầu tiên, nhưng đầu ra sẽ được lý luận cẩn thận hơn.

Các cấp độ tư duy của Gemini 3 Flash

Ngoài các cấp độ trên, Gemini 3 Flash cũng hỗ trợ các cấp độ tư duy sau đây mà Gemini 3 Pro hiện không hỗ trợ:

minimal: Phù hợp với chế độ "không cần suy nghĩ" cho hầu hết các cụm từ tìm kiếm. Mô hình có thể suy nghĩ rất ít cho các nhiệm vụ viết mã phức tạp. Giảm thiểu độ trễ cho các ứng dụng trò chuyện hoặc ứng dụng có thông lượng cao.medium: Tư duy cân bằng cho hầu hết các nhiệm vụ.

Python

from google import genai

from google.genai import types

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents="How does AI work?",

config=types.GenerateContentConfig(

thinking_config=types.ThinkingConfig(thinking_level="low")

),

)

print(response.text)

JavaScript

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

const response = await ai.models.generateContent({

model: "gemini-3-pro-preview",

contents: "How does AI work?",

config: {

thinkingConfig: {

thinkingLevel: "low",

}

},

});

console.log(response.text);

REST

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "How does AI work?"}]

}],

"generationConfig": {

"thinkingConfig": {

"thinkingLevel": "low"

}

}

}'

Độ phân giải của nội dung nghe nhìn

Gemini 3 giới thiệu khả năng kiểm soát chi tiết đối với quy trình xử lý hình ảnh đa phương thức thông qua tham số media_resolution. Độ phân giải cao hơn giúp cải thiện khả năng đọc văn bản nhỏ hoặc xác định các chi tiết nhỏ của mô hình, nhưng làm tăng mức sử dụng mã thông báo và độ trễ.

Tham số media_resolution xác định số lượng mã thông báo tối đa được phân bổ cho mỗi khung hình video hoặc hình ảnh đầu vào.

Giờ đây, bạn có thể đặt độ phân giải thành media_resolution_low, media_resolution_medium, media_resolution_high hoặc media_resolution_ultra_high cho từng phần nội dung đa phương tiện hoặc trên toàn cầu (thông qua generation_config, độ phân giải siêu cao không có sẵn trên toàn cầu). Nếu bạn không chỉ định, mô hình sẽ sử dụng các giá trị mặc định tối ưu dựa trên loại nội dung nghe nhìn.

Chế độ cài đặt được đề xuất

| Loại phương tiện | Chế độ cài đặt nên dùng | Số mã thông báo tối đa | Hướng dẫn sử dụng |

|---|---|---|---|

| Hình ảnh | media_resolution_high |

1120 | Bạn nên dùng chế độ này cho hầu hết các tác vụ phân tích hình ảnh để đảm bảo chất lượng tối đa. |

| Tệp PDF | media_resolution_medium |

560 | Tối ưu cho việc hiểu tài liệu; chất lượng thường đạt đến mức tối đa ở medium. Việc tăng lên high hiếm khi cải thiện kết quả OCR cho các tài liệu tiêu chuẩn. |

| Video (Chung) | media_resolution_low (hoặc media_resolution_medium) |

70 (mỗi khung hình) | Lưu ý: Đối với video, chế độ cài đặt low và medium được xử lý giống nhau (70 mã thông báo) để tối ưu hoá việc sử dụng ngữ cảnh. Điều này là đủ cho hầu hết các nhiệm vụ nhận dạng và mô tả hành động. |

| Video (Nhiều văn bản) | media_resolution_high |

280 (mỗi khung hình) | Chỉ bắt buộc khi trường hợp sử dụng liên quan đến việc đọc văn bản dày đặc (OCR) hoặc các chi tiết nhỏ trong khung hình video. |

Python

from google import genai

from google.genai import types

import base64

# The media_resolution parameter is currently only available in the v1alpha API version.

client = genai.Client(http_options={'api_version': 'v1alpha'})

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents=[

types.Content(

parts=[

types.Part(text="What is in this image?"),

types.Part(

inline_data=types.Blob(

mime_type="image/jpeg",

data=base64.b64decode("..."),

),

media_resolution={"level": "media_resolution_high"}

)

]

)

]

)

print(response.text)

JavaScript

import { GoogleGenAI } from "@google/genai";

// The media_resolution parameter is currently only available in the v1alpha API version.

const ai = new GoogleGenAI({ apiVersion: "v1alpha" });

async function run() {

const response = await ai.models.generateContent({

model: "gemini-3-pro-preview",

contents: [

{

parts: [

{ text: "What is in this image?" },

{

inlineData: {

mimeType: "image/jpeg",

data: "...",

},

mediaResolution: {

level: "media_resolution_high"

}

}

]

}

]

});

console.log(response.text);

}

run();

REST

curl "https://generativelanguage.googleapis.com/v1alpha/models/gemini-3-pro-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [

{ "text": "What is in this image?" },

{

"inlineData": {

"mimeType": "image/jpeg",

"data": "..."

},

"mediaResolution": {

"level": "media_resolution_high"

}

}

]

}]

}'

Nhiệt độ

Đối với Gemini 3, bạn nên giữ thông số nhiệt độ ở giá trị mặc định là 1.0.

Mặc dù các mô hình trước đây thường được hưởng lợi từ việc điều chỉnh nhiệt độ để kiểm soát khả năng sáng tạo so với tính xác định, nhưng khả năng suy luận của Gemini 3 được tối ưu hoá cho chế độ cài đặt mặc định. Việc thay đổi nhiệt độ (đặt nhiệt độ dưới 1.0) có thể dẫn đến hành vi không mong muốn, chẳng hạn như lặp lại hoặc giảm hiệu suất, đặc biệt là trong các nhiệm vụ phức tạp về toán học hoặc lý luận.

Chữ ký tư duy

Gemini 3 sử dụng Chữ ký suy luận để duy trì ngữ cảnh suy luận trên các lệnh gọi API. Đây là các chữ ký được mã hoá thể hiện quy trình suy nghĩ nội bộ của mô hình. Để đảm bảo mô hình duy trì khả năng suy luận, bạn phải trả lại các chữ ký này cho mô hình trong yêu cầu của mình đúng như khi nhận được:

Gọi hàm (Nghiêm ngặt): API thực thi quy trình xác thực nghiêm ngặt đối với "Lượt hiện tại". Nếu thiếu chữ ký, bạn sẽ gặp lỗi 400.

Văn bản/Trò chuyện: Chúng tôi không bắt buộc xác thực, nhưng việc bỏ qua chữ ký sẽ làm giảm khả năng lập luận và chất lượng câu trả lời của mô hình.

Tạo/chỉnh sửa hình ảnh (Nghiêm ngặt): API thực thi quy trình xác thực nghiêm ngặt trên tất cả các phần của Mô hình, bao gồm cả

thoughtSignature. Nếu thiếu chữ ký, bạn sẽ gặp lỗi 400.

Gọi hàm (xác thực nghiêm ngặt)

Khi tạo functionCall, Gemini dựa vào thoughtSignature để xử lý chính xác đầu ra của công cụ trong lượt tiếp theo. "Lượt tương tác hiện tại" bao gồm tất cả các bước của Mô hình (functionCall) và Người dùng (functionResponse) đã diễn ra kể từ thông báo text Người dùng tiêu chuẩn gần đây nhất.

- Lệnh gọi một hàm: Phần

functionCallchứa một chữ ký. Bạn phải trả lại thiết bị. - Lệnh gọi hàm song song: Chỉ phần

functionCallđầu tiên trong danh sách sẽ chứa chữ ký. Bạn phải trả lại các bộ phận theo đúng thứ tự đã nhận. - Nhiều bước (Tuần tự): Nếu mô hình gọi một công cụ, nhận được kết quả và gọi một công cụ khác (trong cùng một lượt), thì cả hai lệnh gọi hàm đều có chữ ký. Bạn phải trả về tất cả chữ ký tích luỹ trong nhật ký.

Văn bản và truyền trực tuyến

Đối với cuộc trò chuyện hoặc tính năng tạo văn bản thông thường, không đảm bảo sẽ có chữ ký.

- Không truyền trực tuyến: Phần nội dung cuối cùng của phản hồi có thể chứa một

thoughtSignature, mặc dù không phải lúc nào cũng có. Nếu có một giá trị được trả về, bạn nên gửi giá trị đó trở lại để duy trì hiệu suất tốt nhất. - Phát trực tuyến: Nếu được tạo, chữ ký có thể xuất hiện trong một đoạn cuối cùng chứa phần văn bản trống. Đảm bảo trình phân tích cú pháp luồng của bạn kiểm tra chữ ký ngay cả khi trường văn bản trống.

Tạo và chỉnh sửa hình ảnh

Đối với gemini-3-pro-image-preview, chữ ký tư duy đóng vai trò quan trọng trong việc chỉnh sửa đàm thoại. Khi bạn yêu cầu mô hình sửa đổi một hình ảnh, mô hình sẽ dựa vào thoughtSignature từ lượt tương tác trước để hiểu bố cục và logic của hình ảnh gốc.

- Chỉnh sửa: Chữ ký được đảm bảo ở phần đầu tiên sau các suy nghĩ của câu trả lời (

texthoặcinlineData) và ở mọi phầninlineDatatiếp theo. Bạn phải trả về tất cả các chữ ký này để tránh lỗi.

Ví dụ về mã

Gọi hàm nhiều bước (Tuần tự)

Người dùng đặt một câu hỏi yêu cầu hai bước riêng biệt (Kiểm tra chuyến bay -> Đặt taxi) trong một lượt.

Bước 1: Mô hình gọi Công cụ chuyến bay.

Mô hình trả về một chữ ký <Sig_A>

// Model Response (Turn 1, Step 1) { "role": "model", "parts": [ { "functionCall": { "name": "check_flight", "args": {...} }, "thoughtSignature": "<Sig_A>" // SAVE THIS } ] }

Bước 2: Người dùng gửi Kết quả chuyến bay

Chúng ta phải gửi lại <Sig_A> để duy trì mạch suy nghĩ của mô hình.

// User Request (Turn 1, Step 2) [ { "role": "user", "parts": [{ "text": "Check flight AA100..." }] }, { "role": "model", "parts": [ { "functionCall": { "name": "check_flight", "args": {...} }, "thoughtSignature": "<Sig_A>" // REQUIRED } ] }, { "role": "user", "parts": [{ "functionResponse": { "name": "check_flight", "response": {...} } }] } ]

Bước 3: Mô hình gọi Công cụ Taxi

Mô hình ghi nhớ thông tin chuyến bay bị trễ thông qua <Sig_A> và giờ quyết định đặt taxi. Thao tác này sẽ tạo ra một chữ ký mới <Sig_B>.

// Model Response (Turn 1, Step 3) { "role": "model", "parts": [ { "functionCall": { "name": "book_taxi", "args": {...} }, "thoughtSignature": "<Sig_B>" // SAVE THIS } ] }

Bước 4: Người dùng gửi Taxi Result

Để hoàn tất lượt này, bạn phải gửi lại toàn bộ chuỗi: <Sig_A> VÀ <Sig_B>.

// User Request (Turn 1, Step 4) [ // ... previous history ... { "role": "model", "parts": [ { "functionCall": { "name": "check_flight", ... }, "thoughtSignature": "<Sig_A>" } ] }, { "role": "user", "parts": [{ "functionResponse": {...} }] }, { "role": "model", "parts": [ { "functionCall": { "name": "book_taxi", ... }, "thoughtSignature": "<Sig_B>" } ] }, { "role": "user", "parts": [{ "functionResponse": {...} }] } ]

Gọi hàm song song

Người dùng hỏi: "Xem thời tiết ở Paris và London." Mô hình này trả về 2 lệnh gọi hàm trong một phản hồi.

// User Request (Sending Parallel Results) [ { "role": "user", "parts": [ { "text": "Check the weather in Paris and London." } ] }, { "role": "model", "parts": [ // 1. First Function Call has the signature { "functionCall": { "name": "check_weather", "args": { "city": "Paris" } }, "thoughtSignature": "<Signature_A>" }, // 2. Subsequent parallel calls DO NOT have signatures { "functionCall": { "name": "check_weather", "args": { "city": "London" } } } ] }, { "role": "user", "parts": [ // 3. Function Responses are grouped together in the next block { "functionResponse": { "name": "check_weather", "response": { "temp": "15C" } } }, { "functionResponse": { "name": "check_weather", "response": { "temp": "12C" } } } ] } ]

Văn bản/Lý luận trong ngữ cảnh (Không xác thực)

Người dùng đặt câu hỏi đòi hỏi phải suy luận trong ngữ cảnh mà không cần đến các công cụ bên ngoài. Mặc dù không được xác thực một cách nghiêm ngặt, nhưng việc thêm chữ ký sẽ giúp mô hình duy trì chuỗi lập luận cho các câu hỏi tiếp theo.

// User Request (Follow-up question) [ { "role": "user", "parts": [{ "text": "What are the risks of this investment?" }] }, { "role": "model", "parts": [ { "text": "I need to calculate the risk step-by-step. First, I'll look at volatility...", "thoughtSignature": "<Signature_C>" // Recommended to include } ] }, { "role": "user", "parts": [{ "text": "Summarize that in one sentence." }] } ]

Tạo và chỉnh sửa hình ảnh

Đối với tính năng tạo hình ảnh, chữ ký sẽ được xác thực nghiêm ngặt. Chúng xuất hiện ở phần đầu tiên (văn bản hoặc hình ảnh) và tất cả các phần hình ảnh tiếp theo. Tất cả phải được trả lại trong lượt tiếp theo.

// Model Response (Turn 1) { "role": "model", "parts": [ // 1. First part ALWAYS has a signature (even if text) { "text": "I will generate a cyberpunk city...", "thoughtSignature": "<Signature_D>" }, // 2. ALL InlineData (Image) parts ALWAYS have signatures { "inlineData": { ... }, "thoughtSignature": "<Signature_E>" }, ] } // User Request (Turn 2 - Requesting an Edit) { "contents": [ // History must include ALL signatures received { "role": "user", "parts": [{ "text": "Generate a cyberpunk city" }] }, { "role": "model", "parts": [ { "text": "...", "thoughtSignature": "<Signature_D>" }, { "inlineData": "...", "thoughtSignature": "<Signature_E>" }, ] }, // New User Prompt { "role": "user", "parts": [{ "text": "Make it daytime." }] } ] }

Di chuyển từ các mô hình khác

Nếu bạn đang chuyển dấu vết của cuộc trò chuyện từ một mô hình khác (ví dụ: 2.5) hoặc chèn một lệnh gọi hàm tuỳ chỉnh không phải do Gemini 3 tạo, bạn sẽ không có chữ ký hợp lệ.

Để bỏ qua quy trình xác thực nghiêm ngặt trong những trường hợp cụ thể này, hãy điền vào trường chuỗi giả cụ thể sau: "thoughtSignature": "context_engineering_is_the_way_to_go"

Đầu ra có cấu trúc bằng các công cụ

Các mô hình Gemini 3 cho phép bạn kết hợp Đầu ra có cấu trúc với các công cụ tích hợp, bao gồm Căn cứ vào Google Tìm kiếm, Ngữ cảnh URL, Thực thi mã và Gọi hàm.

Python

from google import genai

from google.genai import types

from pydantic import BaseModel, Field

from typing import List

class MatchResult(BaseModel):

winner: str = Field(description="The name of the winner.")

final_match_score: str = Field(description="The final match score.")

scorers: List[str] = Field(description="The name of the scorer.")

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents="Search for all details for the latest Euro.",

config={

"tools": [

{"google_search": {}},

{"url_context": {}}

],

"response_mime_type": "application/json",

"response_json_schema": MatchResult.model_json_schema(),

},

)

result = MatchResult.model_validate_json(response.text)

print(result)

JavaScript

import { GoogleGenAI } from "@google/genai";

import { z } from "zod";

import { zodToJsonSchema } from "zod-to-json-schema";

const ai = new GoogleGenAI({});

const matchSchema = z.object({

winner: z.string().describe("The name of the winner."),

final_match_score: z.string().describe("The final score."),

scorers: z.array(z.string()).describe("The name of the scorer.")

});

async function run() {

const response = await ai.models.generateContent({

model: "gemini-3-pro-preview",

contents: "Search for all details for the latest Euro.",

config: {

tools: [

{ googleSearch: {} },

{ urlContext: {} }

],

responseMimeType: "application/json",

responseJsonSchema: zodToJsonSchema(matchSchema),

},

});

const match = matchSchema.parse(JSON.parse(response.text));

console.log(match);

}

run();

REST

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "Search for all details for the latest Euro."}]

}],

"tools": [

{"googleSearch": {}},

{"urlContext": {}}

],

"generationConfig": {

"responseMimeType": "application/json",

"responseJsonSchema": {

"type": "object",

"properties": {

"winner": {"type": "string", "description": "The name of the winner."},

"final_match_score": {"type": "string", "description": "The final score."},

"scorers": {

"type": "array",

"items": {"type": "string"},

"description": "The name of the scorer."

}

},

"required": ["winner", "final_match_score", "scorers"]

}

}

}'

Tạo hình ảnh

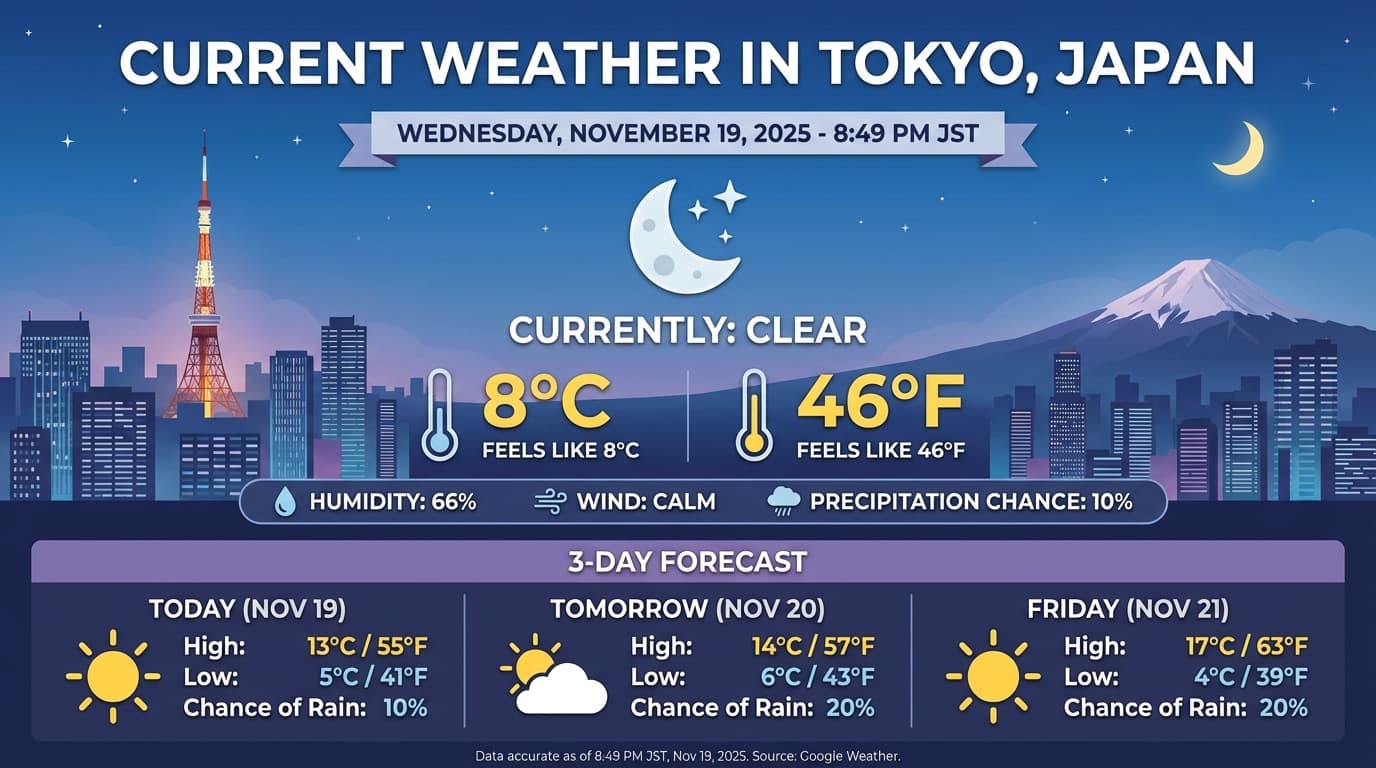

Gemini 3 Pro Image cho phép bạn tạo và chỉnh sửa hình ảnh từ câu lệnh dạng văn bản. Mô hình này sử dụng khả năng suy luận để "suy nghĩ" về một câu lệnh và có thể truy xuất dữ liệu theo thời gian thực (chẳng hạn như dự báo thời tiết hoặc biểu đồ chứng khoán) trước khi sử dụng tính năng Tìm kiếm trên Google để tạo ra những hình ảnh có độ trung thực cao.

Các chức năng mới và được cải thiện:

- Độ phân giải 4K và kết xuất văn bản: Tạo văn bản và sơ đồ rõ ràng, dễ đọc với độ phân giải lên đến 2K và 4K.

- Tạo nội dung dựa trên thông tin thực tế: Sử dụng công cụ

google_searchđể xác minh thông tin thực tế và tạo hình ảnh dựa trên thông tin thực tế. - Chỉnh sửa bằng cách trò chuyện: Chỉnh sửa hình ảnh nhiều lần bằng cách chỉ cần yêu cầu thay đổi (ví dụ: Tạo hình nền là cảnh hoàng hôn"). Quy trình này dựa vào Chữ ký tư duy để duy trì ngữ cảnh trực quan giữa các lượt.

Để biết thông tin chi tiết đầy đủ về tỷ lệ khung hình, quy trình chỉnh sửa và các lựa chọn cấu hình, hãy xem hướng dẫn Tạo hình ảnh.

Python

from google import genai

from google.genai import types

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-pro-image-preview",

contents="Generate an infographic of the current weather in Tokyo.",

config=types.GenerateContentConfig(

tools=[{"google_search": {}}],

image_config=types.ImageConfig(

aspect_ratio="16:9",

image_size="4K"

)

)

)

image_parts = [part for part in response.parts if part.inline_data]

if image_parts:

image = image_parts[0].as_image()

image.save('weather_tokyo.png')

image.show()

JavaScript

import { GoogleGenAI } from "@google/genai";

import * as fs from "node:fs";

const ai = new GoogleGenAI({});

async function run() {

const response = await ai.models.generateContent({

model: "gemini-3-pro-image-preview",

contents: "Generate a visualization of the current weather in Tokyo.",

config: {

tools: [{ googleSearch: {} }],

imageConfig: {

aspectRatio: "16:9",

imageSize: "4K"

}

}

});

for (const part of response.candidates[0].content.parts) {

if (part.inlineData) {

const imageData = part.inlineData.data;

const buffer = Buffer.from(imageData, "base64");

fs.writeFileSync("weather_tokyo.png", buffer);

}

}

}

run();

REST

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-image-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "Generate a visualization of the current weather in Tokyo."}]

}],

"tools": [{"googleSearch": {}}],

"generationConfig": {

"imageConfig": {

"aspectRatio": "16:9",

"imageSize": "4K"

}

}

}'

Ví dụ về phản hồi

Thực thi mã bằng hình ảnh

Gemini 3 Flash có thể coi hình ảnh là một đối tượng cần được chủ động tìm hiểu, chứ không chỉ là một cái nhìn thoáng qua. Bằng cách kết hợp lập luận với thực thi mã, mô hình sẽ xây dựng một kế hoạch, sau đó viết và thực thi mã Python để phóng to, cắt, chú thích hoặc thao tác hình ảnh theo cách khác từng bước để đưa ra câu trả lời trực quan.

Trường hợp sử dụng:

- Phóng to và kiểm tra: Mô hình sẽ tự động phát hiện khi các chi tiết quá nhỏ (ví dụ: đọc một đồng hồ đo hoặc số sê-ri ở xa) và viết mã để cắt cũng như kiểm tra lại khu vực ở độ phân giải cao hơn.

- Phép toán và biểu đồ trực quan: Mô hình có thể chạy các phép tính nhiều bước bằng mã (ví dụ: tính tổng các mục hàng trên biên nhận hoặc tạo biểu đồ Matplotlib từ dữ liệu đã trích xuất).

- Chú thích hình ảnh: Mô hình có thể vẽ mũi tên, khung viền hoặc các chú thích khác trực tiếp lên hình ảnh để trả lời các câu hỏi về không gian như "Mặt hàng này nên đặt ở đâu?".

Để bật tính năng tư duy trực quan, hãy định cấu hình Thực thi mã làm công cụ. Mô hình sẽ tự động dùng mã để chỉnh sửa hình ảnh khi cần.

Python

from google import genai

from google.genai import types

import requests

from PIL import Image

import io

image_path = "https://goo.gle/instrument-img"

image_bytes = requests.get(image_path).content

image = types.Part.from_bytes(data=image_bytes, mime_type="image/jpeg")

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents=[

image,

"Zoom into the expression pedals and tell me how many pedals are there?"

],

config=types.GenerateContentConfig(

tools=[types.Tool(code_execution=types.ToolCodeExecution)]

),

)

for part in response.candidates[0].content.parts:

if part.text is not None:

print(part.text)

if part.executable_code is not None:

print(part.executable_code.code)

if part.code_execution_result is not None:

print(part.code_execution_result.output)

if part.as_image() is not None:

display(Image.open(io.BytesIO(part.as_image().image_bytes)))

JavaScript

import { GoogleGenAI } from "@google/genai";

const ai = new GoogleGenAI({});

async function main() {

const imageUrl = "https://goo.gle/instrument-img";

const response = await fetch(imageUrl);

const imageArrayBuffer = await response.arrayBuffer();

const base64ImageData = Buffer.from(imageArrayBuffer).toString("base64");

const result = await ai.models.generateContent({

model: "gemini-3-flash-preview",

contents: [

{

inlineData: {

mimeType: "image/jpeg",

data: base64ImageData,

},

},

{

text: "Zoom into the expression pedals and tell me how many pedals are there?",

},

],

config: {

tools: [{ codeExecution: {} }],

},

});

for (const part of result.candidates[0].content.parts) {

if (part.text) {

console.log("Text:", part.text);

}

if (part.executableCode) {

console.log("Code:", part.executableCode.code);

}

if (part.codeExecutionResult) {

console.log("Output:", part.codeExecutionResult.output);

}

}

}

main();

REST

IMG_URL="https://goo.gle/instrument-img"

MODEL="gemini-3-flash-preview"

MIME_TYPE=$(curl -sIL "$IMG_URL" | grep -i '^content-type:' | awk -F ': ' '{print $2}' | sed 's/\r$//' | head -n 1)

if [[ -z "$MIME_TYPE" || ! "$MIME_TYPE" == image/* ]]; then

MIME_TYPE="image/jpeg"

fi

if [[ "$(uname)" == "Darwin" ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -b 0)

elif [[ "$(base64 --version 2>&1)" = *"FreeBSD"* ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64)

else

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -w0)

fi

curl "https://generativelanguage.googleapis.com/v1beta/models/$MODEL:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts":[

{

"inline_data": {

"mime_type":"'"$MIME_TYPE"'",

"data": "'"$IMAGE_B64"'"

}

},

{"text": "Zoom into the expression pedals and tell me how many pedals are there?"}

]

}],

"tools": [{"code_execution": {}}]

}'

Để biết thêm thông tin chi tiết về việc thực thi mã bằng hình ảnh, hãy xem phần Thực thi mã.

Phản hồi của hàm đa phương thức

Tính năng gọi hàm đa phương thức cho phép người dùng nhận được các phản hồi của hàm có chứa các đối tượng đa phương thức, giúp cải thiện khả năng sử dụng tính năng gọi hàm của mô hình. Tính năng gọi hàm tiêu chuẩn chỉ hỗ trợ các phản hồi hàm dựa trên văn bản:

Python

from google import genai

from google.genai import types

import requests

client = genai.Client()

# This is a manual, two turn multimodal function calling workflow:

# 1. Define the function tool

get_image_declaration = types.FunctionDeclaration(

name="get_image",

description="Retrieves the image file reference for a specific order item.",

parameters={

"type": "object",

"properties": {

"item_name": {

"type": "string",

"description": "The name or description of the item ordered (e.g., 'instrument')."

}

},

"required": ["item_name"],

},

)

tool_config = types.Tool(function_declarations=[get_image_declaration])

# 2. Send a message that triggers the tool

prompt = "Show me the instrument I ordered last month."

response_1 = client.models.generate_content(

model="gemini-3-flash-preview",

contents=[prompt],

config=types.GenerateContentConfig(

tools=[tool_config],

)

)

# 3. Handle the function call

function_call = response_1.function_calls[0]

requested_item = function_call.args["item_name"]

print(f"Model wants to call: {function_call.name}")

# Execute your tool (e.g., call an API)

# (This is a mock response for the example)

print(f"Calling external tool for: {requested_item}")

function_response_data = {

"image_ref": {"$ref": "instrument.jpg"},

}

image_path = "https://goo.gle/instrument-img"

image_bytes = requests.get(image_path).content

function_response_multimodal_data = types.FunctionResponsePart(

inline_data=types.FunctionResponseBlob(

mime_type="image/jpeg",

display_name="instrument.jpg",

data=image_bytes,

)

)

# 4. Send the tool's result back

# Append this turn's messages to history for a final response.

history = [

types.Content(role="user", parts=[types.Part(text=prompt)]),

response_1.candidates[0].content,

types.Content(

role="tool",

parts=[

types.Part.from_function_response(

name=function_call.name,

response=function_response_data,

parts=[function_response_multimodal_data]

)

],

)

]

response_2 = client.models.generate_content(

model="gemini-3-flash-preview",

contents=history,

config=types.GenerateContentConfig(

tools=[tool_config],

thinking_config=types.ThinkingConfig(include_thoughts=True)

),

)

print(f"\nFinal model response: {response_2.text}")

JavaScript

import { GoogleGenAI, Type } from '@google/genai';

const client = new GoogleGenAI({ apiKey: process.env.GEMINI_API_KEY });

// This is a manual, two turn multimodal function calling workflow:

// 1. Define the function tool

const getImageDeclaration = {

name: 'get_image',

description: 'Retrieves the image file reference for a specific order item.',

parameters: {

type: Type.OBJECT,

properties: {

item_name: {

type: Type.STRING,

description: "The name or description of the item ordered (e.g., 'instrument').",

},

},

required: ['item_name'],

},

};

const toolConfig = {

functionDeclarations: [getImageDeclaration],

};

// 2. Send a message that triggers the tool

const prompt = 'Show me the instrument I ordered last month.';

const response1 = await client.models.generateContent({

model: 'gemini-3-flash-preview',

contents: prompt,

config: {

tools: [toolConfig],

},

});

// 3. Handle the function call

const functionCall = response1.functionCalls[0];

const requestedItem = functionCall.args.item_name;

console.log(`Model wants to call: ${functionCall.name}`);

// Execute your tool (e.g., call an API)

// (This is a mock response for the example)

console.log(`Calling external tool for: ${requestedItem}`);

const functionResponseData = {

image_ref: { $ref: 'instrument.jpg' },

};

const imageUrl = "https://goo.gle/instrument-img";

const response = await fetch(imageUrl);

const imageArrayBuffer = await response.arrayBuffer();

const base64ImageData = Buffer.from(imageArrayBuffer).toString('base64');

const functionResponseMultimodalData = {

inlineData: {

mimeType: 'image/jpeg',

displayName: 'instrument.jpg',

data: base64ImageData,

},

};

// 4. Send the tool's result back

// Append this turn's messages to history for a final response.

const history = [

{ role: 'user', parts: [{ text: prompt }] },

response1.candidates[0].content,

{

role: 'tool',

parts: [

{

functionResponse: {

name: functionCall.name,

response: functionResponseData,

parts: [functionResponseMultimodalData],

},

},

],

},

];

const response2 = await client.models.generateContent({

model: 'gemini-3-flash-preview',

contents: history,

config: {

tools: [toolConfig],

thinkingConfig: { includeThoughts: true },

},

});

console.log(`\nFinal model response: ${response2.text}`);

REST

IMG_URL="https://goo.gle/instrument-img"

MIME_TYPE=$(curl -sIL "$IMG_URL" | grep -i '^content-type:' | awk -F ': ' '{print $2}' | sed 's/\r$//' | head -n 1)

if [[ -z "$MIME_TYPE" || ! "$MIME_TYPE" == image/* ]]; then

MIME_TYPE="image/jpeg"

fi

# Check for macOS

if [[ "$(uname)" == "Darwin" ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -b 0)

elif [[ "$(base64 --version 2>&1)" = *"FreeBSD"* ]]; then

IMAGE_B64=$(curl -sL "$IMG_URL" | base64)

else

IMAGE_B64=$(curl -sL "$IMG_URL" | base64 -w0)

fi

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-flash-preview:generateContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [

...,

{

"role": "user",

"parts": [

{

"functionResponse": {

"name": "get_image",

"response": {

"image_ref": {

"$ref": "instrument.jpg"

}

},

"parts": [

{

"inlineData": {

"displayName": "instrument.jpg",

"mimeType":"'"$MIME_TYPE"'",

"data": "'"$IMAGE_B64"'"

}

}

]

}

}

]

}

]

}'

Di chuyển từ Gemini 2.5

Gemini 3 là nhóm mô hình mạnh mẽ nhất của chúng tôi cho đến nay và có những bước cải tiến so với Gemini 2.5. Khi di chuyển, hãy cân nhắc những điều sau:

- Tư duy: Nếu trước đây bạn đang sử dụng kỹ thuật tạo câu lệnh phức tạp (chẳng hạn như chuỗi suy nghĩ) để buộc Gemini 2.5 suy luận, hãy thử Gemini 3 với

thinking_level: "high"và câu lệnh đơn giản. - Chế độ cài đặt nhiệt độ: Nếu mã hiện tại của bạn đặt nhiệt độ một cách rõ ràng (đặc biệt là ở các giá trị thấp cho đầu ra xác định), thì bạn nên xoá thông số này và sử dụng giá trị mặc định là 1.0 của Gemini 3 để tránh các vấn đề tiềm ẩn về vòng lặp hoặc hiệu suất giảm sút đối với các tác vụ phức tạp.

- Hiểu tệp PDF và tài liệu: Độ phân giải OCR mặc định cho tệp PDF đã thay đổi.

Nếu bạn dựa vào hành vi cụ thể để phân tích cú pháp tài liệu dày đặc, hãy kiểm thử chế độ cài đặt

media_resolution_highmới để đảm bảo độ chính xác liên tục. - Mức tiêu thụ mã thông báo: Việc di chuyển sang Gemini 3 mặc định có thể tăng mức sử dụng mã thông báo cho tệp PDF nhưng giảm mức sử dụng mã thông báo cho video. Nếu các yêu cầu hiện vượt quá cửa sổ ngữ cảnh do độ phân giải mặc định cao hơn, bạn nên giảm rõ ràng độ phân giải của nội dung nghe nhìn.

- Phân đoạn hình ảnh: Gemini 3 Pro hoặc Gemini 3 Flash không hỗ trợ các chức năng phân đoạn hình ảnh (trả về mặt nạ ở cấp độ pixel cho các đối tượng). Đối với những khối lượng công việc yêu cầu phân đoạn hình ảnh gốc, bạn nên tiếp tục sử dụng Gemini 2.5 Flash khi tắt chế độ tư duy hoặc Gemini Robotics-ER 1.5.

- Sử dụng máy tính: Gemini 3 Pro và Gemini 3 Flash hỗ trợ tính năng Sử dụng máy tính. Không giống như dòng 2.5, bạn không cần sử dụng một mô hình riêng để truy cập vào công cụ Sử dụng máy tính.

- Hỗ trợ công cụ: Các mô hình Gemini 3 hiện chưa hỗ trợ tính năng căn cứ vào bản đồ, nên sẽ không di chuyển. Ngoài ra, hệ thống chưa hỗ trợ việc kết hợp các công cụ tích hợp với tính năng gọi hàm.

Khả năng tương thích với OpenAI

Đối với những người dùng sử dụng lớp tương thích OpenAI, các tham số tiêu chuẩn sẽ tự động được liên kết với các tham số tương đương trên Gemini:

reasoning_effort(OAI) tương ứng vớithinking_level(Gemini). Xin lưu ý rằngreasoning_efforttrung bình tương ứng vớithinking_levelcao trên Gemini 3 Flash.

Các phương pháp hay nhất để đưa ra câu lệnh

Gemini 3 là một mô hình suy luận, do đó bạn cần thay đổi cách đưa ra câu lệnh.

- Hướng dẫn chính xác: Nhập câu lệnh một cách ngắn gọn. Gemini 3 phản hồi tốt nhất khi nhận được chỉ dẫn trực tiếp và rõ ràng. Có thể phân tích quá mức các kỹ thuật tạo câu lệnh dài dòng hoặc quá phức tạp được dùng cho các mô hình cũ.

- Mức độ chi tiết của kết quả: Theo mặc định, Gemini 3 ít chi tiết hơn và ưu tiên cung cấp câu trả lời trực tiếp, hiệu quả. Nếu trường hợp sử dụng của bạn yêu cầu một nhân cách trò chuyện hoặc "hay trò chuyện" hơn, bạn phải hướng dẫn rõ ràng cho mô hình trong câu lệnh (ví dụ: "Giải thích điều này với vai trò là một trợ lý thân thiện và hay trò chuyện").

- Quản lý bối cảnh: Khi làm việc với các tập dữ liệu lớn (ví dụ: toàn bộ sách, cơ sở mã hoặc video dài), hãy đặt hướng dẫn hoặc câu hỏi cụ thể của bạn ở cuối câu lệnh, sau bối cảnh dữ liệu. Neo lập luận của mô hình vào dữ liệu được cung cấp bằng cách bắt đầu câu hỏi bằng một cụm từ như "Dựa trên thông tin ở trên...".

Tìm hiểu thêm về các chiến lược thiết kế câu lệnh trong hướng dẫn kỹ thuật tạo câu lệnh.

Câu hỏi thường gặp

Thời điểm ngừng cập nhật kiến thức của Gemini 3 là khi nào? Các mô hình Gemini 3 có thời điểm ngừng cập nhật kiến thức là tháng 1 năm 2025. Để biết thông tin mới nhất, hãy sử dụng công cụ Tìm kiếm thông tin cơ sở.

Hạn mức cửa sổ ngữ cảnh là bao nhiêu? Các mô hình Gemini 3 hỗ trợ cửa sổ ngữ cảnh đầu vào 1 triệu token và đầu ra lên đến 64.000 token.

Gemini 3 có phiên bản miễn phí không? Gemini 3 Flash

gemini-3-flash-previewcó một cấp miễn phí trong Gemini API. Bạn có thể dùng thử miễn phí cả Gemini 3 Pro và Flash trong Google AI Studio. Tuy nhiên, hiện tại, không có cấp miễn phí nào chogemini-3-pro-previewtrong Gemini API.Mã

thinking_budgetcũ của tôi có còn hoạt động không? Có,thinking_budgetvẫn được hỗ trợ để tương thích ngược, nhưng bạn nên di chuyển sangthinking_levelđể có hiệu suất dễ dự đoán hơn. Đừng sử dụng cả hai trong cùng một yêu cầu.Gemini 3 có hỗ trợ Batch API không? Có, Gemini 3 hỗ trợ Batch API.

Context Caching có được hỗ trợ không? Có, Gemini 3 có hỗ trợ tính năng Lưu vào bộ nhớ đệm theo bối cảnh.

Gemini 3 hỗ trợ những công cụ nào? Gemini 3 hỗ trợ Google Tìm kiếm, Tìm kiếm tệp, Thực thi mã và Ngữ cảnh URL. Công cụ này cũng hỗ trợ tính năng Gọi hàm tiêu chuẩn cho các công cụ tuỳ chỉnh của riêng bạn (nhưng không hỗ trợ các công cụ tích hợp). Xin lưu ý rằng Tính năng tiếp đất bằng Google Maps và Sử dụng máy tính hiện không được hỗ trợ.

Các bước tiếp theo

- Bắt đầu sử dụng Gemini 3 Cookbook

- Hãy xem hướng dẫn chuyên biệt về các cấp độ tư duy trong Sổ tay và cách di chuyển từ ngân sách tư duy sang các cấp độ tư duy.