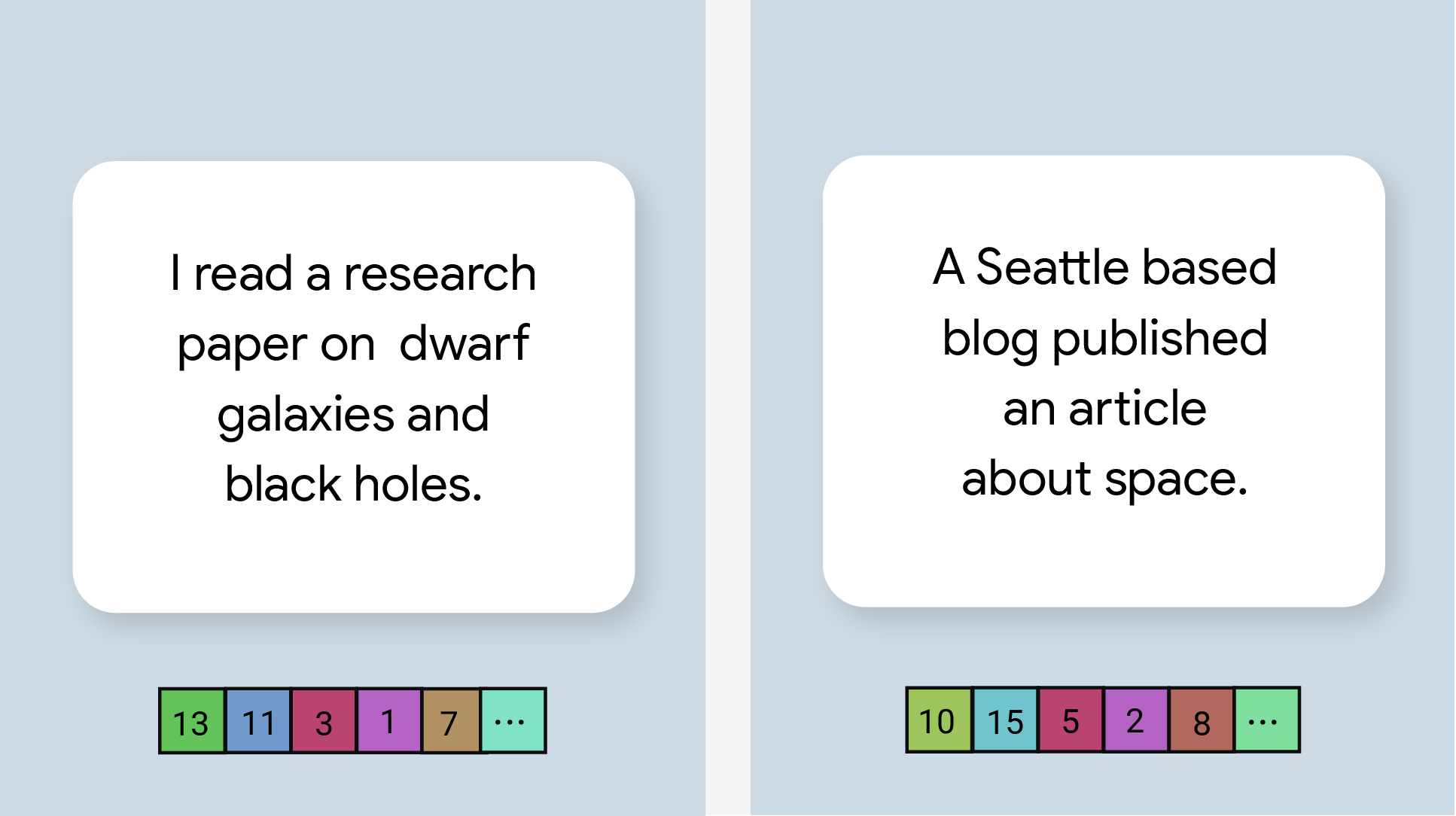

وظیفه MediaPipe Text Embedder به شما امکان می دهد یک نمایش عددی از داده های متنی ایجاد کنید تا معنای معنایی آن را دریافت کنید. این قابلیت اغلب برای مقایسه شباهت معنایی دو قطعه متن با استفاده از تکنیک های مقایسه ریاضی مانند شباهت کسینوس استفاده می شود. این وظیفه بر روی دادههای متنی با مدل یادگیری ماشین (ML) عمل میکند و نمایش عددی دادههای متنی را بهعنوان فهرستی از بردارهای ویژگی با ابعاد بالا، که بهعنوان بردارهای جاسازی نیز شناخته میشوند، به صورت ممیز شناور یا کوانتیزه شده، خروجی میدهد.

شروع کنید

استفاده از این کار را با دنبال کردن یکی از این راهنماهای پیاده سازی برای پلتفرم هدف خود شروع کنید. این راهنماهای مخصوص پلتفرم شما را از طریق اجرای اساسی این کار، از جمله یک مدل توصیه شده، و نمونه کد با گزینه های پیکربندی توصیه شده، راهنمایی می کنند:

جزئیات کار

این بخش قابلیت ها، ورودی ها، خروجی ها و گزینه های پیکربندی این کار را شرح می دهد.

ویژگی ها

- پردازش متن ورودی - از توکنسازی خارج از نمودار برای مدلهای بدون نشانهسازی درون گراف پشتیبانی میکند.

- تعبیه محاسبات شباهت - تابع ابزار داخلی برای محاسبه شباهت کسینوس بین دو بردار ویژگی.

- Quantization - از کوانتیزهسازی اسکالر برای بردارهای ویژگی پشتیبانی میکند.

| ورودی های وظیفه | خروجی های وظیفه |

|---|---|

Text Embedder نوع داده ورودی زیر را می پذیرد:

| Text Embedder لیستی از جاسازیها شامل موارد زیر را خروجی میدهد:

|

گزینه های پیکربندی

این کار دارای گزینه های پیکربندی زیر است:

| نام گزینه | توضیحات | محدوده ارزش | مقدار پیش فرض |

|---|---|---|---|

l2_normalize | آیا باید بردار ویژگی بازگشتی را با نرمال L2 عادی سازی کرد. فقط در صورتی از این گزینه استفاده کنید که مدل از قبل دارای یک L2_NORMALIZATION TFLite Op بومی نباشد. در بیشتر موارد، این قبلاً وجود دارد و بنابراین عادی سازی L2 از طریق استنتاج TFLite بدون نیاز به این گزینه حاصل می شود. | Boolean | False |

quantize | اینکه آیا تعبیه برگشتی باید از طریق کوانتیزه کردن اسکالر به بایت تبدیل شود یا خیر. تعبیهها به طور ضمنی واحد هنجار فرض میشوند و بنابراین هر بعد تضمین میشود که مقداری در [-1.0، 1.0] داشته باشد. اگر اینطور نیست از گزینه l2_normalize استفاده کنید. | Boolean | False |

مدل ها

هنگامی که شما شروع به توسعه با این کار می کنید، یک مدل پیش فرض و توصیه شده را ارائه می دهیم.

مدل رمزگذار جمله جهانی (توصیه می شود)

این مدل از معماری رمزگذار دوگانه استفاده می کند و بر روی مجموعه داده های مختلف پرسش و پاسخ آموزش داده شده است.

جفت جمله زیر را در نظر بگیرید:

- ("این یک سفر جذاب و اغلب تاثیرگذار است"، "چه سفر عالی و خارق العاده ای")

- ("من تلفنم را دوست دارم"، "از تلفنم متنفرم")

- ("این رستوران یک ترفند عالی دارد"، "ما باید جزئیات برنامه خود را دوباره بررسی کنیم")

جاسازیهای متن در دو جفت اول شباهت کسینوس بالاتری نسبت به جاسازیهای جفت سوم دارند، زیرا دو جفت جملات اول به ترتیب موضوع مشترک «احساس سفر» و «نظر تلفن» دارند در حالی که جفت جملات سوم دارای یک موضوع مشترک هستند. یک موضوع مشترک را به اشتراک نگذارید

توجه داشته باشید که اگرچه دو جمله در جفت دوم دارای احساسات متضاد هستند، اما به دلیل اشتراک در موضوع مشترک دارای امتیاز شباهت بالایی هستند.

| نام مدل | شکل ورودی | نوع کوانتیزاسیون | نسخه ها |

|---|---|---|---|

| رمزگذار جملات جهانی | رشته، رشته، رشته | هیچکدام (float32) | آخرین |

معیارهای وظیفه

در اینجا معیارهای کار برای کل خط لوله بر اساس مدل های از پیش آموزش دیده بالا آمده است. نتیجه تأخیر، متوسط تأخیر پیکسل 6 با استفاده از CPU / GPU است.

| نام مدل | تاخیر CPU | تاخیر GPU |

|---|---|---|

| رمزگذار جملات جهانی | 18.21 میلیثانیه | - |