Gemini 모델 제품군의 가장 작은 버전인 Gemini Nano는 Google Pixel 8 Pro 및 삼성 S24 시리즈부터 지원되는 Android 기기에서 온디바이스로 실행할 수 있습니다.

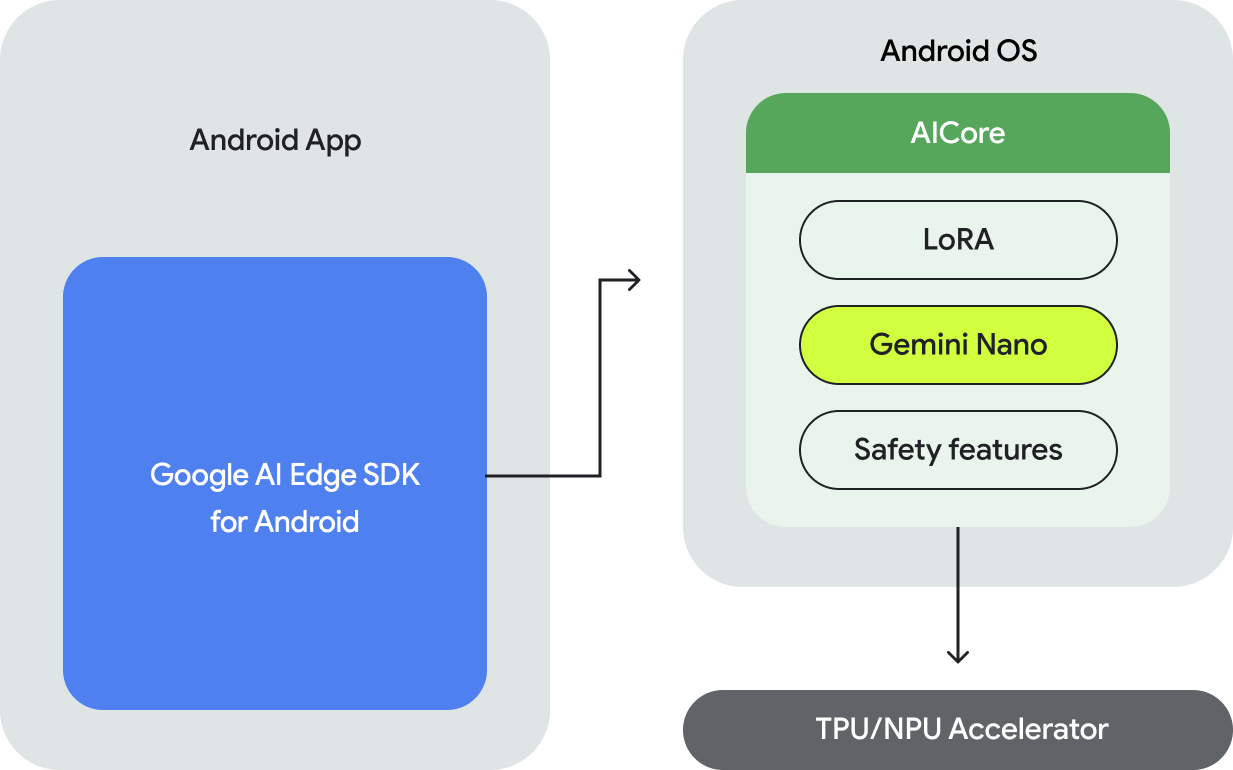

Android에서 Gemini Nano 모델을 실행하려면 다음과 같은 API를 제공하는 Android용 Google AI Edge SDK를 사용해야 합니다.

- 기본 Android 지원 기기가 지원되는지 확인합니다.

- Gemini Nano 모델에 액세스하세요.

- 안전 설정을 조정합니다.

- 고성능으로 추론을 실행하고 대체를 구현합니다.

- 원하는 경우 LoRA 미세 조정 블록을 제공하여 사용 사례에 맞게 모델 성능을 개선합니다.

Gemini Nano에 액세스하기 위한 API는 텍스트 대 텍스트 모달을 지원하며 향후 더 많은 모달이 추가될 예정입니다.

온디바이스 실행의 이점

기기 내 실행을 통해 다음을 실행할 수 있습니다.

- 민감한 정보의 로컬 처리: 데이터를 로컬에서 처리하면 사용자 데이터를 클라우드로 전송하지 않아도 됩니다. 이는 엔드 투 엔드 암호화 기능이 있는 메시지 앱과 같이 민감한 정보를 처리하는 앱에 중요합니다.

- 오프라인 액세스: 사용자가 인터넷에 연결되어 있지 않아도 AI 기능에 액세스할 수 있습니다. 이는 오프라인에서 작동하거나 연결 상태가 가변적인 애플리케이션에 유용합니다.

- 비용 절감: 실행을 소비자 하드웨어로 오프로드하여 추론 비용을 줄일 수 있습니다. 이렇게 하면 자주 사용되는 사용자 흐름에서 상당한 절감 효과를 얻을 수 있습니다.

Gemini의 기기 내 실행에는 많은 이점이 있습니다. 그러나 더 큰 Gemini 모델이 필요하고 다양한 기기를 지원해야 하는 사용 사례의 경우 서버에서 Gemini에 액세스하기 위해 Gemini API를 사용하는 것이 좋습니다. 백엔드 통합 (Python, Go, Node.js 또는 REST 사용)을 통해 또는 새로운 Android용 Google AI 클라이언트 SDK를 통해 Android 앱에서 직접 실행할 수 있습니다.

작동 방식

Gemini Nano의 온디바이스 실행은 Android 14에서 도입된 온디바이스 실행을 위한 기반 모델에 대한 액세스를 제공하는 새로운 시스템 수준 기능인 Android AICore를 기반으로 합니다. 기반 모델은 AICore를 사용하여 사전 설치되므로 앱 내에서 다운로드하거나 배포할 필요가 없습니다. LoRa를 사용하여 다운스트림 작업에 맞게 이러한 모델을 미세 조정할 수 있습니다. 이제 Android AICore는 Google Pixel 8 Pro 및 삼성 S24 시리즈 기기에서 프로덕션 버전으로 제공되며 이미 Google 앱의 혁신적인 기능을 지원하고 있습니다.

자세한 내용은 Android AICore를 참고하세요.

다음 단계

- Android 앱에서 Google 서버의 Gemini Pro 추론을 활용하는 방법을 알아보려면 Android용 Google AI 클라이언트 SDK 빠른 시작을 참고하세요.