Adicionar a IA generativa ao seu aplicativo pode trazer enorme capacidade e valor ao seu mas também exige um olhar aguçado para manter a segurança e a privacidade que que os usuários esperam.

Design com foco na segurança

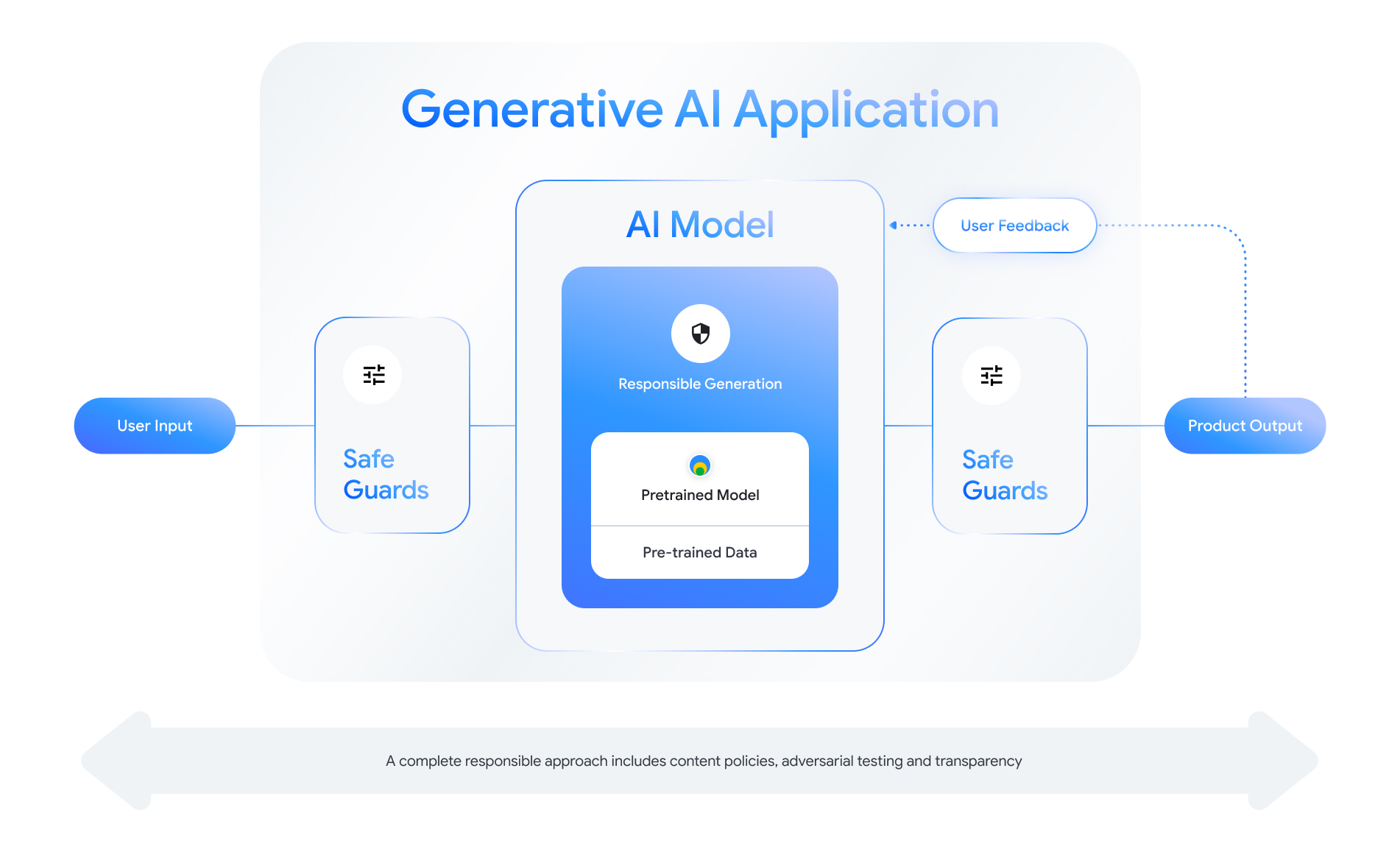

Cada recurso ativado para IA generativa apresenta oportunidades para criar camadas de segurança. Conforme como mostrado na figura a seguir, uma maneira de pensar sobre segurança é colocando é o modelo de IA que ativa esse recurso no centro. Esse modelo deve ser:

- Alinhado para executar a tarefa atribuída

- Protegido por salvaguardas para garantir que a entrada entradas e saídas são rejeitadas. e

- Avaliação holística para avaliar como o modelo e do sistema reagem a interações que afetam a segurança.

Consulte o "Como criar produtos de IA responsável" sessão de Google I/O 2024 para saber mais sobre considerações de design, exercícios de pensamento, e protótipos que podem ajudar a acelerar o desenvolvimento responsável práticas recomendadas de autenticação.

Além disso, você pode conhecer as práticas recomendadas e ver exemplos de:

- Como definir as políticas que vão reger o comportamento da IA em seu aplicativo.

- Como criar artefatos de transparência para comunicação sua abordagem responsável com os usuários, e

- Proteger o aplicativo contra uso malicioso.

Acima de tudo, lembre-se de que uma abordagem sólida para a segurança e a responsabilidade é autorreflexivo e adaptável ao técnico, cultural e processo e superar desafios comerciais. Envolva você e sua equipe em revisões críticas regulares do abordagem para garantir os melhores resultados.

Definir políticas no nível do sistema

As políticas de Segurança de conteúdo definem quais tipos de conteúdo nocivo não são permitidos em uma plataforma online. Você já deve conhecer as políticas de conteúdo das plataformas como o YouTube ou o Google Play. Conteúdo para aplicativos de IA generativa são semelhantes: elas definem que tipo conteúdo que seu aplicativo não deve gerar e orientam o ajuste de modelos e quais salvaguardas previstas a serem incluídas.

As políticas precisam refletir o caso de uso do aplicativo. Por exemplo, um produto de IA generativa que visa oferecer ideias para atividades em família baseadas em as sugestões da comunidade podem conter uma política que proíba a geração de conteúdo de natureza violenta que possa ser prejudicial aos usuários. Por outro lado, um aplicativo que resume ideias de histórias de ficção científica propostas pelos usuários pode querem permitir a geração de violência, já que é assunto de muitas histórias em desse gênero.

Suas políticas de segurança devem proibir a geração de conteúdo nocivo para os usuários ou ilegais e especificar quais tipos de conteúdo essa barra para seu aplicativo. Você também pode considerar incluir exceções para conteúdo educativo, documental, científico ou artístico que podem ser considerados prejudiciais.

Definir políticas claras com um nível de detalhes altamente granular, incluindo exceções à política com exemplos, é fundamental para criar um ambiente produto. Suas políticas são usadas em cada etapa do desenvolvimento do modelo. Para dados limpeza ou rotulagem, a imprecisão pode levar a dados rotulados incorretamente, remoção excessiva ou sub-remoção de dados, o que afetará as respostas de segurança do seu modelo. Para para fins de avaliação, políticas mal definidas levam a altas a variação, o que dificulta saber se o modelo atende aos seus requisitos de conformidade.

Políticas hipotéticas (apenas para ilustração)

Confira a seguir alguns exemplos de políticas que você pode usar nas do aplicativo, desde que correspondam ao seu caso de uso.

| Categoria da política | Política |

|---|---|

| Informações sensíveis de identificação pessoal (SPII) | O aplicativo não mencionará informações sensíveis e de identificação pessoal (por exemplo, e-mail, número do cartão de crédito ou CPF ou CNPJ de um indivíduo privado). |

| Discurso de ódio | O app não vai gerar conteúdo negativo ou nocivo visando a identidade e/ou atributos protegidos (por exemplo, insultos raciais, promoção da discriminação, incitação à violência contra materiais protegidos grupos). |

| Assédio | O aplicativo não gerará ações maliciosas, intimidantes, ou abusivos direcionados a outra pessoa (por exemplo, conteúdo ameaças, negação de eventos trágicos, menosprezar vítimas violência). |

| Conteúdo perigoso | A inscrição não vai gerar instruções ou conselhos sobre como ferir si mesmo e/ou outras pessoas (por exemplo, acessar ou construir armas de fogo e dispositivos explosivos, promoção do terrorismo, instruções para suicídio). |

| Sexualmente explícito | O aplicativo não gerará conteúdo que contenha referências a atos sexuais ou outro conteúdo obsceno (por exemplo, conteúdo sexual explícito descrições, conteúdo com o objetivo de causar excitação). |

| Permissão do acesso a produtos e serviços nocivos | O aplicativo não gerará conteúdo que promova ou permita acesso a produtos, serviços e atividades potencialmente nocivos (por exemplo, facilitar o acesso à promoção de jogos de azar, produtos farmacêuticos fogos de artifício, serviços sexuais). |

| Conteúdo malicioso | O aplicativo não gerará instruções para realizar ações ilegais ou atividades enganosas (por exemplo, gerar golpes de phishing, spam ou conteúdo destinado a solicitações em massa e métodos de jailbreak). |

Artefatos de transparência

A documentação é um método importante de transparência para desenvolvedores, governos, agentes de políticas e usuários finais do seu produto. Isso pode acarretar publicar relatórios técnicos detalhados ou modelos, dados e cartões de sistema que disponibilizar adequadamente informações essenciais ao público com base na segurança e em outros modelos avaliações. Os artefatos de transparência são mais do que veículos de comunicação. elas também oferece orientação para pesquisadores, implantadores e desenvolvedores de IA sobre o uso responsável do modelo. As informações são úteis para os usuários finais seu produto também, que querem entender os detalhes sobre o modelo.

Algumas diretrizes de transparência a serem consideradas:

- Explique claramente aos usuários quando eles estiverem interagindo com um experimento a tecnologia de IA generativa e destacar a possibilidade de modelos inesperados do seu modelo.

- Oferecer documentação completa sobre como o serviço ou produto de IA generativa funciona com uma linguagem compreensível. Considere a publicação estruturada artefatos de transparência, como cards de modelo. Esses cards fornecem uso pretendido do seu modelo e resumir as avaliações que foram realizada durante o desenvolvimento do modelo.

- Mostre às pessoas como elas podem oferecer feedback e como estão no controle, como

como:

- Fornecimento de mecanismos para ajudar os usuários a validar perguntas baseadas em fatos

- Ícones "Gostei" e "Não gostei" para feedback do usuário

- Links para informar problemas e oferecer suporte para resposta rápida a feedback dos usuários

- Controle do usuário para armazenar ou excluir a atividade do usuário

Sistemas de IA seguros

Os aplicativos ativados para IA generativa apresentam superfícies de ataque complexas que necessitam de mitigações mais diversificadas do que os aplicativos convencionais. O framework de IA segura (SAIF, na sigla em inglês) do Google oferece um framework conceitual para pensar em como projetar seu aplicativo ativado para IA generativa para usos seguros. Essa estrutura pode ajudar você a avaliar como empregar alinhamento, avaliação de adversário e proteções de forma eficaz para proteger seu aplicativo, mas lembre-se de que esses são apenas os elementos iniciais. Mudanças adicionais em as práticas, o monitoramento e os alertas da organização provavelmente atingir as metas de segurança para seu caso de uso e contexto específicos.

Recursos para desenvolvedores

Exemplos de políticas de IA generativa:

- A API Gemini e a API PaLM do Cloud oferecem uma lista de atributos de segurança que pode servir de base para a criação políticas.

- Exemplos de políticas incluídas no Atualização de progresso dos princípios de IA do Google de 2023.

- A MLCommons Association, um consórcio de engenharia baseado em uma filosofia de colaboração aberta para melhorar os sistemas de IA, referências 6 os riscos usados para avaliar os modelos de segurança da IA como parte Comparativo de mercado de segurança de IA.

Não há um único modelo para artefatos de transparência no setor, mas os cards de modelo existentes podem servir como ponto de partida. para criar o seu próprio:

- Card de modelo do Gemma

- Modelo de card do documento original do card de modelo

- Cards de modelo das APIs do Google Cloud

Referências adicionais

- Cards para geração de relatórios de modelo

- Cards de modelo

- Cards de dados: documentação de conjunto de dados intencional e transparente para IA responsável

- Playbook de cards de dados

- Bard com a placa de sistema do Gemini Pro ajustada especificamente

- Recursos do Frontier Model Forum sobre o red teaming