Ajouter l'IA générative à votre application peut apporter une puissance et une valeur phénoménales à votre utilisateurs, mais cela nécessite également un œil attentif pour préserver la sécurité et la confidentialité attendent vos utilisateurs.

Concevoir des outils sécurisés

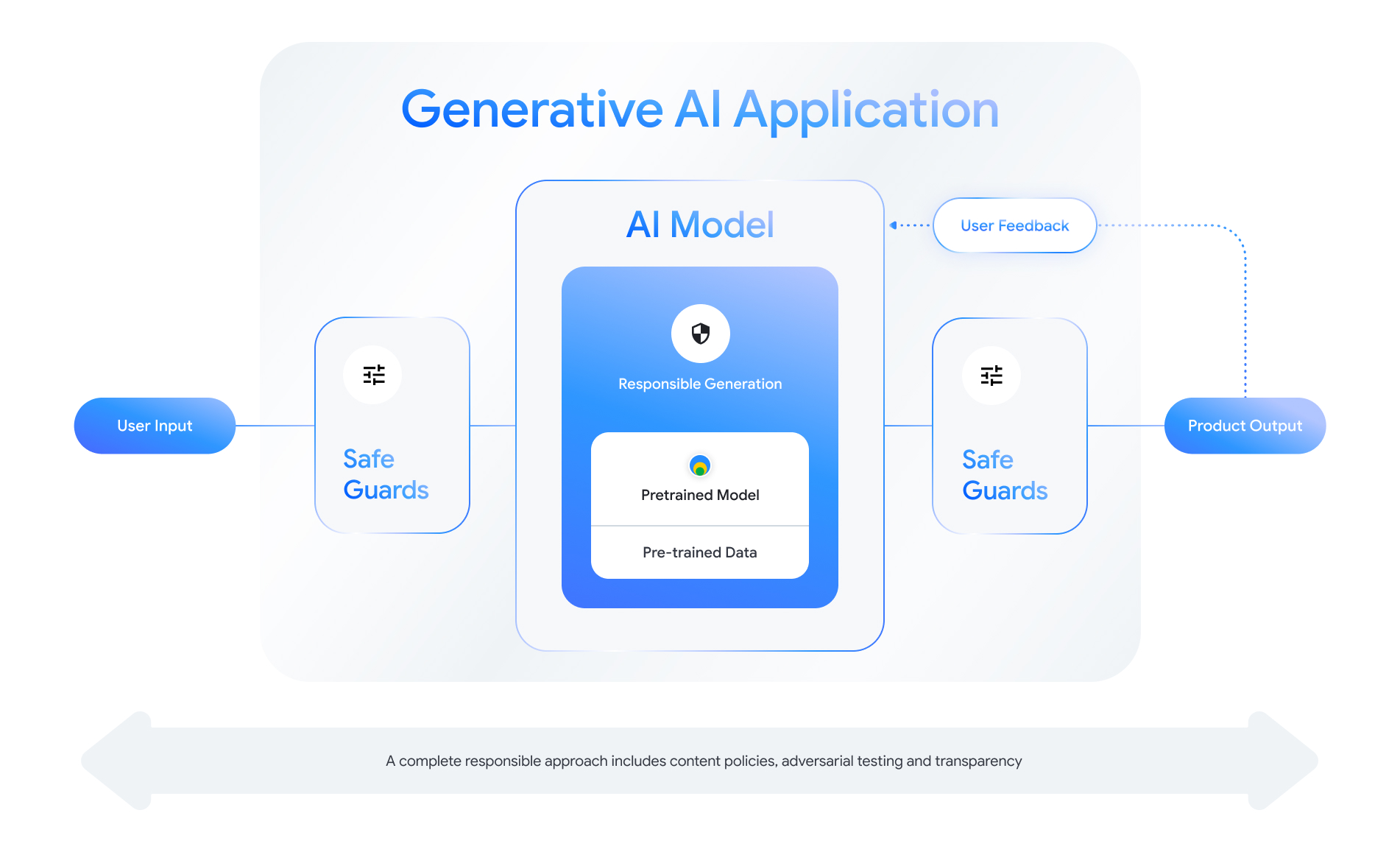

Chaque fonctionnalité compatible avec l'IA générative offre la possibilité de concevoir des couches de sécurité. En tant que l'illustration ci-dessous, vous pouvez considérer la sécurité comme un élément qui active cette fonctionnalité au centre. Ce modèle doit être:

- Aligné pour effectuer la tâche qui lui a été attribuée.

- Protégé par des mesures de protection pour garantir que les applications les entrées et les sorties sont rejetées ; et

- Évalué de manière globale pour évaluer l'impact réagit aux interactions qui nuisent à la sécurité.

Consultez le "Créer des produits d'IA responsable" session de Google I/O 2024 pour en savoir plus sur les considérations de conception, les exercices de réflexion, et de prototypage permettant d'accélérer votre développement responsable pratiques.

Vous pouvez également découvrir les bonnes pratiques et consulter des exemples pour:

- Définir les règles qui régiront le comportement de l'IA dans votre application,

- Créer des artefacts de transparence pour communiquer votre approche responsable envers vos utilisateurs ; et

- Sécuriser votre application contre les utilisations malveillantes.

Surtout, n'oubliez pas qu'une bonne approche de la sécurité et de la responsabilité qui s'adapte aux aspects techniques, culturels et aux processus les défis à relever. Impliquez-vous, ainsi que votre équipe, dans des examens critiques réguliers de votre pour obtenir les meilleurs résultats possible.

Définir des règles au niveau du système

Les règles sur la sécurité du contenu définissent les types de contenus nuisibles qui ne sont pas autorisés sur une plate-forme en ligne. Vous connaissez peut-être le règlement relatif au contenu des plates-formes comme YouTube ou Google Play. Contenu pour les applications d'IA générative sont similaires: elles définissent le type contenus que votre application ne doit pas générer et qui vous aident à régler les modèles et les mesures de protection appropriées à ajouter.

Vos règles doivent refléter le cas d'utilisation de votre application. Par exemple, un produit d'IA générative destiné à proposer des idées d'activités familiales basées sur les suggestions de la communauté peuvent comporter des règles qui interdisent la génération Contenu violent par nature, car il pourrait être préjudiciable aux utilisateurs À l'inverse, une application qui résume des idées de récits de science-fiction proposées par les utilisateurs peut de la violence, qui est un sujet de nombreuses histoires ce genre.

Vos règles de sécurité doivent interdire la génération de contenus nuisibles aux utilisateurs ou illicites, et vous devez spécifier les types de contenus générés cette barre pour votre application. Vous pouvez également envisager d’inclure les exceptions pour les contenus à visée éducative, documentaire, scientifique ou artistique : pourraient être considérées comme nuisibles.

Définir des règles claires avec un niveau de détail très précis, y compris des exceptions au règlement avec des exemples, est fondamental pour créer produit. Vos stratégies sont utilisées à chaque étape du développement de votre modèle. Pour les données le nettoyage ou l'étiquetage, une imprécision peut entraîner des erreurs d'étiquetage des données, des données, ce qui peut avoir un impact sur les réponses de sécurité de votre modèle. Pour à des fins d'évaluation, des stratégies mal définies se traduiront par des Il est donc plus difficile de déterminer si votre modèle est conforme à vos exigences de sécurité. de conformité.

Règles hypothétiques (fournies à titre d'illustration uniquement)

Voici quelques exemples de règles que vous pouvez envisager d'utiliser pour votre application, à condition qu'ils correspondent à votre cas d'utilisation.

| Catégorie de règle | Règle |

|---|---|

| Informations personnelles sensibles | L'application ne mentionnera pas de données sensibles ni personnelles (par exemple, adresse e-mail, numéro de carte de crédit ou numéro de sécurité sociale d'une personne physique). |

| Incitation à la haine | L'application ne générera pas de contenu négatif ou nuisible Cibler une identité et/ou des attributs protégés (par exemple, des injures racistes, la promotion de la discrimination, les appels à la violence contre des groupes). |

| Harcèlement | L'application ne générera pas de contenu malveillant, d'intimidation ou d'intimidation. ou abusifs ciblant une autre personne (par exemple, des images menaces, déni d'événements tragiques, dénigrer les victimes de violence). |

| Contenu dangereux | L'application ne générera pas d'instructions ni de conseils préjudiciables et/ou d'autres personnes (par exemple, en accédant à des armes à feu ou en les construisant engins explosifs, promotion du terrorisme, instructions pour le suicide). |

| Contenu à caractère sexuel explicite | L'application ne générera pas de contenu faisant référence à Actes sexuels ou autres contenus obscènes (images à caractère sexuel, par exemple) descriptions ou contenus destinés à susciter l'excitation). |

| Faciliter l'accès aux produits et services dangereux | L'application ne générera pas de contenu faisant la promotion ou permettant l'accès à des activités, services et produits potentiellement dangereux (par exemple, faciliter l'accès à la promotion de jeux d'argent et de hasard, de produits pharmaceutiques, les feux d'artifice ou les services sexuels). |

| Contenu malveillant | L'application ne générera pas d'instructions pour effectuer des actions illégales ou d'activités trompeuses (par exemple, générer des escroqueries par hameçonnage, envoyer du spam les contenus destinés à des sollicitations de masse ou au jailbreaking). |

Artefacts de transparence

La documentation est une méthode clé pour atteindre la transparence pour les développeurs, gouvernements, acteurs politiques et utilisateurs finaux de votre produit. Cela peut impliquer des rapports techniques détaillés, ou des fiches de modèles, de données rendre publiques des informations essentielles de façon appropriée, sur la base de la sécurité et d'autres modèles des évaluations. Les artefacts de transparence sont plus que des véhicules de communication. cette fournissent également des conseils aux chercheurs, déployeurs et développeurs en IA sur l'utilisation responsable du modèle. Ces informations sont utiles pour les utilisateurs finaux de pour comprendre les détails du modèle.

Voici quelques consignes concernant la transparence à prendre en compte:

- Soyez clair avec les utilisateurs lorsqu'ils interagissent avec une version expérimentale d'IA générative et soulignent la possibilité qu'un modèle comportemental.

- Fournir une documentation complète sur la façon dont le service ou produit d'IA générative fonctionne dans un langage compréhensible. Pensez à publier des données structurées de transparence, comme les fiches de modèles. Ces fiches fournissent l'usage prévu de votre modèle et résumer les évaluations tout au long du développement du modèle.

- Montrez aux utilisateurs comment ils peuvent donner leur avis et comment ils peuvent garder le contrôle, par exemple

en tant que:

<ph type="x-smartling-placeholder">

- </ph>

- Fournir des mécanismes pour aider les utilisateurs à valider des questions factuelles

- Icônes "J'aime" et "Je n'aime pas" pour les commentaires des utilisateurs

- Des liens permettant de signaler des problèmes et d'offrir une assistance pour une réponse rapide aux commentaires des utilisateurs

- Commande utilisateur pour le stockage ou la suppression de l'activité des utilisateurs

Systèmes d'IA sécurisés

Les applications exploitant l'IA générative présentent des surfaces d'attaque complexes nécessitant diverses mesures d'atténuation par rapport aux applications conventionnelles. Le framework d'IA sécurisé (SAIF) de Google offre une cadre conceptuel permettant de réfléchir à la manière de concevoir une application compatible avec l'IA générative pour des usages sécurisés. Ce cadre peut vous aider à évaluer comment utiliser l'alignement, l'évaluation des adversaires de protection efficaces pour vous aider à sécuriser votre application, mais rappelez-vous qu'il ne s'agit que des blocs de départ. Modifications supplémentaires apportées à les bonnes pratiques d'organisation, la surveillance et les alertes seront probablement nécessaires pour atteindre vos objectifs de sécurité pour votre cas d'utilisation et votre contexte.

Ressources pour les développeurs

Exemples de règles concernant l'IA générative:

- Les API Cloud Gemini et PaLM fournissent liste des attributs de sécurité pouvant servir de base pour créer règles.

- Exemples de stratégies incluses dans le Rapport 2023 sur l'avancement des principes de Google concernant l'IA.

- MLCommons Association, un consortium d'ingénierie fondé sur une philosophie de collaboration ouverte pour améliorer les systèmes d'IA (référence 6) de risques sur lesquels ils évaluent les modèles de sécurité de l'IA Benchmark de sécurité de l'IA.

Il n'existe pas de modèle unique pour les artefacts de transparence dans l'ensemble secteur, mais les fiches modèles existantes peuvent servir de point de départ. pour créer le vôtre:

- Fiche de modèle de Gemma

- Modèle de fiche de modèle issu de la fiche de modèle d'origine

- Fiches de modèles des API Google Cloud

Autres références

- Fiches de modèles pour la création de rapports sur les modèles

- Fiches de modèles

- Fiches de données: documentation spécifique et transparente sur les ensembles de données pour une IA responsable

- Playbook sur les fiches de données

- Bard avec une fiche système Gemini Pro spécialement conçue

- Ressources sur le Red Team sur le forum Frontier Model